GenAI GeoGuesser

เดาชื่อประเทศจากเพลงฮิตที่สร้างโดย AI

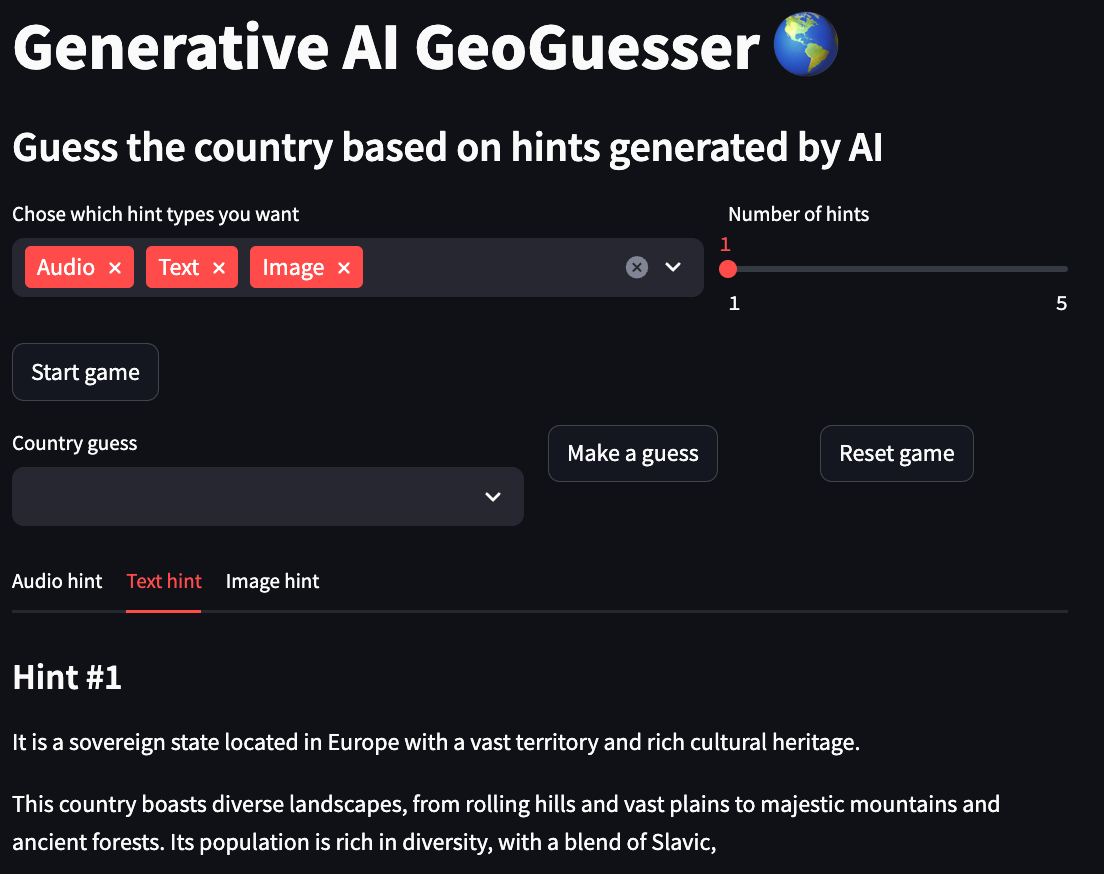

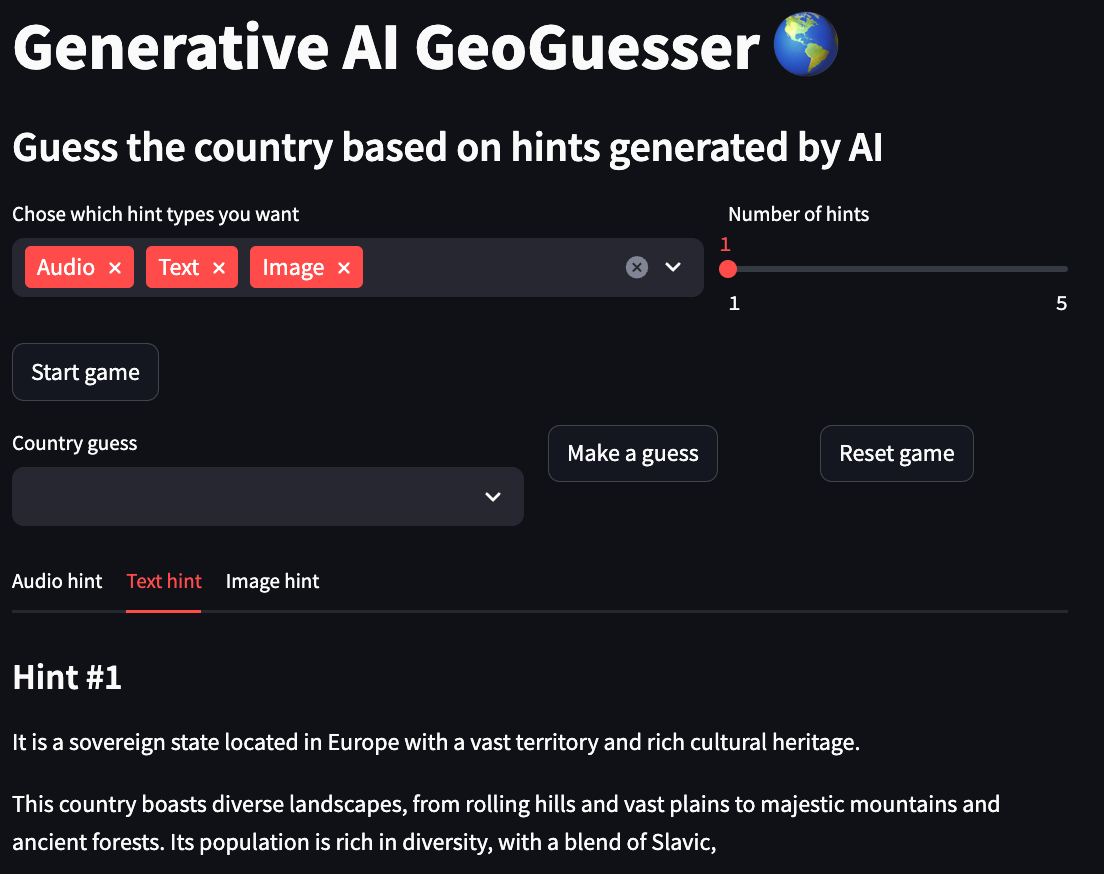

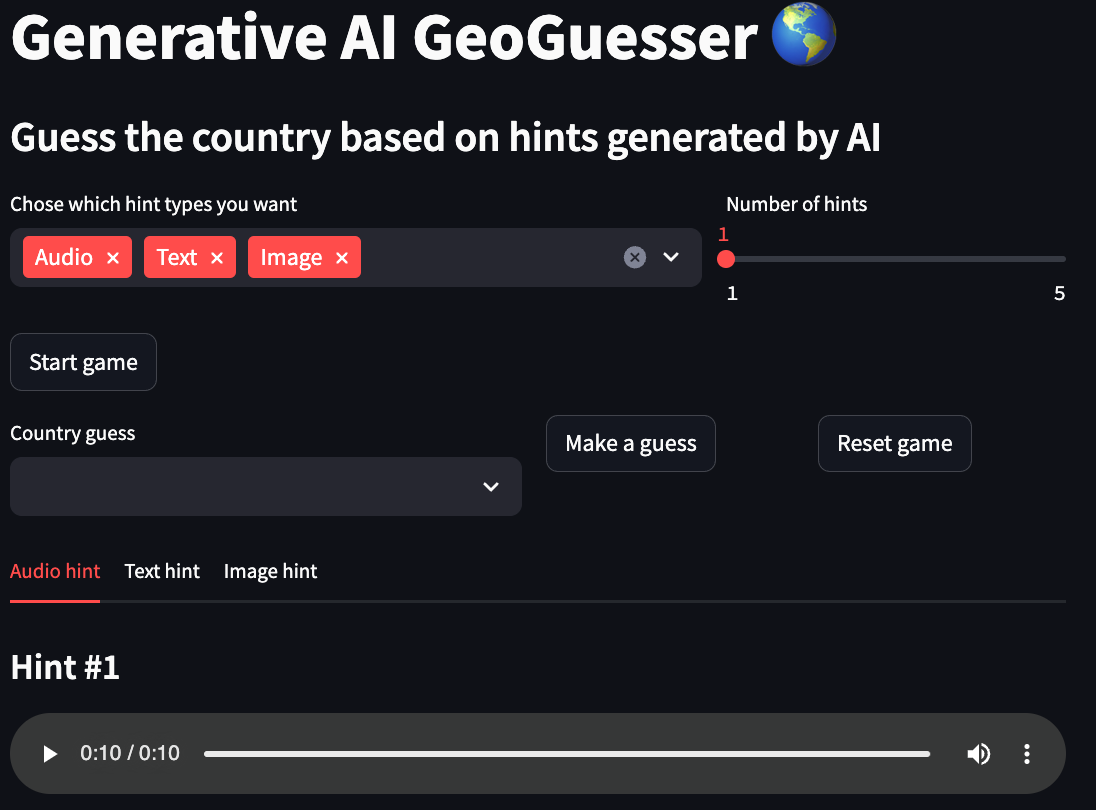

โปรเจ็กต์นี้เป็นอีกเกมหนึ่งในเกม GeoGuessr ยอดนิยมที่คุณจะถูกวางตำแหน่งบนโลกแบบสุ่มบน Google Maps และต้องเดาตำแหน่งระหว่างการนับถอยหลังเวลา ที่นี่คุณจะต้องเดาชื่อประเทศตามคำใบ้หลายรูปแบบที่สร้างโดยโมเดล AI คุณสามารถเลือกรูปแบบได้ 3 แบบ ข้อความ ที่ให้คำอธิบายเกี่ยวกับข้อความของประเทศ รูปภาพ ที่ให้ภาพที่คล้ายกับประเทศและ เสียง ที่ให้ คุณตัวอย่างเสียงที่เกี่ยวข้องกับประเทศ

คุณสามารถตรวจสอบการสาธิตออนไลน์ของแอปนี้ได้ที่ช่องว่าง HuggingFace การสาธิตนี้จำกัดให้สร้างเฉพาะคำแนะนำรูปภาพเนื่องจากเหตุผลด้านประสิทธิภาพ

หากคุณต้องการเรียนรู้เพิ่มเติมอีกเล็กน้อยเกี่ยวกับวิธีการทำงานของโปรเจ็กต์นี้และวิธีการสร้าง โปรดอ่านบทความ "การสร้าง GeoGuesser ที่ใช้ AI แบบกำเนิด"

ขั้นตอนการทำงาน

- เลือกรูปแบบคำใบ้ที่ต้องการ

- เลือกจำนวนคำแนะนำสำหรับแต่ละรูปแบบ

- คลิกที่ปุ่ม "เริ่มเกม"

- ดูคำแนะนำทั้งหมดแล้วพิมพ์การเดาของคุณลงในช่อง "เดาประเทศ"

- คลิกที่ปุ่ม "ทำการเดา"

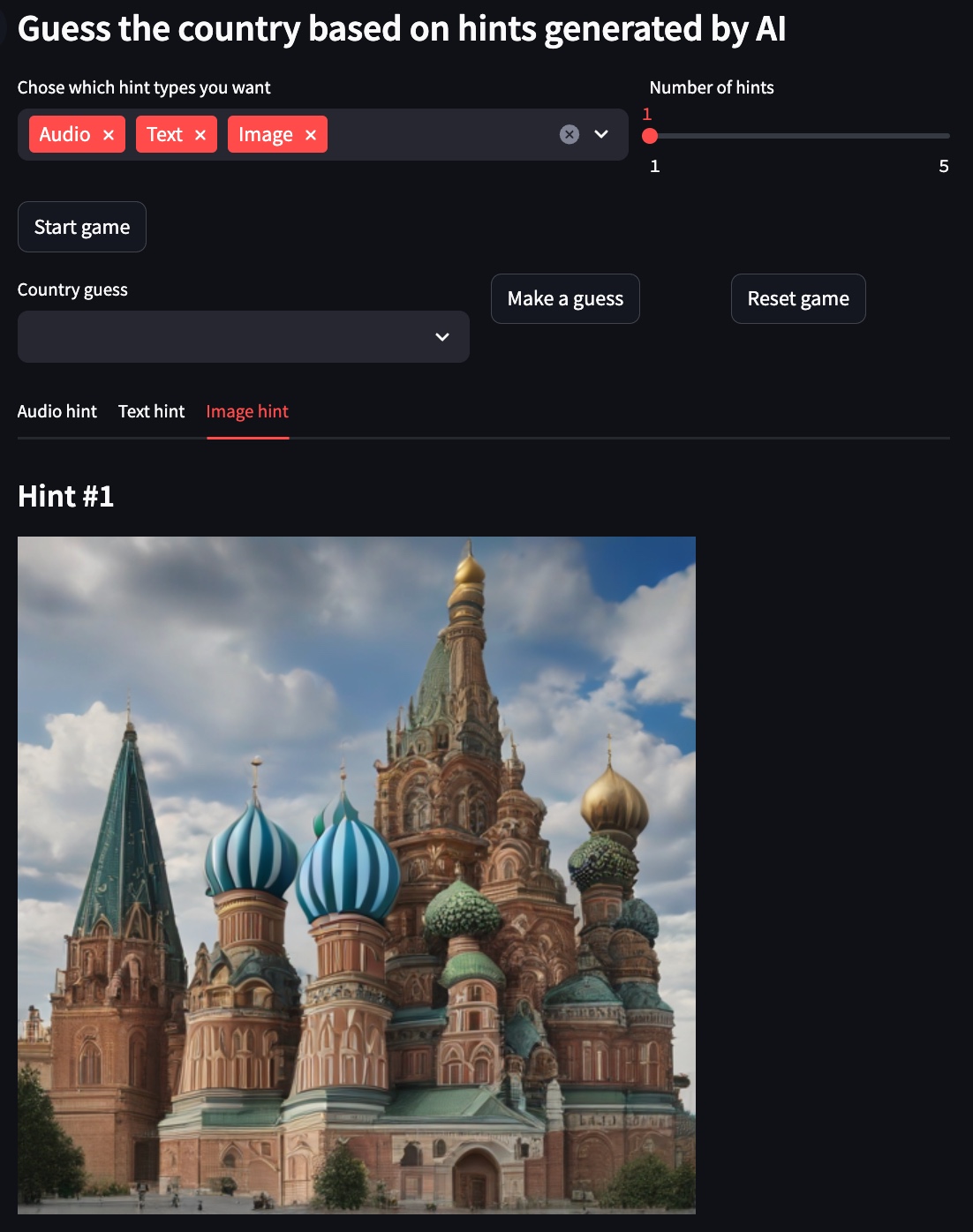

สาธิต

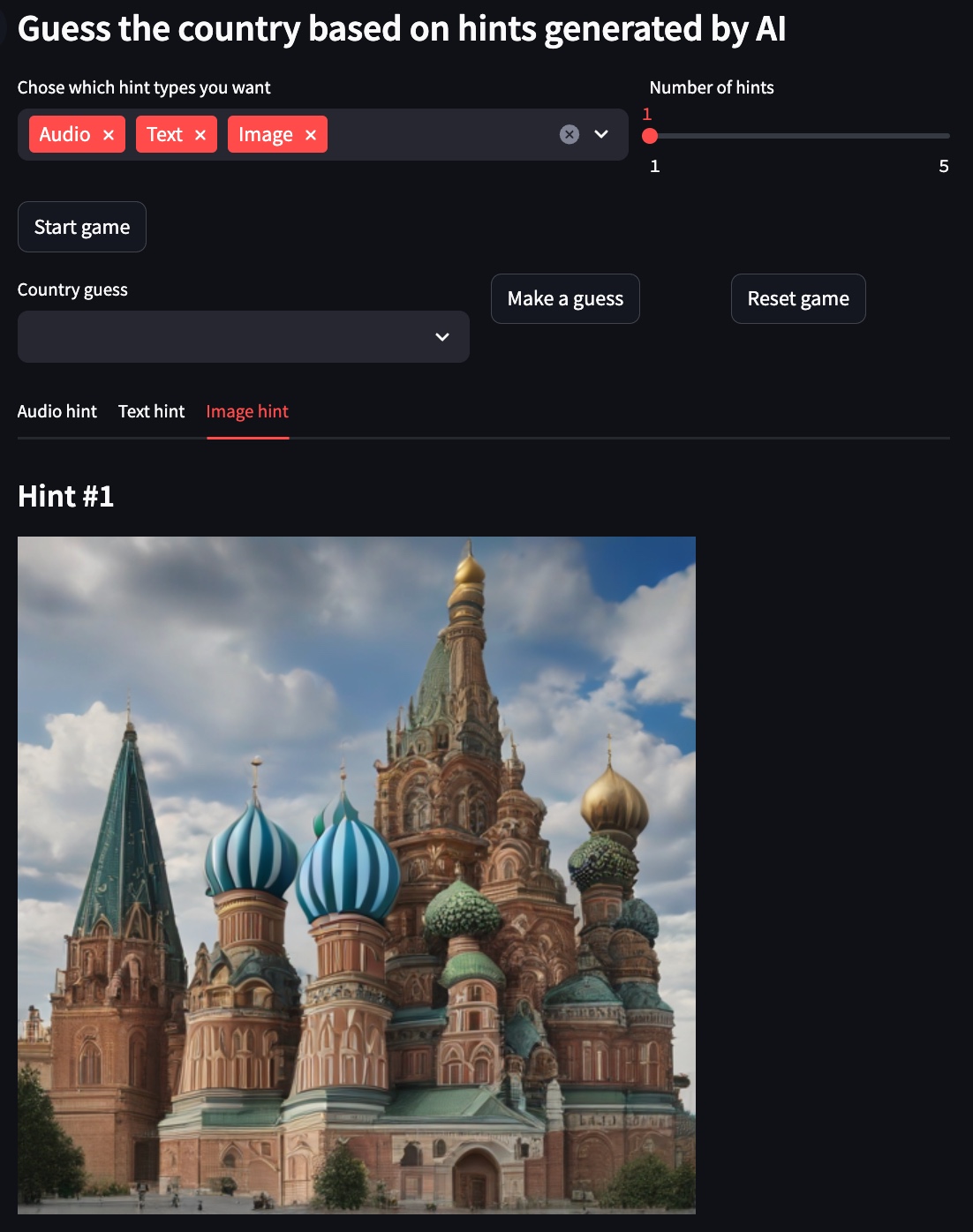

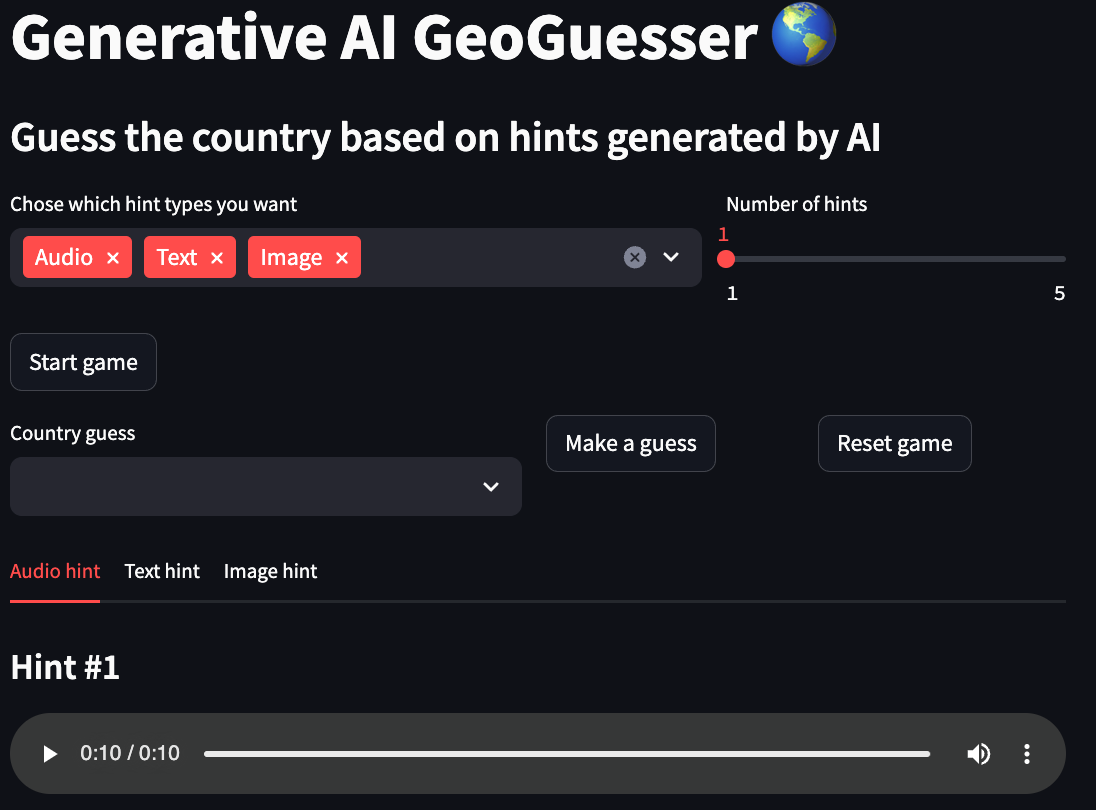

สำหรับตัวอย่างด้านล่าง ประเทศที่เลือกคือ รัสเซีย

คำใบ้ข้อความ

คำแนะนำรูปภาพ

คำใบ้เสียง

การใช้งาน

แนวทางที่แนะนำในการใช้พื้นที่เก็บข้อมูลนี้คือกับ Docker แต่คุณสามารถใช้ venv แบบกำหนดเองได้ เพียงตรวจสอบให้แน่ใจว่าได้ติดตั้งการอ้างอิงทั้งหมด

การกำหนดค่า

local:

to_use: true

text:

model_id: google/gemma-1.1-2b-it

device: cpu

max_output_tokens: 50

temperature: 1

top_p: 0.95

top_k: 32

image:

model_id: stabilityai/sdxl-turbo

device: mps

num_inference_steps: 1

guidance_scale: 0.0

audio:

model_id: cvssp/audioldm2-music

device: cpu

num_inference_steps: 200

audio_length_in_s: 10

vertex:

to_use: false

project: {VERTEX_AI_PROJECT}

location: {VERTEX_AI_LOCALTION}

text:

model_id: gemini-1.5-pro-preview-0409

max_output_tokens: 50

temperature: 1

top_p: 0.95

top_k: 32

- ท้องถิ่น

- to_use: หากโครงการควรใช้การกำหนดค่าการตั้งค่านี้

- ข้อความ

- model_id: โมเดลที่ใช้สร้างคำแนะนำข้อความ

- อุปกรณ์: อุปกรณ์ที่ใช้โดยรุ่นซึ่งมักจะเป็นหนึ่งใน (cpu, cuda, mps)

- max_output_tokens: จำนวนโทเค็นสูงสุดที่สร้างโดยโมเดล

- อุณหภูมิ: อุณหภูมิจะควบคุมระดับของการสุ่มในการเลือกโทเค็น อุณหภูมิที่ต่ำกว่าเหมาะสำหรับการแจ้งเตือนที่คาดหวังการตอบสนองที่แท้จริงหรือถูกต้อง ในขณะที่อุณหภูมิที่สูงขึ้นอาจนำไปสู่ผลลัพธ์ที่หลากหลายหรือไม่คาดคิดมากขึ้น เมื่ออุณหภูมิเป็น 0 โทเค็นความน่าจะเป็นสูงสุดจะถูกเลือกเสมอ

- top_p: Top-p เปลี่ยนวิธีที่โมเดลเลือกโทเค็นสำหรับเอาต์พุต โทเค็นจะถูกเลือกจากความน่าจะเป็นมากที่สุดไปน้อยที่สุดจนกว่าผลรวมของความน่าจะเป็นจะเท่ากับค่า top-p ตัวอย่างเช่น หากโทเค็น A, B และ C มีความน่าจะเป็นที่ .3, .2 และ .1 และค่า top-p คือ .5 โมเดลจะเลือก A หรือ B เป็นโทเค็นถัดไป (โดยใช้อุณหภูมิ )

- top_k: Top-k เปลี่ยนวิธีที่โมเดลเลือกโทเค็นสำหรับเอาต์พุต top-k ของ 1 หมายความว่าโทเค็นที่เลือกนั้นน่าจะเป็นไปได้มากที่สุดในบรรดาโทเค็นทั้งหมดในคำศัพท์ของโมเดล (หรือที่เรียกว่า greedy decoding) ในขณะที่ top-k ของ 3 หมายความว่าโทเค็นถัดไปจะถูกเลือกจาก 3 โทเค็นที่เป็นไปได้มากที่สุด ( โดยใช้อุณหภูมิ)

- ภาพ

- model_id: โมเดลที่ใช้สร้างคำแนะนำรูปภาพ

- อุปกรณ์: อุปกรณ์ที่ใช้โดยรุ่นซึ่งมักจะเป็นหนึ่งใน (cpu, cuda, mps)

- num_inference_steps: จำนวนขั้นตอนการอนุมานสำหรับโมเดล

- แนวทาง_สเกล: บังคับให้รุ่นตรงกับข้อความแจ้งมากขึ้น โดยอาจต้องแลกกับคุณภาพของภาพหรือความหลากหลาย

- เสียง

- model_id: โมเดลที่ใช้สร้างคำแนะนำเสียง

- อุปกรณ์: อุปกรณ์ที่ใช้โดยรุ่นซึ่งมักจะเป็นหนึ่งใน (cpu, cuda, mps)

- num_inference_steps: จำนวนขั้นตอนการอนุมานสำหรับโมเดล

- audio_length_in_s: ความยาวระยะเวลาของคำใบ้เสียง

- จุดยอด

- to_use: หากโครงการควรใช้การกำหนดค่าการตั้งค่านี้

- โครงการ: ชื่อโครงการที่ใช้โดย Vertex AI

- ตำแหน่ง: ตำแหน่งโครงการที่ใช้โดย Vertex AI

- ข้อความ

- model_id: โมเดลที่ใช้สร้างคำแนะนำข้อความ

- max_output_tokens: จำนวนโทเค็นสูงสุดที่สร้างโดยโมเดล

- อุณหภูมิ: อุณหภูมิจะควบคุมระดับของการสุ่มในการเลือกโทเค็น อุณหภูมิที่ต่ำกว่าเหมาะสำหรับการแจ้งเตือนที่คาดหวังการตอบสนองที่แท้จริงหรือถูกต้อง ในขณะที่อุณหภูมิที่สูงขึ้นอาจนำไปสู่ผลลัพธ์ที่หลากหลายหรือไม่คาดคิดมากขึ้น เมื่ออุณหภูมิเป็น 0 โทเค็นความน่าจะเป็นสูงสุดจะถูกเลือกเสมอ

- top_p: Top-p เปลี่ยนวิธีที่โมเดลเลือกโทเค็นสำหรับเอาต์พุต โทเค็นจะถูกเลือกจากความน่าจะเป็นมากที่สุดไปน้อยที่สุดจนกว่าผลรวมของความน่าจะเป็นจะเท่ากับค่า top-p ตัวอย่างเช่น หากโทเค็น A, B และ C มีความน่าจะเป็นที่ .3, .2 และ .1 และค่า top-p คือ .5 โมเดลจะเลือก A หรือ B เป็นโทเค็นถัดไป (โดยใช้อุณหภูมิ )

- top_k: Top-k เปลี่ยนวิธีที่โมเดลเลือกโทเค็นสำหรับเอาต์พุต top-k ของ 1 หมายความว่าโทเค็นที่เลือกนั้นน่าจะเป็นไปได้มากที่สุดในบรรดาโทเค็นทั้งหมดในคำศัพท์ของโมเดล (หรือที่เรียกว่า greedy decoding) ในขณะที่ top-k ของ 3 หมายความว่าโทเค็นถัดไปจะถูกเลือกจาก 3 โทเค็นที่เป็นไปได้มากที่สุด ( โดยใช้อุณหภูมิ)

คำสั่ง

เริ่มแอพเกม

สร้างอิมเมจนักเทียบท่า

ใช้ผ้าสำลีและการจัดรูปแบบกับโค้ด (จำเป็นสำหรับการพัฒนาเท่านั้น)