อิมเมจ Docker ที่ให้ชุดเครื่องมือ OSINT ที่เรียบง่ายสำหรับการนำเข้าและวิเคราะห์เนื้อหาการสื่อสารจากไฟล์ MBOX ของอีเมล และข้อมูล CSV อื่นๆ (เช่น ข้อความ) โดยใช้ Elasticsearch และ Kibana นี่เป็นคำสั่งเดียวที่เรียกใช้สแต็กซอฟต์แวร์วิเคราะห์ OSINT เต็มรูปแบบ พร้อมทั้งนำเข้าการสื่อสารทั้งหมดของคุณลงไป พร้อมสำหรับการวิเคราะห์ด้วย Kibana และ ElasticSearch

โปรเจ็กต์นี้จัดการ Dockerfile เพื่อสร้างอิมเมจที่เมื่อเรียกใช้จะเริ่มต้นทั้ง ElasticSearch และ Kibana จากนั้นเลือกนำเข้าข้อมูลการสื่อสารโดยใช้เครื่องมือต่อไปนี้ที่รวมอยู่ในคอนเทนเนอร์:

สิ่งสำคัญ ลิงก์ด้านล่างคือ ทางแยก ของโครงการดั้งเดิมเนื่องจากปัญหาคงค้างกับโครงการดั้งเดิมที่ไม่ได้รับการแก้ไขในขณะที่พัฒนาโครงการนี้

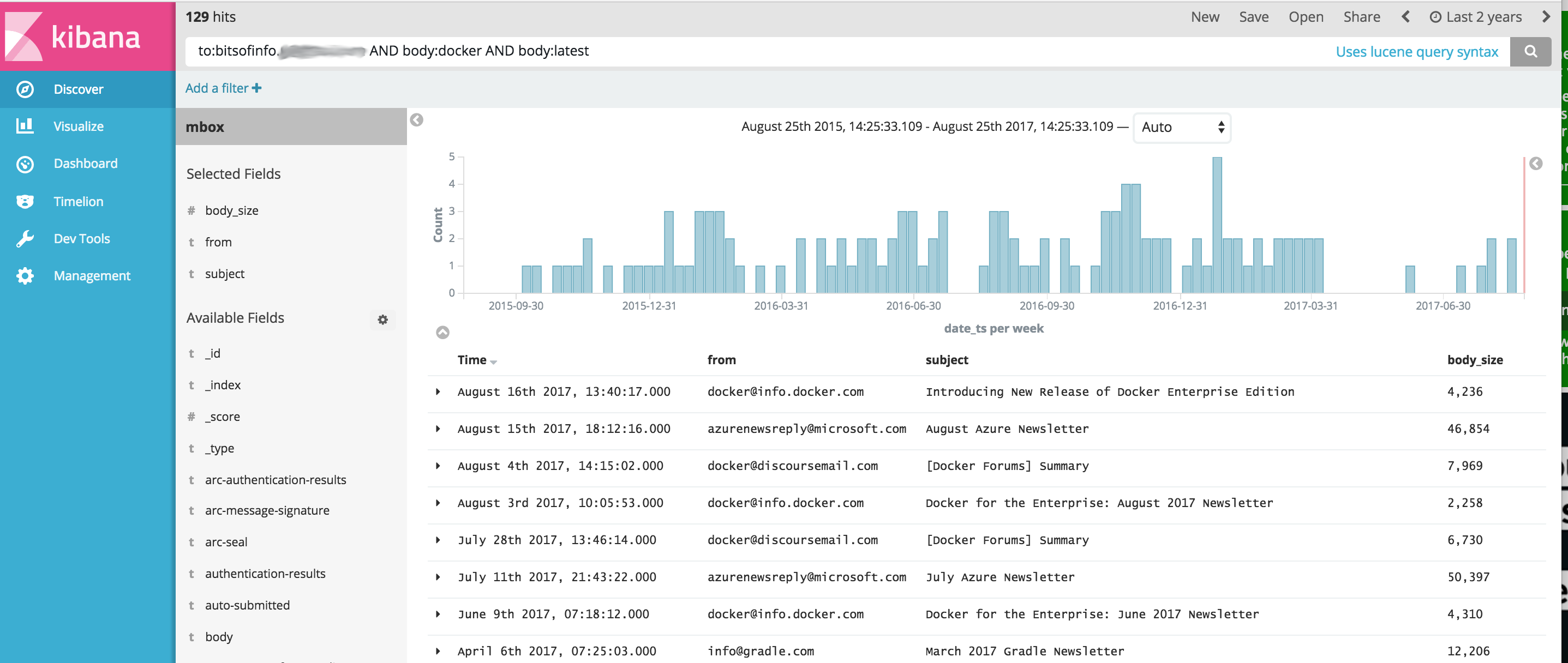

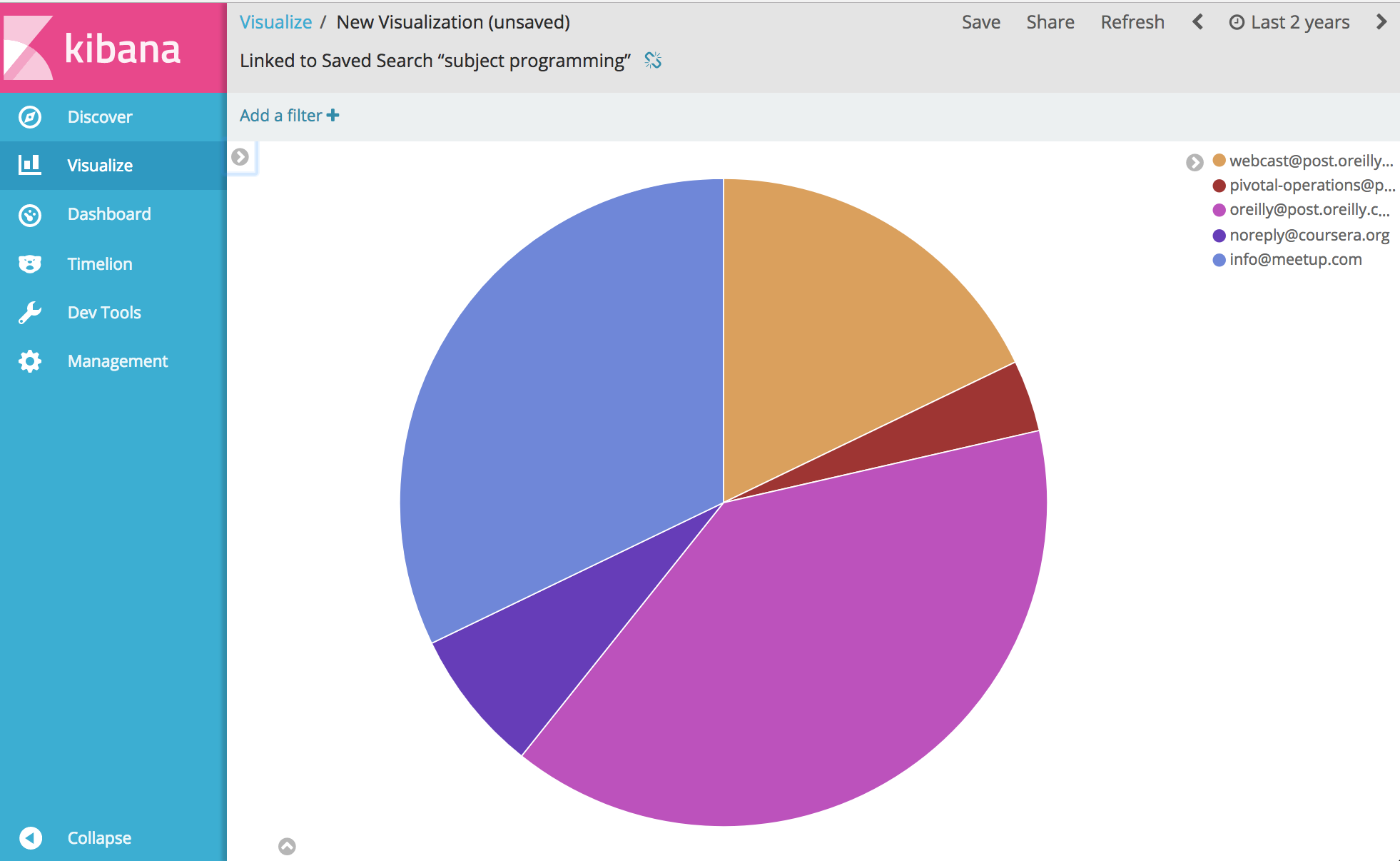

จากนั้น... คุณสามารถวิเคราะห์และแสดงภาพทุกอย่างเกี่ยวกับการสื่อสารของคุณได้ สนุก.

ก่อนที่จะรันตัวอย่างด้านล่าง คุณต้องติดตั้ง Docker ก่อน

Windows หมายเหตุ : เมื่อคุณ git clone เจ็กต์นี้บน Windows ก่อนที่จะสร้าง อย่าลืมเพิ่มแฟล็ก git clone --config core.autocrlf=input ตัวอย่าง git clone https://github.com/bitsofinfo/comms-analyzer-toolbox.git --config core.autocrlf=input อ่านเพิ่มเติมที่นี่

เมื่อติดตั้ง Docker แล้ว ให้เปิดเชลล์บรรทัดคำสั่งแล้วพิมพ์คำสั่งต่อไปนี้เพื่อสร้างอิมเมจนักเทียบท่าสำหรับกล่องเครื่องมือ:

docker build -t comms-analyzer-toolbox .

กล่องเครื่องมือ Docker สำหรับ Windows Notes

VM เครื่องนักเทียบท่า default ที่สร้างขึ้นมีแนวโน้มที่จะมีกำลังไม่เพียงพอในการรันสิ่งนี้ทันที คุณจะต้องทำสิ่งต่อไปนี้เพื่อเพิ่ม CPU และหน่วยความจำของเครื่องกล่องเสมือนในเครื่อง

เรียก "Docker Quickstart Terminal" ขึ้นมา

ลบเครื่องเริ่มต้น: docker-machine rm default

สร้างใหม่: docker-machine create -d virtualbox --virtualbox-cpu-count=[N cpus] --virtualbox-memory=[XXXX megabytes] --virtualbox-disk-size=[XXXXXX] default

การแก้ไขปัญหาข้อผิดพลาด: "พื้นที่หน่วยความจำเสมือนสูงสุด vm.max_map_count [65530] ต่ำเกินไป เพิ่มเป็นอย่างน้อย [262144]"

หากคุณเห็นข้อผิดพลาดนี้เมื่อเริ่มต้นกล่องเครื่องมือ (มีรายงานข้อผิดพลาดจาก Elasticsearch) คุณจะต้องดำเนินการต่อไปนี้บนโฮสต์นักเทียบท่าที่คอนเทนเนอร์กำลังเปิดใช้อยู่

sysctl -w vm.max_map_count=262144

หากคุณใช้ Docker Toolbox คุณต้องเชลล์ไปที่ boot2docker VM ก่อนโดยใช้ docker ssh default เพื่อรันคำสั่งนี้ หรือดำเนินการต่อไปนี้เพื่อทำให้เป็นแบบถาวร: docker/machine#3859

สำหรับข้อความอีเมลทุกข้อความในไฟล์ MBOX ของคุณ แต่ละข้อความจะกลายเป็นเอกสารแยกต่างหากใน ElasticSearch โดยที่ส่วนหัวอีเมลทั้งหมดได้รับการจัดทำดัชนีเป็นช่องแต่ละช่อง และเนื้อหาเนื้อหาทั้งหมดได้รับการจัดทำดัชนีและแยกออกจาก html/css/js

ตัวอย่างเช่น อีเมลแต่ละฉบับที่นำเข้าสู่ดัชนีจะมีช่องต่อไปนี้สำหรับการค้นหาและวิเคราะห์ใน Kibana (รวมถึงอื่นๆ อีกมากมาย)

เมื่อ Docker พร้อมใช้งานในระบบของคุณ ก่อนที่คุณจะเรียกใช้ comms-analyzer-toolbox คุณต้องมีอีเมลเพื่อวิเคราะห์ในรูปแบบ MBOX ด้านล่างนี้คือวิธีการส่งออกอีเมลจาก Gmail

เข้าสู่ระบบบัญชี Gmail ของคุณด้วยเว็บเบราว์เซอร์บนคอมพิวเตอร์

ไปที่: https://takeout.google.com/settings/takeout

บนหน้าจอที่ระบุว่า "ดาวน์โหลดข้อมูลของคุณ" ใต้ส่วน "เลือกข้อมูลที่จะรวม" คลิกที่ปุ่ม "เลือกไม่มี" การดำเนินการนี้จะทำให้ "ผลิตภัณฑ์" ทั้งหมดที่แสดงด้านล่างเป็นสีเทา

ตอนนี้เลื่อนลงและค้นหาส่วนสีเทาที่มีข้อความว่า "Mail" และคลิกที่ช่องทำเครื่องหมาย X ทางด้านขวามือ ตอนนี้จะเปลี่ยนเป็นสีเขียวเพื่อแสดงว่าข้อมูลนี้พร้อมให้คุณดาวน์โหลดแล้ว

เลื่อนลงและคลิกที่ปุ่ม "ถัดไป" สีน้ำเงิน

ปล่อยให้การตั้งค่า "ปรับแต่งรูปแบบไฟล์เก็บถาวร" เหมือนเดิมแล้วกดปุ่ม "สร้างไฟล์เก็บถาวร"

ตอนนี้จะนำคุณไปที่หน้า "เรากำลังเตรียมการเก็บถาวรของคุณ" หน้าจอ. การดำเนินการนี้อาจใช้เวลาสองสามชั่วโมง ขึ้นอยู่กับขนาดของอีเมลทั้งหมดที่คุณมี

คุณจะได้รับอีเมลจาก Google เมื่อไฟล์เก็บถาวรพร้อมให้ดาวน์โหลด เมื่อคุณได้รับมัน ให้ดาวน์โหลดไฟล์ zip ลงในฮาร์ดไดรฟ์ของคอมพิวเตอร์ของคุณ โดยจะมีชื่อว่า takeout-[YYYMMMDDD..].zip

เมื่อบันทึกลงในฮาร์ดไดรฟ์แล้ว คุณจะต้องคลายซิปไฟล์ เมื่อคลายซิปเมลที่ส่งออกทั้งหมดจาก Gmail แล้ว จะอยู่ในไฟล์ส่งออก mbox ในโฟลเดอร์ Takeout/Mail/ และชื่อไฟล์ที่มีเมลทั้งหมดของคุณอยู่ใน: All mail Including Spam and Trash.mbox

คุณควรเปลี่ยนชื่อไฟล์นี้เป็นชื่อที่ง่ายกว่า เช่น my-email.mbox

จดตำแหน่งของไฟล์ .mbox ของคุณ เนื่องจากคุณจะใช้ไฟล์ด้านล่างนี้เมื่อเรียกใช้กล่องเครื่องมือ

ก่อนที่จะรันตัวอย่างด้านล่าง คุณต้องติดตั้ง Docker ก่อน

เปิดเทอร์มินัลหรือพรอมต์คำสั่งบนคอมพิวเตอร์ของคุณและเรียกใช้สิ่งต่อไปนี้ ก่อนที่จะดำเนินการดังกล่าว คุณต้องแทนที่ PATH/TO/YOUR/email.mbox และ PATH/TO/ELASTICSEARCH_DATA_DIR ด้านล่างด้วยพาธที่เหมาะสมบนระบบภายในเครื่องของคุณตามความเหมาะสม

หมายเหตุ: หากใช้ Docker Toolbox สำหรับ Windows : โวลุ่มที่ติดตั้งทั้งหมดด้านล่างควรอยู่ที่ไหนสักแห่งภายใต้โฮมไดเร็กตอรี่ของคุณภายใต้ c:Users[your username]... เนื่องจากปัญหาการอนุญาต

docker run --rm -ti

--ulimit nofile=65536:65536

-v PATH/TO/YOUR/my-email.mbox:/toolbox/email.mbox

-v PATH/TO/ELASTICSEARCH_DATA_DIR:/toolbox/elasticsearch/data

comms-analyzer-toolbox:latest

python /toolbox/elasticsearch-gmail/src/index_emails.py

--infile=/toolbox/email.mbox

--init=[True | False]

--index-bodies=True

--index-bodies-ignore-content-types=application,image

--index-bodies-html-parser=html5lib

--index-name=comm_data

การตั้งค่า --init=True จะลบและสร้างดัชนี comm_data ขึ้นมาใหม่ การตั้งค่า --init=False จะเก็บข้อมูลที่มีอยู่แล้ว

คอนโซลจะบันทึกเอาท์พุตของสิ่งที่เกิดขึ้น เมื่อระบบบูทขึ้นมา คุณสามารถเปิดเว็บเบราว์เซอร์บนเดสก์ท็อปของคุณและไปที่ http://localhost:5601 เพื่อเริ่มใช้ Kibana เพื่อวิเคราะห์ข้อมูลของคุณ หมายเหตุ: หากใช้งานกล่องเครื่องมือนักเทียบท่า 'localhost' อาจใช้งานไม่ได้ ให้ดำเนินการตาม docker-machine env default เพื่อระบุที่อยู่ IP ของโฮสต์ docker จากนั้นไปที่ http://[machine-ip]:5601"

ในหน้าจอแรกที่ระบุว่า Configure an index pattern ในฟิลด์ Index name or pattern ที่คุณพิมพ์ comm_data คุณจะเห็นฟิลด์ date_ts ที่เลือกโดยอัตโนมัติ จากนั้นกดปุ่ม Create จากนั้น Kibana ก็พร้อมใช้งาน!

การเปิดตัวจะทำหลายสิ่งหลายอย่างตามลำดับต่อไปนี้

เมื่อตัวนำเข้า mbox ทำงาน คุณจะเห็นรายการต่อไปนี้ในบันทึก เนื่องจากระบบจะดำเนินการนำเข้าอีเมลของคุณจากไฟล์ mbox

...

[I 170825 18:46:53 index_emails:96] Upload: OK - upload took: 467ms, total messages uploaded: 1000

[I 170825 18:48:23 index_emails:96] Upload: OK - upload took: 287ms, total messages uploaded: 2000

...

เมื่อเรียกใช้อิมเมจ comms-analyzer-toolbox อาร์กิวเมนต์ข้อหนึ่งคือการเรียกใช้สคริปต์ elasticsearch-gmail ซึ่งรับอาร์กิวเมนต์ต่อไปนี้ คุณสามารถปรับคำสั่ง docker run ด้านบนเพื่อส่งผ่านแฟล็กต่อไปนี้ได้ตามที่คุณต้องการ:

Usage: /toolbox/elasticsearch-gmail/src/index_emails.py [OPTIONS]

Options:

--help show this help information

/toolbox/elasticsearch-gmail/src/index_emails.py options:

--batch-size Elasticsearch bulk index batch size (default

500)

--es-url URL of your Elasticsearch node (default

http://localhost:9200)

--index-bodies Will index all body content, stripped of

HTML/CSS/JS etc. Adds fields: 'body',

'body_size' and 'body_filenames' for any

multi-part attachments (default False)

--index-bodies-html-parser The BeautifulSoup parser to use for

HTML/CSS/JS stripping. Valid values

'html.parser', 'lxml', 'html5lib' (default

html.parser)

--index-bodies-ignore-content-types

If --index-bodies enabled, optional list of

body 'Content-Type' header keywords to match

to ignore and skip decoding/indexing. For

all ignored parts, the content type will be

added to the indexed field

'body_ignored_content_types' (default

application,image)

--index-name Name of the index to store your messages

(default gmail)

--infile The mbox input file

--init Force deleting and re-initializing the

Elasticsearch index (default False)

--num-of-shards Number of shards for ES index (default 2)

--skip Number of messages to skip from the mbox

file (default 0)

เมื่อนำเข้าข้อมูลอีเมล MBOX ในเอาต์พุตบันทึก คุณอาจเห็นคำเตือน/ข้อผิดพลาดดังต่อไปนี้

เป็นไปตามคาดหวังและโอเค เป็นเพียงคำเตือนเกี่ยวกับอักขระพิเศษบางตัวที่ไม่สามารถถอดรหัสได้ เป็นต้น

...

/usr/lib/python2.7/site-packages/bs4/__init__.py:282: UserWarning: "https://someurl.com/whatever" looks like a URL. Beautiful Soup is not an HTTP client. You should probably use an HTTP client like requests to get the document behind the URL, and feed that document to Beautiful Soup.

' that document to Beautiful Soup.' % decoded_markup

[W 170825 18:41:56 dammit:381] Some characters could not be decoded, and were replaced with REPLACEMENT CHARACTER.

[W 170825 18:41:56 dammit:381] Some characters could not be decoded, and were replaced with REPLACEMENT CHARACTER.

...

เครื่องมือนำเข้า CSV csv2es ที่ฝังอยู่ในกล่องเครื่องมือสามารถนำเข้าไฟล์ CSV ใดก็ได้ ไม่ใช่แค่รูปแบบตัวอย่างด้านล่างนี้

สำหรับข้อมูลทุกแถวในไฟล์ CSV แต่ละแถวจะกลายเป็นเอกสารแยกต่างหากใน ElasticSearch โดยที่คอลัมน์ CSV ทั้งหมดได้รับการจัดทำดัชนีเป็นแต่ละฟิลด์

ตัวอย่างเช่น แต่ละบรรทัดในไฟล์ข้อมูล CSV ด้านล่าง (ข้อความจาก iPhone) ที่นำเข้าไปยังดัชนีจะมีฟิลด์ต่อไปนี้สำหรับการค้นหาและวิเคราะห์ใน Kibana

"Name","Address","date_ts","Message","Attachment","iMessage"

"Me","+1 555-555-5555","7/17/2016 9:21:39 AM","How are you doing?","","True"

"Joe Smith","+1 555-444-4444","7/17/2016 9:38:56 AM","Pretty good you?","","True"

"Me","+1 555-555-5555","7/17/2016 9:39:02 AM","Great!","","True"

....

CSV การส่งออกข้อความข้างต้นเป็นเพียงตัวอย่างเท่านั้น เครื่องมือ csv2es ที่มาพร้อมกับกล่องเครื่องมือ สามารถนำเข้าชุดข้อมูลใดๆ ที่คุณต้องการได้ ไม่ใช่แค่รูปแบบตัวอย่างข้างต้น

เมื่อ Docker พร้อมใช้งานบนระบบของคุณ ก่อนที่คุณจะเรียกใช้ comms-analyzer-toolbox คุณจำเป็นต้องมีข้อมูลบางส่วนเพื่อวิเคราะห์ในรูปแบบ CSV ตามตัวอย่าง ด้านล่างนี้คือวิธีการส่งออกข้อความจาก iPhone ไปเป็นไฟล์ CSV

ส่งออกข้อความ iPhone โดยใช้ iExplorer สำหรับ Mac หรือ Windows

แก้ไขไฟล์ CSV ที่สร้างขึ้นและเปลี่ยนค่าส่วนหัวของแถวแรกของ "Time" เป็น "date_ts" บันทึกและออก

จดตำแหน่งของไฟล์ .csv ของคุณ เนื่องจากคุณจะใช้ไฟล์ด้านล่างนี้เมื่อเรียกใช้กล่องเครื่องมือ

ก่อนที่จะรันตัวอย่างด้านล่าง คุณต้องติดตั้ง Docker ก่อน

ตัวอย่างด้านล่างนี้ใช้สำหรับไฟล์ข้อมูล CSV ที่มีข้อมูลข้อความที่ส่งออกโดยใช้ IExplorer โดยเฉพาะ

เนื้อหาของ data.csv

"Name","Address","date_ts","Message","Attachment","iMessage"

"Me","+1 555-555-5555","7/17/2016 9:21:39 AM","How are you doing?","","True"

"Joe Smith","+1 555-444-4444","7/17/2016 9:38:56 AM","Pretty good you?","","True"

"Me","+1 555-555-5555","7/17/2016 9:39:02 AM","Great!","","True"

....

เนื้อหาของ csvdata.mapping.json

{

"dynamic": "true",

"properties": {

"date_ts": {"type": "date" },

"name": {"type": "string", "index" : "not_analyzed"},

"address": {"type": "string", "index" : "not_analyzed"},

"imessage": {"type": "string", "index" : "not_analyzed"}

}

}

เปิดเทอร์มินัลหรือพรอมต์คำสั่งบนคอมพิวเตอร์ของคุณและเรียกใช้สิ่งต่อไปนี้ ก่อนที่จะดำเนินการดังกล่าว คุณจะต้องแทนที่ PATH/TO/YOUR/data.csv , PATH/TO/YOUR/csvdata.mapping.json และ PATH/TO/ELASTICSEARCH_DATA_DIR ด้านล่างพร้อมเส้นทางที่เหมาะสมบนระบบภายในของคุณตามความเหมาะสม

หมายเหตุ: หากใช้ Docker Toolbox สำหรับ Windows : โวลุ่มที่ติดตั้งทั้งหมดด้านล่างควรอยู่ที่ไหนสักแห่งภายใต้โฮมไดเร็กตอรี่ของคุณภายใต้ c:Users[your username]... เนื่องจากปัญหาการอนุญาต

docker run --rm -ti -p 5601:5601

-v PATH/TO/YOUR/data.csv:/toolbox/data.csv

-v PATH/TO/YOUR/csvdata.mapping.json:/toolbox/csvdata.mapping.json

-v PATH/TO/ELASTICSEARCH_DATA_DIR:/toolbox/elasticsearch/data

comms-analyzer-toolbox:latest

python /toolbox/csv2es/csv2es.py

[--existing-index ]

[--delete-index ]

--index-name comm_data

--doc-type txtmsg

--mapping-file /toolbox/csvdata.mapping.json

--import-file /toolbox/data.csv

--delimiter ','

--csv-clean-fieldnames

--csv-date-field date_ts

--csv-date-field-gmt-offset -1

หากทำงานกับดัชนี comm_data ที่มีอยู่แล้ว ตรวจสอบให้แน่ใจว่าได้รวมแฟล็ก --existing-index เท่านั้น หากคุณต้องการสร้างดัชนี comm_data อีกครั้งก่อนที่จะนำเข้า ให้รวมแฟล็ก --delete-index เท่านั้น

คอนโซลจะบันทึกเอาท์พุตของสิ่งที่เกิดขึ้น เมื่อระบบบูทขึ้นมา คุณสามารถเปิดเว็บเบราว์เซอร์บนเดสก์ท็อปของคุณและไปที่ http://localhost:5601 เพื่อเริ่มใช้ Kibana เพื่อวิเคราะห์ข้อมูลของคุณ หมายเหตุ: หากใช้งานกล่องเครื่องมือนักเทียบท่า 'localhost' อาจใช้งานไม่ได้ ให้ดำเนินการตาม docker-machine env default เพื่อระบุที่อยู่ IP ของโฮสต์ docker จากนั้นไปที่ http://[machine-ip]:5601"

ในหน้าจอแรกที่ระบุว่า Configure an index pattern ในฟิลด์ Index name or pattern ที่คุณพิมพ์ comm_data คุณจะเห็นฟิลด์ date_ts ที่เลือกโดยอัตโนมัติ จากนั้นกดปุ่ม Create จากนั้น Kibana ก็พร้อมใช้งาน!

การเปิดตัวจะทำหลายสิ่งหลายอย่างตามลำดับต่อไปนี้

เมื่อตัวนำเข้า mbox ทำงาน คุณจะเห็นรายการต่อไปนี้ในบันทึก เนื่องจากระบบจะดำเนินการนำเข้าอีเมลของคุณจากไฟล์ mbox

เมื่อรันอิมเมจ comms-analyzer-toolbox หนึ่งในอาร์กิวเมนต์คือการเรียกใช้สคริปต์ csv2es ซึ่งรับอาร์กิวเมนต์ต่อไปนี้ คุณสามารถปรับคำสั่ง docker run ด้านบนเพื่อส่งผ่านแฟล็กต่อไปนี้ได้ตามที่คุณต้องการ:

Usage: /toolbox/csv2es/csv2es.py [OPTIONS]

Bulk import a delimited file into a target Elasticsearch instance. Common

delimited files include things like CSV and TSV.

Load a CSV file:

csv2es --index-name potatoes --doc-type potato --import-file potatoes.csv

For a TSV file, note the tab delimiter option

csv2es --index-name tomatoes --doc-type tomato --import-file tomatoes.tsv --tab

For a nifty pipe-delimited file (delimiters must be one character):

csv2es --index-name pipes --doc-type pipe --import-file pipes.psv --delimiter '|'

Options:

--index-name TEXT Index name to load data into

[required]

--doc-type TEXT The document type (like user_records)

[required]

--import-file TEXT File to import (or '-' for stdin)

[required]

--mapping-file TEXT JSON mapping file for index

--delimiter TEXT The field delimiter to use, defaults to CSV

--tab Assume tab-separated, overrides delimiter

--host TEXT The Elasticsearch host

(http://127.0.0.1:9200/)

--docs-per-chunk INTEGER The documents per chunk to upload (5000)

--bytes-per-chunk INTEGER The bytes per chunk to upload (100000)

--parallel INTEGER Parallel uploads to send at once, defaults

to 1

--delete-index Delete existing index if it exists

--existing-index Don't create index.

--quiet Minimize console output

--csv-clean-fieldnames Strips double quotes and lower-cases all CSV

header names for proper ElasticSearch

fieldnames

--csv-date-field TEXT The CSV header name that represents a date

string to parsed (via python-dateutil) into

an ElasticSearch epoch_millis

--csv-date-field-gmt-offset INTEGER

The GMT offset for the csv-date-field (i.e.

+/- N hours)

--tags TEXT Custom static key1=val1,key2=val2 pairs to

tag all entries with

--version Show the version and exit.

--help Show this message and exit.

การทำงานในโหมดนี้จะเป็นการเปิดตัว elasticsearch และ kibana และจะไม่นำเข้าอะไรเลย มันเพียงเปิดกล่องเครื่องมือขึ้นมาเพื่อให้คุณสามารถวิเคราะห์ข้อมูลที่นำเข้าก่อนหน้านี้ซึ่งอยู่ใน ElasticSearch

หมายเหตุ: หากใช้ Docker Toolbox สำหรับ Windows : โวลุ่มที่ติดตั้งทั้งหมดด้านล่างควรอยู่ที่ไหนสักแห่งภายใต้โฮมไดเร็กตอรี่ของคุณภายใต้ c:Users[your username]... เนื่องจากปัญหาการอนุญาต

docker run --rm -ti -p 5601:5601

-v PATH/TO/ELASTICSEARCH_DATA_DIR:/toolbox/elasticsearch/data

comms-analyzer-toolbox:latest

analyze-only

ต้องการควบคุมตัวเลือกฮีปหน่วยความจำ ElasticSearch JVM เริ่มต้นที่คุณสามารถทำได้ผ่านตัวแปรสภาพแวดล้อมนักเทียบท่า เช่น -e ES_JAVA_OPTS="-Xmx1g -Xms1g" เป็นต้น

สำหรับ hotmail/outlook คุณต้องส่งออกเป็น PST จากนั้นในขั้นตอนที่ 2 ให้แปลงเป็น MBOX

การใช้เครื่องมือนี้จะเกิดขึ้นเฉพาะกับเครื่องใดก็ตามที่คุณใช้เครื่องมือนี้ (เช่น โฮสต์ Docker ของคุณ) ในกรณีที่ใช้งานบนแล็ปท็อปหรือคอมพิวเตอร์เดสก์ท็อปจะเป็นแบบท้องถิ่น 100%

ข้อมูลจะไม่ถูกอัพโหลดหรือถ่ายโอนที่ใดก็ได้

ข้อมูลจะไม่ไปที่อื่นนอกจากบนดิสก์ในเครื่องไปยังโฮสต์ Docker ที่กำลังทำงานอยู่

หากต้องการลบข้อมูลที่วิเคราะห์ออกโดยสมบูรณ์ คุณสามารถ docker rm -f [container-id] ของคอนเทนเนอร์ comms-analyzer-toolbox ที่ทำงานบนเครื่องของคุณได้

หากคุณติดตั้งไดเร็กทอรีข้อมูล elasticsearch ผ่านโวลุ่มบนโฮสต์ (เช่น -v PATH/TO/ELASTICSEARCH_DATA_DIR:/toolbox/elasticsearch/data ) ไดเร็กทอรีในเครื่องนั้นเป็นที่ที่ข้อมูลที่จัดทำดัชนีทั้งหมดอยู่ในเครื่องบนดิสก์