สนทนากับโมเดลภาษาเชิงสร้างสรรค์ในเครื่องคอมพิวเตอร์ของคุณโดยไม่ต้องตั้งค่าใดๆ LocalChat เป็นแชท AI ท้องถิ่นแบบโอเพ่นซอร์สที่เรียบง่าย ติดตั้งง่าย สร้างขึ้นบน llama.cpp ไม่จำเป็นต้องมีความรู้ด้านเทคนิคและช่วยให้ผู้ใช้สัมผัสประสบการณ์พฤติกรรมที่คล้ายกับ ChatGPT บนเครื่องของตนเอง — เป็นไปตามข้อกำหนด GDPR โดยสมบูรณ์และไม่ต้องกลัวว่าข้อมูลจะรั่วไหลโดยไม่ได้ตั้งใจ ดาวน์โหลด LocalChat สำหรับ macOS, Windows หรือ Linux ที่นี่

สารบัญ

ภาพรวม | เหตุผล | ความต้องการของระบบ | เริ่มต้นอย่างรวดเร็ว | เอกสารประกอบ

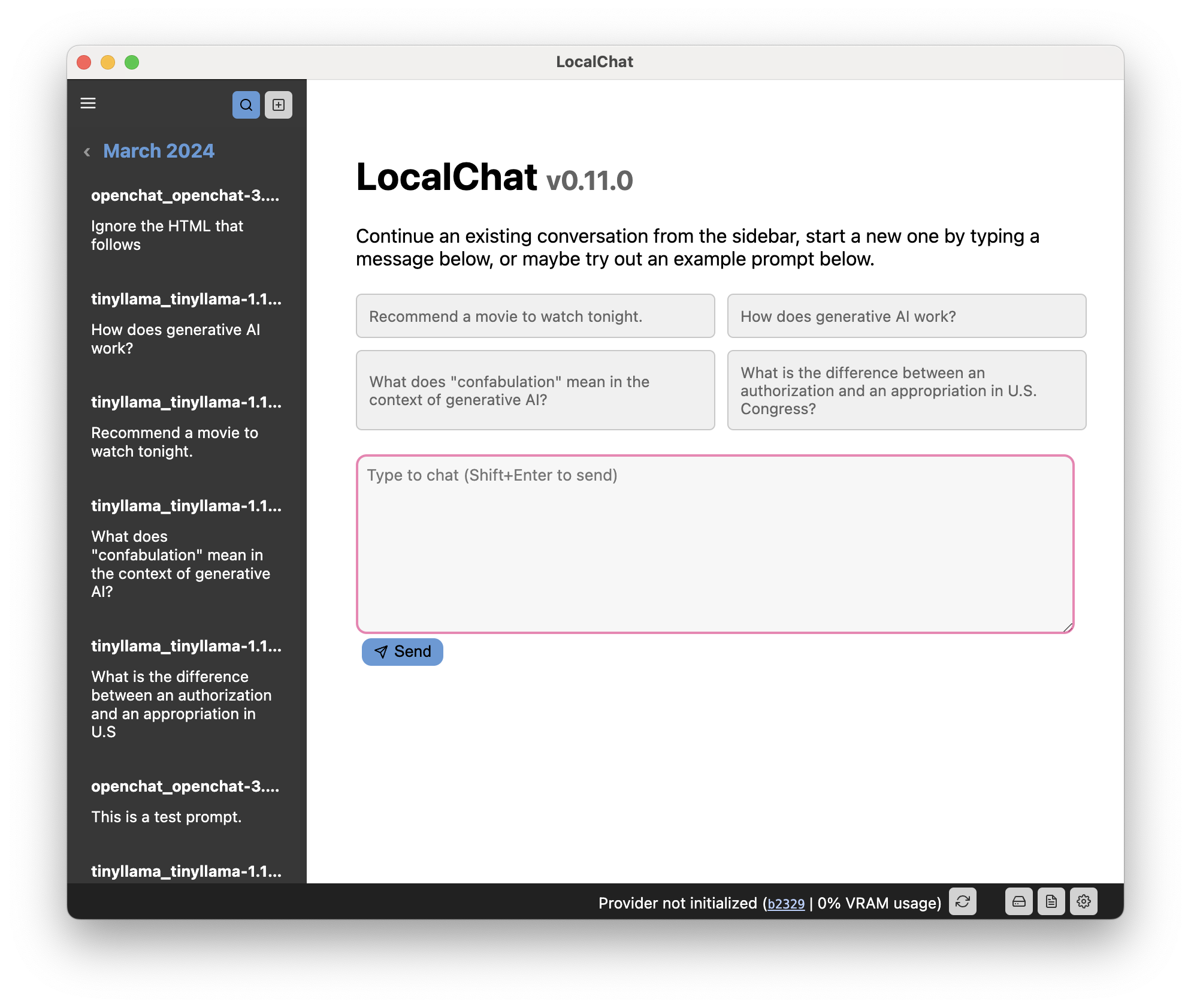

LocalChat มีอินเทอร์เฟซเหมือนการแชทสำหรับการโต้ตอบกับ generative Large Language Models (LLM) ดูเหมือนและให้ความรู้สึกเหมือนการสนทนาแชท แต่เกิดขึ้นภายในเครื่องคอมพิวเตอร์ของคุณ ไม่มีการส่งข้อมูลไปยังเซิร์ฟเวอร์คลาวด์บางแห่ง

มีโมเดลภาษากำเนิดที่มีความสามารถสูงอยู่หลายโมเดลซึ่งมีรูปลักษณ์และความรู้สึกเกือบจะเหมือนกับ ChatGPT ข้อแตกต่างที่สำคัญคือโมเดลเหล่านั้นทำงานภายในเครื่องและเป็นแบบเปิด

สำคัญ

ดังที่คุณคงทราบอยู่แล้วว่าการสนทนากับ LLM อาจรู้สึกเป็นธรรมชาติมาก แต่แบบจำลองต่างๆ ยังคงมีความน่าจะเป็น: พวกเขาจะสร้างคำที่เป็นไปได้ถัดไปโดยอิงจากสิ่งอื่นที่อยู่ในพรอมต์ LLM ไม่มีความรู้สึกเกี่ยวกับเวลา ความเป็นเหตุเป็นผล บริบท และสิ่งที่นักภาษาศาสตร์เรียกว่าเชิงปฏิบัติ ดังนั้นพวกเขาจึงมีแนวโน้มที่จะประดิษฐ์เหตุการณ์ที่ไม่เคยเกิดขึ้น ผสมผสานข้อเท็จจริงจากเหตุการณ์ที่แตกต่างกันโดยสิ้นเชิง หรือเล่าเรื่องโกหกตรงๆ (เรียกว่า "ภาพหลอน") เช่นเดียวกับโค้ดหรือการคำนวณที่โมเดลเหล่านี้สามารถส่งออกได้ ที่ถูกกล่าวว่า:

ใช้ความระมัดระวังและใช้แบบจำลองนี้โดยยอมรับความเสี่ยงเอง โปรดทราบว่ามันเป็นของเล่น ไม่ใช่สิ่งที่น่าเชื่อถือ

เมื่อ ChatGPT เปิดตัวในเดือนพฤศจิกายน 2022 ฉันตื่นเต้นมาก แต่ก็ระมัดระวังเช่นกัน แม้ว่าฉันจะประทับใจมากกับความสามารถของ GPT-3 แต่ฉันก็ตระหนักดีว่าโมเดลดังกล่าวเป็นกรรมสิทธิ์ และแม้ว่าจะไม่เป็นเช่นนั้น แต่ก็เป็นไปไม่ได้ที่จะเรียกใช้ในเครื่อง ในฐานะพลเมืองชาวยุโรปที่ตระหนักถึงความเป็นส่วนตัว ฉันไม่ชอบความคิดที่ต้องพึ่งพาบริษัทมูลค่าหลายพันล้านดอลลาร์ที่สามารถตัดสิทธิ์การเข้าถึงได้ทุกเมื่อ

ด้วยเหตุนี้ ฉันจึงไม่สามารถเล่นกับ GPT ได้จริงๆ และตัดสินใจที่จะรอสิ่งที่หลีกเลี่ยงไม่ได้ นั่นก็คือการพัฒนาเครื่องมือที่มีขนาดเล็กลงและดีขึ้น ขณะนี้มีหลายรุ่นที่ทำเครื่องหมายในช่องทั้งหมด: รุ่นเหล่านี้ทำงานภายในเครื่อง และ ให้ความรู้สึกเหมือน ChatGPT ด้วยการหาปริมาณ (ซึ่งโดยทั่วไปจะลดความละเอียดโดยสูญเสียคุณภาพบางส่วน) จึงสามารถรันบนฮาร์ดแวร์รุ่นเก่าได้

อย่างไรก็ตาม หากคุณไม่มีประสบการณ์ใดๆ เกี่ยวกับ LLM การดำเนินการ ดังกล่าวก็จะเป็นเรื่องยาก

สาเหตุที่ทำให้แอปนี้มีอยู่ก็คือ (ก) ฉันต้องการใช้สิ่งนี้ด้วยตัวเองเพื่อดูว่ามันทำงานอย่างไรตามหลักสรีรศาสตร์ และ (ข) ฉันต้องการสร้างเลเยอร์ที่เรียบง่ายสำหรับการโต้ตอบกับสิ่งเหล่านี้โดยไม่ต้องกังวลกับการตั้งค่า PyTorch และ หม้อแปลงไฟฟ้าในพื้นที่

คุณเพียงแค่ติดตั้งแอป ดาวน์โหลดโมเดล และใช้งานได้ทันที

แอปนี้ต้องใช้คอมพิวเตอร์เวอร์ชันล่าสุดพอสมควรจึงจะรันได้ อย่างไรก็ตาม แอปนี้ขึ้นอยู่กับ LLM ซึ่งมีชื่อเสียงในด้านการใช้พลังงานมาก ดังนั้นฮาร์ดแวร์คอมพิวเตอร์ของคุณจะเป็นตัวกำหนดว่าคุณสามารถใช้งานได้กับรุ่นใด

รุ่นขนาด "ปกติ" น่าจะต้องใช้การ์ดกราฟิกเฉพาะที่มีหน่วยความจำวิดีโอระหว่าง 6 ถึง 18 GB เว้นแต่คุณจะยินดีรอนานกว่าหนึ่งวินาทีต่อคำ

ทุกวันนี้โมเดลจำนวนมากมาในรูปแบบเชิงปริมาณ ซึ่งทำให้โมเดลขนาดใหญ่สามารถใช้ได้กับฮาร์ดแวร์รุ่นเก่าหรือที่มีประสิทธิภาพน้อยกว่าด้วย บางครั้งการหาปริมาณจะลดความต้องการของระบบของรุ่นที่มีขนาดใหญ่เกินไปลงได้มากโดยไม่สูญเสียคุณภาพมากเกินไป (แต่ระยะทางของคุณอาจแตกต่างกันไปในแต่ละรุ่น)

สำคัญ

เนื่องจากเป็นโมเดลภาษาขนาดใหญ่ การสร้างคำตอบจะใช้เวลาสักครู่ ดังนั้นโดยเฉพาะอย่างยิ่งหากคุณไม่มี GPU เฉพาะในคอมพิวเตอร์ของคุณ โปรดอดทนรอหรือลองใช้รุ่นที่เล็กกว่า

เคล็ดลับ

คุณสามารถดูเอกสารฉบับเต็มได้จากเว็บไซต์ของแอป

อินเทอร์เฟซผู้ใช้แบ่งออกเป็นสามองค์ประกอบหลัก:

รหัสนี้ได้รับอนุญาตผ่าน GNU GPL 3.0 อ่านเพิ่มเติมในไฟล์ LICENSE