การรวบรวม AI ที่น่ารังเกียจ

รายการแหล่งข้อมูลที่เป็นประโยชน์ซึ่งครอบคลุมถึง Offensive AI

- เนื้อหา ?

- ใช้ในทางที่ผิด

- - การเรียนรู้ของเครื่องฝ่ายตรงข้าม ?

- ⚡ การโจมตี ⚡

- การสกัด

- ข้อจำกัด

- ️ การดำเนินการป้องกัน ⁉ ️

- - ลิงค์ที่มีประโยชน์ ?

- ⬅️ การผกผัน (หรือการอนุมาน) ⬅️

- ️ การดำเนินการป้องกัน ⁉ ️

- - ลิงค์ที่มีประโยชน์ ?

- - พิษ?

- - แบ็คดอร์ ?

- ️ การดำเนินการป้องกัน ⁉ ️

- - ลิงค์ที่มีประโยชน์ ?

- ?♂️ การหลบหลีก ?♂️

- ️ การดำเนินการป้องกัน ⁉ ️

- - ลิงค์ที่มีประโยชน์ ?

- เครื่องมือ

- - ใช้ ?

- ♂️ บททดสอบ ♂️

- - มัลแวร์ ?

- ️โอซินต์ ⁉️

- - ฟิชชิ่ง ?

- ?? AI กำเนิด ??

- - เสียง ?

- เครื่องมือ

- การใช้งาน

- - การตรวจจับ ?

- - ภาพ ?

- เครื่องมือ

- การใช้งาน

- - การตรวจจับ ?

- - วีดีโอ ?

- เครื่องมือ

- การใช้งาน

- - การตรวจจับ ?

- - ข้อความ ?

- เครื่องมือ

- - การตรวจจับ ?

- การใช้งาน

- เบ็ดเตล็ด

- แบบสำรวจ

- - ผู้ร่วมให้ข้อมูล ?

- ©️ใบอนุญาต©️

ใช้ในทางที่ผิด

การใช้ประโยชน์จากช่องโหว่ของโมเดล AI

- การเรียนรู้ของเครื่องฝ่ายตรงข้าม ?

การเรียนรู้ของเครื่องฝ่ายตรงข้ามมีหน้าที่รับผิดชอบในการประเมินจุดอ่อนและจัดเตรียมมาตรการรับมือ

⚡ การโจมตี ⚡

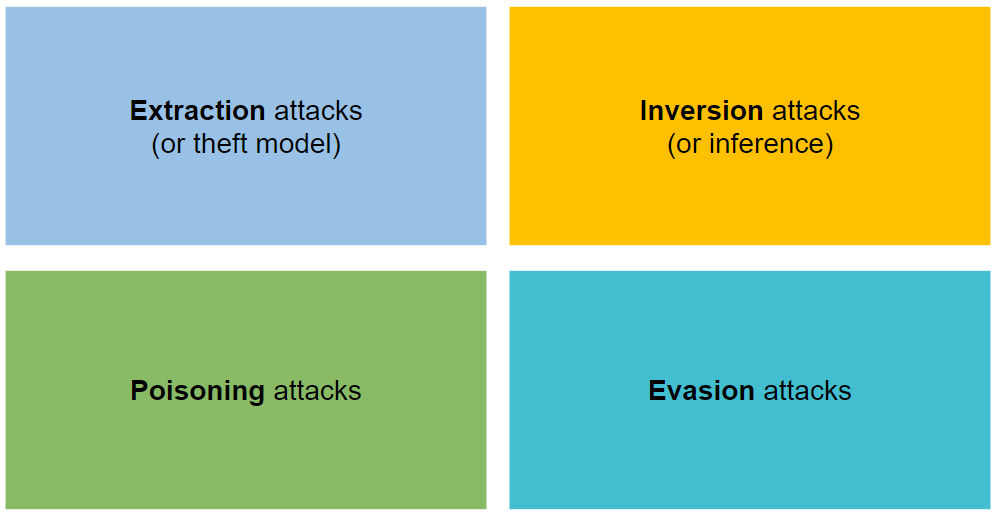

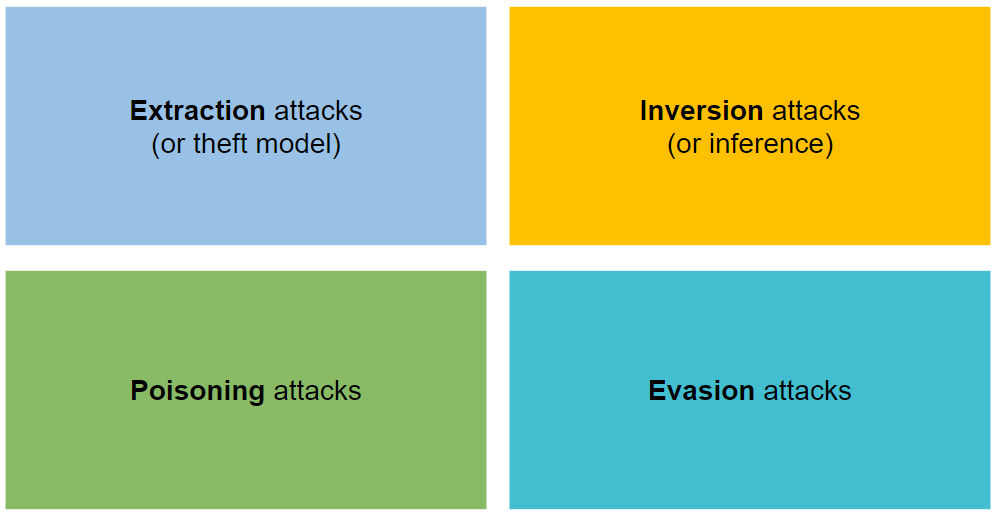

แบ่งออกเป็นการโจมตีสี่ประเภท: การสกัด การผกผัน การวางยาพิษ และการหลบหลีก

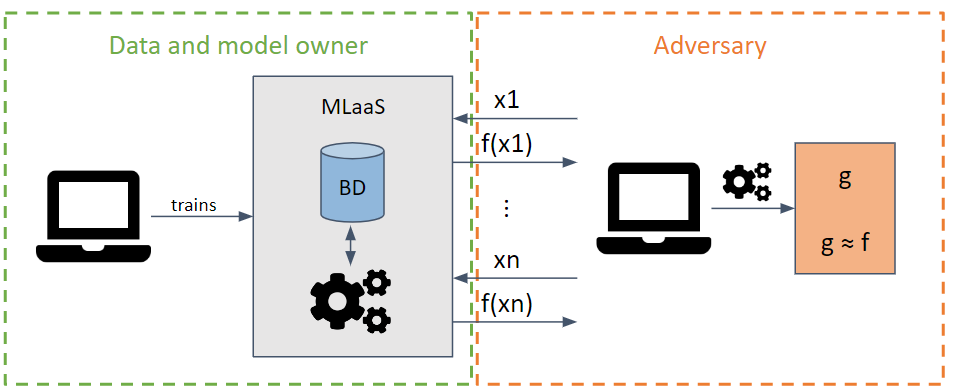

การสกัด

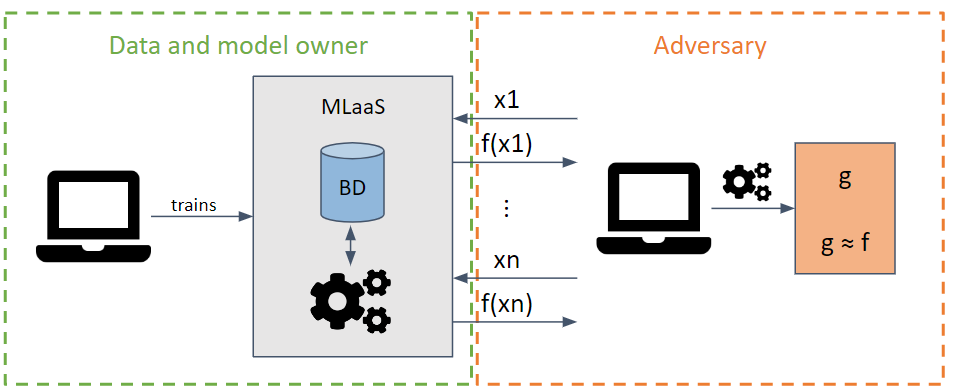

มันพยายามขโมยพารามิเตอร์และไฮเปอร์พารามิเตอร์ของโมเดลโดยส่งคำขอที่ดึงข้อมูลได้สูงสุด

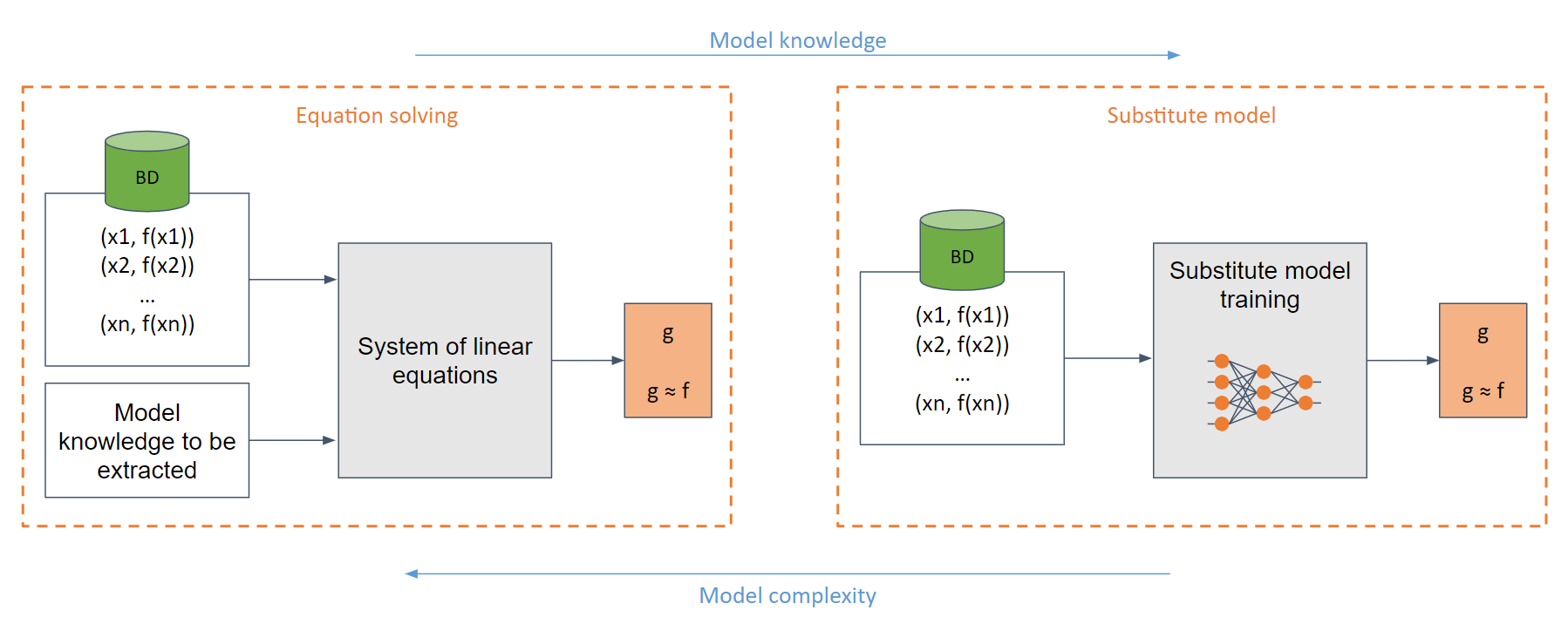

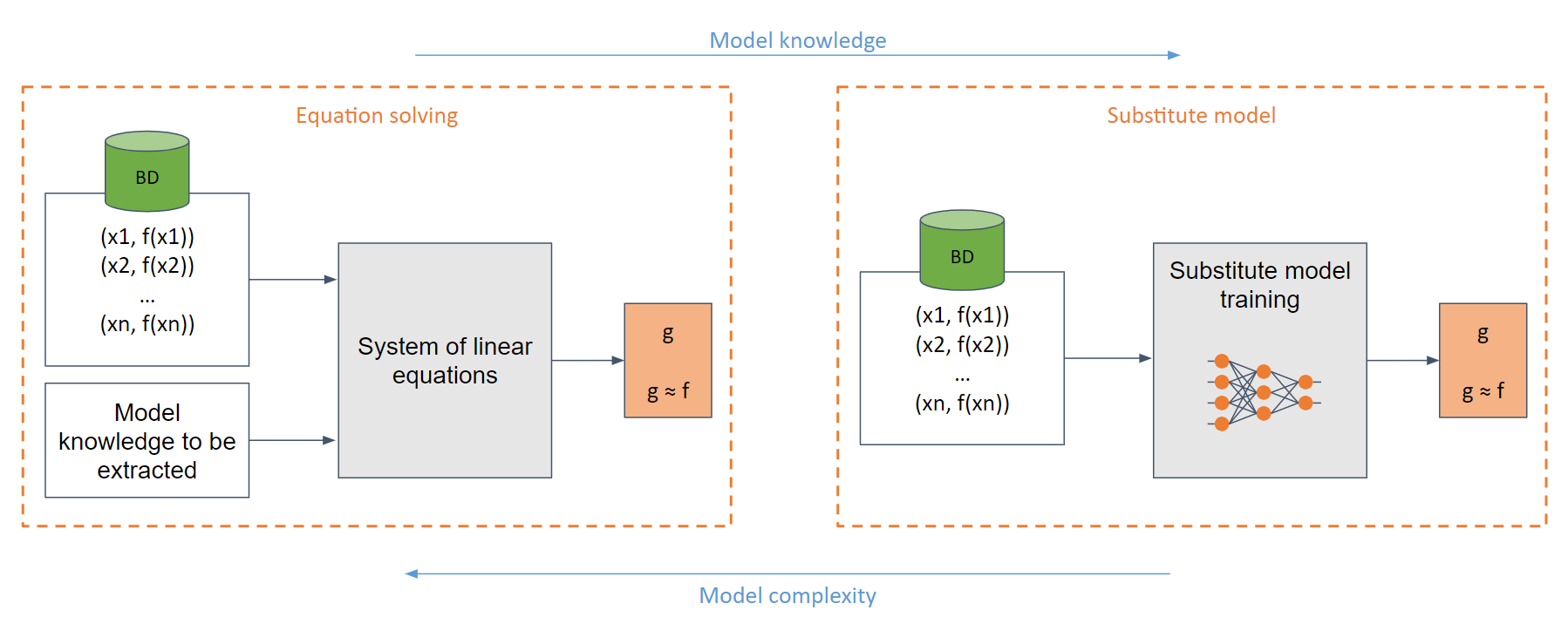

ขึ้นอยู่กับความรู้ของแบบจำลองของฝ่ายตรงข้าม การโจมตีแบบกล่องขาวและกล่องดำสามารถทำได้

ในกรณีกล่องสีขาวที่ง่ายที่สุด (เมื่อฝ่ายตรงข้ามมีความรู้ครบถ้วนเกี่ยวกับแบบจำลอง เช่น ฟังก์ชันซิกมอยด์) เราสามารถสร้างระบบสมการเชิงเส้นที่สามารถแก้ได้อย่างง่ายดาย

ในกรณีทั่วไป ซึ่งมีความรู้ไม่เพียงพอเกี่ยวกับแบบจำลอง จะใช้แบบจำลองทดแทน โมเดลนี้ได้รับการฝึกตามคำขอที่ทำกับโมเดลดั้งเดิมเพื่อเลียนแบบฟังก์ชันการทำงานเดียวกันกับโมเดลดั้งเดิม

ข้อจำกัด

️ การดำเนินการป้องกัน ⁉ ️

- ลิงค์ที่มีประโยชน์ ?

- การขโมยโมเดล Machine Learning ผ่าน Prediction API

- การขโมยไฮเปอร์พารามิเตอร์ในการเรียนรู้ของเครื่อง

- Knockoff Nets: การขโมยฟังก์ชันการทำงานของรุ่น Black-Box

- คำเตือนการแยกโมเดลในกระบวนทัศน์ MLaaS

- Copycat CNN: ขโมยความรู้ด้วยการโน้มน้าวคำสารภาพด้วยข้อมูลแบบสุ่มที่ไม่มีป้ายกำกับ

- พิษจากการคาดการณ์: สู่การป้องกันการโจมตีที่ขโมยโมเดล DNN

- การขโมยโครงข่ายประสาทเทียมผ่าน Timing Side Channels

- โมเดลการขโมยการโจมตีต่อโครงข่ายประสาทเทียมแบบกราฟอุปนัย

- ความแม่นยำสูงและการสกัดโครงข่ายประสาทเทียมที่มีความเที่ยงตรงสูง

- ชุดข้อมูลการฝึกอบรม Web-Scale ที่เป็นพิษนั้นใช้ได้จริง

- การสกัดด้วยการเข้ารหัสลับเวลาพหุนามของโมเดลโครงข่ายประสาทเทียม

- การโจมตีแบบเป็นพิษเฉพาะเจาะจงทันทีในโมเดลการสร้างข้อความเป็นรูปภาพ

- การเป็นพิษต่อข้อมูลและการโจมตีลับๆ ที่ยอดเยี่ยม: รายการเอกสารและทรัพยากรที่รวบรวมไว้ซึ่งเชื่อมโยงกับการเป็นพิษของข้อมูล การโจมตีลับๆ และการป้องกันพวกเขา

- BackdoorBox: กล่องเครื่องมือ Python แบบโอเพ่นซอร์สสำหรับการโจมตีและป้องกันประตูหลัง

- การขโมยส่วนหนึ่งของโมเดลภาษาการผลิต

- การสกัดการเข้ารหัสลับแบบฮาร์ดเลเบลของโมเดลโครงข่ายประสาทเทียม

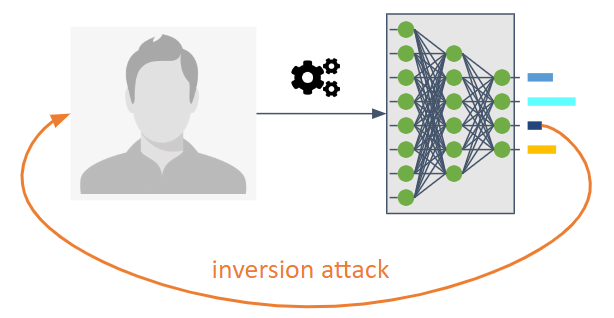

⬅️ การผกผัน (หรือการอนุมาน) ⬅️

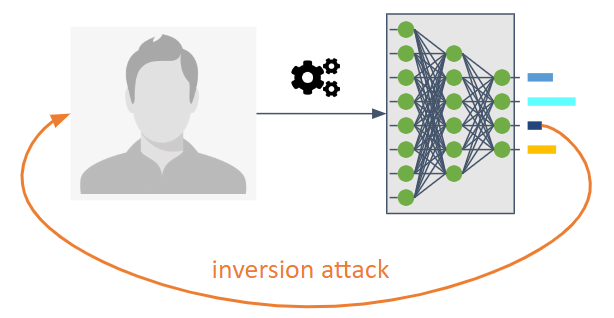

มีวัตถุประสงค์เพื่อย้อนกลับการไหลของข้อมูลของโมเดลแมชชีนเลิร์นนิง

ช่วยให้ฝ่ายตรงข้ามทราบโมเดลที่ไม่ได้ตั้งใจจะแชร์อย่างชัดเจน

ช่วยให้เราทราบข้อมูลการฝึกอบรมหรือข้อมูลที่เป็นคุณสมบัติทางสถิติของแบบจำลอง

เป็นไปได้สามประเภท:

Membership Inference Attack (MIA) : ฝ่ายตรงข้ามพยายามตรวจสอบว่ากลุ่มตัวอย่างถูกใช้เป็นส่วนหนึ่งของการฝึกอบรมหรือไม่

การโจมตีด้วยการอนุมานทรัพย์สิน (PIA) : ฝ่ายตรงข้ามมีเป้าหมายเพื่อแยกคุณสมบัติทางสถิติที่ไม่ได้เข้ารหัสไว้อย่างชัดเจนเป็นคุณสมบัติในระหว่างขั้นตอนการฝึกอบรม

การสร้างใหม่ : ฝ่ายตรงข้ามพยายามสร้างตัวอย่างตั้งแต่หนึ่งตัวอย่างขึ้นไปจากชุดการฝึกและ/หรือป้ายกำกับที่เกี่ยวข้อง เรียกอีกอย่างว่าการผกผัน

️ การดำเนินการป้องกัน ⁉ ️

การใช้การเข้ารหัสขั้นสูง มาตรการตอบโต้ ได้แก่ ความเป็นส่วนตัวที่แตกต่าง การเข้ารหัสแบบโฮโมมอร์ฟิก และการคำนวณหลายฝ่ายที่ปลอดภัย

การใช้เทคนิคการทำให้เป็นมาตรฐาน เช่น การออกกลางคันเนื่องจากความสัมพันธ์ระหว่างการฝึกมากเกินไปและความเป็นส่วนตัว

มีการเสนอการบีบอัดแบบจำลองเพื่อป้องกันการโจมตีด้วยการสร้างใหม่

- ลิงค์ที่มีประโยชน์ ?

- การโจมตีการอนุมานสมาชิกกับโมเดลการเรียนรู้ของเครื่อง

- โมเดลการโจมตีแบบผกผันที่ใช้ประโยชน์จากข้อมูลความเชื่อมั่นและมาตรการตอบโต้ขั้นพื้นฐาน

- โมเดลการเรียนรู้ของเครื่องที่จดจำมากเกินไป

- ML-Leaks: โมเดลและข้อมูลการโจมตีและการป้องกันการอนุมานการเป็นสมาชิกอิสระบนโมเดลการเรียนรู้ของเครื่อง

- โมเดลเชิงลึกภายใต้ GAN: การรั่วไหลของข้อมูลจากการเรียนรู้เชิงลึกแบบร่วมมือกัน

- LOGAN: การโจมตีการอนุมานสมาชิกภาพต่อโมเดลเจนเนอเรทีฟ

- การติดตั้งมากเกินไป ความคงทน และอัลกอริธึมที่เป็นอันตราย: การศึกษาสาเหตุที่เป็นไปได้ของความเสี่ยงด้านความเป็นส่วนตัวในการเรียนรู้ของเครื่อง

- การวิเคราะห์ความเป็นส่วนตัวที่ครอบคลุมของการเรียนรู้เชิงลึก: การเรียนรู้แบบสแตนด์อโลนและแบบรวมศูนย์ภายใต้การโจมตีแบบอนุมานไวท์บ็อกซ์แบบพาสซีฟและแบบแอคทีฟ

- การโจมตีแบบอนุมานต่อการเรียนรู้แบบร่วมมือกัน

- ผู้แบ่งปันความลับ: การประเมินและทดสอบการท่องจำโดยไม่ได้ตั้งใจในโครงข่ายประสาทเทียม

- สู่ศาสตร์แห่งความปลอดภัยและความเป็นส่วนตัวในการเรียนรู้ของเครื่อง

- MemGuard: ป้องกันการโจมตีโดยอนุมานสมาชิก Black-Box ผ่านตัวอย่างฝ่ายตรงข้าม

- การแยกข้อมูลการฝึกอบรมจากโมเดลภาษาขนาดใหญ่

- การโจมตีการอนุมานทรัพย์สินบนโครงข่ายประสาทเทียมที่เชื่อมต่ออย่างสมบูรณ์โดยใช้การแทนค่าคงที่ของการเรียงสับเปลี่ยน

- การแยกข้อมูลการฝึกอบรมจากแบบจำลองการแพร่กระจาย

- การสร้างภาพความละเอียดสูงขึ้นใหม่ด้วยแบบจำลองการแพร่กระจายแฝงจากการทำงานของสมองมนุษย์

- การขโมยและหลบเลี่ยงตัวแยกประเภทมัลแวร์และโปรแกรมป้องกันไวรัสที่มีเงื่อนไขผลบวกลวงต่ำ

- การโจมตีด้วยการนำเสนอลายนิ้วมือที่สมจริงโดยใช้แนวทางของฝ่ายตรงข้าม

- การทดสอบฝ่ายตรงข้ามที่ใช้งานอยู่: เพิ่มความมั่นใจในการประเมินความแข็งแกร่งของฝ่ายตรงข้าม

- สถานะการแหกคุก GPT: อัปเดตสถานะการแหกคุกโมเดลภาษา OpenAI GPT

- ลำดับความสำคัญ Speedups สำหรับการอนุมานสมาชิก LLM

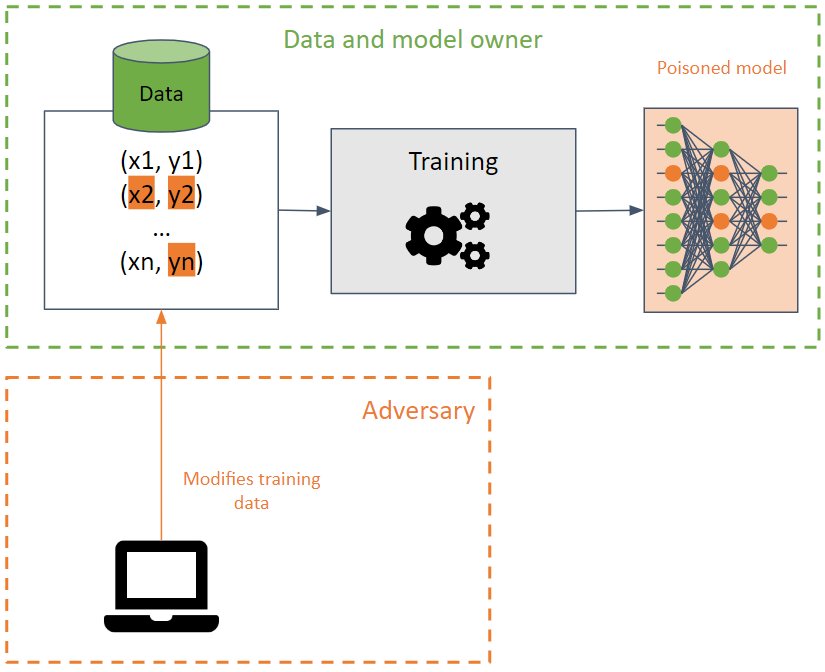

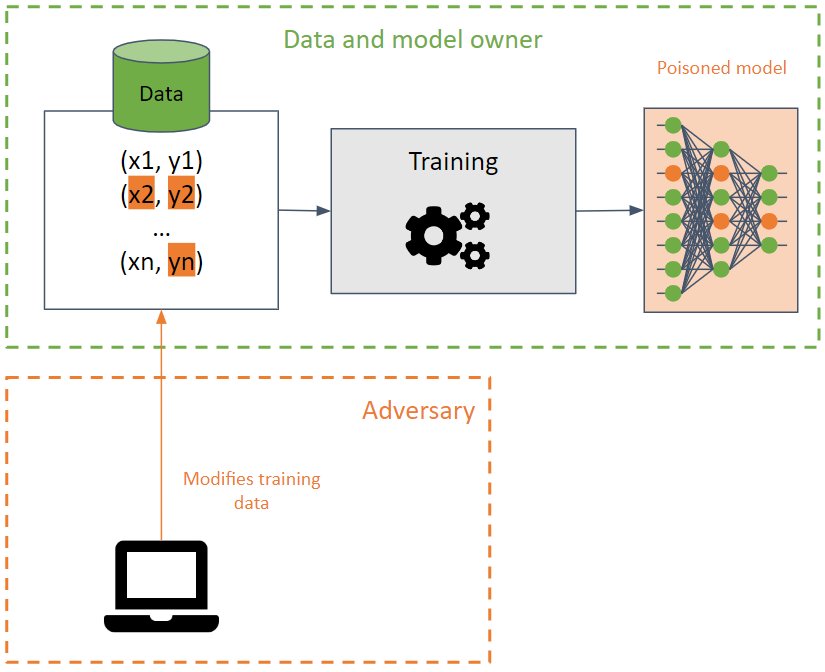

- พิษ?

พวกเขามุ่งหวังที่จะทำลายชุดการฝึกอบรมโดยทำให้โมเดลการเรียนรู้ของเครื่องลดความแม่นยำลง

การโจมตีนี้ตรวจพบได้ยากเมื่อดำเนินการกับข้อมูลการฝึก เนื่องจากการโจมตีสามารถแพร่กระจายไปยังโมเดลต่างๆ โดยใช้ข้อมูลการฝึกเดียวกัน

ฝ่ายตรงข้ามพยายามที่จะทำลายความพร้อมใช้งานของแบบจำลองโดยการแก้ไขขอบเขตการตัดสินใจ และเป็นผลให้เกิดการคาดการณ์ที่ไม่ถูกต้อง หรือสร้างประตูหลังในแบบจำลอง ในกรณีส่วนใหญ่ โมเดลจะทำงานอย่างถูกต้อง (ส่งคืนการคาดการณ์ที่ต้องการ) ยกเว้นอินพุตบางอย่างที่สร้างขึ้นเป็นพิเศษโดยฝ่ายตรงข้ามซึ่งให้ผลลัพธ์ที่ไม่ต้องการ ฝ่ายตรงข้ามสามารถจัดการผลลัพธ์ของการคาดการณ์และเปิดการโจมตีในอนาคตได้

- แบ็คดอร์ ?

BadNets เป็นแบ็คดอร์ประเภทที่ง่ายที่สุดในโมเดลแมชชีนเลิร์นนิง ยิ่งไปกว่านั้น BadNets ยังสามารถรักษาไว้ในโมเดลได้ แม้ว่าจะถูกฝึกใหม่อีกครั้งสำหรับงานที่แตกต่างจากโมเดลดั้งเดิม (การเรียนรู้แบบถ่ายโอน)

สิ่งสำคัญคือต้องทราบว่า โมเดลสาธารณะที่ได้รับการฝึกอบรมล่วงหน้าอาจมีแบ็คดอร์

️ การดำเนินการป้องกัน ⁉ ️

- ลิงค์ที่มีประโยชน์ ?

- การโจมตีพิษต่อเครื่องเวกเตอร์สนับสนุน

- การโจมตีแบบแบ็คดอร์แบบกำหนดเป้าหมายบนระบบการเรียนรู้เชิงลึกโดยใช้ข้อมูลเป็นพิษ

- การโจมตีแบบโทรจันบนโครงข่ายประสาทเทียม

- การตัดแต่งกิ่งแบบละเอียด: การป้องกันการโจมตีแบบแบ็คดอร์บนโครงข่ายประสาทเทียมเชิงลึก

- กบพิษ! การโจมตีแบบ Clean-Label Poisoning แบบกำหนดเป้าหมายบนโครงข่ายประสาทเทียม

- ลายเซ็นสเปกตรัมในการโจมตีลับๆ

- การโจมตีแบ็คดอร์แฝงบนเครือข่าย Deep Neural

- Regula Sub-rosa: การโจมตีแบ็คดอร์แฝงบนเครือข่าย Deep Neural

- การโจมตีลับๆ ที่ซ่อนอยู่

- การโจมตีพิษแบบ Clean-Label ที่ถ่ายโอนได้บน Deep Neural Nets

- TABOR: วิธีการที่แม่นยำสูงในการตรวจสอบและกู้คืนแบ็คดอร์โทรจันในระบบ AI

- สู่พิษของอัลกอริทึมการเรียนรู้เชิงลึกด้วยการเพิ่มประสิทธิภาพการไล่ระดับสีด้านหลัง

- การเรียนรู้ของเครื่องล้มเหลวเมื่อใด ความสามารถในการถ่ายโอนทั่วไปสำหรับการหลบหลีกและการโจมตีพิษ

- การป้องกันที่ผ่านการรับรองสำหรับการโจมตีข้อมูลเป็นพิษ

- การโจมตีแบ็คดอร์แบบไดนามิกแบบ Input-Aware

- วิธีการแบ็คดอร์การเรียนรู้แบบสหพันธรัฐ

- การสร้างแบ็คดอร์ที่ตรวจไม่พบในโมเดลแมชชีนเลิร์นนิง

- หลอก AI!: แฮกเกอร์สามารถใช้แบ็คดอร์เพื่อสร้างพิษให้กับข้อมูลการฝึก และทำให้โมเดล AI จำแนกรูปภาพผิดประเภท เรียนรู้ว่านักวิจัยของ IBM สามารถบอกได้อย่างไรเมื่อข้อมูลถูกโจมตี จากนั้นเดาว่ามีแบ็คดอร์ใดบ้างที่ซ่อนอยู่ในชุดข้อมูลเหล่านี้ คุณสามารถเดาประตูหลังได้หรือไม่?

- กล่องเครื่องมือลับๆ: กล่องเครื่องมือขนาดกะทัดรัดสำหรับการโจมตีและป้องกันลับๆ

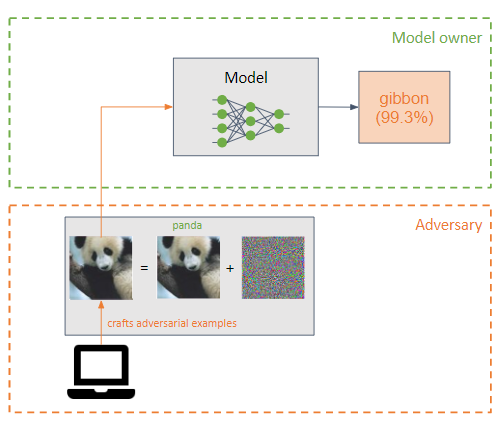

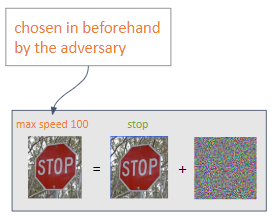

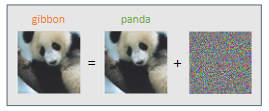

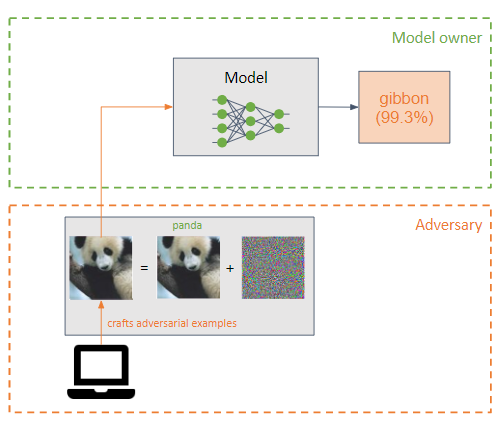

?♂️ การหลบหลีก ?♂️

ฝ่ายตรงข้ามเพิ่มการก่อกวนเล็กน้อย (ในรูปแบบของสัญญาณรบกวน) ให้กับอินพุตของโมเดลการเรียนรู้ของเครื่องเพื่อให้จำแนกประเภทไม่ถูกต้อง (ตัวอย่างฝ่ายตรงข้าม)

พวกมันคล้ายกับการโจมตีด้วยพิษ แต่ความแตกต่างที่สำคัญคือการโจมตีแบบหลบเลี่ยงพยายามใช้ประโยชน์จากจุดอ่อนของแบบจำลองในขั้นตอนการอนุมาน

เป้าหมายของปฏิปักษ์คือการเป็นตัวอย่างของปฏิปักษ์ที่มนุษย์มองไม่เห็น

การโจมตีสองประเภทสามารถทำได้ขึ้นอยู่กับผลลัพธ์ที่คู่ต่อสู้ต้องการ:

การโจมตีที่พบบ่อยที่สุดคือ การโจมตีกล่องขาว :

- L-BFGS

- เอฟจีเอสเอ็ม

- บีไอเอ็ม

- จส.ม

- คาร์ลินี แอนด์ วากเนอร์ (C&W)

- นิวตันคนโง่

- อี๊ด

- UAP

️ การดำเนินการป้องกัน ⁉ ️

การฝึกอบรมฝ่ายตรงข้าม ซึ่งประกอบด้วยการสร้างตัวอย่างฝ่ายตรงข้ามในระหว่างการฝึกอบรมเพื่อให้แบบจำลองเรียนรู้คุณลักษณะของตัวอย่างฝ่ายตรงข้าม ทำให้แบบจำลองมีความแข็งแกร่งมากขึ้นต่อการโจมตีประเภทนี้

การเปลี่ยนแปลงของอินพุต

การไล่ระดับสี/การทำให้เป็นมาตรฐาน ไม่ค่อยมีประสิทธิผล

การป้องกันที่อ่อนแอ

การป้องกันการฉีดทันที: ทุกการป้องกันเชิงปฏิบัติและที่นำเสนอต่อการฉีดทันที

เกณฑ์มาตรฐาน Lakera PINT: เกณฑ์มาตรฐานการทดสอบการฉีดพร้อมท์ (PINT) มอบวิธีที่เป็นกลางในการประเมินประสิทธิภาพของระบบตรวจจับการฉีดพร้อมท์ เช่น Lakera Guard โดยไม่ต้องอาศัยชุดข้อมูลสาธารณะที่รู้จักซึ่งเครื่องมือเหล่านี้สามารถใช้เพื่อปรับประสิทธิภาพการประเมินให้เหมาะสมที่สุด

การอนุมานของปีศาจ: วิธีการประเมินโมเดลคำสั่ง Phi-3 Instruct แบบตรงกันข้าม โดยการสังเกตการกระจายความสนใจทั่วศีรษะเมื่อสัมผัสกับอินพุตเฉพาะ แนวทางนี้กระตุ้นให้แบบจำลองนำ 'กรอบความคิดของปีศาจ' มาใช้ ซึ่งช่วยให้สามารถสร้างผลลัพธ์ที่มีลักษณะความรุนแรงได้

- ลิงค์ที่มีประโยชน์ ?

- การโจมตีกล่องดำเชิงปฏิบัติต่อการเรียนรู้ของเครื่อง

- ข้อจำกัดของการเรียนรู้เชิงลึกในการตั้งค่าที่ขัดแย้งกัน

- สู่การประเมินความคงทนของโครงข่ายประสาทเทียม

- การกลั่นเพื่อป้องกันการก่อกวนฝ่ายตรงข้ามกับโครงข่ายประสาทเทียมระดับลึก

- ตัวอย่างปฏิปักษ์ในโลกทางกายภาพ

- การฝึกอบรมฝ่ายตรงข้ามทั้งมวล: การโจมตีและการป้องกัน

- สู่โมเดลการเรียนรู้เชิงลึกที่ทนทานต่อการโจมตีของฝ่ายตรงข้าม

- คุณสมบัติที่น่าสนใจของโครงข่ายประสาทเทียม

- การอธิบายและควบคุมตัวอย่างฝ่ายตรงข้าม

- เจาะลึกตัวอย่างฝ่ายตรงข้ามที่สามารถถ่ายโอนได้และการโจมตีแบบกล่องดำ

- แมชชีนเลิร์นนิงของฝ่ายตรงข้ามในวงกว้าง

- การโจมตีฝ่ายตรงข้ามกล่องดำที่มีการสืบค้นและข้อมูลที่จำกัด

- การบีบคุณสมบัติ: การตรวจจับตัวอย่างฝ่ายตรงข้ามในโครงข่ายประสาทเทียมระดับลึก

- การโจมตีฝ่ายตรงข้ามตามการตัดสินใจ: การโจมตีที่เชื่อถือได้ต่อโมเดลการเรียนรู้ของเครื่องกล่องดำ

- ส่งเสริมการโจมตีของฝ่ายตรงข้ามด้วยโมเมนตัม

- พื้นที่ของตัวอย่างฝ่ายตรงข้ามที่สามารถโอนย้ายได้

- การตอบโต้ภาพฝ่ายตรงข้ามโดยใช้การแปลงอินพุต

- Defense-GAN: การปกป้องตัวแยกประเภทจากการโจมตีของฝ่ายตรงข้ามโดยใช้แบบจำลองเชิงกำเนิด

- การสังเคราะห์ตัวอย่างฝ่ายตรงข้ามที่แข็งแกร่ง

- การบรรเทาผลกระทบของฝ่ายตรงข้ามด้วยการสุ่ม

- ในการตรวจจับการรบกวนของฝ่ายตรงข้าม

- แพทช์ฝ่ายตรงข้าม

- PixelDefend: การใช้ประโยชน์จากโมเดล Generative เพื่อทำความเข้าใจและป้องกันตัวอย่างที่ขัดแย้งกัน

- การโจมตีหนึ่งพิกเซลเพื่อหลอกโครงข่ายประสาทเทียมระดับลึก

- การป้องกันที่มีประสิทธิภาพต่อการโจมตีของฝ่ายตรงข้าม

- การโจมตีทางกายภาพ-โลกที่แข็งแกร่งในการจำแนกประเภทภาพการเรียนรู้เชิงลึก

- การรบกวนฝ่ายตรงข้ามกับโครงข่ายประสาทเทียมระดับลึกเพื่อการจำแนกประเภทมัลแวร์

- การโจมตีฝ่ายตรงข้าม 3 มิติที่เหนือกว่า Point Cloud

- การก่อกวนของฝ่ายตรงข้ามหลอกเครื่องตรวจจับ Deepfake

- Adversarial Deepfakes: การประเมินช่องโหว่ของตัวตรวจจับ Deepfake เป็นตัวอย่างที่เป็นปฏิปักษ์

- ภาพรวมช่องโหว่ของระบบควบคุมด้วยเสียง

- FastWordBug: วิธีที่รวดเร็วในการสร้างข้อความที่ขัดแย้งกับแอปพลิเคชัน NLP

- Phantom of the ADAS: การรักษาความปลอดภัยระบบช่วยเหลือผู้ขับขี่ขั้นสูงจากการโจมตี Phantom แบบเสี้ยววินาที

- llm-attacks: การโจมตีแบบสากลและแบบถ่ายโอนได้บนโมเดลภาษาที่สอดคล้อง

- การโจมตีโมเดล AI: การฉีดพร้อมท์เทียบกับพิษในห่วงโซ่อุปทาน

- การโจมตีพร้อมท์การฉีดต่อแอปพลิเคชันที่รวม LLM

- Garak: เครื่องสแกนช่องโหว่ LLM

- การเปลี่ยนแปลงฝ่ายตรงข้ามอย่างง่ายใน PyTorch

- ปลั๊กอิน ChatGPT: การกรองข้อมูลผ่านรูปภาพและการปลอมแปลงคำขอปลั๊กอินข้าม

- การแย่งชิงรูปภาพ: รูปภาพของฝ่ายตรงข้ามสามารถควบคุมโมเดลทั่วไปได้ที่รันไทม์

- การโจมตีหลายครั้ง: รูปภาพจำนวนมาก + การโจมตีของฝ่ายตรงข้ามแบบเดียวกัน → ป้ายกำกับเป้าหมายจำนวนมาก

- ใช้งานอยู่: สู่การพรางทางกายภาพ 3 มิติที่สามารถถ่ายโอนได้สูงเพื่อการหลบหลีกยานพาหนะอเนกประสงค์และทนทาน

- LLM Red Teaming GPTS's: การรั่วไหลอย่างรวดเร็ว, การรั่วไหลของ API, การรั่วไหลของเอกสาร

- ตัวอย่างปฏิปักษ์ที่มนุษย์สร้างขึ้น

- ความท้าทายในการแหกคุกหลายภาษาในโมเดลภาษาขนาดใหญ่

- การใช้เครื่องมือในทางที่ผิดในโมเดลภาษาขนาดใหญ่พร้อมตัวอย่างภาพที่ขัดแย้งกัน

- AutoDAN: การโจมตีฝ่ายตรงข้ามที่ใช้การไล่ระดับสีแบบตีความได้ในโมเดลภาษาขนาดใหญ่

- การฉีดต่อเนื่องหลายรูปแบบ: (Ab) การใช้ภาพและเสียงสำหรับการฉีดคำสั่งทางอ้อมใน Multi-Modal LLM

- JailbreakingLLMs: โมเดลภาษาขนาดใหญ่ Jailbreaking Black Box ในยี่สิบแบบสอบถาม

- แผนผังแห่งการโจมตี: การแหกคุก Black-Box LLM โดยอัตโนมัติ

- GPT: ข้อความแจ้งของ GPT ที่รั่วไหล

- การหาประโยชน์จาก AI: ชุดของการหาประโยชน์จาก AI/ML ในโลกแห่งความเป็นจริงสำหรับช่องโหว่ที่เปิดเผยอย่างมีความรับผิดชอบ

- ตัวแทน LLM สามารถแฮ็กเว็บไซต์ได้โดยอัตโนมัติ

- Cloudflare ประกาศไฟร์วอลล์สำหรับ AI

- PromptInject: กรอบงานที่รวบรวมการแจ้งเตือนในรูปแบบโมดูลาร์เพื่อให้การวิเคราะห์เชิงปริมาณของความแข็งแกร่งของ LLM ต่อการโจมตีพร้อมท์ของฝ่ายตรงข้าม

- LLM Red Teaming: แนวทางฝ่ายตรงข้าม การเขียนโปรแกรม และภาษาศาสตร์ VS ChatGPT, Claude, Mistral, Grok, LLAMA และ Gemini

- ลำดับชั้นคำสั่ง: การฝึกอบรม LLM เพื่อจัดลำดับความสำคัญของคำสั่งที่มีสิทธิพิเศษ

- การฉีดทันที / การแหกคุกตัวแทน LLM ของธนาคาร (GPT-4, Langchain)

- GitHub Copilot Chat: ตั้งแต่การแทรกพร้อมท์ไปจนถึงการกรองข้อมูล

- ตัวอย่างฝ่ายตรงข้ามอยู่ในแนวที่ไม่ตรงในท่อร่วมแบบจำลองการแพร่กระจาย

- การแหกคุกลอจิกจากรูปภาพเป็นข้อความ: จินตนาการของคุณสามารถช่วยให้คุณทำทุกอย่างได้

- Mitigating Skeleton Key ซึ่งเป็นเทคนิคการแหกคุก AI รูปแบบใหม่

- เกณฑ์มาตรฐานการทำให้คลุมเครือของรูปภาพ: พื้นที่เก็บข้อมูลนี้มีโค้ดสำหรับประเมินแบบจำลองบนเกณฑ์มาตรฐานการทำให้คลุมเครือของรูปภาพ ซึ่งนำเสนอครั้งแรกในการเปรียบเทียบความทนทานต่อความคลุมเครือของรูปภาพที่ขัดแย้งกัน

- การแหกคุกโมเดลภาษาขนาดใหญ่ด้วยคณิตศาสตร์เชิงสัญลักษณ์

เครื่องมือ

| ชื่อ | พิมพ์ | อัลกอริธึมที่รองรับ | ประเภทการโจมตีที่รองรับ | โจมตี/ป้องกัน | กรอบการทำงานที่รองรับ | ความนิยม |

|---|

| เคลฟเวอร์ฮานส์ | ภาพ | การเรียนรู้เชิงลึก | การหลีกเลี่ยง | จู่โจม | เทนเซอร์โฟลว์, เคราส, JAX | |

| กล่องโง่ | ภาพ | การเรียนรู้เชิงลึก | การหลีกเลี่ยง | จู่โจม | เทนเซอร์โฟลว์, PyTorch, JAX | |

| ศิลปะ | ประเภทใดก็ได้ (รูปภาพ ข้อมูลแบบตาราง เสียง...) | การเรียนรู้เชิงลึก, SVM, LR ฯลฯ | ใดๆ (การสกัด การอนุมาน การวางยาพิษ การหลีกเลี่ยง) | ทั้งคู่ | Tensorflow, Keras, Pytorch, Scikit เรียนรู้ | |

| ข้อความโจมตี | ข้อความ | การเรียนรู้เชิงลึก | การหลีกเลี่ยง | จู่โจม | Keras, กอดใบหน้า | |

| โฆษณา | ภาพ | การเรียนรู้เชิงลึก | การหลีกเลี่ยง | ทั้งคู่ | - | |

| AdvBox | ภาพ | การเรียนรู้เชิงลึก | การหลีกเลี่ยง | ทั้งคู่ | PyTorch, เทนเซอร์โฟลว์, MxNet | |

| ล้ำลึกทนทาน | รูปภาพ, กราฟ | การเรียนรู้เชิงลึก | การหลีกเลี่ยง | ทั้งคู่ | ไพทอร์ช | |

| ของปลอม | ใดๆ | ใดๆ | การหลีกเลี่ยง | จู่โจม | - | |

| ตัวอย่างเสียงของฝ่ายตรงข้าม | เสียง | คำพูดเชิงลึก | การหลีกเลี่ยง | จู่โจม | - | |

ศิลปะ

Adversarial Robustness Toolbox หรือเรียกโดยย่อว่า ART เป็นไลบรารี Adversarial Machine Learning แบบโอเพ่นซอร์สสำหรับการทดสอบความทนทานของโมเดล Machine Learning

ได้รับการพัฒนาใน Python และดำเนินการสกัด การผกผัน การวางยาพิษ และการหลบเลี่ยงการโจมตีและการป้องกัน

ART รองรับเฟรมเวิร์กยอดนิยม: Tensorflow, Keras, PyTorch, MxNet และ ScikitLearn และอื่นๆ อีกมากมาย

ไม่จำกัดเพียงการใช้โมเดลที่ใช้รูปภาพเป็นอินพุต แต่ยังรองรับข้อมูลประเภทอื่นๆ เช่น เสียง วิดีโอ ข้อมูลแบบตาราง เป็นต้น

เวิร์คช็อปเพื่อเรียนรู้ Adversarial Machine Learning ด้วย ART ??

เคลฟเวอร์ฮานส์

Cleverhans เป็นไลบรารีสำหรับการโจมตีแบบหลบเลี่ยงและทดสอบความแข็งแกร่งของโมเดลการเรียนรู้เชิงลึกบนโมเดลรูปภาพ

ได้รับการพัฒนาใน Python และทำงานร่วมกับเฟรมเวิร์ก Tensorflow, Torch และ JAX

มีการโจมตีมากมาย เช่น L-BFGS, FGSM, JSMA, C&W และอื่นๆ

- ใช้ ?

AI ถูกใช้เพื่อทำงานที่เป็นอันตรายให้สำเร็จและเพิ่มการโจมตีแบบคลาสสิก

♂️ บททดสอบ ♂️

- GyoiThon: เครื่องมือทดสอบการเจาะระบบยุคใหม่ เครื่องมือรวบรวมข้อมูลสำหรับเว็บเซิร์ฟเวอร์

- Deep Exploit: เครื่องมือทดสอบการเจาะระบบอัตโนมัติโดยใช้ Deep Reinforcement Learning

- AutoPentest-DRL: การทดสอบการเจาะระบบอัตโนมัติโดยใช้การเรียนรู้การเสริมแรงเชิงลึก

- DeepGenerator: สร้างโค้ดการแทรกโดยอัตโนมัติสำหรับการประเมินแอปพลิเคชันเว็บโดยใช้อัลกอริทึมทางพันธุกรรมและเครือข่าย Generative Adversarial

- Eyeballer: Eyeballer มีไว้สำหรับการทดสอบการเจาะเครือข่ายในขอบเขตขนาดใหญ่ ซึ่งคุณต้องการค้นหาเป้าหมายที่ "น่าสนใจ" จากโฮสต์บนเว็บชุดใหญ่

- Nebula: ผู้ช่วยแฮ็กตามหลักจริยธรรมที่ขับเคลื่อนด้วย AI

- ทีมตัวแทน LLM สามารถใช้ประโยชน์จากช่องโหว่ Zero-Day

- ข้อมูลเชิงลึกและช่องว่างปัจจุบันในเครื่องสแกนช่องโหว่ LLM แบบโอเพ่นซอร์ส: การวิเคราะห์เปรียบเทียบ

- มัลแวร์ ?

- DeepLocker: ปกปิดการโจมตีแบบกำหนดเป้าหมายด้วยช่างทำกุญแจ AI โดย IBM Labs บน BH

- ภาพรวมของปัญญาประดิษฐ์ที่ใช้ในมัลแวร์: รายการแหล่งข้อมูลมัลแวร์ AI ที่คัดสรรแล้ว

- DeepObfusCode: การสร้างความสับสนให้กับซอร์สโค้ดผ่านเครือข่ายแบบเรียงลำดับต่อลำดับ

- AutoCAT: การเสริมการเรียนรู้สำหรับการสำรวจการโจมตีแบบแคชไทม์โดยอัตโนมัติ

- บอตเน็ตที่ใช้ AI: แนวทางเชิงทฤษฎีเกมสำหรับการป้องกันการโจมตีบอตเน็ตที่ใช้ AI

- SECML_Malware: ไลบรารี Python สำหรับสร้างการโจมตีฝ่ายตรงข้ามกับเครื่องตรวจจับมัลแวร์ Windows

- Transcendent-release: การใช้การประเมินตามข้อกำหนดเพื่อตรวจจับการเบี่ยงเบนของแนวคิดที่ส่งผลต่อการตรวจจับมัลแวร์

️โอซินท์ ⁉️

- SNAP_R: สร้างโพสต์แบบฟิชชิ่งอัตโนมัติบนโซเชียลมีเดีย

- SpyScrap: SpyScrap รวมวิธีการจดจำใบหน้าเพื่อกรองผลลัพธ์และใช้การประมวลผลภาษาธรรมชาติเพื่อรับเอนทิตีที่สำคัญจากเว็บไซต์ที่ผู้ใช้ปรากฏ

- ฟิชชิ่ง ?

- DeepDGA: การใช้งาน DeepDGA: การสร้างและการตรวจจับโดเมนที่ได้รับการปรับแต่งโดยฝ่ายตรงข้าม

- หน่วยสืบราชการลับภัยคุกคาม ?

- จากผืนทรายสู่คฤหาสน์: เปิดใช้งานการสร้างการโจมตีทางไซเบอร์วงจรชีวิตอัตโนมัติด้วย LLM

- ช่องข้าง ?

- SCAAML: การโจมตีช่องทางด้านข้างที่ได้รับความช่วยเหลือจากการเรียนรู้ของเครื่อง

?? AI กำเนิด ??

- เสียง ?

เครื่องมือ

- การแปลงเสียงแบบลึก: โครงข่ายประสาทเทียมระดับลึกสำหรับการแปลงเสียง (การถ่ายโอนรูปแบบเสียง) ใน Tensorflow

- Tacotron: การใช้ TensorFlow ของการสังเคราะห์เสียงพูด Tacotron ของ Google ด้วยโมเดลที่ได้รับการฝึกอบรมล่วงหน้า (ไม่เป็นทางการ)

- การโคลนเสียงแบบเรียลไทม์: โคลนเสียงใน 5 วินาทีเพื่อสร้างคำพูดตามอำเภอใจแบบเรียลไทม์

- mimic2: เครื่องมือแปลงข้อความเป็นคำพูดที่ใช้สถาปัตยกรรม Tacotron ซึ่งเริ่มใช้งานครั้งแรกโดย Keith Ito

- การโคลนเสียงแบบประสาทเสียงด้วยตัวอย่างไม่กี่ตัวอย่าง: การปรับใช้การโคลนเสียงแบบประสาทด้วยตัวอย่างไม่กี่ตัวอย่าง เอกสารวิจัยโดย Baidu

- Vall-E: การใช้งาน PyTorch อย่างไม่เป็นทางการของเสียง LM VALL-E

- โปรแกรมเปลี่ยนเสียง: โปรแกรมเปลี่ยนเสียงแบบเรียลไทม์

- การดึงข้อมูล-ตาม-การแปลงเสียง-WebUI: กรอบงานการแปลงเสียงที่ใช้งานง่ายตาม VITS

- Audiocraft: Audiocraft เป็นห้องสมุดสำหรับการประมวลผลเสียงและการสร้างด้วยการเรียนรู้เชิงลึก มันมีคอมเพรสเซอร์เสียง/โทเค็นเซอร์ EnCodec ที่ล้ำสมัย พร้อมด้วย MusicGen ซึ่งเป็น LM การสร้างเพลงที่เรียบง่ายและควบคุมได้พร้อมการปรับสภาพข้อความและทำนอง

- VALL-EX: การใช้งานโอเพ่นซอร์สของโมเดล TTS แบบ Zero-shot VALL-E X ของ Microsoft

- OpenVoice: การโคลนเสียงทันทีโดย MyShell

- MeloTTS: ไลบรารีการอ่านออกเสียงข้อความหลายภาษาคุณภาพสูงโดย MyShell.ai รองรับภาษาอังกฤษ สเปน ฝรั่งเศส จีน ญี่ปุ่น และเกาหลี

- VoiceCraft: การแก้ไขคำพูดแบบ Zero-Shot และการแปลงข้อความเป็นคำพูดในป่า

- Parler-TTS: ไลบรารีการอนุมานและการฝึกอบรมสำหรับโมเดล TTS คุณภาพสูง

- ChatTTS: โมเดลคำพูดเชิงสร้างสรรค์สำหรับบทสนทนารายวัน

การใช้งาน

- Lip2Wav: สร้างคำพูดคุณภาพสูงจากการเคลื่อนไหวของริมฝีปากเท่านั้น

- AudioLDM: การสร้างข้อความเป็นเสียงด้วยโมเดลการแพร่กระจายแฝง

- deepvoice3_pytorch: การใช้งาน PyTorch ของแบบจำลองการสังเคราะห์ข้อความเป็นคำพูดที่ใช้เครือข่ายประสาทเทียม

- - Riffusion: การแพร่กระจายที่เสถียรสำหรับการสร้างเพลงแบบเรียลไทม์

- กระซิบcpp: พอร์ตของโมเดล Whisper ของ OpenAI ใน C/C++

- ทีทีเอส: ? - ชุดเครื่องมือการเรียนรู้เชิงลึกสำหรับการอ่านออกเสียงข้อความ ผ่านการทดสอบการต่อสู้ในการวิจัยและการผลิต

- YourTTS: สู่ Zero-Shot Multi-Speaker TTS และ Zero-Shot Voice Conversion สำหรับทุกคน

- TorToiSe: ระบบ TTS หลายเสียงที่ได้รับการฝึกอบรมโดยเน้นที่คุณภาพ

- DiffSinger: การสังเคราะห์เสียงร้องเพลงผ่านกลไกการแพร่กระจายตื้น (SVS & TTS)

- โวโคเดอร์ WaveNet: การใช้งานโวโคเดอร์ WaveNet ซึ่งสามารถสร้างตัวอย่างคำพูดดิบคุณภาพสูงที่มีเงื่อนไขตามคุณสมบัติทางภาษาหรืออะคูสติก

- Deepvoice3_pytorch: การใช้งาน PyTorch ของแบบจำลองการสังเคราะห์ข้อความเป็นคำพูดที่ใช้เครือข่ายประสาทเทียม

- eSpeak NG การแปลงข้อความเป็นคำพูด: eSpeak NG เป็นโปรแกรมสังเคราะห์เสียงพูดแบบโอเพ่นซอร์สที่รองรับภาษาและสำเนียงมากกว่าร้อยภาษา

- RealChar: สร้าง ปรับแต่ง และพูดคุยกับตัวละคร AI/คู่หูของคุณแบบเรียลไทม์ (โค้ดเบสทั้งหมดในที่เดียว!) สนทนาอย่างเป็นธรรมชาติกับ AI ได้ทุกที่ (มือถือ เว็บ และเทอร์มินัล) โดยใช้ LLM OpenAI GPT3.5/4, Anthropic Claude2, Chroma Vector DB, Whisper Speech2Text, ElevenLabs Text2Speech

- การโคลนเสียงประสาทด้วยตัวอย่างบางส่วน

- NAUTILUS: ระบบโคลนเสียงอเนกประสงค์

- การเรียนรู้ที่จะพูดอย่างคล่องแคล่วในภาษาต่างประเทศ: การสังเคราะห์คำพูดหลายภาษาและการโคลนเสียงข้ามภาษา

- เมื่อความดีกลายเป็นความชั่ว: การอนุมานการกดแป้นพิมพ์ด้วยสมาร์ทวอทช์

- KeyListener: การอนุมานการกดแป้นพิมพ์บนคีย์บอร์ด QWERTY ของหน้าจอสัมผัสผ่านสัญญาณเสียง

- ไม่มีเสียงนี้: ในการสังเคราะห์เสียง เสียง Deepfakes และการตรวจจับ

- AudioSep: แยกสิ่งที่คุณอธิบายออกจากกัน

- เครื่องมือเสียงที่เสถียร: โมเดลเจนเนอเรชั่นสำหรับการสร้างเสียงแบบมีเงื่อนไข

- GPT-SoVITS-WebUI: ข้อมูลเสียง 1 นาทีสามารถใช้เพื่อฝึกโมเดล TTS ที่ดีได้! (การโคลนเสียงแบบยิงไม่กี่ครั้ง)

- Hybrid-Net: การแยกแหล่งกำเนิดเสียงแบบเรียลไทม์ สร้างเนื้อเพลง คอร์ด และจังหวะ

- CosyVoice: โมเดลการสร้างเสียงขนาดใหญ่หลายภาษา ให้ความสามารถในการอนุมาน การฝึกอบรม และการใช้งานเต็มรูปแบบ

- EasyVolcap: เร่งการวิจัยวิดีโอเชิงปริมาตรประสาท

- การตรวจจับ ?

- การตรวจจับเสียงปลอม: การใช้การบิดชั่วขณะเพื่อตรวจจับ Audio Deepfakes

- ระบบตรวจจับการปลอมแปลงด้วยเสียงที่มีประสิทธิภาพโดยใช้คุณสมบัติ CLS-LBP และ LSTM แบบใหม่

- เครื่องตรวจจับการปลอมแปลงด้วยเสียง: กรอบการทำงานป้องกันการปลอมแปลงแบบครบวงจร

- การรักษาความปลอดภัยอินเทอร์เฟซที่ขับเคลื่อนด้วยเสียงจากการโจมตีทางเสียงปลอม (โคลน)

- DeepSonar: สู่การตรวจจับเสียงปลอมที่สังเคราะห์โดย AI ได้อย่างมีประสิทธิภาพและแข็งแกร่ง

- ต่อสู้กับ AI ด้วย AI: การตรวจจับคำพูดปลอมโดยใช้การเรียนรู้เชิงลึก

- การทบทวนวิธีการตรวจจับ Deepfake เสียงสมัยใหม่: ความท้าทายและทิศทางในอนาคต

- ภาพ ?

เครื่องมือ

- StyleGAN: StyleGAN - การใช้งาน TensorFlow อย่างเป็นทางการ

- StyleGAN2: StyleGAN2 - การใช้งาน TensorFlow อย่างเป็นทางการ

- stylegan2-ada-pytorch: StyleGAN2-ADA - การใช้งาน PyTorch อย่างเป็นทางการ

- StyleGAN-nada: การปรับโดเมนแบบ CLIP-Guided ของเครื่องสร้างภาพ

- StyleGAN3: การใช้งาน PyTorch อย่างเป็นทางการของ StyleGAN3

- Imaginaire: Imaginaire เป็นไลบรารี pytorch ที่มีการปรับใช้วิธีการสังเคราะห์ภาพและวิดีโอต่างๆ ที่พัฒนาขึ้นที่ NVIDIA อย่างเหมาะสมที่สุด

- ชุดข้อมูล ffhq: ชุดข้อมูล Flickr-Faces-HQ (FFHQ)

- DALLE2-pytorch: การใช้งาน DALL-E 2 ซึ่งเป็นเครือข่ายประสาทสังเคราะห์ข้อความเป็นรูปภาพที่ได้รับการอัปเดตของ OpenAI ใน Pytorch

- ImaginAIry: AI จินตนาการภาพที่ การสร้าง Pythonic ของภาพการแพร่กระจายที่เสถียร

- Lama Cleaner: เครื่องมือวาดภาพในรูปภาพที่ขับเคลื่อนโดย SOTA AI Model ลบวัตถุ ข้อบกพร่อง หรือบุคคลที่ไม่ต้องการออกจากรูปภาพของคุณ หรือลบและแทนที่สิ่งใดๆ บนรูปภาพของคุณ (ขับเคลื่อนด้วยการกระจายที่เสถียร)

- Invertible-Image-Rescaling: นี่คือการใช้งาน PyTorch ของกระดาษ: การลดขนาดรูปภาพแบบกลับด้านได้

- DifFace: การฟื้นฟูใบหน้าคนตาบอดพร้อมการหดตัวของข้อผิดพลาดแบบกระจาย (PyTorch)

- CodeFormer: สู่การฟื้นฟูใบหน้าคนตาบอดที่แข็งแกร่งด้วย Codebook Lookup Transformer

- การแพร่กระจายแบบกำหนดเอง: การปรับแต่งหลายแนวคิดของการแพร่กระจายข้อความเป็นรูปภาพ

- เครื่องกระจายกลิ่น: ? ตัวกระจาย: โมเดลการแพร่กระจายที่ล้ำสมัยสำหรับการสร้างภาพและเสียงใน PyTorch

- การแพร่กระจายที่เสถียร: การสังเคราะห์ภาพความละเอียดสูงด้วยแบบจำลองการแพร่กระจายแบบแฝง

- InvolveAI: InvokeAI เป็นเครื่องมือสร้างสรรค์ชั้นนำสำหรับโมเดล Stable Diffusion เสริมศักยภาพให้กับมืออาชีพ ศิลปิน และผู้สนใจ ในการสร้างและสร้างสื่อภาพโดยใช้เทคโนโลยีที่ขับเคลื่อนด้วย AI ล่าสุด โซลูชันนี้นำเสนอ WebUI ชั้นนำของอุตสาหกรรม รองรับการใช้งานเทอร์มินัลผ่าน CLI และทำหน้าที่เป็นรากฐานสำหรับผลิตภัณฑ์เชิงพาณิชย์หลายประเภท

- UI เว็บการแพร่กระจายที่เสถียร: UI เว็บการแพร่กระจายที่เสถียร

- Stable Diffusion Infinity: การทาสีภายนอกด้วย Stable Diffusion บนผืนผ้าใบที่ไม่มีที่สิ้นสุด

- การแพร่กระจายที่เสถียรอย่างรวดเร็ว: การแพร่กระจายที่เสถียรอย่างรวดเร็ว + DreamBooth

- GET3D: โมเดลกำเนิดของรูปทรงพื้นผิว 3 มิติคุณภาพสูงที่เรียนรู้จากรูปภาพ

- การสังเคราะห์ภาพศิลปะ AI ที่ยอดเยี่ยม: รายการเครื่องมือ ไอเดีย เครื่องมือวิศวกรรมพร้อมท์ การร่วมงาน โมเดล และผู้ช่วยที่ยอดเยี่ยมสำหรับนักออกแบบพร้อมท์ที่เล่นกับ aiArt และการสังเคราะห์ภาพ ครอบคลุมเครื่องมือ Dalle2, MidJourney, StableDiffusion และโอเพ่นซอร์ส

- การแพร่กระจายที่เสถียร: โมเดลการแพร่กระจายข้อความเป็นภาพที่แฝงอยู่

- การแพร่กระจายของสภาพอากาศ: รหัสสำหรับ "การฟื้นฟูการมองเห็นในสภาพอากาศที่ไม่เอื้ออำนวยด้วยแบบจำลองการกระจายสัญญาณรบกวนแบบแพตช์"

- DF-GAN: เส้นพื้นฐานที่ง่ายและมีประสิทธิภาพสำหรับการสังเคราะห์ข้อความเป็นรูปภาพ

- Dall-E Playground: สนามเด็กเล่นสำหรับสร้างภาพจากข้อความแจ้งใด ๆ โดยใช้ Stable Diffusion (อดีต: ใช้ DALL-E Mini)

- MM-CelebA-HQ-ชุดข้อมูล: ชุดข้อมูลภาพใบหน้าขนาดใหญ่ที่ช่วยให้สามารถสร้างข้อความเป็นภาพ การจัดการภาพที่มีข้อความแนะนำ การสร้างภาพร่างเป็นภาพ GAN สำหรับการสร้างและแก้ไขใบหน้า คำบรรยายภาพ และ VQA

- Deep Daze: เครื่องมือบรรทัดคำสั่งอย่างง่ายสำหรับการสร้างข้อความเป็นรูปภาพโดยใช้ CLIP และ Siren ของ OpenAI (เครือข่ายการแสดงประสาทโดยนัย)

- StyleMapGAN: การใช้ประโยชน์จากมิติเชิงพื้นที่ของแฝงใน GAN สำหรับการแก้ไขภาพแบบเรียลไทม์

- Kandinsky-2: แบบจำลองการแพร่กระจายแฝงของข้อความ 2 รูปภาพหลายภาษา

- DragGAN: การจัดการตามจุดเชิงโต้ตอบบน Generative Image Manifold

- เซ็กเมนต์อะไรก็ได้: พื้นที่เก็บข้อมูลจะมีโค้ดสำหรับการเรียกใช้การอนุมานด้วย SegmentAnything Model (SAM) ลิงก์สำหรับดาวน์โหลดจุดตรวจสอบโมเดลที่ได้รับการฝึก และสมุดบันทึกตัวอย่างที่แสดงวิธีใช้โมเดล

- เซ็กเมนต์อะไรก็ได้ 2: พื้นที่เก็บข้อมูลจะมีโค้ดสำหรับการรันการอนุมานด้วย Meta Segment Anything Model 2 (SAM 2) ลิงก์สำหรับดาวน์โหลดจุดตรวจสอบโมเดลที่ได้รับการฝึก และสมุดบันทึกตัวอย่างที่แสดงวิธีใช้โมเดล

- MobileSAM: นี่คือโค้ดอย่างเป็นทางการสำหรับโปรเจ็กต์ MobileSAM ที่ทำให้ SAM มีน้ำหนักเบาสำหรับแอปพลิเคชันบนมือถือและอื่นๆ!

- FastSAM: แบ่งส่วนอย่างรวดเร็วอะไรก็ได้

- Infinigen: โลกเสมือนจริงที่ไม่มีที่สิ้นสุดโดยใช้การสร้างขั้นตอน

- ดอล·อี 3

- StreamDiffusion: โซลูชันระดับไปป์ไลน์สำหรับการสร้างการโต้ตอบแบบเรียลไทม์

- AnyDoor: การปรับแต่งภาพระดับวัตถุแบบ Zero-shot

- DiT: โมเดลการแพร่กระจายที่ปรับขนาดได้พร้อมหม้อแปลง

- BrushNet: โมเดลการลงสีรูปภาพแบบ Plug-and-Play พร้อมการกระจายแบบ Dual-Branch ที่แยกส่วน

- OOTDiffusion: การติดตั้งการแพร่กระจายแบบแฝงบนพื้นฐานฟิวชั่นสำหรับการลองใช้งานเสมือนที่ควบคุมได้

- VAR: ความหมายอย่างเป็นทางการ ของ "การสร้างแบบจำลองภาพอัตโนมัติถดถอย: การสร้างภาพที่ปรับขนาดได้ผ่านการทำนายระดับถัดไป"

- ลองนึกภาพ Flash: เร่งโมเดลการแพร่กระจายของนกอีมูด้วยการกลั่นแบบย้อนกลับ

การใช้งาน

- ArtLine: โปรเจ็กต์การเรียนรู้เชิงลึกสำหรับการสร้างภาพลายเส้น

- Depix: กู้คืนรหัสผ่านจากภาพหน้าจอที่มีพิกเซล

- นำภาพถ่ายเก่ากลับมามีชีวิตอีกครั้ง: การฟื้นฟูภาพถ่ายเก่า (การใช้งาน PyTorch อย่างเป็นทางการ)

- การเขียนใหม่: เครื่องมือแบบโต้ตอบเพื่อแก้ไขกฎของ GAN โดยตรงเพื่อสังเคราะห์ฉากที่มีวัตถุเพิ่ม ลบออก หรือเปลี่ยนแปลง เปลี่ยน StyleGANv2 ให้คิ้วดูหรูหรา หรือม้าสวมหมวก

- ฟอกส์: เครื่องมือรักษาความเป็นส่วนตัวจากระบบจดจำใบหน้า

- Pulse: การสุ่มตัวอย่างภาพถ่ายที่ดูแลตนเองผ่านการสำรวจอวกาศแฝงของแบบจำลองกำเนิด

- HiDT: พื้นที่เก็บข้อมูลอย่างเป็นทางการสำหรับรายงาน "การแปลในเวลากลางวันที่มีความละเอียดสูงโดยไม่มีป้ายกำกับโดเมน"

- การวาดภาพด้วยภาพถ่าย 3 มิติ: การถ่ายภาพ 3 มิติโดยใช้การวาดภาพด้วยความลึกแบบเลเยอร์ตามบริบท

- SteganoGAN: SteganoGAN เป็นเครื่องมือสำหรับสร้างภาพ Steganographic โดยใช้การฝึกอบรมฝ่ายตรงข้าม

- Stylegan-T: ปลดล็อกพลังของ GAN เพื่อการสังเคราะห์ข้อความเป็นรูปภาพขนาดใหญ่ที่รวดเร็ว

- MegaPortraits: อวตารหัวระบบประสาทล้านพิกเซลแบบช็อตเดียว

- eg3d: เครือข่ายฝ่ายตรงข้ามที่สร้าง 3 มิติที่รับรู้รูปทรงเรขาคณิตที่มีประสิทธิภาพ

- TediGAN: การใช้งาน Pytorch สำหรับ TediGAN: การสร้างและการจัดการภาพใบหน้าที่หลากหลายโดยใช้ข้อความ

- DALLE-pytorch: การใช้งาน / การจำลองแบบของ DALL-E ซึ่งเป็นตัวแปลงข้อความเป็นรูปภาพของ OpenAI ใน Pytorch

- StyleNeRF: นี่คือการใช้งานโอเพ่นซอร์สของรายงาน ICLR2022 เรื่อง "StyleNeRF: เครื่องสร้างการรับรู้ 3 มิติตามสไตล์สำหรับการสังเคราะห์ภาพความละเอียดสูง"

- DeepSVG: รหัสอย่างเป็นทางการสำหรับบทความ "DeepSVG: A Hierarchical Generative Network for Vector Graphics Animation" รวมไลบรารี PyTorch สำหรับการเรียนรู้เชิงลึกด้วยข้อมูล SVG

- NUWA: ไปป์ไลน์หม้อแปลง 3 มิติแบบครบวงจรสำหรับการสังเคราะห์ภาพ

- Image-Super-Resolution-via-Iterative-Refinement: การใช้งาน Image Super-Resolution อย่างไม่เป็นทางการผ่าน Iterative Refinement โดย Pytorch

- ลามะ: ? LaMa Image Inpainting, การลงสี Mask ขนาดใหญ่ที่มีความละเอียดและทนทานพร้อม Fourier Convolutions

- Person_reID_baseline_pytorch: Pytorch ReID: การใช้ pytorch ขนาดเล็ก เป็นมิตร และแข็งแกร่งของพื้นฐานการระบุวัตถุอีกครั้ง

- instruct-pix2pix: การใช้ PyTorch ของ InstructPix2Pix ซึ่งเป็นโมเดลการแก้ไขรูปภาพตามคำสั่ง

- GFPGAN: GFPGAN มุ่งเป้าไปที่การพัฒนาอัลกอริธึมเชิงปฏิบัติสำหรับการฟื้นฟูใบหน้าในโลกแห่งความเป็นจริง

- DeepVecFont: การสังเคราะห์แบบอักษรเวกเตอร์คุณภาพสูงผ่านการเรียนรู้แบบ Dual-modality

- Stargan v2 Tensorflow: การใช้งาน Tensorflow อย่างเป็นทางการ

- การกลั่น StyleGAN2: การแปลภาพเป็นภาพคู่ที่ได้รับการฝึกอบรมเกี่ยวกับข้อมูลสังเคราะห์ที่สร้างโดย StyleGAN2 มีประสิทธิภาพเหนือกว่าแนวทางที่มีอยู่ในการจัดการภาพ

- การแยกข้อมูลการฝึกอบรมจากแบบจำลองการแพร่กระจาย

- Mann-E - Mann-E (เปอร์เซีย: مانی) คือโมเดลเครื่องกำเนิดงานศิลปะโดยอิงตามน้ำหนักของ Stable Diffusion 1.5 และข้อมูลที่รวบรวมจากสื่อทางศิลปะที่มีอยู่ใน Pinterest

- เครือข่ายเข้ารหัสและถอดรหัส CNN ที่ได้รับการฝึกอบรมแบบครบวงจรสำหรับการถ่ายภาพ Steganography

- Grounded-Segment-Anything: แต่งงานกับ Grounding DINO ด้วย Segment Anything & Stable Diffusion & Tag2Text & BLIP & Whisper & ChatBot - ตรวจจับอัตโนมัติ แบ่งกลุ่ม และสร้างทุกสิ่งด้วยอินพุตรูปภาพ ข้อความ และเสียง

- AnimateDiff: สร้างภาพเคลื่อนไหวแบบจำลองการแพร่กระจายข้อความเป็นภาพส่วนบุคคลของคุณโดยไม่ต้องปรับแต่งเฉพาะ

- BasicSR: กล่องเครื่องมือฟื้นฟูรูปภาพและวิดีโอแบบโอเพ่นซอร์สสำหรับความละเอียดสูงพิเศษ Denoise การลบภาพเบลอ ฯลฯ ปัจจุบันประกอบด้วย EDSR, RCAN, SRResNet, SRGAN, ESRGAN, EDVR, BasicVSR, SwinIR, ECBSR ฯลฯ นอกจากนี้ยังรองรับ StyleGAN2 และ DFDNet [](https://github.com/XPixelGroup/ BasicSR)

- Real-ESRGAN: Real-ESRGAN มุ่งเป้าไปที่การพัฒนาอัลกอริธึมเชิงปฏิบัติสำหรับการกู้คืนรูปภาพ/วิดีโอทั่วไป

- ESRGAN: SRGAN ที่ได้รับการปรับปรุง Champion Pirm Challenge เกี่ยวกับการรับรู้ระดับสูง

- Mixnmatch: การลดความพุ่งออกมาและการเข้ารหัสแบบมัลติปัจจัยสำหรับการสร้างภาพแบบมีเงื่อนไข

- Clarity-Upscaler: การปรับขนาดภาพที่ปรับเปลี่ยนสำหรับทุกคน

- การแพร่กระจายขั้นตอนเดียวพร้อมการกระจายการแจกแจงการกลั่น

- Invisible Stitch: สร้างฉาก 3 มิติที่ราบรื่นด้วยความลึก inpainting

- SSR: การสร้างฉาก 3D มุมมองเดี่ยวด้วยรูปร่างและพื้นผิวที่มีความเที่ยงตรงสูง

- INVSR: รูปภาพขั้นตอนการปรับความละเอียดสูงผ่านการผกผันการแพร่กระจาย

- การตรวจจับ?

- Stylegan3-detector: Stylegan3 การตรวจจับภาพสังเคราะห์

- stylegan2-projecting-images: ฉายภาพไปยังพื้นที่แฝงด้วย Stylegan2

- Faldetector: การตรวจจับใบหน้า photoshopped โดยสคริปต์ Photoshop

- วิดีโอ?

เครื่องมือ

- DeepFacelab: DeepFacelab เป็นซอฟต์แวร์ชั้นนำสำหรับการสร้าง Deepfakes

- FACESWAP: ซอฟต์แวร์ DeepFakes สำหรับทุกคน

- DOT: ชุดเครื่องมือที่น่ารังเกียจของ Deepfake

- SIMSWAP: กรอบการแลกเปลี่ยนใบหน้าโดยพลการบนภาพและวิดีโอด้วยรุ่นที่ผ่านการฝึกอบรมหนึ่งรุ่น!

- FACESWAP-GAN: AutoEncoder + Denoising Autoencoder + การสูญเสียที่เป็นปฏิปักษ์และกลไกความสนใจสำหรับการแลกเปลี่ยนใบหน้า

- Celeb Deepfakeforensics: ชุดข้อมูลที่ท้าทายขนาดใหญ่สำหรับนิติเวช Deepfake

- VGEN: ระบบการสร้างวิดีโอแบบองค์รวมสำหรับการสร้างการสร้างวิดีโอในรูปแบบการแพร่กระจาย

- MUSEV: การสร้างวิดีโอมนุษย์เสมือนจริงที่มีความยาวไม่สิ้นสุด

- Glee: โมเดลมูลนิธิวัตถุทั่วไปสำหรับรูปภาพและวิดีโอในระดับ

- T-Rex: ไปสู่การตรวจจับวัตถุทั่วไปผ่านการทำงานร่วมกันของข้อความและภาพ

- Dynamicrafter: ภาพเคลื่อนไหวโดเมนเปิดโดเมนพร้อมวิดีโอ Priors Diffusion

- Mora: มากกว่า Sora สำหรับการสร้างวิดีโอทั่วไป

การใช้งาน

- FACE2FACE-DEMO: การสาธิต PIX2PIX ที่เรียนรู้จากสถานที่สำคัญบนใบหน้าและแปลสิ่งนี้เป็นใบหน้า

- FaceSwap-Deepfake-Pytorch: faceswap กับ pytorch หรือ deepfake ด้วย pytorch

- Point-E: การแพร่กระจายของคลาวด์จุดสำหรับการสังเคราะห์แบบจำลอง 3 มิติ

- EGVSR: วิดีโอที่มีประสิทธิภาพและทั่วไปความละเอียดสูง

- Stit: Stitch มันในเวลา: การแก้ไขใบหน้าของ Gan-based ของวิดีโอจริง

- พื้นหลัง Mattingv2: การปูพื้นหลังความละเอียดสูงแบบเรียลไทม์

- Modnet: โซลูชันการปูแนวตั้งแบบไม่ใช้ Trimap แบบเรียลไทม์

- การปูพื้นหลัง: การปูพื้นหลัง: โลกเป็นหน้าจอสีเขียวของคุณ

- รุ่นลำดับแรก: ที่เก็บนี้มีซอร์สโค้ดสำหรับโมเดลการเคลื่อนไหวลำดับแรกของกระดาษสำหรับภาพเคลื่อนไหวภาพ

- แอนิเมชั่นที่เน้นเสียง: ที่เก็บนี้มีซอร์สโค้ดสำหรับ CVPR'2021 การเป็นตัวแทนการเคลื่อนไหวกระดาษสำหรับแอนิเมชั่นที่พูดชัดแจ้ง

- การลบบุคคลแบบเรียลไทม์: ลบผู้คนออกจากภูมิหลังที่ซับซ้อนแบบเรียลไทม์โดยใช้ tensorflow.js ในเว็บเบราว์เซอร์

- สไตล์ Adain: การถ่ายโอนสไตล์โดยพลการแบบเรียลไทม์ด้วยการปรับอินสแตนซ์แบบปรับได้

- การแก้ไขเฟรม: การแก้ไขเฟรมสำหรับการเคลื่อนไหวขนาดใหญ่

- ภาพสีที่ยอดเยี่ยม: คอลเลกชันของภาพสีที่ใช้การเรียนรู้อย่างลึกซึ้งและกระดาษสีวิดีโอ

- Sadtalker: การเรียนรู้ค่าสัมประสิทธิ์การเคลื่อนไหว 3 มิติที่สมจริงสำหรับภาพอนิเมชั่นภาพอนิเมชั่นที่ขับเคลื่อนด้วยเสียงที่มีความคล่องแคล่ว

- Roop: คลิกแบบเดียว (การแลกเปลี่ยนใบหน้า)

- StableVideo: การแก้ไขวิดีโอการแพร่กระจายที่รับรู้ถึงความสม่ำเสมอ

- Magicedit: การแก้ไขวิดีโอที่เชื่อมโยงกันชั่วคราวสูงชั่วคราว

- RERENDER_A_VIDEO: การแปลวิดีโอแบบนำทางไปยังวิดีโอเป็นศูนย์

- DreamEditor: การแก้ไขฉาก 3 มิติที่ขับเคลื่อนด้วยข้อความด้วยทุ่งประสาท

- DreamEditor: การสังเคราะห์มุมมอง 4D แบบเรียลไทม์ที่ความละเอียด 4K

- AnimateanyOne: การสังเคราะห์ภาพต่อภาพที่สอดคล้องและควบคุมได้สำหรับภาพเคลื่อนไหวของตัวละคร

- Moore-Animateanyone: ที่เก็บนี้สร้าง animateanyone ซ้ำ

- Audio2photoreal: จากเสียงไปจนถึงศูนย์รวมแสง: สังเคราะห์มนุษย์ในการสนทนา

- MagicVideo-V2: การสร้างวิดีโอความสูงหลายขั้นตอน

- LWM: โมเดล Autoregressive หลายรูปแบบขนาดใหญ่ทั่วไป ได้รับการฝึกฝนในชุดข้อมูลขนาดใหญ่ของวิดีโอยาวและหนังสือที่หลากหลายโดยใช้ Ringattention และสามารถดำเนินการภาษารูปภาพและวิดีโอและการสร้างได้

- Aniportrait: การสังเคราะห์เสียงที่ขับเคลื่อนด้วยเสียงของภาพเคลื่อนไหวภาพบุคคล

- แชมป์: ภาพเคลื่อนไหวภาพมนุษย์ที่ควบคุมได้และสอดคล้องกันพร้อมคำแนะนำพารามิเตอร์ 3 มิติ

- Streamv2V: สตรีมมิ่งการแปลวิดีโอสู่วิดีโอด้วยฟีเจอร์แบงก์

- Deep-Live-Cam: การแลกเปลี่ยนหน้าแบบเรียลไทม์และวิดีโอ Deepfake แบบคลิกเดียวด้วยภาพเดียวเท่านั้น

- Sapiens: รากฐานสำหรับแบบจำลองการมองเห็นของมนุษย์

- การตรวจจับ?

- FaceForensics ++: ชุดข้อมูล FaceForensics

- การตรวจจับ Deepfake: ไปสู่การตรวจจับ Deepfake ที่ใช้งานได้จริง

- Fakevideoforensics: ตรวจจับวิดีโอ Fakes ลึก

- การตรวจจับ Deepfake: การใช้งาน pytorch ของการตรวจจับ deepfake ตาม faceforensics ++

- seqdeepfake: รหัส pytorch สำหรับ seqdeepfake: การตรวจจับและการกู้คืนการจัดการแบบ deepfake ตามลำดับ

- PCL-I2G: การใช้งานอย่างไม่เป็นทางการ: การเรียนรู้ความสอดคล้องของตนเองสำหรับการตรวจจับ Deepfake

- DFDC Deepfake Challenge: โซลูชันที่ได้รับรางวัลสำหรับ DFDC Challenge

- Poi-Forensics: การตรวจจับ Deepfake ของผู้มีประโยชน์ด้านเสียงและเสียง

- การตรวจจับมาตรฐานของ Deepfakes: ทำไมผู้เชี่ยวชาญบอกว่ามันสำคัญ

- ต้องการเห็น deepfake หรือไม่? มองหาดวงดาวในสายตาของพวกเขา

- ข้อความ ?

เครื่องมือ

- GLM-130B: แบบเปิดสองภาษาแบบเปิดสองภาษา

- Longtermchatexternalsources: GPT-3 chatbot พร้อมหน่วยความจำระยะยาวและแหล่งภายนอก

- Sketch: AI ผู้ช่วยเขียนโค้ดที่เข้าใจเนื้อหาข้อมูล

- Langchain: ⚡แอพพลิเคชั่นอาคารที่มี LLM ผ่านการรวมกัน⚡

- CHATGPT Wrapper: API สำหรับการโต้ตอบกับ CHATGPT โดยใช้ Python และจาก Shell

- Openai-Python: Openai Python Library ให้การเข้าถึง OpenAI API ที่สะดวกจากแอปพลิเคชันที่เขียนในภาษา Python

- Beto: รุ่น Bert เวอร์ชันภาษาสเปน

- GPT-CODE-CLIPPY: GPT-CODE-CLIPPY (GPT-CC) เป็นเวอร์ชันโอเพ่นซอร์สของ GitHub Copilot ซึ่งเป็นรูปแบบภาษา-ตาม GPT-3 เรียกว่า GPT-CODEX

- GPT Neo: การใช้งานโมเดล GPT-2 และ GPT-3 แบบจำลองแบบขนานโดยใช้ไลบรารี Mesh-Tensorflow

- CTRL: แบบจำลองภาษาหม้อแปลงแบบมีเงื่อนไขสำหรับการสร้างที่ควบคุมได้

- LLAMA: รหัสการอนุมานสำหรับรุ่น Llama

- Llama2

- Llama Guard 3

- UL2 20B: ผู้เรียนภาษาโอเพ่นซอร์สแบบครบวงจร

- BURGPT: ส่วนขยายชุด Burp ที่รวม GPT ของ OpenAI เพื่อทำการสแกนแบบพาสซีฟเพิ่มเติมเพื่อค้นหาช่องโหว่ที่มีความต้องการสูงและช่วยให้สามารถทำการวิเคราะห์ตามการจราจรทุกประเภท

- Ollama: ลุกขึ้นและทำงานกับ Llama 2 และรุ่นภาษาขนาดใหญ่อื่น ๆ ในพื้นที่

- SneakyPrompt: การสร้างแบบจำลองการสร้างข้อความเป็นภาพต่อภาพ

- Copilot-for-Security: โซลูชันความปลอดภัยที่ขับเคลื่อนด้วย AI แบบกำเนิดซึ่งช่วยเพิ่มประสิทธิภาพและความสามารถของผู้พิทักษ์เพื่อปรับปรุงผลลัพธ์ด้านความปลอดภัยด้วยความเร็วและมาตราส่วนของเครื่องในขณะที่ยังคงสอดคล้องกับหลักการ AI ที่รับผิดชอบ

- LM Studio: ค้นพบดาวน์โหลดและเรียกใช้ LLMS ท้องถิ่น

- บายพาส GPT: แปลงข้อความ AI เป็นเนื้อหาที่เหมือนมนุษย์

- MGM: เฟรมเวิร์กรองรับชุดของแบบจำลองภาษาขนาดใหญ่ที่หนาแน่นและ MOE (LLMs) จาก 2B ถึง 34B ด้วยการทำความเข้าใจภาพการใช้เหตุผลและการสร้างพร้อมกัน

- Secret Llama: LLM chatbot ส่วนตัวที่ทำงานทั้งหมดด้วยเบราว์เซอร์ที่ไม่มีเซิร์ฟเวอร์ไม่จำเป็น สนับสนุน Mistral และ Llama 3

- LLAMA3: เว็บไซต์ Meta Llama 3 GitHub อย่างเป็นทางการ

- การตรวจจับ?

- การตรวจจับข้อความปลอม: ห้องทดสอบแบบจำลองภาษายักษ์

- Grover: รหัสสำหรับการป้องกันข่าวปลอม

- rebuff.ai: เครื่องตรวจจับการฉีดทันที

- ตัวจําแนก AI ใหม่สำหรับการระบุข้อความที่เขียนด้วย AI

- ค้นพบวิธีเวทย์มนตร์ 4 วิธีในการตรวจจับข้อความที่สร้างขึ้นด้วย AI (รวมถึง CHATGPT)

- gptzero

- เครื่องตรวจจับเนื้อหา AI (เบต้า)

- ลายน้ำสำหรับรุ่นภาษาขนาดใหญ่

- สามารถตรวจพบข้อความ Ai-Generated ได้อย่างน่าเชื่อถือหรือไม่?

- เครื่องตรวจจับ GPT มีอคติต่อนักเขียนชาวอังกฤษที่ไม่ใช่เจ้าของภาษา

- ถึง chatgpt หรือไม่เพื่อพูดคุย: นั่นคือคำถาม!

- นักภาษาศาสตร์สามารถแยกความแตกต่างระหว่าง chatgpt/ai และการเขียนของมนุษย์ได้หรือไม่: การศึกษาจริยธรรมการวิจัยและการเผยแพร่ทางวิชาการ

- CHATGPT เป็นเรื่องไร้สาระ

การใช้งาน

- Handwrite: Handwrite สร้างแบบอักษรที่กำหนดเองตามตัวอย่างการเขียนด้วยลายมือของคุณ

- GPT Sandbox: เป้าหมายของโครงการนี้คือการเปิดใช้งานผู้ใช้ในการสร้างการสาธิตเว็บที่ยอดเยี่ยมโดยใช้ OpenAI GPT-3 API ที่เปิดตัวใหม่ด้วย Python เพียงไม่กี่บรรทัด

- Passgan: วิธีการเรียนรู้อย่างลึกซึ้งสำหรับการคาดเดารหัสผ่าน

- ดัชนี GPT: ดัชนี GPT เป็นโครงการที่ประกอบด้วยชุดของโครงสร้างข้อมูลที่ออกแบบมาเพื่อให้ง่ายต่อการใช้ฐานความรู้ภายนอกขนาดใหญ่ด้วย LLMS

- Nanogpt: พื้นที่เก็บข้อมูลที่ง่ายที่สุดและเร็วที่สุดสำหรับการฝึกอบรม/finetuning GPTs ขนาดกลาง

- whatsapp-gpt

- ส่วนขยาย Chatgpt Chrome: ส่วนขยาย Chatgpt Chrome รวม CHATGPT เข้ากับทุกกล่องข้อความบนอินเทอร์เน็ต

- UNILM: การฝึกอบรมก่อนการฝึกอบรมตนเองขนาดใหญ่ในงานภาษาและรังสี

- MINGPT: การใช้ Pytorch ที่น้อยที่สุดของการฝึกอบรม OpenAI GPT

- Codegeex: โมเดลการสร้างรหัสหลายภาษาแบบเปิด

- Openai Cookbook: ตัวอย่างและคำแนะนำสำหรับการใช้ OpenAI API

- - พรอมต์ chatgpt ที่ยอดเยี่ยม: repo นี้รวมถึง CHATGPT Promp Curation เพื่อใช้ chatgpt ดีกว่า

- อลิซ: ให้ผู้แชทเข้าถึงเทอร์มินัลจริง

- รีวิวรหัสความปลอดภัยด้วย chatgpt

- ผู้ใช้เขียนรหัสที่ไม่ปลอดภัยมากขึ้นกับผู้ช่วย AI หรือไม่?

- ข้ามตัวกรองสแปมของ Gmail ด้วย chatgpt

- แคร็กเกอร์รหัสผ่าน Gans ซ้ำสำหรับการปรับปรุงความปลอดภัยรหัสผ่าน IoT

- PENTESTGPT: เครื่องมือทดสอบการเจาะทะลุ GPT ที่มีอำนาจ

- นักวิจัย GPT: ตัวแทนอิสระจาก GPT ซึ่งทำการวิจัยที่ครอบคลุมออนไลน์ในหัวข้อใดก็ได้

- วิศวกร GPT: ระบุสิ่งที่คุณต้องการให้สร้าง AI ขอให้คำชี้แจงและสร้างมันขึ้นมา

- LocalPilot: ใช้ GitHub Copilot ในท้องถิ่นบน MacBook ของคุณด้วยคลิกเดียว!

- [WORMGPT]) (https://thehackernews.com/2023/07/wormgpt-new-ai-tool-allows.html): เครื่องมือ AI ใหม่ช่วยให้อาชญากรไซเบอร์เปิดตัวการโจมตีทางไซเบอร์ที่ซับซ้อน

- Poisongpt: เราซ่อนตัว LLM lobotomized เมื่อกอดหน้าเพื่อกระจายข่าวปลอม

- PassGPT: การสร้างแบบจำลองรหัสผ่านและการสร้าง (ไกด์) ที่มีรูปแบบภาษาขนาดใหญ่

- Deeppass - ค้นหารหัสผ่านที่มีการเรียนรู้อย่างลึกซึ้ง

- GPTFUZZ: RED Teaming รุ่นภาษาขนาดใหญ่ที่มีพรอมต์การแหกคุกที่สร้างขึ้นอัตโนมัติ

- Open Interpreter: Code Interpreter ของ OpenAi ในเทอร์มินัลของคุณทำงานในพื้นที่

- ยูเรก้า: การออกแบบรางวัลระดับมนุษย์ผ่านการเข้ารหัสแบบจำลองภาษาขนาดใหญ่

- Metaclip: ข้อมูลคลิป demystifying

- LLM OSINT: วิธีการพิสูจน์แนวคิดของการใช้ LLM เพื่อรวบรวมข้อมูลจากอินเทอร์เน็ตจากนั้นทำงานกับข้อมูลนี้

- HackingBuddyGpt: LLMS X Pentesting

- CHATGPT-JAILBREAKS: การแหกคุกอย่างเป็นทางการสำหรับ CHATGPT (GPT-3.5) ส่งข้อความยาว ๆ ในช่วงเริ่มต้นของการสนทนากับ CHATGPT เพื่อรับคำตอบที่น่ารังเกียจผิดจรรยาบรรณก้าวร้าวและเหมือนมนุษย์ในภาษาอังกฤษและอิตาลี

- Magika: ตรวจจับประเภทเนื้อหาไฟล์ด้วยการเรียนรู้อย่างลึกซึ้ง

- ม.ค. : ทางเลือกโอเพ่นซอร์สสำหรับ CHATGPT ที่ทำงานออฟไลน์ 100% บนคอมพิวเตอร์ของคุณ

- Librechat: การปรับปรุง chatgpt clone: คุณสมบัติ Openai, Assistants API, Azure, Groq, GPT-4 Vision, Mistral, Bing, มานุษยวิทยา, OpenRouter, Vertex AI, Gemini, การสลับโมเดล AI, การค้นหาข้อความ, Langchain, Dall-e-3 ปลั๊กอิน, ฟังก์ชั่น openai, ระบบผู้ใช้หลายคนที่ปลอดภัย, การตั้งค่าล่วงหน้า, โอเพ่นซอร์สอย่างสมบูรณ์สำหรับการโฮสต์ตัวเอง

- LUMINA-T2X: เฟรมเวิร์กแบบครบวงจรสำหรับข้อความไปยังรุ่นใด ๆ

ผิด

- GPT + ความปลอดภัยที่ยอดเยี่ยม: รายการเครื่องมือรักษาความปลอดภัยที่ยอดเยี่ยมกรณีทดลองหรือสิ่งที่น่าสนใจอื่น ๆ ด้วย LLM หรือ GPT

- การเรียนรู้การเสริมแรงที่ยอดเยี่ยมเพื่อความปลอดภัยในโลกไซเบอร์: รายการทรัพยากรที่รวบรวมไว้เพื่อการเรียนรู้การเสริมแรงที่ใช้กับความปลอดภัยของไซเบอร์

- การเรียนรู้ของเครื่องจักรที่ยอดเยี่ยมสำหรับการรักษาความปลอดภัยในโลกไซเบอร์: รายการเครื่องมือและทรัพยากรที่ยอดเยี่ยมอย่างน่าอัศจรรย์ที่เกี่ยวข้องกับการใช้การเรียนรู้ของเครื่องเพื่อความปลอดภัยในโลกไซเบอร์

- การกอดแบบจำลองการแพร่กระจายของใบหน้า: วัสดุสำหรับหลักสูตรการแพร่กระจายของใบหน้ากอด

- Awesome-AI-Security: รายการทรัพยากรความปลอดภัย AI ที่รวบรวมไว้

- ML สำหรับแฮ็กเกอร์: รหัสที่มาพร้อมกับหนังสือ "Machine Learning for Hackers"

- AI ที่น่ากลัว: AID AI เป็นรายการที่รวบรวมไว้เพื่อติดตามประเพณีที่น่ากลัวในปัจจุบันของ AI - หวังว่าจะสร้างความตระหนัก

- NIST AI Framework Framework Framework Plamework

- SOK: การเรียนรู้ของเครื่องที่อธิบายได้สำหรับแอปพลิเคชันความปลอดภัยของคอมพิวเตอร์

- ใครประเมินผู้ประเมิน? เกี่ยวกับตัวชี้วัดอัตโนมัติสำหรับการประเมินเครื่องกำเนิดรหัสที่ไม่เหมาะสม AI ที่ใช้ AI

- การจัดลำดับความสำคัญของช่องโหว่: วิธีการรักษาความปลอดภัยที่น่ารังเกียจ

- MITER ATLAS ™ (ภูมิทัศน์ภัยคุกคามที่เป็นภัย

- การสำรวจความปลอดภัยในการเรียนรู้การเสริมแรงด้วยแอปพลิเคชันเพื่อการขับขี่แบบอิสระ

- วิธีหลีกเลี่ยงข้อผิดพลาดในการเรียนรู้ของเครื่อง: คู่มือสำหรับนักวิจัยเชิงวิชาการ

- รายชื่อกิจกรรมการรักษาความปลอดภัยและความเป็นส่วนตัวของ AI CURATED

- NIST AI 100-2 E2023: การเรียนรู้ของเครื่องจักรกันเอง อนุกรมวิธานและคำศัพท์ของการโจมตีและการบรรเทา

- - RootedCon 2023 - Inteligencia Artificial Ofensiva - ¿Cómo Podemos Estar Preparados?

- ความปลอดภัยของระบบ AI: พื้นฐาน - การเรียนรู้ลึกซึ้งฝ่ายตรงข้าม

- นอกเหนือจากการป้องกัน: สำรวจความเสี่ยงด้านความปลอดภัยของ CHATGPT

- แผนที่พื้นผิวการโจมตี AI v1.0

- เกี่ยวกับความปลอดภัยที่เป็นไปไม่ได้ของรุ่น AI ขนาดใหญ่

- กฎระเบียบ Frontier AI: การจัดการความเสี่ยงที่เกิดขึ้นเพื่อความปลอดภัยสาธารณะ

- เฟรมเวิร์กหลายชั้นสำหรับแนวทางปฏิบัติด้านความปลอดภัยทางไซเบอร์ที่ดีสำหรับ AI

- แนะนำกรอบ AI ที่ปลอดภัยของ Google

- OWASP TOP 10 สำหรับ LLM

- ความปลอดภัย LLM ที่ยอดเยี่ยม: การจัดการเครื่องมือเอกสารและโครงการที่ยอดเยี่ยมเกี่ยวกับ LLM Security

- กรอบการใช้งาน LLM ใน บริษัท อย่างปลอดภัย ส่วนที่ 1: ภาพรวมของความเสี่ยง ส่วนที่ 2: การจัดการความเสี่ยง ส่วนที่ 3: การรักษาความปลอดภัย CHATGPT และ GitHub Copilot

- การศึกษาเกี่ยวกับความแข็งแกร่งและความน่าเชื่อถือของการสร้างรหัสรูปแบบภาษาขนาดใหญ่

- การระบุภาพ Ai-Generated ด้วย synthid

- การตรวจสอบโมเดลภาษาขนาดใหญ่: วิธีการสามชั้น

- การแก้ไขการต่อสู้ระยะสั้นกับความเสี่ยง AI ระยะยาว

- Fraudgpt: อวตารของวายร้ายของ CHATGPT

- ความเสี่ยงของ AI - Schneier on Security

- การใช้ LLM เพื่อวัตถุประสงค์ที่ผิดกฎหมาย: ภัยคุกคามมาตรการป้องกันและช่องโหว่

- AI RED-TEAMING ไม่ได้เป็นทางออกแบบครบวงจรสำหรับ AI Harms: คำแนะนำสำหรับการใช้การกำหนดด้วยการกำหนดความรับผิดชอบ AI สีแดงสำหรับ AI

- อนุกรมวิธานของความน่าเชื่อถือสำหรับปัญญาประดิษฐ์

- การจัดการความเสี่ยง AI ในยุคของความก้าวหน้าอย่างรวดเร็ว

- Google - ทำตามความมุ่งมั่นของเราที่ปลอดภัยและปลอดภัย AI

- Playbook ML ที่น่ารังเกียจ

- Demystifying AI Generative? บันทึกของนักวิจัยด้านความปลอดภัย

- Genai-Security-Adventures: ความคิดริเริ่มโอเพนซอร์ซเพื่อแบ่งปันบันทึกย่องานนำเสนอและคอลเลกชันที่หลากหลายของการทดลองที่นำเสนอในสมุดบันทึก Jupyter ทั้งหมดมีวัตถุประสงค์เพื่อช่วยให้คุณเข้าใจแนวคิดที่สำคัญเบื้องหลังแบบจำลองภาษาขนาดใหญ่และสำรวจจุดตัดที่น่าสนใจของความปลอดภัยและธรรมชาติ การประมวลผลภาษา

- AI Safety Camp เชื่อมโยงคุณกับการวิจัยที่นำไปทำงานร่วมกันในโครงการ - เพื่อดูว่างานของคุณสามารถช่วยให้มั่นใจได้ว่า AI ในอนาคตจะปลอดภัย

- แนวทางการพัฒนาระบบ AI ที่ปลอดภัย

- วิธีการปัญญาประดิษฐ์และความปลอดภัยทางไซเบอร์ รายงานแนวปฏิบัติที่ดีที่สุด

- Stanford Safe ปลอดภัยและน่าเชื่อถือ AI EO 14110 Tracker

- Security ML ที่ยอดเยี่ยม: รายการที่รวบรวมของการอ้างอิงความปลอดภัยของการเรียนรู้ของเครื่องที่ยอดเยี่ยมคำแนะนำเครื่องมือและอื่น ๆ

- เส้นทางที่คาดการณ์ได้ของ AI: 7 สิ่งที่คาดหวังจาก AI ในปี 2024+

- ปัญญาประดิษฐ์และความปลอดภัยทางไซเบอร์ (เป็นภาษาสเปน ??)

- Vigil: ตรวจจับการฉีดทันทีการแหกคุกและอินพุตแบบจำลองภาษาขนาดใหญ่ที่มีความเสี่ยงอื่น ๆ (LLM) ที่มีความเสี่ยงอื่น ๆ

- แบบจำลอง AI Generative - โอกาสและความเสี่ยงสำหรับอุตสาหกรรมและหน่วยงาน

- การปรับใช้ระบบ AI อย่างปลอดภัย แนวทางปฏิบัติที่ดีที่สุดสำหรับการปรับใช้ระบบ AI ที่ปลอดภัยและยืดหยุ่น

- NIST AI 600-1: กรอบการจัดการความเสี่ยงด้านปัญญาประดิษฐ์: โปรไฟล์ปัญญาประดิษฐ์กำเนิดกำเนิด

- - ANSSI: ข้อเสนอแนะ de Sécurité pour un système d'ia générative (คำแนะนำด้านความปลอดภัยสำหรับระบบ AI กำเนิดกำเนิด)

- Pyrit: เครื่องมือระบุความเสี่ยงของ Python สำหรับ Generative AI (Pyrit) เป็นกรอบการทำงานอัตโนมัติแบบเปิดเพื่อเพิ่มขีดความสามารถให้ผู้เชี่ยวชาญด้านความปลอดภัยและวิศวกรการเรียนรู้ของเครื่องเพื่อค้นหาความเสี่ยงในระบบ AI ที่เกิดขึ้นเชิงรุก

- OWASP-AGENTIC-AI: ทำงานเพื่อสร้าง OWASP TOP 10 สำหรับ AGETIC AI (AI Agent Security)

- สู่การรับประกัน AI Safe: กรอบการทำงานเพื่อให้มั่นใจว่าระบบ AI ที่แข็งแกร่งและเชื่อถือได้

- กำหนดความเสี่ยง AI ที่แท้จริง

- แนวทางที่ปลอดภัยในการกำเนิด AI

- แบบจำลองภาษาขนาดใหญ่ในโลกไซเบอร์

- เฮ้นั่นคือนางแบบของฉัน! แนะนำ Chain & Hash ซึ่งเป็นเทคนิคการพิมพ์ลายนิ้วมือ LLM

- การใช้ AI ในทางที่ผิด: อนุกรมวิธานของยุทธวิธีและข้อมูลเชิงลึกจากข้อมูลโลกแห่งความเป็นจริง

- พื้นที่เก็บข้อมูลความเสี่ยงของ AI

- ทบทวน AI Red-Teaming

- คำแนะนำจากเยอรมัน-ฝรั่งเศสสำหรับการใช้ผู้ช่วยโปรแกรม AI

- ลายน้ำที่ปรับขนาดได้สำหรับการระบุเอาต์พุตแบบจำลองภาษาขนาดใหญ่

การสำรวจ

- ภัยคุกคามของ AI ที่น่ารังเกียจต่อองค์กร

- ปัญญาประดิษฐ์ในโดเมนไซเบอร์: ความผิดและการป้องกัน

- การสำรวจการโจมตีและการป้องกันที่เป็นปฏิปักษ์

- การเรียนรู้อย่างลึกซึ้งฝ่ายตรงข้าม: การสำรวจเกี่ยวกับการโจมตีของฝ่ายตรงข้ามและกลไกการป้องกันในการจำแนกภาพ

- การสำรวจการโจมตีความเป็นส่วนตัวในการเรียนรู้ของเครื่องจักร

- ต่อภัยคุกคามความปลอดภัยของระบบการเรียนรู้ลึก: การสำรวจ

- การสำรวจภัยคุกคามความปลอดภัยและเทคนิคการป้องกันของการเรียนรู้ของเครื่อง: มุมมองที่ขับเคลื่อนด้วยข้อมูล

- SOK: ความปลอดภัยและความเป็นส่วนตัวในการเรียนรู้ของเครื่อง

- การเรียนรู้ของเครื่องจักรที่เป็นปฏิปักษ์: การเพิ่มขึ้นของอาชญากรรมที่เปิดใช้งาน AI และบทบาทในการหลีกเลี่ยงตัวกรองสแปม

- ภัยคุกคามช่องโหว่และการควบคุมระบบการเรียนรู้ของเครื่อง: การสำรวจและอนุกรมวิธาน

- การโจมตีและการป้องกันที่เป็นปฏิปักษ์: การสำรวจ

- เรื่องความปลอดภัย: การสำรวจเกี่ยวกับการเรียนรู้ของเครื่องจักรศัตรู

- การสำรวจการโจมตีของฝ่ายตรงข้ามสำหรับการวิเคราะห์มัลแวร์

- การเรียนรู้ของเครื่องจักรที่เป็นปฏิปักษ์ในการจำแนกรูปภาพ: การสำรวจสู่มุมมองของผู้พิทักษ์

- การสำรวจการฝึกอบรมฝ่ายตรงข้ามที่แข็งแกร่งในการจดจำรูปแบบ: พื้นฐานทฤษฎีและวิธีการ

- ความเป็นส่วนตัวในรูปแบบภาษาขนาดใหญ่: การโจมตีการป้องกันและทิศทางในอนาคต

- ผู้ดูแล?

Miguel Hernández |

José Ignacio Escribano |

©️ใบอนุญาต©️

- Creative Commons Attribution-Share Alike 4.0 International