TEXTOIR เป็นแพลตฟอร์มการรับรู้ข้อความเปิดคุณภาพสูงแห่งแรก Repo นี้มีชุดเครื่องมือที่สะดวกสบายพร้อมอินเทอร์เฟซที่ขยายได้ ซึ่งรวมชุดอัลกอริธึมที่ล้ำสมัยของสองงาน (การตรวจจับเจตนาแบบเปิดและการค้นพบเจตนาแบบเปิด) นอกจากนี้เรายังเผยแพร่เฟรมเวิร์กไปป์ไลน์และแพลตฟอร์มที่มองเห็นได้ใน repo TEXTOIR-DEMO

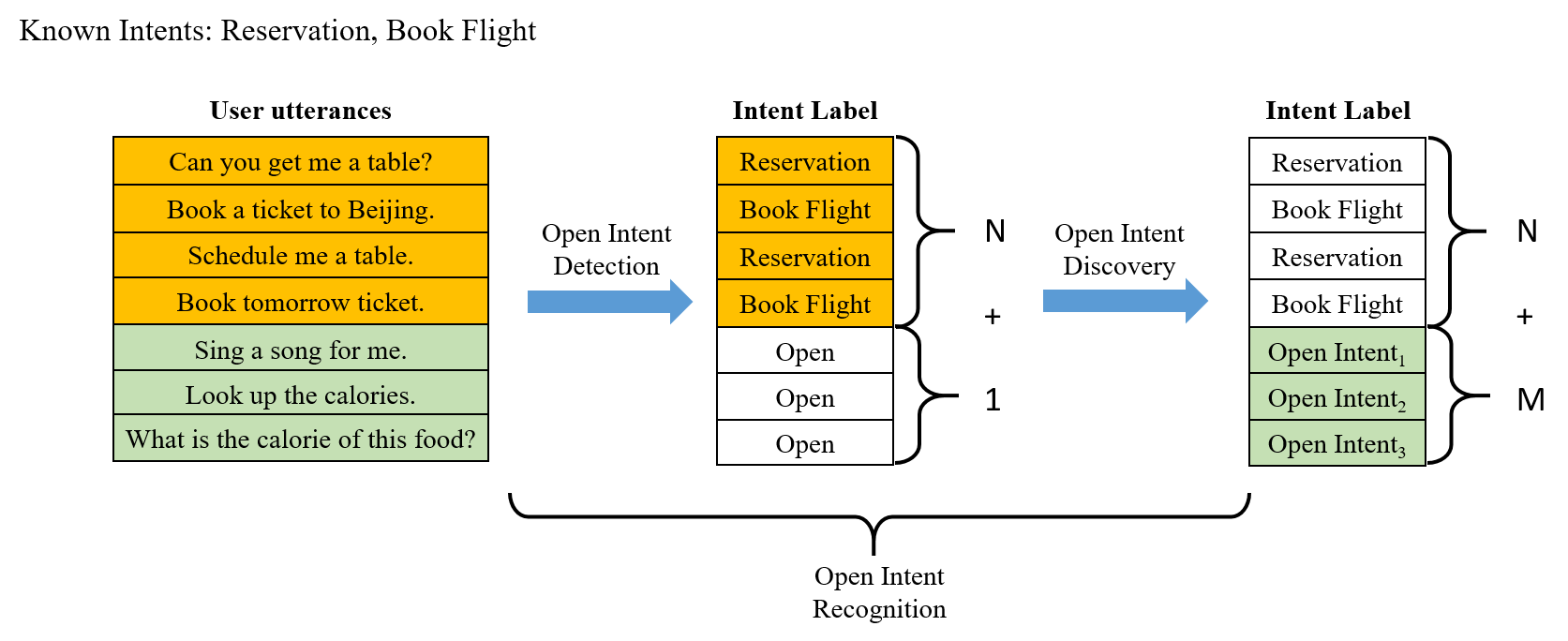

TEXTOIR มุ่งหวังที่จะจัดเตรียมชุดเครื่องมืออำนวยความสะดวกสำหรับนักวิจัยในการทำซ้ำวิธีการจำแนกประเภทข้อความแบบเปิดและการจัดกลุ่มแบบเปิดที่เกี่ยวข้องกัน ประกอบด้วยสองงาน ซึ่งถูกกำหนดให้เป็นการตรวจจับเจตนาแบบเปิดและการค้นพบเจตนาแบบเปิด การตรวจจับเจตนาแบบเปิดมีจุดมุ่งหมายเพื่อระบุเจตนาที่รู้จักในคลาส n และตรวจจับเจตนาแบบเปิดระดับเดียว การค้นพบเจตนาแบบเปิดมีจุดมุ่งหมายเพื่อใช้ประโยชน์จากความรู้เดิมที่จำกัดเกี่ยวกับเจตนาที่ทราบ เพื่อค้นหาคลัสเตอร์ที่ทราบเจตนาแบบเปิดที่มีรายละเอียดละเอียด เอกสารและรหัสที่เกี่ยวข้องจะถูกรวบรวมไว้ในรายการเรื่องรออ่านที่เผยแพร่ก่อนหน้านี้ของเรา

เปิดการรับรู้เจตนา:

| วันที่ | ประกาศ |

|---|---|

| 12/2023 | - - บทความใหม่และ SOTA ใน Open Intent Discovery โปรดดูไดเร็กทอรี USNID สำหรับรหัส อ่านบทความ -- กรอบงานการจัดกลุ่มสำหรับการค้นพบเจตนาใหม่แบบไม่ได้รับการดูแลและแบบกึ่งกำกับดูแล (เผยแพร่ใน IEEE TKDE 2023) |

| 04/2023 | - - เอกสารใหม่และ SOTA ใน Open Intent Detection โปรดดูไดเร็กทอรี DA-ADB สำหรับโค้ด อ่านบทความ -- การเรียนรู้การนำเสนอแบบแบ่งแยกและขอบเขตการตัดสินใจสำหรับการตรวจจับเจตนาแบบเปิด (เผยแพร่ใน IEEE/ACM TASLP 2023) |

| 09/2021 | - - แพลตฟอร์มแรกที่บูรณาการและแสดงภาพสำหรับข้อความ Open Intent Recognition TEXTOIR ได้รับการเผยแพร่แล้ว โปรดดูไดเร็กทอรี TEXTOIR-DEMO สำหรับรหัสสาธิต อ่านรายงานของเรา TEXTOIR: แพลตฟอร์มแบบบูรณาการและมองเห็นได้สำหรับการรับรู้เจตนาข้อความแบบเปิด (เผยแพร่ใน ACL 2021) |

| 05/2021 | เอกสารและบรรทัดฐานใหม่ DeepAligned ใน Open Intent Discovery ได้รับการเผยแพร่แล้ว อ่านบทความของเรา Discovering New Intents with Deep Aligned Clustering (เผยแพร่ใน AAAI 2021) |

| 05/2021 | รายงานและบรรทัดฐานใหม่ ADB ใน Open Intent Detection ได้รับการเผยแพร่แล้ว อ่านบทความของเรา การจำแนกประเภทเจตนาแบบเปิดกว้างพร้อมขอบเขตการตัดสินใจแบบปรับเปลี่ยนได้ (เผยแพร่ใน AAAI 2021) |

| 05/2020 | เอกสารใหม่และบรรทัดฐาน CDAC+ ใน Open Intent Discovery ได้รับการเผยแพร่แล้ว อ่านบทความของเรา การค้นพบเจตนาใหม่ผ่านการจัดกลุ่มแบบปรับตัวเชิงลึกที่มีข้อจำกัดพร้อมการปรับแต่งคลัสเตอร์ (เผยแพร่ใน AAAI 2020) |

| 07/2019 | เอกสารและบรรทัดฐานใหม่ DeepUNK ใน Open Intent Detection ได้รับการเผยแพร่แล้ว อ่านบทความของเรา Deep Unknown Intent Detection พร้อม Margin Loss (เผยแพร่ใน ACL 2019) |

เราขอแนะนำอย่างยิ่งให้คุณใช้ชุดเครื่องมือ TEXTOIR ซึ่งมีอินเทอร์เฟซมาตรฐานและแบบครบวงจร (โดยเฉพาะการตั้งค่าข้อมูล) เพื่อให้ได้ผลลัพธ์ที่ยุติธรรมและน่าเชื่อถือสำหรับชุดข้อมูลความตั้งใจในการวัดประสิทธิภาพ!

| ชุดข้อมูล | แหล่งที่มา |

|---|---|

| การธนาคาร | กระดาษ |

| OOS/คลินิก150 | กระดาษ |

| สแต็คโอเวอร์โฟลว์ | กระดาษ |

| ชื่อรุ่น | แหล่งที่มา | ที่ตีพิมพ์ |

|---|---|---|

| โอเพ่นแม็กซ์* | รหัสกระดาษ | ซีพีอาร์ 2016 |

| เอ็มเอสพี | รหัสกระดาษ | ไอซีแอลอาร์ 2017 |

| หมอ | รหัสกระดาษ | เอ็มแอลพี 2017 |

| ดีพอังก์ | รหัสกระดาษ | เอซีแอล 2019 |

| สค | รหัสกระดาษ | เอซีแอล 2020 |

| เอดีบี | รหัสกระดาษ | AAAI 2021 |

| (K+1)-ทาง | รหัสกระดาษ | เอซีแอล 2021 |

| ไม้เอ็มดีเอฟ | รหัสกระดาษ | เอซีแอล 2021 |

| เออาร์พีแอล* | รหัสกระดาษ | IEEE TPAMI 2022 |

| เคเอ็นซีแอล | รหัสกระดาษ | เอซีแอล 2022 |

| DA-ADB | รหัสกระดาษ | IEEE/ACM TASLP 2023 |

| การตั้งค่า | ชื่อรุ่น | แหล่งที่มา | ที่ตีพิมพ์ |

|---|---|---|---|

| ไม่ได้รับการดูแล | กม | กระดาษ | บีเอสเอ็มเอสพี 1967 |

| ไม่ได้รับการดูแล | เอจี | กระดาษ | ประชาสัมพันธ์ 2521 |

| ไม่ได้รับการดูแล | แซ่-กม | กระดาษ | เจเอ็มแอลอาร์ 2010 |

| ไม่ได้รับการดูแล | ธ.ค | รหัสกระดาษ | ไอซีเอ็มแอล 2016 |

| ไม่ได้รับการดูแล | ดีซีเอ็น | รหัสกระดาษ | ไอซีเอ็มแอล 2017 |

| ไม่ได้รับการดูแล | ซีซี | รหัสกระดาษ | AAAI 2021 |

| ไม่ได้รับการดูแล | เอสซีซีแอล | รหัสกระดาษ | เอ็นเอเอซีแอล 2021 |

| ไม่ได้รับการดูแล | USNID | รหัสกระดาษ | IEEE TKDE2023 |

| กึ่งกำกับดูแล | เคซีแอล* | รหัสกระดาษ | ไอซีแอลอาร์ 2018 |

| กึ่งกำกับดูแล | เอ็มซีแอล* | รหัสกระดาษ | ไอซีแอลอาร์ 2019 |

| กึ่งกำกับดูแล | ดีทีซี* | รหัสกระดาษ | ไอซีซีวี 2019 |

| กึ่งกำกับดูแล | ซีดีเอซี+ | รหัสกระดาษ | AAAI 2020 |

| กึ่งกำกับดูแล | จัดชิดลึก | รหัสกระดาษ | AAAI 2021 |

| กึ่งกำกับดูแล | จีซีดี | รหัสกระดาษ | ซีวีพีอาร์ 2022 |

| กึ่งกำกับดูแล | MTP-CLNN | รหัสกระดาษ | เอซีแอล 2022 |

| กึ่งกำกับดูแล | USNID | รหัสกระดาษ | IEEE TKDE2023 |

(* หมายถึงโมเดล CV ที่แทนที่ด้วยแกนหลัก BERT)

conda create --name textoir python=3.6

conda activate textoir

conda install pytorch torchvision torchaudio cudatoolkit=11.0 -c pytorch -c conda-forge

git clone [email protected]:thuiar/TEXTOIR.git

cd TEXTOIR

cd open_intent_detection

pip install -r requirements.txt

sh examples/run_ADB.sh

ชุดเครื่องมือนี้สามารถขยายได้และรองรับการเพิ่มวิธีการ ชุดข้อมูล การกำหนดค่า แบ็คโบน ตัวโหลดข้อมูล และการสูญเสียข้อมูลใหม่ได้อย่างสะดวก ข้อมูลรายละเอียดเพิ่มเติมสามารถดูได้ในบทช่วยสอนของไดเร็กทอรี open_intent_detection และ open_intent_discovery

หากงานนี้มีประโยชน์ หรือคุณต้องการใช้โค้ดและผลลัพธ์ใน Repo นี้ โปรดอ้างอิงเอกสารต่อไปนี้:

@inproceedings{zhang-etal-2021-textoir,

title = "{TEXTOIR}: An Integrated and Visualized Platform for Text Open Intent Recognition",

author = "Zhang, Hanlei and Li, Xiaoteng and Xu, Hua and Zhang, Panpan and Zhao, Kang and Gao, Kai",

booktitle = "Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing: System Demonstrations",

pages = "167--174",

year = "2021",

url = "https://aclanthology.org/2021.acl-demo.20",

doi = "10.18653/v1/2021.acl-demo.20",

}

@article{DA-ADB,

title = {Learning Discriminative Representations and Decision Boundaries for Open Intent Detection},

author = {Zhang, Hanlei and Xu, Hua and Zhao, Shaojie and Zhou, Qianrui},

journal = {IEEE/ACM Transactions on Audio, Speech, and Language Processing},

volume = {31},

pages = {1611-1623},

year = {2023},

doi = {10.1109/TASLP.2023.3265203}

}

@ARTICLE{USNID,

author={Zhang, Hanlei and Xu, Hua and Wang, Xin and Long, Fei and Gao, Kai},

journal={IEEE Transactions on Knowledge and Data Engineering},

title={A Clustering Framework for Unsupervised and Semi-supervised New Intent Discovery},

year={2023},

doi={10.1109/TKDE.2023.3340732}

}

ฮั่นเล่ย จาง, เชาเจี๋ย จ้าว, ซิน หวาง, ติงเอิน หลิน, เฉียนรุย โจว, ฮุ่ยเซิง เหมา

หากคุณมีคำถามใดๆ โปรดเปิดประเด็นและอธิบายปัญหาของคุณให้ละเอียดที่สุด หากคุณต้องการรวมวิธีการของคุณเข้ากับ repo ของเรา โปรด ดึงคำขอ ได้เลย!