สำคัญ

2024.10.10: การผ่าตัดการคืนค่าไฟล์ฉุกเฉินของไฟล์เซิร์ฟเวอร์ที่ให้แพ็คเกจ WHL

2024.10.8: เวอร์ชัน 3..90 เพิ่มการสนับสนุนเบื้องต้นสำหรับ Llama-Idex, เวอร์ชัน 3.80 เพิ่มฟังก์ชั่นเมนูรองปลั๊กอิน (ดูรายละเอียด Wiki)

2024.5.1: เพิ่มฟังก์ชั่นของเอกสาร PDF การแปล doc2x, ดูรายละเอียด

2024.3.11: สนับสนุนรูปแบบภาษาขนาดใหญ่ของจีนอย่างเต็มที่เช่น Qwen, GLM, DeepSeekCoder! โมดูลการโคลนเสียงของ Sovits, ดูรายละเอียด 2024.1.17: เมื่อติดตั้งการพึ่งพาให้เลือก รุ่นที่ระบุ ใน requirements.txt คำสั่งการติดตั้ง: pip install -r requirements.txt โครงการนี้เป็นโอเพ่นซอร์สอย่างสมบูรณ์และฟรี

ถ้าคุณชอบโครงการนี้โปรดให้ดาว

ถ้าคุณชอบ multi_language.py นี้โปรดให้ดาว

บันทึก

1. ฟังก์ชั่นของแต่ละไฟล์ในโครงการนี้คือรายงานการแปลตัวเอง self_analysis.md ด้วยการวนซ้ำของเวอร์ชันคุณสามารถคลิกที่ปลั๊กฟังก์ชั่นที่เกี่ยวข้องในเวลาใดก็ได้เพื่อเรียกรายงาน GPT Re -GPT -GENERATION SELF -PARSING สำหรับคำถามทั่วไปโปรดตรวจสอบวิกิ

2. โครงการนี้เข้ากันได้กับและส่งเสริมการทดลองใช้แบบจำลองฐานภาษาจีนขนาดใหญ่ในประเทศเช่น Tongyi Qianqian, Wisdom Spectrum GLM ฯลฯ รองรับการอยู่ร่วมกันของ API-KEY หลายครั้งคุณสามารถกรอกข้อมูลในไฟล์การกำหนดค่าเช่น API_KEY="openai-key1,openai-key2,azure-key3,api2d-key4" เมื่อคุณต้องการเปลี่ยน API_KEY ชั่วคราวให้ป้อน API_KEY ชั่วคราวในพื้นที่อินพุตแล้วส่งไปยังปุ่ม Ride เพื่อให้มีผล

| ฟังก์ชั่น (= คุณสมบัติใหม่ล่าสุด) | อธิบาย |

|---|---|

| รุ่นใหม่ | Baidu Qianfan และ Wenxin กล่าว, Tongyi Qian Qi Qwen, Shanghai Ai-Lab Scholar, Xun Feixing Fire, Llama2, ความเร็ว Wisdom GLM4, Dalle3, DeepseekCoder |

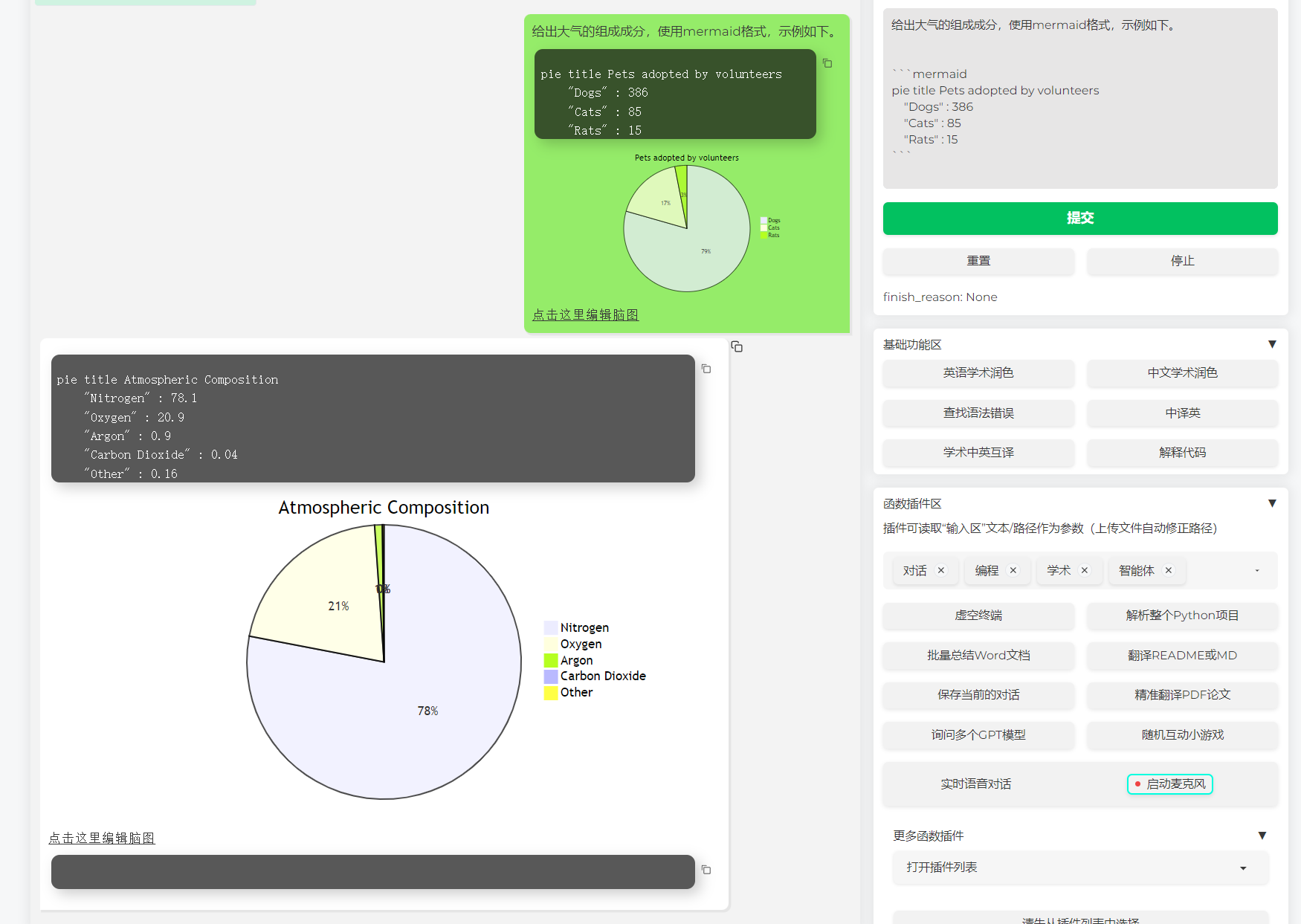

| รองรับการแสดงภาพนางเงือก | สนับสนุนเพื่ออนุญาตให้ GPT สร้างผังงานแผนภูมิการถ่ายโอนสถานะแผนผัง GAND แผนที่เค้ก gitgraph ฯลฯ (เวอร์ชัน 3.7) |

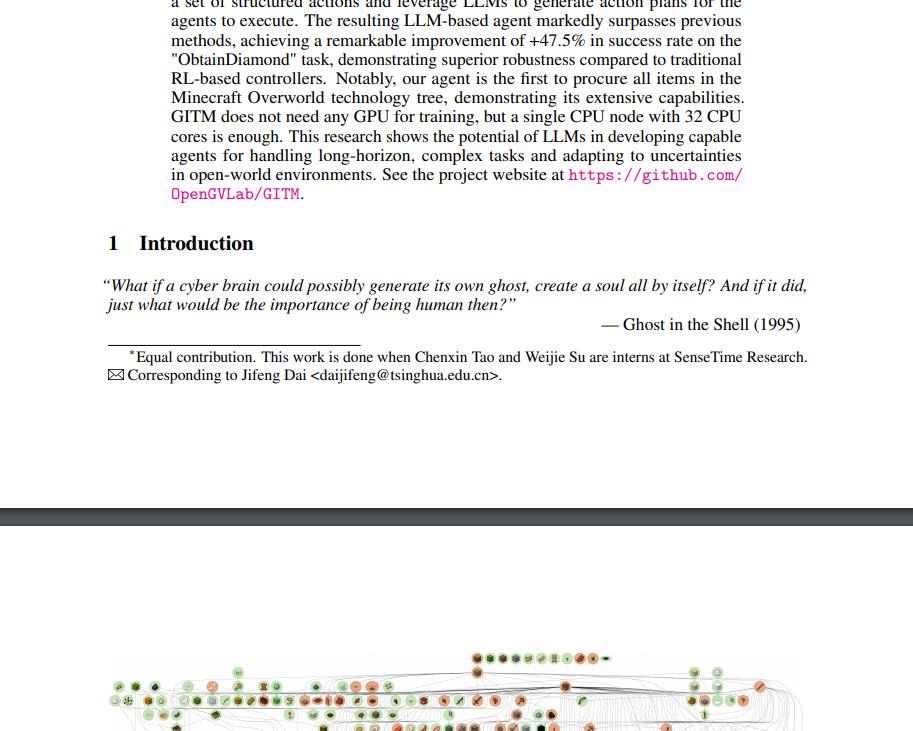

| Arxiv วิทยานิพนธ์การแปลที่ดี (Docker) | [plug -in] หนึ่ง -click การแปลของวิทยานิพนธ์ arxiv ด้วยหนึ่ง -click เครื่องมือแปลกระดาษที่ดีที่สุดในปัจจุบัน |

| อินพุตกล่องโต้ตอบเสียงจริง -เวลา | [plug -in] เสียงฟังแบบอะซิงโครนัส, การขาดการเชื่อมต่อประโยคอัตโนมัติ, ค้นหาเวลาในการตอบโดยอัตโนมัติ |

| ปลั๊กอิน Autogen Multi -Smart | [plug -in] ด้วยความช่วยเหลือของ Microsoft Autogen สำรวจความเป็นไปได้ของการเกิดขึ้นอย่างชาญฉลาดของตัวแทน Duo! |

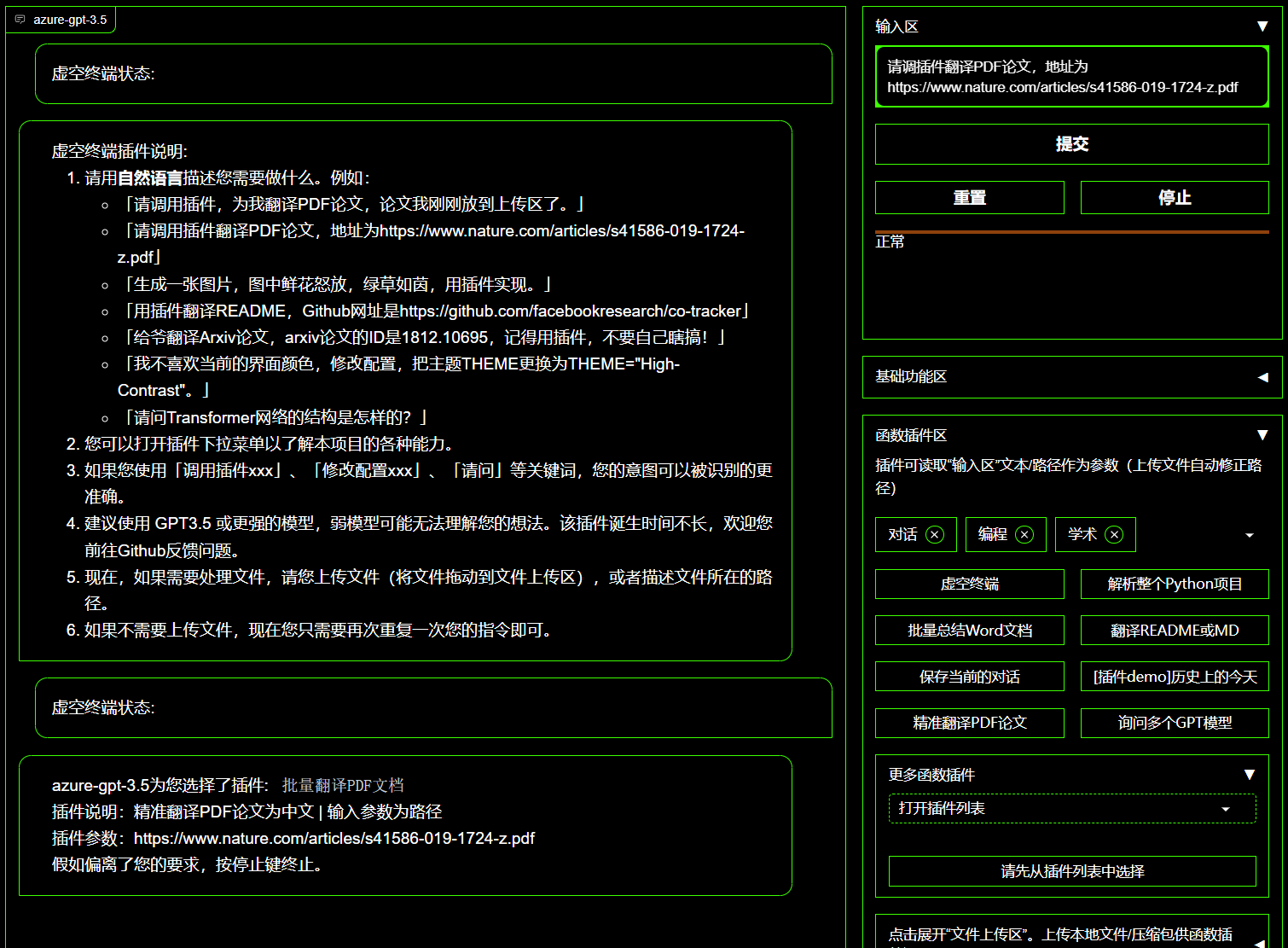

| โมฆะปลั๊กอินเทอร์มินัล | [plug -in] สามารถกำหนดเวลาปลั๊กอื่น ๆ ในโครงการนี้ได้โดยตรงในภาษาธรรมชาติ |

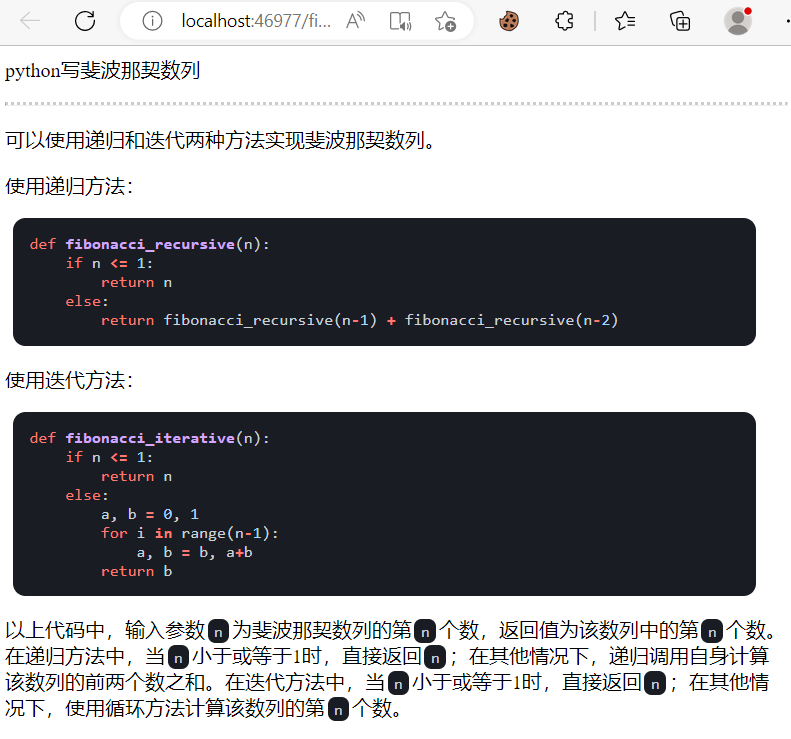

| การตีความสีการแปลรหัสคำอธิบาย | การชุ่มชื้นแบบคลิกหนึ่งการแปลการค้นหาข้อผิดพลาดทางไวยากรณ์เอกสารรหัสการตีความ |

| คีย์ทางลัดที่กำหนดเอง | รองรับปุ่มทางลัดที่กำหนดเอง |

| การออกแบบแบบแยกส่วน | รองรับปลั๊กที่แข็งแกร่งที่กำหนดเองเสียบปลั๊กรองรับการอัปเดตร้อน |

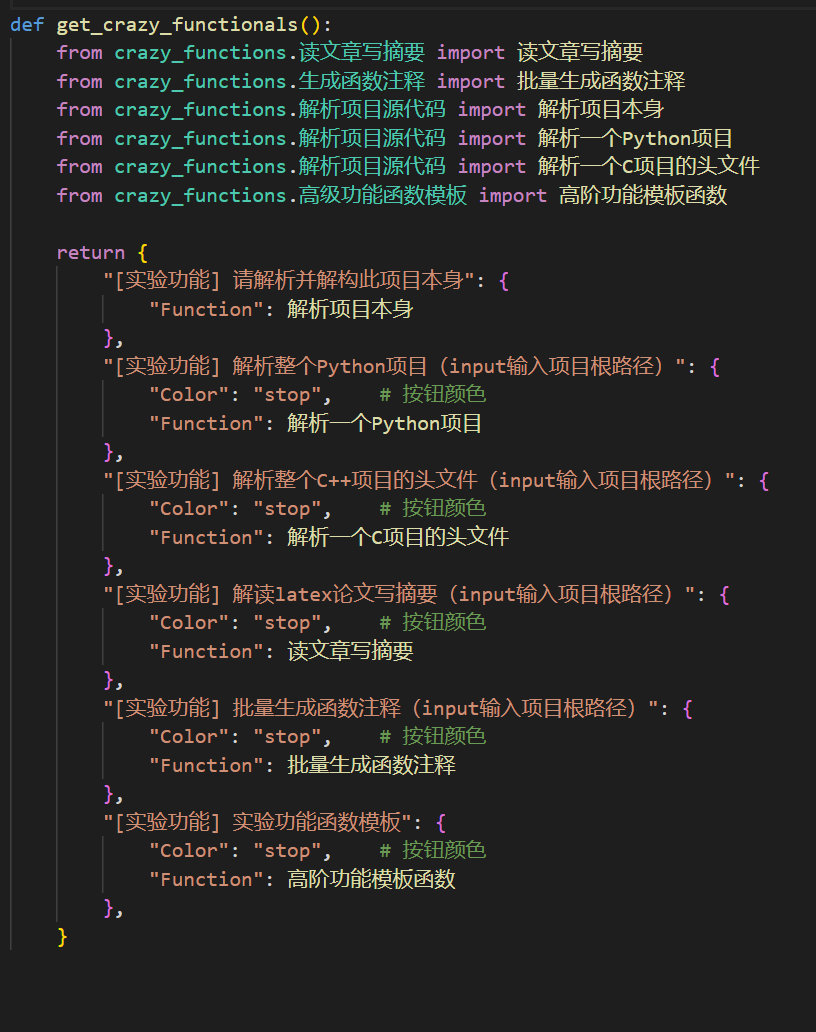

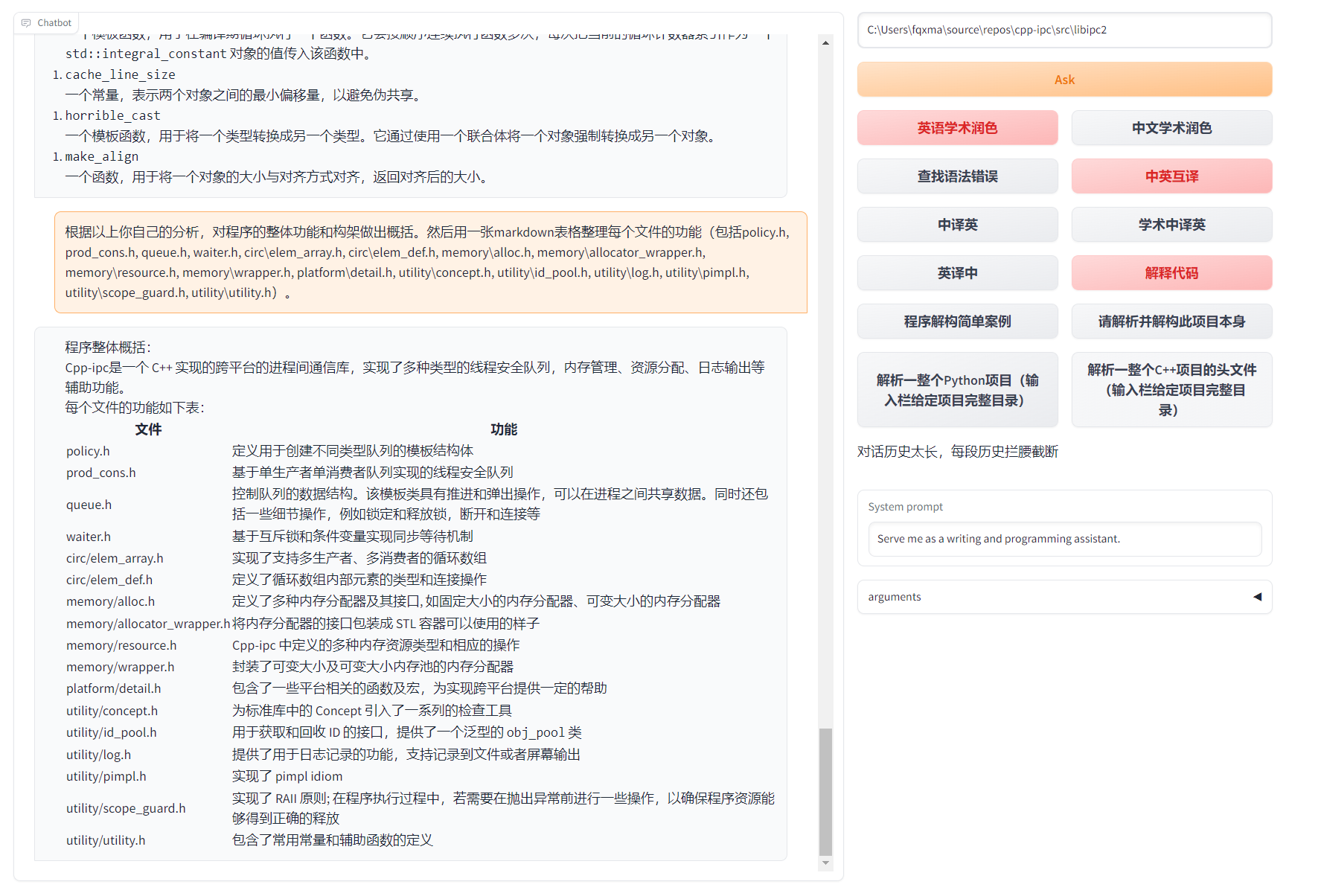

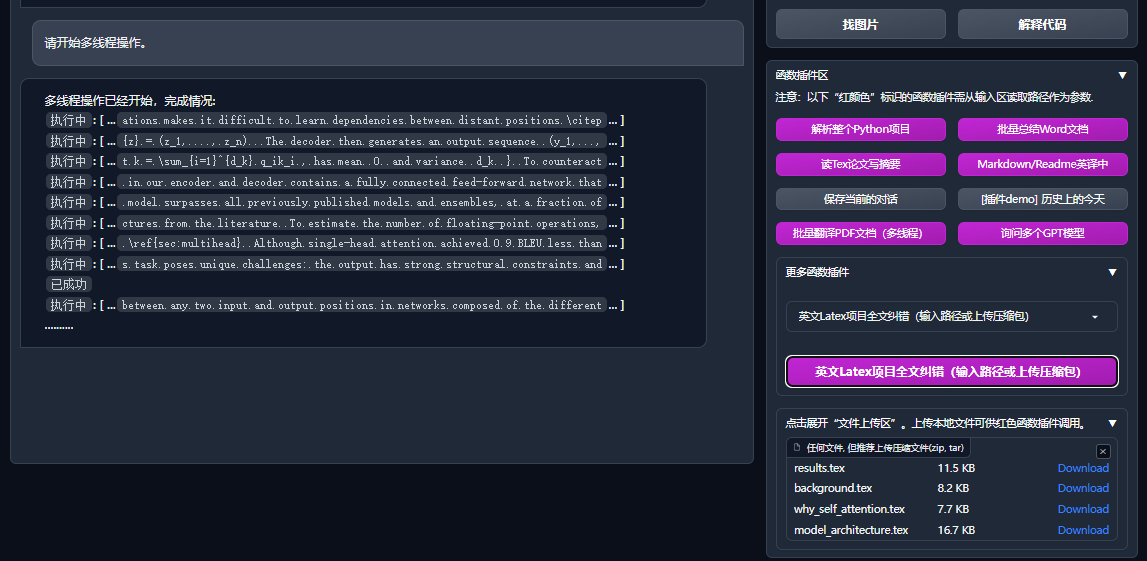

| การวิเคราะห์โปรแกรม | [plug -in] การวิเคราะห์หนึ่งครั้งของ Python/C/C ++/Java/Lua/... Project Tree หรือ Self -analysis |

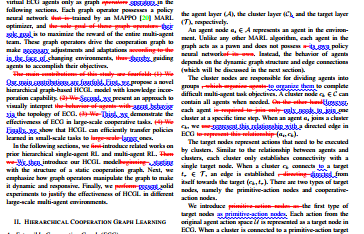

| อ่านกระดาษแปลวิทยานิพนธ์ | [plug -in] การตีความหนึ่ง -click ของกระดาษ latex/pdf ข้อความเต็มและสร้างบทคัดย่อ |

| การแปลแบบเต็มยาง -ข้อความความชุ่มชื้น | [plug -in] หนึ่ง -click translation หรือกระดาษยางที่ให้ความชุ่มชื้น |

| คำอธิบายประกอบชุด | [plug -in] หนึ่ง -click batch สร้างฟังก์ชันคำอธิบายประกอบ |

| การแปลร่วมกันของ Markdown และ British | [plug -in] คุณเห็นภาษาอ่าน 5 หรือไม่? มันมาจากลายมือของเขา |

| PDF Paper ฟังก์ชั่นการแปลข้อความแบบเต็ม | [plug -in] PDF Paper Extract คำถาม & บทสรุป+การแปลข้อความเต็ม (มัลติเธรด) |

| ผู้ช่วยอาร์กซ์ | [plug -in] ป้อน url บทความ arxiv เป็นหนึ่ง -click บทสรุปการแปล+ดาวน์โหลด pdf |

| เอกสารน้ำยางหนึ่งคู่โรงเรียนคลิกคู่หนึ่ง | [plug -in] การเลียนแบบไวยากรณ์ไปยังไวยากรณ์, การแก้ไขการสะกดคำ+การควบคุมเอาต์พุต PDF บนบทความลาเท็กซ์ |

| Google Assistant การรวมกลุ่มวิชาการ | [plug -in] ได้รับ URL ของหน้าการค้นหาทางวิชาการของ Ren Italy ให้ GPT ช่วยคุณเขียนที่เกี่ยวข้อง |

| การรวมข้อมูลอินเทอร์เน็ต+GPT | [plug -in] หนึ่ง -click เพื่อให้ GPT รับข้อมูลจากอินเทอร์เน็ตและตอบคำถามเพื่อให้ข้อมูลจะไม่ล้าสมัย |

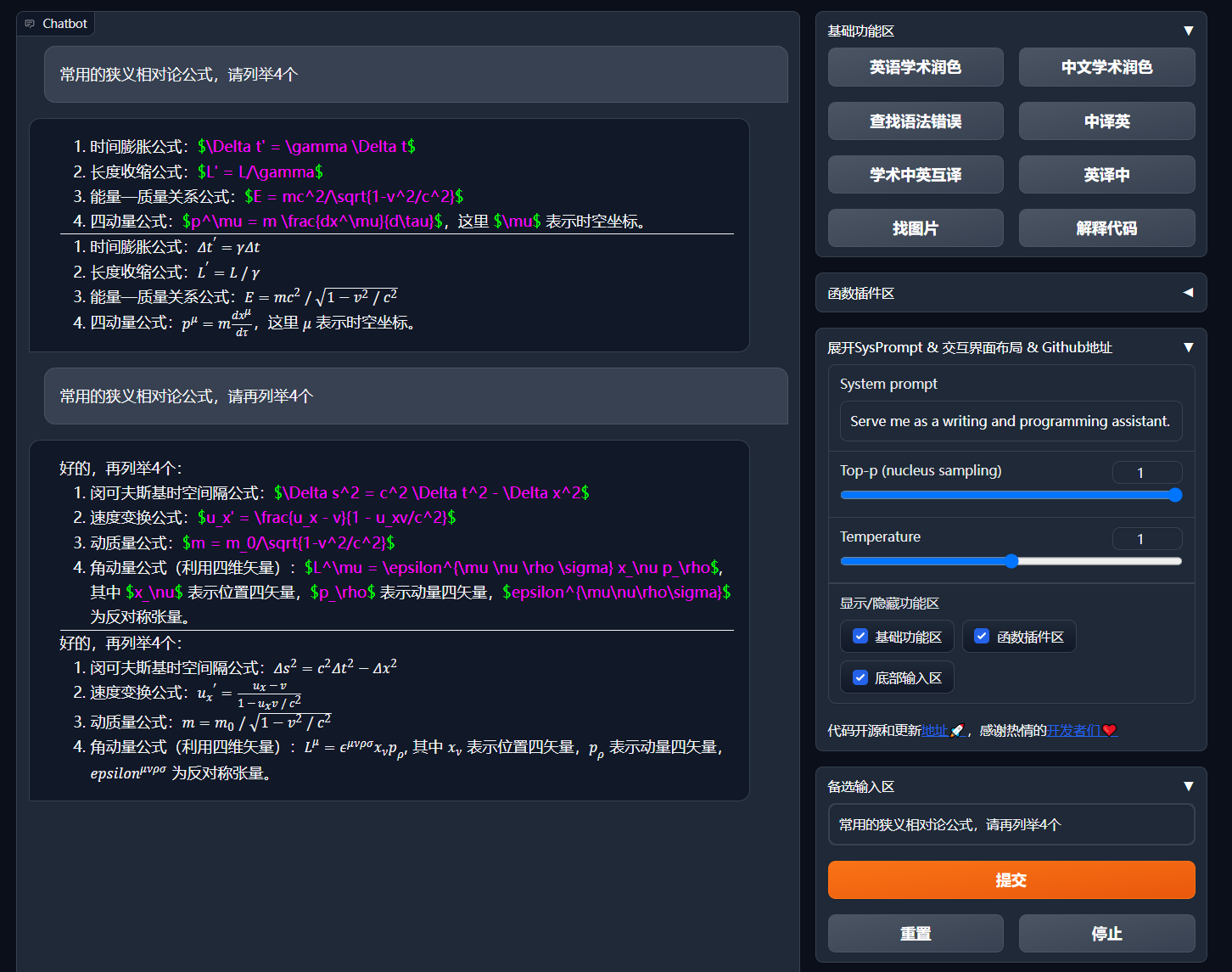

| การแสดงสูตร/รูปภาพ/ฟอร์ม | คุณสามารถแสดงสูตรและรูปแบบการแสดงผลของสูตรในเวลาเดียวกันและรองรับสูตรและไฮไลต์รหัส |

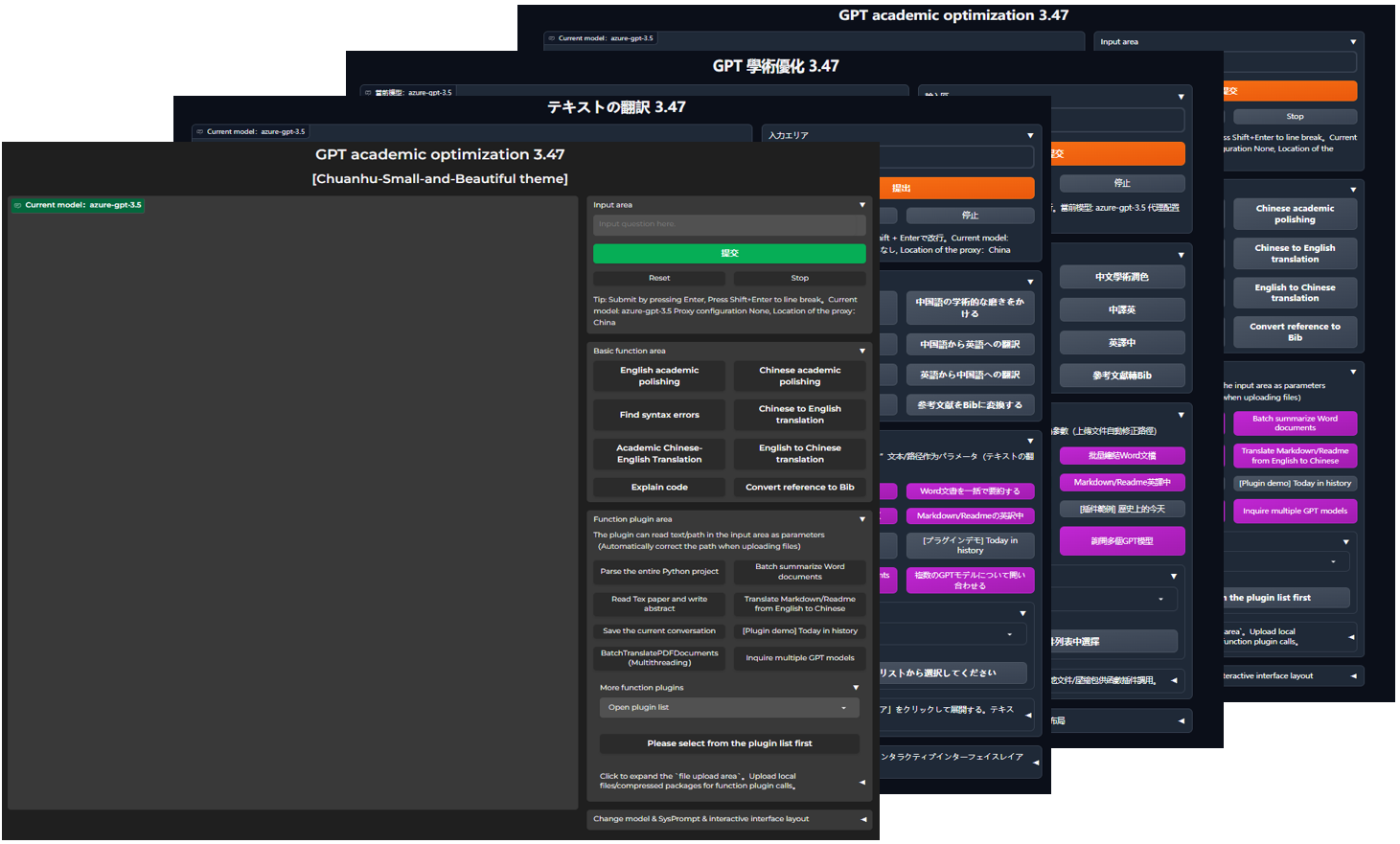

| เริ่มธีมมืด | เพิ่ม /?__theme=dark หลังจาก URL เบราว์เซอร์สามารถสลับธีมมืดได้ |

| การรองรับรุ่น Multi LLM | ในเวลาเดียวกันความรู้สึกของการรับใช้โดย GPT3.5, GPT4, Tsinghua Chatglm2, Fudan Moss ต้องดีมาก? |

| การเข้าถึงแบบจำลอง LLM เพิ่มเติมรองรับการปรับใช้ HuggingFace | เข้าร่วมอินเตอร์เฟส newbing (ใหม่ต้อง) แนะนำ tsinghua jittorllms เพื่อสนับสนุน llama และ pangu α |

| แพ็คเกจ PIP เป็นโมฆะ-เทอร์มินัล | ออกจาก GUI โทรหาปลั๊กฟังก์ชั่นทั้งหมดโดยตรงของรายการใน Python (กำลังพัฒนา) |

| การแสดงคุณสมบัติใหม่เพิ่มเติม (การสร้างภาพ ฯลฯ ) ... | ดูจุดสิ้นสุดของบทความนี้ ... |

config.py เพื่อให้ได้การสลับ "เลย์เอาต์ซ้าย -ไรท์" และ "เลย์เอาต์ด้านบนและล่าง")

ผังงาน TD

A {"วิธีการติดตั้ง"} -> w1 ("i.? เรียกใช้โดยตรง (windows, linux หรือ macOS)"

W1-> W11 ["1. Python PIP Management Management Independence"]

W1-> W12 ["2. Anaconda Package Management Dependencies (คำแนะนำ)"]]]]]

A -> W2 ["ii.? ใช้ Docker (Windows, Linux หรือ MacOS)"

w2-> k1 ["1. ภาพกระจกขนาดใหญ่ปรับใช้ความสามารถทั้งหมด (คำแนะนำ)"]]]

W2-> K2 ["2. เฉพาะรุ่นออนไลน์ (GPT, GLM4, ฯลฯ ) Mirror"]

w2-> k3 ["3. รุ่นออนไลน์+ กระจกขนาดใหญ่ของ LaTex"]]

a -> w4 ["iv. วิธีการปรับใช้อื่น ๆ "]]]

W4-> C1 ["1. Windows/MacOS One -Click การติดตั้งและเรียกใช้สคริปต์ (คำแนะนำ)"

w4-> c2 ["2. Huggingface, การปรับใช้ระยะไกลของ sealos"]]]

w4-> c4 ["3. ... อื่น ๆ ... "]]

ดาวน์โหลดโครงการ

git clone --depth=1 https://github.com/binary-husky/gpt_academic.git

cd gpt_academicกำหนดค่า api_key และตัวแปรอื่น ๆ

ใน config.py กำหนดค่าตัวแปรเช่นคีย์ API วิธีการตั้งค่าสภาพแวดล้อมเครือข่ายพิเศษคำอธิบายการกำหนดค่า Wiki-Project

"โปรแกรมจะให้ความสำคัญกับการตรวจสอบว่ามีไฟล์การกำหนดค่าส่วนตัวที่เรียกว่า config_private.py และกำหนดค่าชื่อเดียวกันด้วยการกำหนดค่าของ config.py หากคุณสามารถเข้าใจตรรกะการอ่านด้านบนเราขอแนะนำให้คุณสร้างภายใต้ config_private.py ธ config.py config_private.py

"สนับสนุนรายการการกำหนดค่า环境变量โปรดดูไฟล์ docker-compose.yml หรือหน้า wiki ของเราของรูปแบบการเขียนของตัวแปรสภาพแวดล้อมลำดับความสำคัญการอ่านการกำหนดค่า:环境变量> config_private.py > config.py "

การพึ่งพาการติดตั้ง

# (选择I: 如熟悉python, python推荐版本 3.9 ~ 3.11)备注:使用官方pip源或者阿里pip源, 临时换源方法:python -m pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/

python -m pip install -r requirements.txt

# (选择II: 使用Anaconda)步骤也是类似的 (https://www.bilibili.com/video/BV1rc411W7Dr):

conda create -n gptac_venv python=3.11 # 创建anaconda环境

conda activate gptac_venv # 激活anaconda环境

python -m pip install -r requirements.txt # 这个步骤和pip安装一样的步骤[ขั้นตอนเสริม] หากคุณต้องการสนับสนุน Tsinghua Chatglm3/Fudan Moss เป็นส่วนหลังคุณต้องติดตั้งการพึ่งพามากขึ้น (สิ่งที่จำเป็นต้องมี: คุ้นเคยกับ Python + Pytorch + การกำหนดค่าคอมพิวเตอร์):

# 【可选步骤I】支持清华ChatGLM3。清华ChatGLM备注:如果遇到"Call ChatGLM fail 不能正常加载ChatGLM的参数" 错误,参考如下: 1:以上默认安装的为torch+cpu版,使用cuda需要卸载torch重新安装torch+cuda; 2:如因本机配置不够无法加载模型,可以修改request_llm/bridge_chatglm.py中的模型精度, 将 AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True) 都修改为 AutoTokenizer.from_pretrained("THUDM/chatglm-6b-int4", trust_remote_code=True)

python -m pip install -r request_llms/requirements_chatglm.txt

# 【可选步骤II】支持复旦MOSS

python -m pip install -r request_llms/requirements_moss.txt

git clone --depth=1 https://github.com/OpenLMLab/MOSS.git request_llms/moss # 注意执行此行代码时,必须处于项目根路径

# 【可选步骤III】支持RWKV Runner

参考wiki:https://github.com/binary-husky/gpt_academic/wiki/%E9%80%82%E9%85%8DRWKV-Runner

# 【可选步骤IV】确保config.py配置文件的AVAIL_LLM_MODELS包含了期望的模型,目前支持的全部模型如下(jittorllms系列目前仅支持docker方案):

AVAIL_LLM_MODELS = [ " gpt-3.5-turbo " , " api2d-gpt-3.5-turbo " , " gpt-4 " , " api2d-gpt-4 " , " chatglm " , " moss " ] # + ["jittorllms_rwkv", "jittorllms_pangualpha", "jittorllms_llama"]

# 【可选步骤V】支持本地模型INT8,INT4量化(这里所指的模型本身不是量化版本,目前deepseek-coder支持,后面测试后会加入更多模型量化选择)

pip install bitsandbyte

# windows用户安装bitsandbytes需要使用下面bitsandbytes-windows-webui

python -m pip install bitsandbytes --prefer-binary --extra-index-url=https://jllllll.github.io/bitsandbytes-windows-webui

pip install -U git+https://github.com/huggingface/transformers.git

pip install -U git+https://github.com/huggingface/accelerate.git

pip install peftpython main.py ความสามารถทั้งหมดของการปรับใช้โครงการ (นี่คือกระจกขนาดใหญ่ที่มี CUDA และ LATEX แต่ถ้าคุณมีความเร็วเครือข่ายที่ช้าและฮาร์ดดิสก์ขนาดเล็กวิธีนี้ไม่แนะนำให้ปรับใช้รายการที่สมบูรณ์)

# 修改docker-compose.yml,保留方案0并删除其他方案。然后运行:

docker-compose up เฉพาะ chatgpt + glm4 + wenxin กล่าว + Spark และรุ่นออนไลน์อื่น ๆ (แนะนำโดยคนส่วนใหญ่)

# 修改docker-compose.yml,保留方案1并删除其他方案。然后运行:

docker-compose upหาก PS ต้องการพึ่งพาฟังก์ชั่น LaTex Plug -in ให้ดูที่ Wiki นอกจากนี้คุณยังสามารถใช้ Scheme 4 หรือ Scheme 0 โดยตรงเพื่อรับฟังก์ชั่น LaTex

chatgpt + glm3 + moss + llama2 + tongyi qianwen (จำเป็นต้องคุ้นเคยกับ Nvidia Docker เมื่อทำงาน)

# 修改docker-compose.yml,保留方案2并删除其他方案。然后运行:

docker-compose upWindows One -Click Runtime Script ผู้ใช้ Windows ที่ไม่คุ้นเคยอย่างสมบูรณ์กับสภาพแวดล้อม Python สามารถดาวน์โหลดสคริปต์ที่ใช้งานได้หนึ่งครั้งที่เผยแพร่ในรีลีสเพื่อติดตั้งเวอร์ชันที่ไม่มีรุ่นท้องถิ่น แหล่งที่มาของการมีส่วนร่วมของสคริปต์: Oobabooga

ใช้ API ที่สาม -Party, Azure ฯลฯ , Wen Xinyi, Star Fire, ฯลฯ ดูหน้า Wiki

เซิร์ฟเวอร์คลาวด์ปรับใช้แนวทางในการหลีกเลี่ยงหลุมจากระยะไกล กรุณาเยี่ยมชม wiki การปรับใช้ระยะไกลของเซิร์ฟเวอร์เซิร์ฟเวอร์

ปรับใช้บนแพลตฟอร์มอื่น ๆ และการปรับใช้ URL รอง

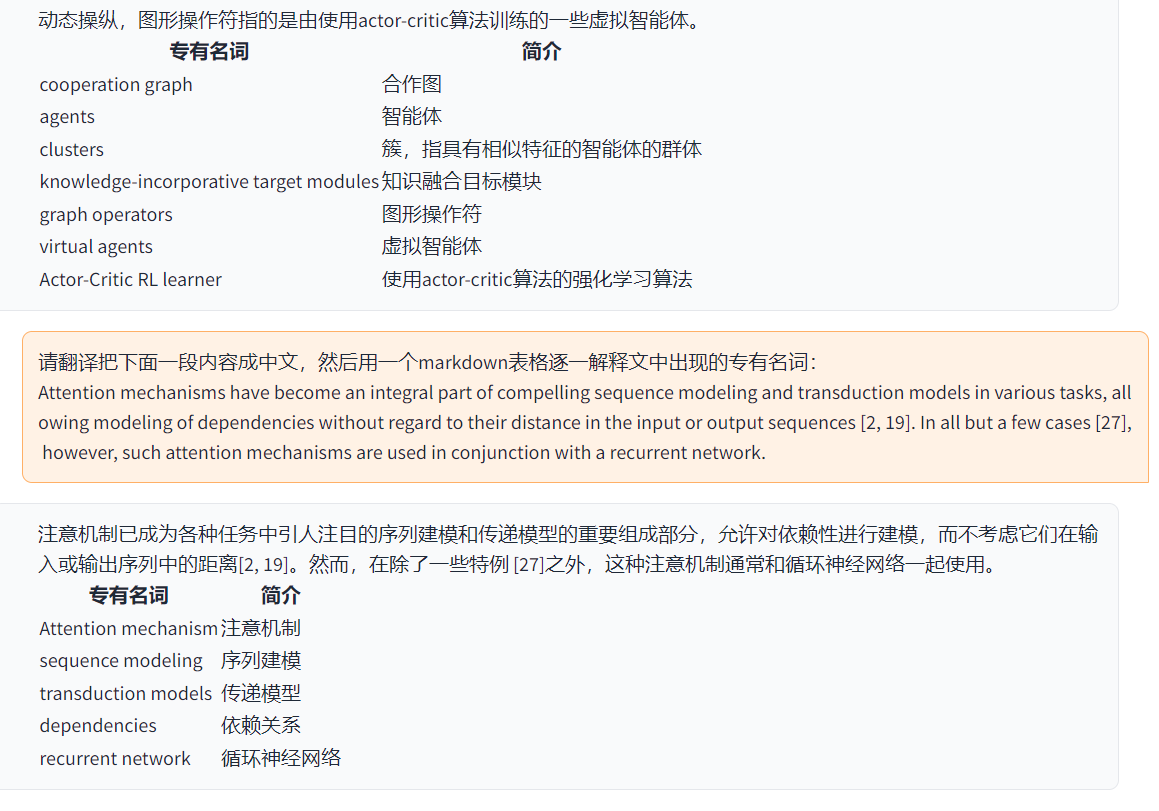

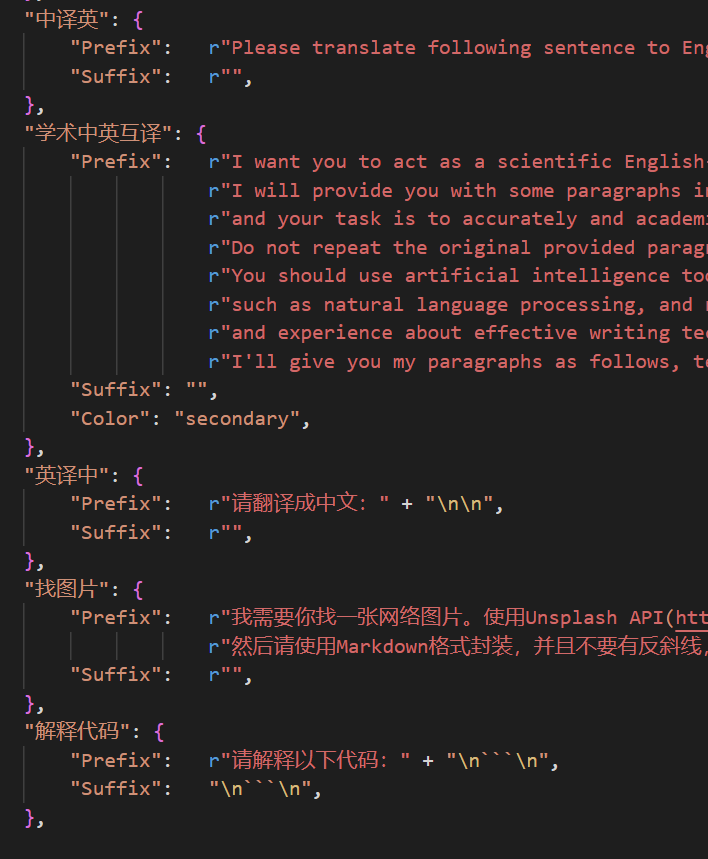

http://localhost/subpath ) กรุณาเยี่ยมชมคำแนะนำการดำเนินงาน fastapi ตอนนี้คุณสามารถเพิ่มปุ่มที่สะดวกใหม่ใน自定义菜单ในเมนู界面外观ใน UI หากคุณต้องการกำหนดในรหัสให้ใช้ตัวแก้ไขข้อความใด ๆ เพื่อเปิด core_functional.py เพิ่มรายการต่อไปนี้:

"超级英译中" : {

# 前缀,会被加在你的输入之前。例如,用来描述你的要求,例如翻译、解释代码、润色等等

"Prefix" : "请翻译把下面一段内容成中文,然后用一个markdown表格逐一解释文中出现的专有名词: n n " ,

# 后缀,会被加在你的输入之后。例如,配合前缀可以把你的输入内容用引号圈起来。

"Suffix" : "" ,

},

เขียนปลั๊กฟังก์ชั่นที่ทรงพลังในการทำงานใด ๆ ที่คุณต้องการและไม่คาดคิด ปลั๊กและการดีบักของโครงการนี้อยู่ในระดับต่ำมาก สำหรับรายละเอียดโปรดดูที่คู่มือปลั๊กฟังก์ชัน

保存当前的对话ในพื้นที่ปลั๊กฟังก์ชั่นเพื่อบันทึกบทสนทนาปัจจุบันเป็นไฟล์载入对话历史存档ที่สามารถกู้คืนได้载入对话历史存档เพื่อกู้คืนเซสชันก่อนหน้า เคล็ดลับ: หากคุณไม่ได้ระบุไฟล์ให้คลิก载入对话历史存档เพื่อดูแคช HTML เก็บถาวรทางประวัติศาสตร์

-

-

config.py )

-

-

GPT Academic Developer กลุ่ม QQ: 610599535

requirement.txt เพื่อติดตั้ง gradio ไทม์ไลน์ LR

ชื่อกระบวนการพัฒนาโครงการ GPT-Academic ส่วน 2.x

1.0 ~ 2.2: ฟังก์ชั่นพื้นฐาน: แนะนำฟังก์ชั่นฟังก์ชั่นแบบแยกส่วน: เค้าโครงแบบพับเก็บได้: ปลั๊กฟังก์ชั่น -รองรับโหลดความร้อน 2.3 ~ 2.5: ปรับปรุงการโต้ตอบแบบหลายเธรด: ฟังก์ชั่นการแปลแบบเต็มรูปแบบ PDF ใหม่ 2.6: การสร้างโครงสร้างปลั๊กใหม่: ปรับปรุงการโต้ตอบ: เพิ่มปลั๊กเพิ่มเติมในส่วน 3.x

3.0 ~ 3.1: รองรับ Chatglm: รองรับ LLM ขนาดเล็กอื่น ๆ : รองรับรุ่น GPT หลายรุ่นในเวลาเดียวกัน: รองรับ Apikey Load Balancing หลายครั้ง 3.2 ~ 3.3: ฟังก์ชั่นปลั๊กฟังก์ชั่นรองรับอินเตอร์เฟสพารามิเตอร์เพิ่มเติม: บันทึกฟังก์ชั่นการสนทนา: ตีความรหัสภาษาใด ๆ : ในเวลาเดียวกันถามชุด LLM ใด ๆ : ข้อมูลที่ครอบคลุมข้อมูลอินเทอร์เน็ต 3.4: เข้าร่วมการแปลวิทยานิพนธ์ Arxiv: เพิ่มฟังก์ชั่นการแก้ไขวิทยานิพนธ์ LaTex 3.44: สนับสนุน Azure อย่างเป็นทางการ: อินเตอร์เฟสที่ดีที่สุดใช้งานง่าย 3.46: แบบจำลองตัวกรอง Chatglm2 แบบกำหนดเอง: บทสนทนาเสียงจริง 3.49: สนับสนุน Alida Mo Yuan Tongyi Qian Qian: Shanghai Ai-Lab Scholar: Xun Fei Xinghuo: สนับสนุนแพลตฟอร์ม Baidu Qianfan & Wenxin A คำ 3.50: เทอร์มินัลโมฆะ: การจัดหมวดหมู่ปลั๊กอิน: ปรับปรุง UI: ออกแบบหัวข้อใหม่ 3.53: แบบไดนามิก : การปรับปรุงเสถียรภาพ: แก้ปัญหาของความขัดแย้งหลายผู้ใช้ 3.55: ล่ามโค้ดไดนามิก: การสร้างส่วนต่อประสานด้านหน้า -สิ้นสุด: การแนะนำหน้าต่างและแถบเมนูที่ถูกระงับ 3.56: ปุ่มฟังก์ชั่นพื้นฐานเพิ่มเติมแบบไดนามิก: รายงานใหม่ PDF สรุปหน้า 3.57: GLM3 Star Fire V3: รองรับ Wenxinyi Sight V4: แก้ไขข้อบกพร่องที่เกิดขึ้นพร้อมกันของโมเดลท้องถิ่น

3.60: บทนำสู่ Autogen

3.70: แนะนำภาพวาดนางเงือก: ฟังก์ชั่นการใช้งานเช่น GPT Brain Drawing 3.80 (TODO): Plug Autogen ที่ได้รับการปรับให้เหมาะสม คุณสามารถเปลี่ยนธีมได้โดยการแก้ไข THEME

Chuanhu-Small-and-Beautifulmaster : สาขาหลักเวอร์ชันเสถียรfrontier : สาขาการพัฒนาเวอร์ชันทดสอบ代码中参考了很多其他优秀项目中的设计,顺序不分先后:

# 清华ChatGLM2-6B:

https://github.com/THUDM/ChatGLM2-6B

# 清华JittorLLMs:

https://github.com/Jittor/JittorLLMs

# ChatPaper:

https://github.com/kaixindelele/ChatPaper

# Edge-GPT:

https://github.com/acheong08/EdgeGPT

# ChuanhuChatGPT:

https://github.com/GaiZhenbiao/ChuanhuChatGPT

# Oobabooga one-click installer:

https://github.com/oobabooga/one-click-installers

# More:

https://github.com/gradio-app/gradio

https://github.com/fghrsh/live2d_demo