บรรณาธิการของ Downcodes ได้เรียนรู้ว่าทีมงาน Tongyi Qianwen เพิ่งเปิดซอร์สโมเดล Qwen2.5-Coder เต็มรูปแบบล่าสุด ซึ่งถือเป็นอีกก้าวสำคัญในด้านโมเดลโอเพ่นซอร์สขนาดใหญ่ รุ่นซีรีส์ Qwen2.5-Coder ได้รับความสนใจอย่างมากเนื่องจากความสามารถในการเขียนโค้ดอันทรงพลัง ฟังก์ชันที่หลากหลาย และการใช้งานที่สะดวกสบาย โดยได้แสดงให้เห็นถึงประสิทธิภาพที่ยอดเยี่ยมในการสร้าง การซ่อมแซม และการใช้เหตุผล ทำให้นักพัฒนามีเครื่องมืออันทรงพลังที่ช่วยส่งเสริมการพัฒนา Open Code ต่อไป LLM โอเพ่นซอร์สของโมเดลซีรีส์นี้จะส่งเสริมการประยุกต์ใช้และนวัตกรรมของเทคโนโลยีปัญญาประดิษฐ์ในด้านการเขียนโปรแกรมอย่างมาก

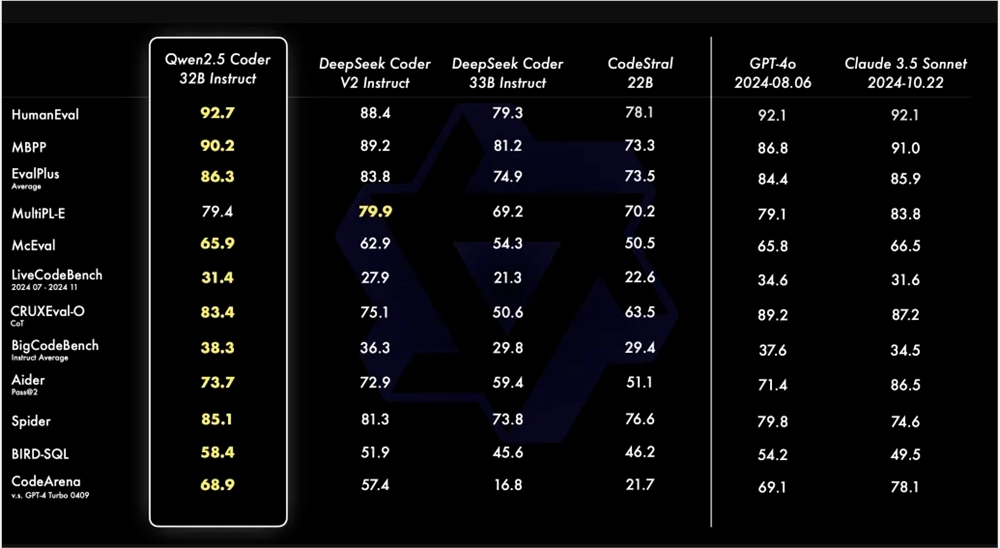

เมื่อเร็วๆ นี้ ทีมงาน Tongyi Qianwen ประกาศว่าจะเปิดซอร์สซีรีส์ Qwen2.5-Coder ล่าสุด โดยมีเป้าหมายเพื่อส่งเสริมการพัฒนา Open Code LLM Qwen2.5-Coder ดึงดูดความสนใจด้วยพลัง ความหลากหลาย และการใช้งานจริง โมเดล Qwen2.5-Coder-32B-Instruct ได้ถึงระดับ SOTA ในแง่ของความสามารถของโค้ด ซึ่งเทียบเท่ากับ GPT-4o ซึ่งแสดงความสามารถที่ครอบคลุม รวมถึงการสร้างโค้ด การซ่อมแซมโค้ด และการใช้เหตุผลของโค้ด มีประสิทธิภาพสูงสุดในเกณฑ์มาตรฐานการสร้างโค้ดหลายรายการ และได้คะแนน 73.7 ในเกณฑ์มาตรฐาน Aider ซึ่งเทียบได้กับ GPT-4o

Qwen2.5-Coder รองรับภาษาการเขียนโปรแกรมมากกว่า 40 ภาษา และได้คะแนน 65.9 คะแนนใน McEval โดยภาษาอย่าง Haskell และ Racket ทำงานได้ดีเป็นพิเศษ นี่เป็นเพราะการล้างข้อมูลและการจับคู่ข้อมูลที่เป็นเอกลักษณ์ในขั้นตอนก่อนการฝึกอบรม นอกจากนี้ Qwen2.5-Coder-32B-Instruct ยังทำงานได้ดีในด้านความสามารถในการซ่อมแซมโค้ดในภาษาการเขียนโปรแกรมหลายภาษา โดยได้คะแนน 75.2 ในเกณฑ์มาตรฐาน MdEval ซึ่งอยู่ในอันดับหนึ่ง

เพื่อทดสอบประสิทธิภาพการจัดตำแหน่งของ Qwen2.5-Coder-32B-Instruct เกี่ยวกับการกำหนดลักษณะของมนุษย์ จึงได้สร้างเกณฑ์มาตรฐานการประเมินการกำหนดลักษณะโค้ดที่มีคำอธิบายประกอบภายใน Code Arena ขึ้น ผลการวิจัยพบว่า Qwen2.5-Coder-32B-Instruct มีข้อดีในการจัดตำแหน่งที่ต้องการ

ซีรีส์ Qwen2.5-Coder มีโมเดลโอเพ่นซอร์สในสี่ขนาดในครั้งนี้ รวมถึง 0.5B/3B/14B/32B ซึ่งครอบคลุมโมเดลกระแสหลักหกขนาด เพื่อตอบสนองความต้องการของนักพัฒนาที่แตกต่างกัน อย่างเป็นทางการมีสองรุ่น: ฐานและคำสั่ง แบบแรกทำหน้าที่เป็นพื้นฐานสำหรับนักพัฒนาในการปรับแต่งโมเดล และแบบหลังทำหน้าที่เป็นโมเดลการแชทที่สอดคล้องอย่างเป็นทางการ มีความสัมพันธ์เชิงบวกระหว่างขนาดโมเดลและประสิทธิภาพ และ Qwen2.5-Coder บรรลุประสิทธิภาพ SOTA ในทุกขนาด

Qwen2.5-Coder รุ่น 0.5B/1.5B/7B/14B/32B ใช้ลิขสิทธิ์ Apache2.0 ในขณะที่รุ่น 3B เป็นลิขสิทธิ์เฉพาะสำหรับการวิจัยเท่านั้น ทีมงานตรวจสอบประสิทธิภาพของ Scaling บน Code LLM โดยประเมินประสิทธิภาพของ Qwen2.5-Coder ในขนาดต่างๆ ในชุดข้อมูลทั้งหมด

โอเพ่นซอร์สของ Qwen2.5-Coder ช่วยให้นักพัฒนามีตัวเลือกโมเดลการเขียนโปรแกรมที่ทรงพลัง หลากหลาย และใช้งานได้จริง ซึ่งช่วยส่งเสริมการพัฒนาและการประยุกต์ใช้โมเดลภาษาการเขียนโปรแกรม

ลิงค์รุ่น Qwen2.5-Coder:

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

กล่าวโดยสรุป โอเพ่นซอร์สของ Qwen2.5-Coder นำเครื่องมืออันทรงพลังมาสู่นักพัฒนา และประสิทธิภาพที่ยอดเยี่ยมและการนำไปใช้งานในวงกว้างของมันจะส่งเสริมการพัฒนาในด้านการสร้างโค้ดและการเขียนโปรแกรมอย่างมาก เราหวังว่า Qwen2.5-Coder จะสามารถมีบทบาทในสถานการณ์การใช้งานเพิ่มเติมได้ในอนาคต