การศึกษาใหม่ของ MIT ได้เปิดเผยความคล้ายคลึงกันอย่างเห็นได้ชัดระหว่างโครงสร้างภายในของโมเดลภาษาขนาดใหญ่ (LLM) และสมองของมนุษย์ ซึ่งจุดประกายให้เกิดการถกเถียงอย่างดุเดือดในสาขาปัญญาประดิษฐ์ บรรณาธิการของ Downcodes จะอธิบายรายละเอียดเกี่ยวกับการค้นพบครั้งยิ่งใหญ่ของงานวิจัยนี้ และความสำคัญของงานวิจัยนี้ต่อการพัฒนา AI ในอนาคต ด้วยการวิเคราะห์เชิงลึกของพื้นที่การเปิดใช้งาน LLM นักวิจัยได้ค้นพบคุณสมบัติโครงสร้างสามระดับ การค้นพบคุณสมบัติเหล่านี้จะช่วยให้เราเข้าใจกลไกการทำงานของ LLM ได้ดีขึ้น และมอบแนวทางใหม่สำหรับการพัฒนาเทคโนโลยี AI ในอนาคต

AI เริ่ม "ปลูกสมอง" ได้แล้วจริงเหรอ?! ผลวิจัยล่าสุดจาก MIT เผยโครงสร้างภายในของโมเดลภาษาขนาดใหญ่ (LLM) คล้ายกับสมองมนุษย์อย่างน่าประหลาดใจ!

การศึกษานี้ใช้เทคโนโลยีการเข้ารหัสอัตโนมัติแบบเบาบางเพื่อทำการวิเคราะห์เชิงลึกของพื้นที่การเปิดใช้งานของ LLM และค้นพบคุณลักษณะทางโครงสร้างสามระดับที่น่าทึ่ง:

ประการแรก ในระดับจุลทรรศน์ นักวิจัยได้ค้นพบการมีอยู่ของโครงสร้างคล้าย "ผลึก" ใบหน้าของ "คริสตัล" เหล่านี้ประกอบด้วยสี่เหลี่ยมด้านขนานหรือสี่เหลี่ยมคางหมู คล้ายกับคำเปรียบเทียบที่คุ้นเคย เช่น "ชาย:หญิง::กษัตริย์:ราชินี"

สิ่งที่น่าแปลกใจยิ่งกว่านั้นคือโครงสร้าง "ผลึก" เหล่านี้ชัดเจนขึ้นหลังจากกำจัดปัจจัยรบกวนที่ไม่เกี่ยวข้องบางอย่าง (เช่น ความยาวของคำ) ออก โดยใช้เทคนิคการวิเคราะห์จำแนกเชิงเส้น

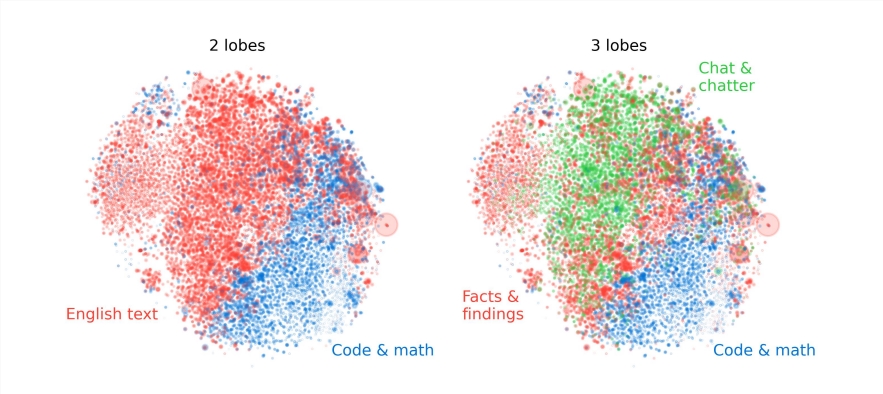

ประการที่สอง ในระดับเมโส นักวิจัยพบว่าพื้นที่กระตุ้นของ LLM มีโครงสร้างแบบโมดูลาร์คล้ายกับการแบ่งหน้าที่การทำงานของสมองมนุษย์

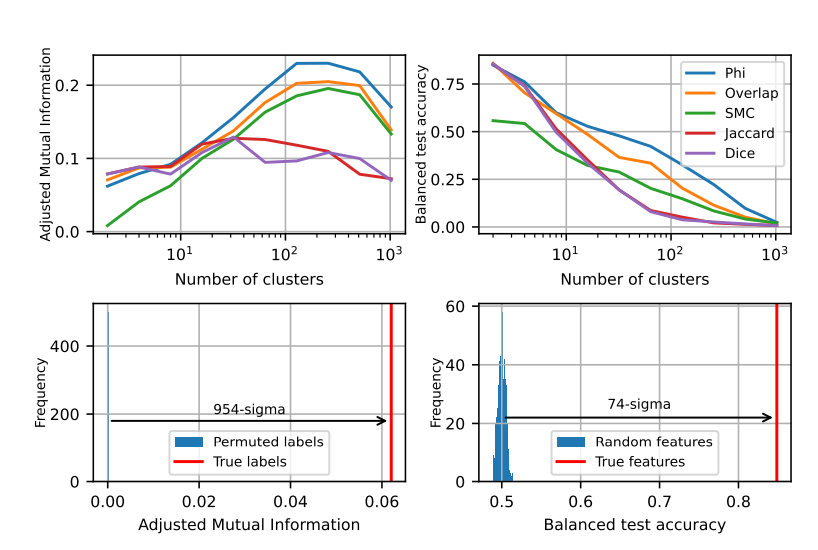

ตัวอย่างเช่น การรวมกลุ่มคุณสมบัติที่เกี่ยวข้องกับคณิตศาสตร์และการเข้ารหัสเข้าด้วยกันจนเกิดเป็น "กลีบ" คล้ายกับกลีบการทำงานของสมองมนุษย์ จากการวิเคราะห์เชิงปริมาณของตัวบ่งชี้หลายตัว นักวิจัยได้ยืนยันตำแหน่งเชิงพื้นที่ของ "กลีบ" เหล่านี้ ซึ่งแสดงให้เห็นว่าลักษณะต่างๆ ที่เกิดขึ้นร่วมกันนั้นยังมีการจัดกลุ่มเชิงพื้นที่มากกว่า ซึ่งเกินกว่าที่คาดไว้จากการกระจายแบบสุ่ม

ในระดับมหภาค นักวิจัยพบว่าโครงสร้างโดยรวมของพอยต์คลาวด์คุณลักษณะ LLM ไม่ใช่ไอโซโทรปิก แต่นำเสนอการกระจายค่าลักษณะเฉพาะของกฎกำลัง และการกระจายนี้ชัดเจนที่สุดในชั้นกลาง

นักวิจัยยังได้วิเคราะห์เชิงปริมาณเอนโทรปีของการจัดกลุ่มในระดับต่างๆ และพบว่าเอนโทรปีของการจัดกลุ่มของชั้นกลางมีค่าต่ำกว่า ซึ่งบ่งชี้ว่าการแสดงคุณลักษณะมีความเข้มข้นมากขึ้น ในขณะที่เอนโทรปีของการจัดกลุ่มของชั้นต้นและชั้นหลังมีสูงกว่า ซึ่งบ่งชี้ว่าคุณลักษณะ การเป็นตัวแทนกระจัดกระจายมากขึ้น

งานวิจัยนี้ให้มุมมองใหม่แก่เราในการทำความเข้าใจกลไกภายในของแบบจำลองภาษาขนาดใหญ่ และยังวางรากฐานสำหรับการพัฒนาระบบ AI ที่ทรงพลังและชาญฉลาดยิ่งขึ้นในอนาคต

ผลการวิจัยนี้น่าตื่นเต้น ไม่เพียงแต่ทำให้เราเข้าใจโมเดลภาษาขนาดใหญ่ได้ลึกซึ้งขึ้นเท่านั้น แต่ยังชี้ให้เห็นทิศทางใหม่สำหรับการพัฒนาปัญญาประดิษฐ์ในอนาคตอีกด้วย บรรณาธิการของ Downcodes เชื่อว่าด้วยความก้าวหน้าทางเทคโนโลยีอย่างต่อเนื่อง ปัญญาประดิษฐ์จะแสดงศักยภาพที่แข็งแกร่งในสาขาต่างๆ มากขึ้น และนำอนาคตที่ดีกว่ามาสู่สังคมมนุษย์