โมเดล AI ล่าสุดของ OpenAI “o1-preview” (ชื่อรหัสเดิมว่า “Strawberry”) ได้จุดประกายให้เกิดการอภิปรายอย่างดุเดือด OpenAI อ้างว่าความสามารถของมันดีพอๆ กับนักศึกษาปริญญาเอก แต่ในการทดสอบจริง กลับแสดงข้อผิดพลาดที่น่าผิดหวัง เครื่องมือแก้ไขของ Downcodes จะพาคุณไปทำความเข้าใจเชิงลึกเกี่ยวกับโมเดล AI ที่หลายคนตั้งตารอแต่มีปัญหานี้ เพื่อดูว่ามันไปถึงระดับไหนแล้วและผลตอบรับจริงจากผู้ใช้

เมื่อเร็วๆ นี้ OpenAI ได้เปิดตัวโมเดล AI ที่หลายคนตั้งตารอ ซึ่งก่อนหน้านี้มีชื่อรหัสว่า "Strawberry" และมีชื่ออย่างเป็นทางการว่า "o1-preview"

OpenAI สัญญาว่าโมเดลใหม่นี้จะทำงานได้ดีพอๆ กับนักศึกษาปริญญาเอกในงานวัดเกณฑ์มาตรฐานที่ยากลำบากในสาขาฟิสิกส์ เคมี และชีววิทยา อย่างไรก็ตาม ผลการทดสอบเบื้องต้นแสดงให้เห็นว่า AI นี้ยังห่างไกลจากเป้าหมายในการแทนที่นักวิทยาศาสตร์หรือโปรแกรมเมอร์ที่เป็นมนุษย์

บนโซเชียลมีเดีย ผู้ใช้จำนวนมากแบ่งปันประสบการณ์ของตนในการโต้ตอบกับ AI “OpenAI o1” และผลลัพธ์แสดงให้เห็นว่าแบบจำลองยังคงทำงานได้ไม่ดีในงานพื้นฐาน

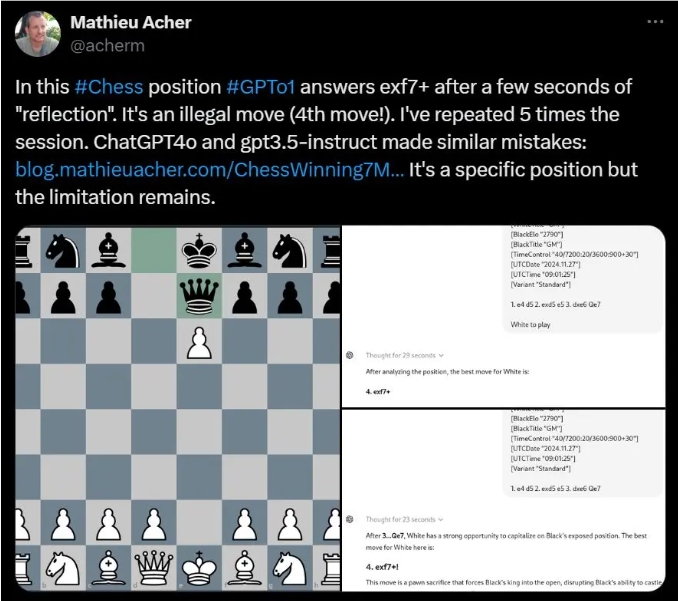

ตัวอย่างเช่น Mathieu Acher นักวิจัยที่ INSA Rennes พบว่า OpenAI o1 มักเสนอการเคลื่อนไหวที่ผิดกฎหมายเมื่อไขปริศนาหมากรุกบางประเภท

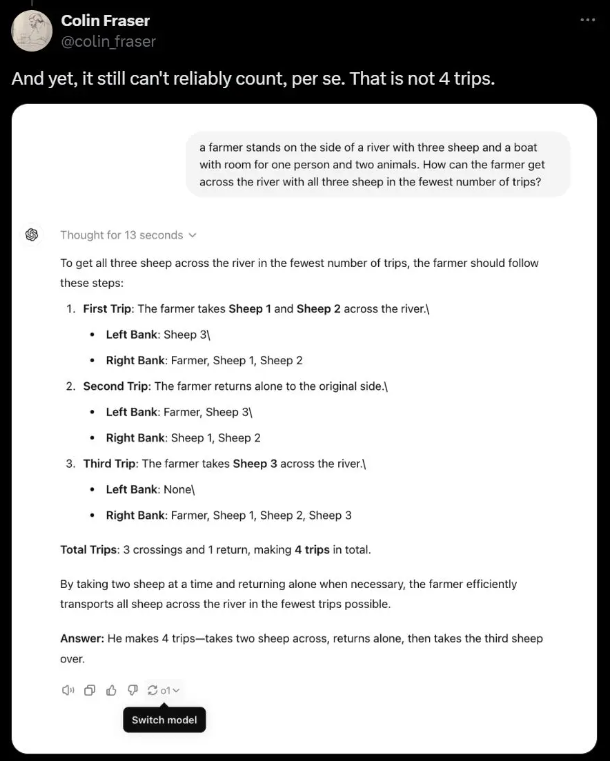

นักวิทยาศาสตร์ Meta AI Colin Fraser ชี้ให้เห็นว่าในปริศนาคำศัพท์ง่ายๆ เกี่ยวกับเกษตรกรที่ขนส่งแกะข้ามแม่น้ำ AI จริง ๆ ละทิ้งคำตอบที่ถูกต้องและกลับให้เรื่องไร้สาระแทน

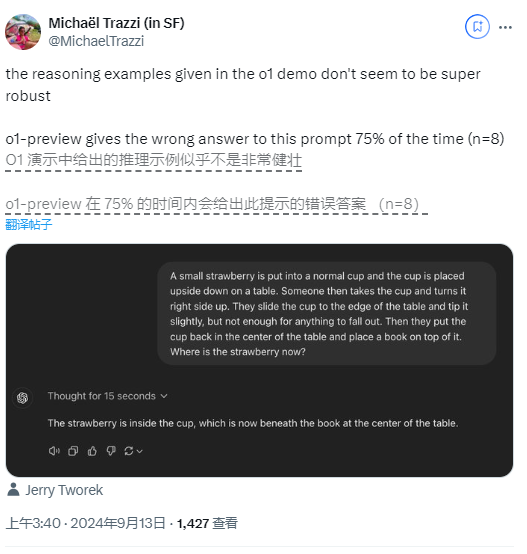

แม้แต่ในเกมไขปริศนาตรรกะที่ OpenAI ใช้ในการสาธิต คำถามเกี่ยวกับสตรอเบอร์รี่ก็ทำให้ผู้ใช้ได้รับคำตอบที่แตกต่างกัน โดยผู้ใช้รายหนึ่งพบว่าแบบจำลองมีอัตราข้อผิดพลาดสูงถึง 75%

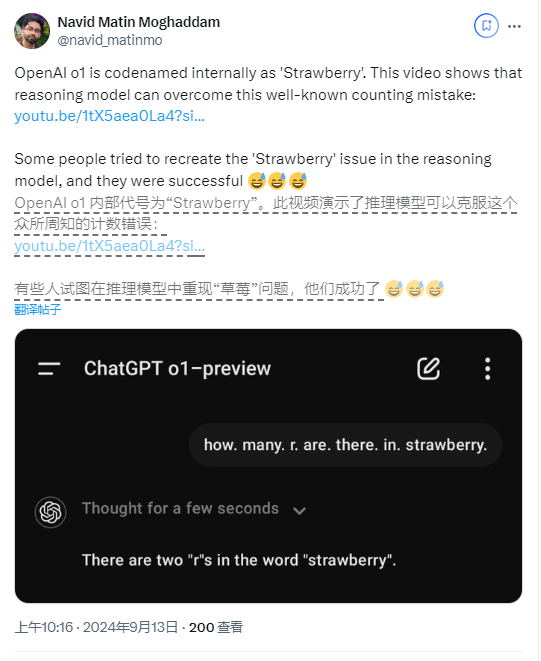

ไม่เพียงเท่านั้น ผู้ใช้บางรายยังรายงานว่ารุ่นใหม่ยังทำผิดพลาดเมื่อนับจำนวนครั้งที่ตัวอักษร "R" ปรากฏในคำว่า "สตรอเบอร์รี่"

แม้ว่า OpenAI จะระบุ ณ เวลาที่วางจำหน่ายว่านี่เป็นรุ่นแรกๆ และยังไม่มีฟีเจอร์ต่างๆ เช่น การท่องเว็บและการอัพโหลดไฟล์ แต่ข้อผิดพลาดพื้นฐานดังกล่าวก็ยังคงน่าประหลาดใจ

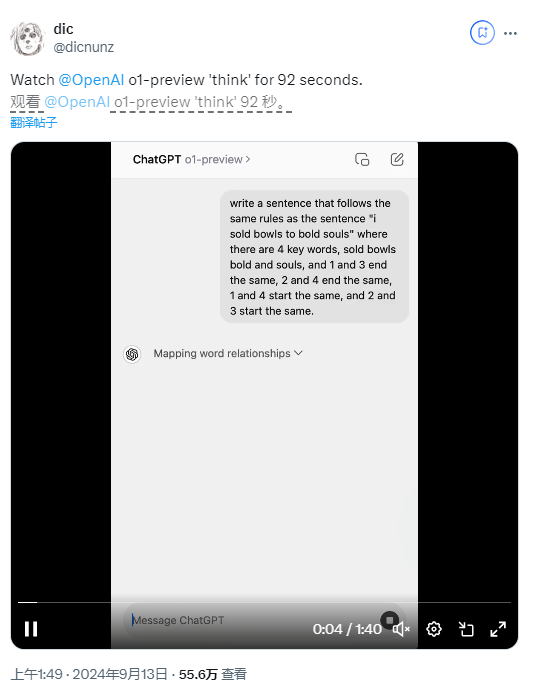

เพื่อปรับปรุง OpenAI ได้แนะนำกระบวนการ "ห่วงโซ่การคิด" ในโมเดลใหม่ ซึ่งทำให้ OpenAI o1 แตกต่างจากรุ่น GPT-4o ก่อนหน้าอย่างมาก วิธีการนี้ช่วยให้ AI คิดซ้ำแล้วซ้ำอีกก่อนที่จะได้คำตอบแม้จะส่งผลให้เวลาตอบสนองนานขึ้นก็ตาม

ผู้ใช้บางคนค้นพบว่าแบบจำลองนี้ใช้เวลา 92 วินาทีในการตอบคำถามปริศนาคำศัพท์ แต่ผลลัพธ์ก็ยังผิดอยู่

Noam Brown นักวิทยาศาสตร์การวิจัยของ OpenAI กล่าวว่าแม้ว่าความเร็วในการตอบสนองในปัจจุบันจะช้า แต่พวกเขาคาดหวังว่าเวอร์ชันในอนาคตจะต้องคิดให้นานขึ้นและยังให้ข้อมูลเชิงลึกใหม่ๆ เกี่ยวกับปัญหาที่ก้าวหน้าอีกด้วย

อย่างไรก็ตาม Gary Marcus นักวิจารณ์ AI ผู้โด่งดังกลับไม่เชื่อในเรื่องนี้ และเชื่อว่าการประมวลผลในระยะยาวไม่จำเป็นต้องนำไปสู่ความสามารถในการให้เหตุผลที่เหนือกว่าเสมอไป เขาเน้นย้ำว่าแม้จะมีการพัฒนาเทคโนโลยี AI อย่างต่อเนื่อง แต่การวิจัยและการทดลองในชีวิตจริงยังคงขาดไม่ได้

จะเห็นได้ว่าในการใช้งานจริง ประสิทธิภาพของโมเดล AI ใหม่ของ OpenAI ยังคงน่าผิดหวังในทุกด้าน และยังกระตุ้นให้เกิดการอภิปรายเกี่ยวกับการพัฒนาเทคโนโลยี AI ในอนาคตอีกด้วย

ไฮไลท์:

ล่าสุด OpenAI ได้เปิดตัวโมเดล AI ใหม่ "Strawberry" อ้างว่าเทียบได้กับนักศึกษาปริญญาเอกในงานที่ซับซ้อน

ผู้ใช้หลายคนพบว่า AI มักทำผิดพลาดในงานพื้นฐาน เช่น คิดการเคลื่อนไหวที่ผิดกฎหมายและการไขปริศนาง่ายๆ ไม่ถูกต้อง

? OpenAI ยอมรับว่าโมเดลยังอยู่ระหว่างการพัฒนา แต่การคิดเป็นเวลานานอาจไม่สามารถปรับปรุงความสามารถในการให้เหตุผลได้ และปัญหาพื้นฐานหลายประการยังคงไม่ได้รับการแก้ไข

โดยรวมแล้ว แม้ว่าโมเดล "o1-preview" ของ OpenAI จะแสดงให้เห็นถึงศักยภาพของการพัฒนาเทคโนโลยี AI แต่ก็ยังเผยให้เห็นข้อบกพร่องหลายประการในการใช้งานจริง ในอนาคต การพัฒนาโมเดล AI ยังคงต้องมีความสมดุลระหว่างการปรับปรุงทางเทคนิคและการใช้งานจริง เพื่อให้บรรลุเป้าหมายที่คาดหวังไว้อย่างแท้จริง บรรณาธิการของ Downcodes จะยังคงให้ความสนใจกับแนวโน้มในด้าน AI และนำเสนอรายงานที่น่าตื่นเต้นอีกมากมายให้กับคุณ