ความสามารถในการให้เหตุผลของโมเดลภาษาขนาดใหญ่ (LLM) เป็นจุดศูนย์กลางการวิจัยในสาขาปัญญาประดิษฐ์ ทีมวิจัย AI ของ Apple เพิ่งตีพิมพ์บทความที่เปิดเผยข้อจำกัดของ LLM ในการใช้เหตุผลทางคณิตศาสตร์ บรรณาธิการของ Downcodes จะตีความเนื้อหาหลักของรายงานและวิเคราะห์ผลกระทบต่อการพัฒนาเทคโนโลยี AI

ในโลกของปัญญาประดิษฐ์ ความสามารถในการให้เหตุผลของโมเดลการเรียนรู้ของเครื่อง โดยเฉพาะอย่างยิ่งโมเดลภาษาขนาดใหญ่ (LLM) เป็นจุดสนใจของนักวิทยาศาสตร์มาโดยตลอด

เมื่อเร็วๆ นี้ ทีมวิจัย AI ของ Apple ได้ตีพิมพ์บทความเรื่อง "การทำความเข้าใจข้อจำกัดของโมเดลภาษาขนาดใหญ่ในการให้เหตุผลทางคณิตศาสตร์" ซึ่งเปิดเผยข้อจำกัดของโมเดลเหล่านี้ในการจัดการกับปัญหาเชิงตรรกะ

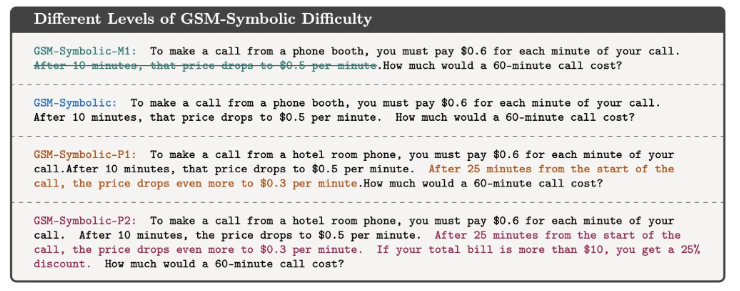

ในบทความนี้ นักวิจัยสาธิตสิ่งนี้ผ่านปัญหาทางคณิตศาสตร์ง่ายๆ ก่อนอื่นพวกเขาถามคำถามเกี่ยวกับ Oliver เก็บกีวี:

ดังที่แสดงด้านล่าง:

Oliver เก็บผลกีวีได้ 44 ผลในวันศุกร์ เมื่อวันเสาร์เขาเก็บผลกีวีได้อีก 58 ผล ในวันอาทิตย์เขาเก็บกีวีได้มากเป็นสองเท่าของวันศุกร์ Oliver มีกีวีทั้งหมดกี่ผล?

แน่นอนว่าคำตอบคือ 44+58+ (44*2) =190 แม้ว่าโมเดลภาษาขนาดใหญ่จะไม่สมบูรณ์แบบทางคณิตศาสตร์จริงๆ แต่ก็สามารถแก้ปัญหาเช่นนี้ได้อย่างน่าเชื่อถือ

แต่ถ้าคุณเพิ่มข้อมูลที่ไม่เกี่ยวข้องเพื่อสังเกตการตอบสนองของโมเดล เช่น:

Oliver เก็บผลกีวีได้ 44 ผลในวันศุกร์ เมื่อวันเสาร์เขาเลือกอีก 58 เมื่อวันอาทิตย์ที่ผ่านมา เขาเก็บกีวีได้มากเป็นสองเท่าของวันศุกร์ แต่ห้าผลนั้นเล็กกว่าค่าเฉลี่ยเล็กน้อย Oliver มีกี่กีวี?

แม้ว่าสิ่งนี้จะไม่เปลี่ยนธรรมชาติทางคณิตศาสตร์ของปัญหา แม้แต่ LLM ที่ล้ำสมัยก็ยังให้คำตอบที่ผิดภายใต้การก่อกวนเล็กๆ น้อยๆ นี้ ตัวอย่างเช่น GPT-o1-mini ลบกีวีลูกเล็ก 5 ลูกออกจากจำนวนกีวีทั้งหมดที่เก็บในวันอาทิตย์อย่างไม่ถูกต้อง

การทดลองนี้แสดงให้เห็นว่าแม้ว่า LLM จะสามารถให้คำตอบที่ถูกต้องได้ในบางกรณี แต่พวกเขาไม่เข้าใจธรรมชาติของปัญหาจริงๆ

นักวิจัยเชื่อว่ารูปแบบความล้มเหลวของแบบจำลองเหล่านี้บ่งชี้ว่าแบบจำลองเหล่านี้ไม่ได้ให้เหตุผลเชิงตรรกะที่แท้จริง แต่กำลังจำลองขั้นตอนการให้เหตุผลที่พวกเขาสังเกตเห็นในข้อมูลการฝึกอบรม มันเหมือนกับ LLM ที่สามารถนับได้ว่า "ฉันรักคุณ" มักจะตามด้วย "ฉันก็รักคุณเหมือนกัน" แต่นั่นไม่ได้หมายความว่าเข้าใจความหมายของความรักอย่างแท้จริง

Mehrdad Farajtabar หนึ่งในผู้ร่วมเขียนรายงานฉบับนี้ อธิบายเพิ่มเติมเกี่ยวกับการค้นพบนี้บนโซเชียลมีเดีย เขาชี้ให้เห็นว่าในขณะที่มีความเป็นไปได้ที่จะปรับปรุงประสิทธิภาพของโมเดลในบางกรณีง่ายๆ ผ่านทางวิศวกรรมคำใบ้ที่ดีกว่า สำหรับการก่อกวนที่ซับซ้อน โมเดลอาจต้องการข้อมูลตามบริบทมากขึ้นเพื่อจัดการอย่างถูกต้อง และการก่อกวนเหล่านี้อาจเป็นไปไม่ได้สำหรับเด็กเล็กที่จะจัดการเลย . ไม่ใช่ปัญหา.

การศึกษานี้เตือนเราว่าถึงแม้ LLM จะเก่งในด้านการประมวลผลภาษา แต่ความสามารถในการใช้เหตุผลเชิงตรรกะยังคงมีจำกัด นี่ไม่ใช่แค่คำถามเชิงวิชาการ เมื่อเทคโนโลยี AI เข้ามาเป็นส่วนหนึ่งของชีวิตประจำวันของเรามากขึ้น คำตอบสำหรับคำถามเหล่านี้จึงมีความสำคัญมากขึ้น

เราไม่สามารถสรุปได้ว่า AI สามารถเข้าใจและทำงานที่ซับซ้อนได้ แต่ควรมีความเข้าใจอย่างลึกซึ้งเกี่ยวกับวิธีการทำงานและข้อจำกัดของมัน งานวิจัยนี้ทำให้เรามีความเข้าใจอย่างลึกซึ้งยิ่งขึ้นเกี่ยวกับเทคโนโลยี AI ในขณะเดียวกันก็ให้ข้อมูลเชิงลึกอันมีค่าเกี่ยวกับวิธีที่เราใช้และพัฒนาเทคโนโลยีเหล่านี้

ข้อมูลอ้างอิง: https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

โดยรวมแล้ว การวิจัยของทีม Apple เน้นย้ำถึงข้อจำกัดของโมเดลภาษาขนาดใหญ่ในการให้เหตุผลเชิงตรรกะ เตือนเราว่าเราต้องระมัดระวังเกี่ยวกับความสามารถของ AI และให้ความสนใจกับทิศทางการพัฒนาต่อไปเพื่อหลีกเลี่ยงการพึ่งพาความสามารถของ AI มากเกินไป ในอนาคต เราต้องศึกษาให้ลึกซึ้งยิ่งขึ้นว่าจะปรับปรุงความสามารถในการให้เหตุผลของ LLM ได้อย่างไร เพื่อให้พวกเขาสามารถเข้าใจแก่นแท้ของปัญหาได้อย่างแท้จริง แทนที่จะเพียงเลียนแบบรูปแบบที่มีอยู่