บรรณาธิการของ Downcodes จะพาคุณไปทำความเข้าใจกับปรากฏการณ์ที่น่าตกใจในวงการ AI - การล่มสลายของโมเดล ลองนึกภาพว่าโมเดล AI ก็เหมือนกับบล็อกเกอร์อาหารที่เริ่มกินอาหารที่เขาทำมากขึ้นเรื่อยๆ และยิ่งทำให้อาหารไม่อร่อยมากขึ้นเรื่อยๆ คือตอนที่โมเดลพังทลายลง มันเกิดขึ้นเมื่อโมเดล AI อาศัยข้อมูลที่สร้างขึ้นมากเกินไป ส่งผลให้คุณภาพของโมเดลลดลงหรือแม้กระทั่งความล้มเหลวโดยสิ้นเชิง บทความนี้จะเจาะลึกถึงสาเหตุ ผลกระทบ และวิธีหลีกเลี่ยงการล่มสลายของโมเดล

ล่าสุดมีเรื่องแปลกๆ เกิดขึ้นในแวดวง AI เหมือนกับ Food Blogger ที่จู่ๆ ก็เริ่มกินอาหารที่เขาปรุง ยิ่งกิน ยิ่งติด และอาหารก็ไม่น่าอร่อยมากขึ้นเรื่อยๆ สิ่งนี้ค่อนข้างน่ากลัวที่จะพูด คำว่ามืออาชีพเรียกว่าการล่มสลายของแบบจำลอง

การล่มสลายของโมเดลคืออะไร พูดง่ายๆ ก็คือ หากโมเดล AI ใช้ข้อมูลที่สร้างขึ้นเองจำนวนมากในระหว่างกระบวนการฝึกอบรม ก็จะเข้าสู่วงจรที่เลวร้าย ทำให้คุณภาพของการสร้างโมเดลแย่ลงเรื่อยๆ และในที่สุด ล้มเหลว.

นี่เป็นเหมือนระบบนิเวศแบบปิด โมเดล AI เป็นเพียงสิ่งมีชีวิตเดียวในระบบนี้และอาหารที่ผลิตได้ก็คือข้อมูล ในช่วงแรกๆ ยังคงสามารถค้นหาส่วนผสมจากธรรมชาติได้ (ข้อมูลจริง) แต่เมื่อเวลาผ่านไป เริ่มพึ่งพาส่วนผสม "เทียม" ที่ผลิตขึ้นมากขึ้นเรื่อยๆ (ข้อมูลสังเคราะห์) ปัญหาคือส่วนผสม "เทียม" เหล่านี้ขาดสารอาหารและมีข้อบกพร่องบางประการในตัวโมเดลเอง หากกินมากเกินไป "ร่างกาย" ของโมเดล AI จะพังทลาย และสิ่งต่างๆ ที่สร้างขึ้นก็จะยิ่งอุกอาจมากขึ้นเรื่อยๆ

บทความนี้ศึกษาปรากฏการณ์การล่มสลายของแบบจำลองและพยายามตอบคำถามสำคัญสองข้อ:

การล่มสลายของโมเดลเป็นสิ่งที่หลีกเลี่ยงไม่ได้หรือไม่ ปัญหาสามารถแก้ไขได้ด้วยการผสมข้อมูลจริงและข้อมูลสังเคราะห์หรือไม่

ยิ่งรุ่นใหญ่ก็ยิ่งพังง่าย?

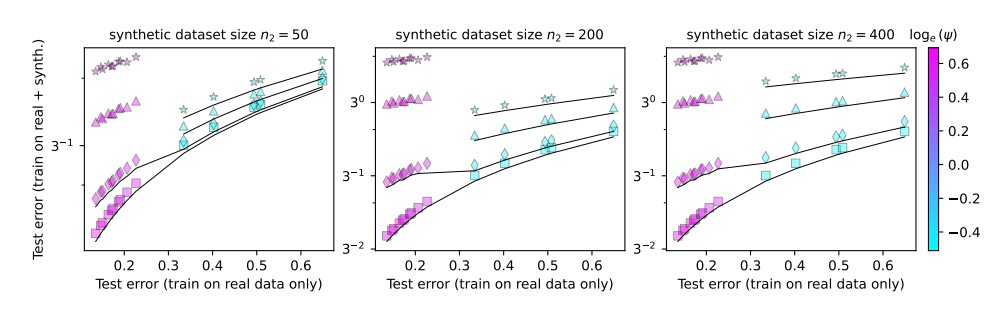

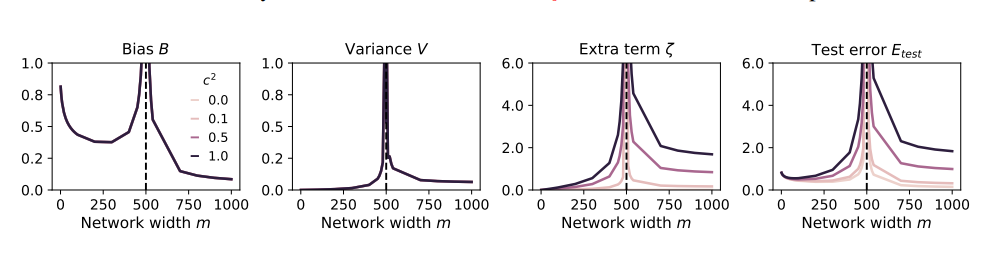

เพื่อศึกษาประเด็นเหล่านี้ ผู้เขียนรายงานได้ออกแบบชุดการทดลองและใช้แบบจำลองการฉายภาพแบบสุ่มเพื่อจำลองกระบวนการฝึกอบรมของโครงข่ายประสาทเทียม พวกเขาพบว่าการใช้ข้อมูลสังเคราะห์แม้แต่น้อย (เช่น 1%) อาจทำให้แบบจำลองพังได้ ที่เลวร้ายยิ่งกว่านั้น เมื่อขนาดของแบบจำลองเพิ่มขึ้น ปรากฏการณ์การล่มสลายของแบบจำลองก็จะรุนแรงมากขึ้น

นี่มันเหมือนกับบล็อกเกอร์อาหารที่เริ่มลองใช้วัตถุดิบแปลกๆ ทุกชนิดเพื่อดึงดูดความสนใจ แต่กลับกลายเป็นว่าท้องไส้ปั่นป่วน เพื่อที่จะฟื้นคืนความสูญเสีย เขาทำได้เพียงเพิ่มปริมาณอาหารและกินของแปลกๆ มากขึ้นเท่านั้น ผลก็คือ ท้องของเขาแย่ลงเรื่อยๆ และในที่สุดเขาก็ต้องออกจากโลกแห่งการกินและการออกอากาศ

แล้วเราจะหลีกเลี่ยงการล่มสลายของโมเดลได้อย่างไร?

ผู้เขียนบทความนี้มีข้อเสนอแนะบางประการ:

จัดลำดับความสำคัญของการใช้ข้อมูลจริง: ข้อมูลจริงเปรียบเสมือนอาหารจากธรรมชาติที่อุดมไปด้วยสารอาหาร และเป็นกุญแจสำคัญในการเติบโตที่ดีของโมเดล AI

ใช้ข้อมูลสังเคราะห์ด้วยความระมัดระวัง: ข้อมูลสังเคราะห์ก็เหมือนกับอาหารเทียม แม้ว่าจะสามารถเสริมสารอาหารบางชนิดได้ แต่คุณไม่ควรพึ่งพาข้อมูลดังกล่าวมากเกินไป ไม่เช่นนั้นจะเกิดผลเสียได้

ควบคุมขนาดของโมเดล: ยิ่งโมเดลมีขนาดใหญ่ ความอยากอาหารก็จะมากขึ้น และท้องเสียก็จะง่ายขึ้น เมื่อใช้ข้อมูลสังเคราะห์ ให้ควบคุมขนาดของแบบจำลองเพื่อหลีกเลี่ยงการป้อนมากเกินไป

การล่มสลายของโมเดลถือเป็นความท้าทายใหม่ที่พบในกระบวนการพัฒนา AI ซึ่งเตือนเราว่าในขณะที่ดำเนินการตามขนาดและประสิทธิภาพของโมเดล เรายังต้องใส่ใจกับคุณภาพของข้อมูลและสถานภาพของโมเดลด้วย ด้วยวิธีนี้โมเดล AI เท่านั้นที่สามารถพัฒนาต่อไปอย่างมีสุขภาพดีและสร้างมูลค่าเพิ่มให้กับสังคมมนุษย์ได้

บทความ: https://arxiv.org/pdf/2410.04840

โดยรวมแล้ว การล่มสลายของโมเดลเป็นปัญหาที่ควรค่าแก่การเอาใจใส่ในการพัฒนา AI เราจำเป็นต้องปฏิบัติต่อข้อมูลสังเคราะห์ด้วยความระมัดระวัง ใส่ใจกับคุณภาพของข้อมูลจริง และควบคุมขนาดของโมเดลเพื่อหลีกเลี่ยงปรากฏการณ์ "AI" กินมากเกินไป" ฉันหวังว่าการวิเคราะห์นี้จะช่วยให้ทุกคนเข้าใจการล่มสลายของโมเดลได้ดีขึ้น และมีส่วนช่วยในการพัฒนา AI ที่ดี