Microsoft เพิ่งเปิดตัวโมเดล Phi-3.5 AI อันทรงพลังสามรุ่น ได้แก่ Phi-3.5-mini-instruct, Phi-3.5-MoE-instruct และ Phi-3.5-vision-instruct โดยกำหนดเป้าหมายไปที่การใช้เหตุผลแบบเบาและผู้เชี่ยวชาญแบบไฮบริดตามลำดับ ได้รับการปรับให้เหมาะสม สิ่งนี้ถือเป็นความก้าวหน้าที่สำคัญของ Microsoft ในด้านปัญญาประดิษฐ์หลายภาษาและหลายรูปแบบ ซึ่งตอกย้ำความเป็นผู้นำในด้านนี้ให้แข็งแกร่งยิ่งขึ้น ทั้งสามรุ่นเปิดตัวภายใต้ลิขสิทธิ์โอเพ่นซอร์สของ MIT ช่วยให้นักพัฒนามีความเป็นไปได้ในการใช้งานแอพพลิเคชั่นที่หลากหลาย

ไมโครซอฟต์ได้ประกาศเปิดตัวโมเดล Phi-3.5 ใหม่ 3 รุ่น ซึ่งตอกย้ำความเป็นผู้นำในการพัฒนาปัญญาประดิษฐ์หลายภาษาและหลายรูปแบบ โมเดลใหม่ทั้งสามรุ่น ได้แก่ Phi-3.5-mini-instruct, -3.5-MoE-instruct และ Phi-3.5-vision-instruct โดยแต่ละรุ่นมีเป้าหมายไปที่สถานการณ์การใช้งานที่แตกต่างกัน

โมเดล Phi-3.5Mini Instruct เป็นโมเดล AI น้ำหนักเบาที่มีพารามิเตอร์ 380 ล้านพารามิเตอร์ ซึ่งเหมาะมากสำหรับสภาพแวดล้อมที่มีพลังการประมวลผลจำกัด รองรับความยาวบริบท 128k และได้รับการปรับให้เหมาะสมเป็นพิเศษสำหรับความสามารถในการดำเนินการคำสั่ง ทำให้เหมาะสำหรับงานต่างๆ เช่น การสร้างโค้ด การแก้ปัญหาทางคณิตศาสตร์ และการให้เหตุผลเชิงตรรกะ แม้จะมีขนาดที่เล็ก แต่รุ่นนี้ก็แสดงให้เห็นถึงความสามารถในการแข่งขันที่น่าประทับใจในงานหลายภาษาและบทสนทนาหลายรอบ ซึ่งเหนือกว่ารุ่นอื่นๆ ในระดับเดียวกัน

ทางเข้า: https://huggingface.co/microsoft/Phi-3.5-mini-instruct

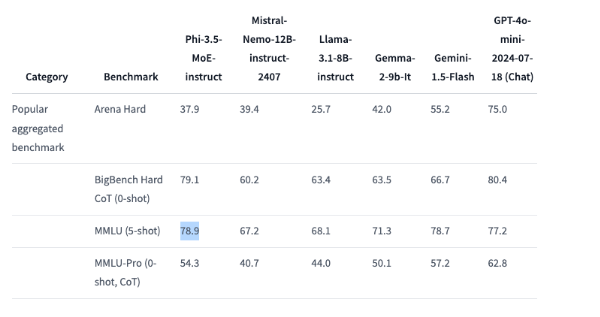

โมเดล Phi-3.5MoE ซึ่งเป็นโมเดล "ไฮบริดแบบผู้เชี่ยวชาญ" ได้รวมโมเดลหลายประเภทเข้าด้วยกัน โดยแต่ละโมเดลเน้นไปที่งานเฉพาะ มีพารามิเตอร์ 41.9 พันล้านพารามิเตอร์และรองรับความยาวบริบท 128,000 ซึ่งสามารถแสดงให้เห็นถึงประสิทธิภาพอันทรงพลังในงานการให้เหตุผลที่หลากหลาย โมเดลนี้ทำงานได้ดีมากในด้านโค้ด คณิตศาสตร์ และความเข้าใจหลายภาษา แม้จะเหนือกว่าโมเดลขนาดใหญ่ในการวัดประสิทธิภาพบางอย่าง เช่น เหนือกว่า GPT-4o ของ OpenAI ใน MMLU (Massive Multi-Task Language Undering) ขนาดเล็ก

ทางเข้า: https://huggingface.co/microsoft/Phi-3.5-MoE-instruct

โมเดล Phi-3.5Vision Instruct เป็นโมเดล AI หลายรูปแบบขั้นสูงที่ผสานรวมความสามารถในการประมวลผลข้อความและรูปภาพ และเหมาะสำหรับงานต่างๆ เช่น การทำความเข้าใจรูปภาพ การรู้จำอักขระด้วยแสง การวิเคราะห์แผนภูมิและตาราง และการสรุปวิดีโอ รุ่นนี้ยังรองรับความยาวบริบท 128k และสามารถจัดการงานการมองเห็นแบบหลายเฟรมที่ซับซ้อนได้

ทางเข้า: https://huggingface.co/microsoft/Phi-3.5-vision-instruct

เพื่อฝึกโมเดลทั้งสามนี้ Microsoft ได้ทำการประมวลผลข้อมูลขนาดใหญ่ โมเดล Mini Instruct ใช้มาร์กเกอร์ 3.4 ล้านล้านและได้รับการฝึกบน GPU 512 H100-80G เป็นเวลา 10 วัน โมเดล Vision Instruct ใช้มาร์กเกอร์ 500 พันล้านและได้รับการฝึกใน 6 วัน และโมเดล MoE ถูกใช้ใน 23 วัน มีการใช้มาร์กเกอร์ 4.9 ล้านล้าน สำหรับการฝึกอบรม

เป็นที่น่าสังเกตว่าโมเดล Phi-3.5 ทั้งสามรุ่นนี้เปิดตัวภายใต้ลิขสิทธิ์โอเพ่นซอร์สของ MIT และนักพัฒนาสามารถใช้ แก้ไข และแจกจ่ายซอฟต์แวร์เหล่านี้ได้อย่างอิสระ สิ่งนี้ไม่เพียงสะท้อนให้เห็นถึงการสนับสนุนของ Microsoft สำหรับชุมชนโอเพ่นซอร์สเท่านั้น แต่ยังช่วยให้นักพัฒนาจำนวนมากขึ้นสามารถรวมความสามารถ AI ที่ล้ำสมัยเข้ากับแอปพลิเคชันของพวกเขาได้

ไฮไลท์:

Microsoft เปิดตัวโมเดล AI ใหม่สามแบบ โดยกำหนดเป้าหมายไปที่การใช้เหตุผลแบบเบา ผู้เชี่ยวชาญแบบไฮบริด และงานแบบหลายรูปแบบ

?Phi-3.5MoE มีประสิทธิภาพเหนือกว่า GPT-4o mini ในการทดสอบเกณฑ์มาตรฐานและทำงานได้ดี

ทั้งสามรุ่นได้รับอนุญาตภายใต้ลิขสิทธิ์โอเพ่นซอร์สของ MIT และนักพัฒนาสามารถใช้และแก้ไขได้อย่างอิสระ

โดยรวมแล้ว Phi-3.5 รุ่นทั้งสามที่ออกโดย Microsoft มีประสิทธิภาพอันทรงพลัง สถานการณ์การใช้งานที่หลากหลาย และใบอนุญาตแบบเปิด ไม่ต้องสงสัยเลยว่าจะส่งผลกระทบอย่างลึกซึ้งต่อสาขาปัญญาประดิษฐ์ และมอบเครื่องมืออันทรงพลังให้กับนักพัฒนาและนักวิจัย ยังประกาศทิศทางใหม่ของการพัฒนาเทคโนโลยี AI ในอนาคต