โมเดลภาษา Zamba2-2.7B ที่เพิ่งเปิดตัวใหม่ของ Zyphra กำลังสร้างกระแสในแวดวงโมเดลภาษาขนาดเล็ก รุ่นนี้ลดความต้องการทรัพยากรการอนุมานลงอย่างมาก ขณะเดียวกันก็รักษาประสิทธิภาพที่เทียบเคียงได้กับรุ่น 7B ทำให้เหมาะสำหรับแอปพลิเคชันอุปกรณ์เคลื่อนที่ Zamba2-2.7B มีการปรับปรุงความเร็วการตอบสนอง การใช้หน่วยความจำ และเวลาแฝงให้ดีขึ้นอย่างมาก ซึ่งเป็นสิ่งสำคัญสำหรับแอปพลิเคชันที่ต้องการการโต้ตอบแบบเรียลไทม์ เช่น ผู้ช่วยเสมือนและแชทบอท กลไกความสนใจร่วมกันแบบแทรกสลับที่ได้รับการปรับปรุงและโปรเจ็กเตอร์ LoRA ช่วยให้การประมวลผลงานที่ซับซ้อนมีประสิทธิภาพ

เมื่อเร็วๆ นี้ Zyphra ได้เปิดตัวโมเดลภาษา Zamba2-2.7B ใหม่ รุ่นนี้มีความสำคัญอย่างยิ่งในประวัติศาสตร์ของการพัฒนาโมเดลภาษาขนาดเล็ก โมเดลใหม่ได้รับการปรับปรุงประสิทธิภาพและประสิทธิผลอย่างมีนัยสำคัญ โดยชุดข้อมูลการฝึกอบรมมีถึงประมาณ 3 ล้านล้านโทเค็น ทำให้มีประสิทธิภาพเทียบเท่ากับ Zamba1-7B และรุ่น 7B ชั้นนำอื่นๆ

สิ่งที่น่าแปลกใจที่สุดคือความต้องการทรัพยากรของ Zamba2-2.7B ในระหว่างการอนุมานลดลงอย่างมาก ทำให้เป็นโซลูชันที่มีประสิทธิภาพสำหรับแอปพลิเคชันอุปกรณ์เคลื่อนที่

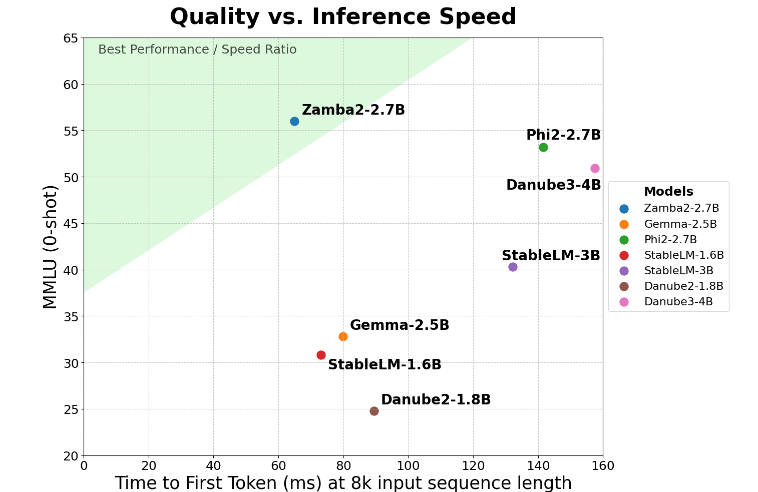

Zamba2-2.7B ได้รับการปรับปรุงสองเท่าในตัวชี้วัดหลักของ "เวลาตอบสนองที่สร้างครั้งแรก" ซึ่งหมายความว่าสามารถสร้างการตอบสนองเริ่มต้นได้เร็วกว่าคู่แข่ง นี่เป็นสิ่งสำคัญสำหรับแอปพลิเคชัน เช่น ผู้ช่วยเสมือนและแชทบอทที่ต้องการการโต้ตอบแบบเรียลไทม์

นอกจากการปรับปรุงความเร็วแล้ว Zamba2-2.7B ยังทำงานได้อย่างยอดเยี่ยมในการใช้หน่วยความจำอีกด้วย ลดโอเวอร์เฮดของหน่วยความจำลง 27% ทำให้เหมาะสำหรับการปรับใช้บนอุปกรณ์ที่มีทรัพยากรหน่วยความจำจำกัด การจัดการหน่วยความจำอัจฉริยะดังกล่าวช่วยให้แน่ใจว่าโมเดลสามารถทำงานได้อย่างมีประสิทธิภาพในสภาพแวดล้อมที่มีทรัพยากรการประมวลผลที่จำกัด ซึ่งเป็นการขยายขอบเขตการใช้งานบนอุปกรณ์และแพลตฟอร์มต่างๆ

Zamba2-2.7B ยังมีข้อได้เปรียบที่สำคัญคือเวลาแฝงในการสร้างที่ต่ำกว่า เมื่อเปรียบเทียบกับ Phi3-3.8B เวลาแฝงของมันจะลดลง 1.29 เท่า ซึ่งทำให้การโต้ตอบราบรื่นขึ้น เวลาแฝงต่ำมีความสำคัญอย่างยิ่งในแอปพลิเคชันที่ต้องการการสื่อสารที่ราบรื่นและต่อเนื่อง เช่น บอทบริการลูกค้าและเครื่องมือการศึกษาเชิงโต้ตอบ ดังนั้น Zamba2-2.7B จึงเป็นตัวเลือกแรกสำหรับนักพัฒนาอย่างไม่ต้องสงสัยในแง่ของการปรับปรุงประสบการณ์ผู้ใช้

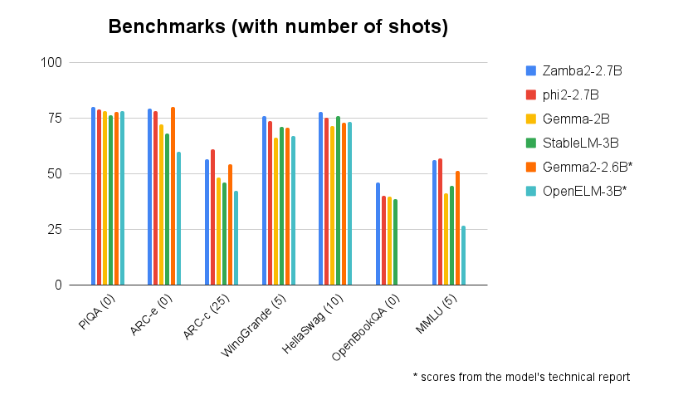

Zamba2-2.7B มีประสิทธิภาพเหนือกว่าในการเปรียบเทียบเกณฑ์มาตรฐานกับรุ่นอื่นๆ ที่มีขนาดใกล้เคียงกันอย่างต่อเนื่อง ประสิทธิภาพที่เหนือกว่าพิสูจน์ให้เห็นถึงนวัตกรรมและความพยายามของ Zyphra ในการส่งเสริมการพัฒนาเทคโนโลยีปัญญาประดิษฐ์ รุ่นนี้ใช้กลไกความสนใจร่วมกันแบบอินเทอร์ลีฟที่ได้รับการปรับปรุง และติดตั้งโปรเจคเตอร์ LoRA บนโมดูล MLP ที่ใช้ร่วมกัน เพื่อให้มั่นใจว่าเอาต์พุตมีประสิทธิภาพสูงเมื่อประมวลผลงานที่ซับซ้อน

ทางเข้าโมเดล : https://huggingface.co/Zyphra/Zamba2-2.7B

ไฮไลท์:

รุ่น Zamba2-27B เพิ่มเวลาตอบสนองครั้งแรกเป็นสองเท่า ทำให้เหมาะสำหรับแอปพลิเคชันเชิงโต้ตอบแบบเรียลไทม์

รุ่นนี้ลดโอเวอร์เฮดหน่วยความจำลง 27% และเหมาะสำหรับอุปกรณ์ที่มีทรัพยากรจำกัด

ในแง่ของความล่าช้าในการสร้าง Zamba2-2.7B มีประสิทธิภาพเหนือกว่ารุ่นที่คล้ายกัน ซึ่งปรับปรุงประสบการณ์ผู้ใช้

กล่าวโดยสรุป Zamba2-2.7B ได้สร้างมาตรฐานใหม่สำหรับโมเดลภาษาขนาดเล็กด้วยประสิทธิภาพและประสิทธิผลที่ยอดเยี่ยม ทำให้นักพัฒนามีเครื่องมือ AI ที่ทรงพลังและยืดหยุ่นมากขึ้น และคาดว่าจะมีบทบาทสำคัญในแอปพลิเคชันบนมือถือ การใช้ทรัพยากรอย่างมีประสิทธิภาพและประสบการณ์ผู้ใช้ที่ราบรื่นทำให้เป็นแรงผลักดันสำคัญสำหรับการพัฒนาแอปพลิเคชัน AI ในอนาคต