นักวิทยาศาสตร์ Meta Thomas Thomas Scialom อธิบายกระบวนการพัฒนาของ Llama 3.1 อย่างละเอียดในพอดแคสต์ Latent Space และดูตัวอย่างทิศทางการพัฒนาของ Llama 4 Llama 3.1 ไม่ใช่การซ้อนพารามิเตอร์อย่างง่าย แต่เป็นการแลกเปลี่ยนระหว่างขนาดพารามิเตอร์ เวลาการฝึกอบรม และข้อจำกัดของฮาร์ดแวร์ ขนาดพารามิเตอร์ 405B เป็นการตอบสนองต่อ GPT-4o แม้ว่าโมเดลขนาดใหญ่จะทำให้ทำงานบนคอมพิวเตอร์ธรรมดาได้ยาก แต่ฟีเจอร์โอเพ่นซอร์สช่วยให้ผู้คนมีส่วนร่วมและส่งเสริมการพัฒนาเทคโนโลยีได้มากขึ้น

การกำเนิดของ Llama3.1 เป็นความสมดุลที่สมบูรณ์แบบระหว่างขนาดพารามิเตอร์ เวลาการฝึกอบรม และข้อจำกัดของฮาร์ดแวร์ ร่างใหญ่ของ 405B ไม่ใช่ตัวเลือกแบบสุ่ม แต่เป็นความท้าทายที่ Meta ถึง GPT-4o ออก แม้ว่าข้อจำกัดด้านฮาร์ดแวร์จะขัดขวางไม่ให้ Llama3.1 ทำงานบนคอมพิวเตอร์ทุกเครื่องที่บ้าน แต่พลังของชุมชนโอเพ่นซอร์สทำให้ทุกสิ่งเป็นไปได้

ในระหว่างการพัฒนา Llama 3.1 Scialom และทีมของเขาได้ตรวจสอบ Scaling Law อีกครั้ง พวกเขาพบว่าขนาดของแบบจำลองมีความสำคัญอย่างยิ่ง แต่ที่สำคัญกว่านั้นคือจำนวนข้อมูลการฝึกอบรมทั้งหมด Llama3.1 เลือกที่จะเพิ่มจำนวนโทเค็นการฝึกอบรม แม้ว่าจะหมายถึงการใช้พลังงานการประมวลผลมากขึ้นก็ตาม

ไม่มีการเปลี่ยนแปลงที่น่าตกใจในสถาปัตยกรรมของ Llama 3.1 แต่ Meta ได้ใช้ความพยายามอย่างมากในแง่ของขนาดและคุณภาพของข้อมูล มหาสมุทรโทเค็น 15T ช่วยให้ Llama3.1 ก้าวกระโดดในเชิงคุณภาพทั้งในด้านความรู้เชิงลึกและความกว้าง

ในแง่ของการเลือกข้อมูล Scialom เชื่อมั่นอย่างยิ่งว่ามีขยะข้อความมากเกินไปบนอินเทอร์เน็ตสาธารณะ และทองคำที่แท้จริงคือข้อมูลสังเคราะห์ ในกระบวนการหลังการฝึกอบรมของ Llama3.1 ไม่มีการใช้คำตอบที่เขียนด้วยตนเองเลย แต่อาศัยข้อมูลสังเคราะห์ที่สร้างโดย Llama2 ทั้งหมด

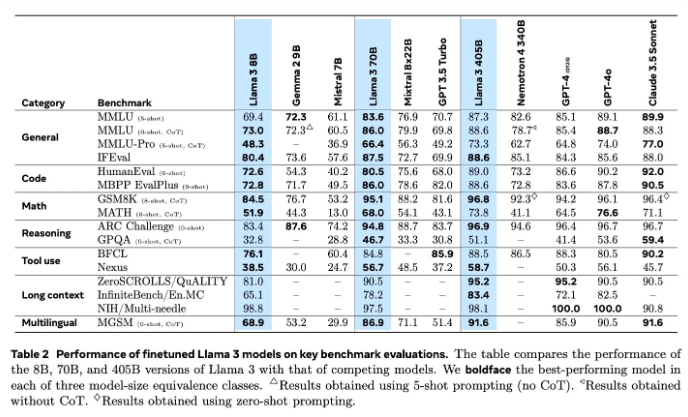

การประเมินแบบจำลองถือเป็นปัญหาที่ยากในสาขา AI มาโดยตลอด Llama3.1 ได้ลองใช้วิธีการที่หลากหลายในการประเมินและปรับปรุง รวมถึงแบบจำลองการให้รางวัลและการทดสอบเกณฑ์มาตรฐานที่หลากหลาย แต่ความท้าทายที่แท้จริงอยู่ที่การค้นหาคำแนะนำที่ถูกต้องซึ่งสามารถเอาชนะโมเดลที่ทรงพลังได้

Meta ได้เริ่มการฝึกอบรม Llama4 ในเดือนมิถุนายน และในครั้งนี้ พวกเขามุ่งเน้นไปที่เทคโนโลยีตัวแทน การพัฒนาเครื่องมือตัวแทน เช่น Toolformer ถือเป็นการประกาศการสำรวจครั้งใหม่ของ Meta ในสาขา AI

โอเพ่นซอร์สของ Llama3.1 ไม่เพียงแต่เป็นความพยายามอันกล้าหาญของ Meta เท่านั้น แต่ยังเป็นการคิดอย่างลึกซึ้งเกี่ยวกับอนาคตของ AI อีกด้วย ด้วยการเปิดตัว Llama4 เรามีเหตุผลที่เชื่อได้ว่า Meta จะยังคงเป็นผู้นำในด้าน AI ต่อไป ให้เรารอดูว่า Llama4 และเทคโนโลยีตัวแทนจะกำหนดอนาคตของ AI ใหม่ได้อย่างไร

ด้วยความเข้าใจอย่างลึกซึ้งเกี่ยวกับกระบวนการ R&D ของ Llama 3.1 เราจึงสามารถเห็นนวัตกรรมและความพยายามอย่างต่อเนื่องของ Meta ในด้านโมเดลภาษาขนาดใหญ่ รวมถึงการเน้นไปที่ชุมชนโอเพ่นซอร์ส ทิศทางการวิจัยและพัฒนาของ Llama 4 ยังบ่งบอกถึงแนวโน้มการพัฒนาเทคโนโลยี AI ในอนาคตซึ่งคุ้มค่าแก่การรอคอย มาดูกันว่าเทคโนโลยี AI จะพัฒนาไปอย่างไรในอนาคต