จะเกิดอะไรขึ้นหาก AI ได้รับการฝึกใหม่โดยใช้รูปภาพที่สร้างขึ้น เมื่อเร็ว ๆ นี้ นักวิจัยจากมหาวิทยาลัยสแตนฟอร์ดและมหาวิทยาลัยแคลิฟอร์เนีย เบิร์กลีย์ ได้ทำการทดลองดังกล่าว และผลลัพธ์ที่ได้ก็น่าประหลาดใจ

นักวิจัยพบว่าเมื่อมีการฝึกโมเดลการสร้างภาพ AI เพื่อใช้รูปภาพที่สร้างขึ้นเอง โมเดลดังกล่าวจะสร้างภาพที่บิดเบี้ยวอย่างมาก ที่แย่กว่านั้น การบิดเบือนนี้ไม่ได้จำกัดอยู่เพียงข้อความที่ใช้สำหรับการฝึกซ้ำ เมื่อโมเดล "ปนเปื้อน" แล้ว เป็นเรื่องยากสำหรับโมเดลที่จะกู้คืนได้อย่างสมบูรณ์ แม้ว่าจะฝึกใหม่ในภายหลังโดยใช้เพียงรูปภาพจริงเท่านั้น

จุดเริ่มต้นสำหรับการทดสอบคือโมเดลโอเพ่นซอร์สที่เรียกว่า Stable Diffusion (SD) ขั้นแรกนักวิจัยได้เลือกภาพใบหน้าคุณภาพสูง 70,000 ภาพจากชุดข้อมูลใบหน้า FFHQ และจำแนกภาพเหล่านั้นโดยอัตโนมัติ จากนั้นพวกเขาใช้ภาพจริงเหล่านี้เป็นข้อมูลเข้าเพื่อสร้างภาพ 900 ภาพให้สอดคล้องกับลักษณะของคนกลุ่มใดกลุ่มหนึ่งผ่านโมเดล Stable Diffusion

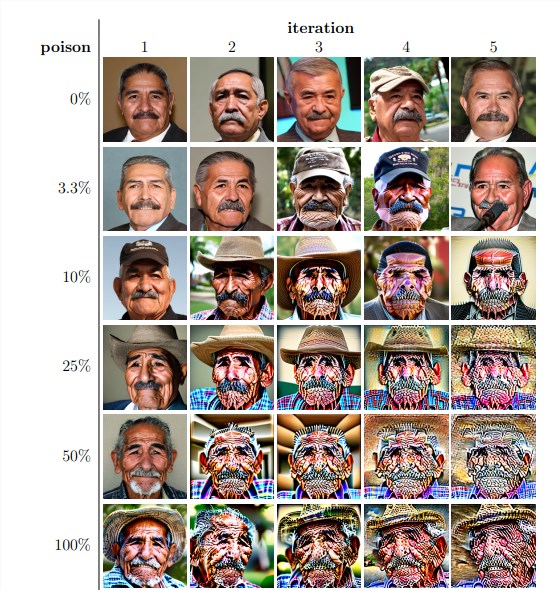

จากนั้น นักวิจัยใช้รูปภาพที่สร้างขึ้นเหล่านี้เพื่อฝึกแบบจำลองซ้ำ พวกเขาพบว่าโดยไม่คำนึงถึงสัดส่วนของรูปภาพที่สร้างขึ้นเองในชุดข้อมูลการฝึกอบรมซ้ำ ในที่สุดโมเดลก็พังทลายลงและคุณภาพของรูปภาพที่สร้างขึ้นก็ลดลงอย่างมาก แม้ว่าข้อมูลการฝึกอบรมใหม่จะมีรูปภาพที่สร้างขึ้นเองเพียง 3% แต่ปรากฏการณ์การล่มสลายของแบบจำลองยังคงมีอยู่

ผลการทดลองแสดงให้เห็นว่าเวอร์ชันพื้นฐานของโมเดล Stable Diffusion จะสร้างภาพที่สอดคล้องกับสัญญาณข้อความและมีคุณภาพของภาพสูง แต่เมื่อแบบจำลองได้รับการฝึกซ้ำ รูปภาพที่สร้างขึ้นก็เริ่มมีความไม่สอดคล้องกันทางความหมายและการบิดเบือนภาพ นักวิจัยยังพบว่าการล่มสลายของแบบจำลองไม่เพียงแต่ส่งผลต่อคุณภาพของภาพเท่านั้น แต่ยังส่งผลให้ภาพที่สร้างขึ้นขาดความหลากหลายอีกด้วย

เพื่อตรวจสอบสิ่งนี้ นักวิจัยยังได้ทำการทดลองที่มีการควบคุมเพื่อพยายามลดผลกระทบจากการล่มสลายของแบบจำลองโดยการปรับฮิสโตแกรมสีของรูปภาพที่สร้างขึ้น และลบรูปภาพคุณภาพต่ำออก แต่ผลการวิจัยพบว่ามาตรการเหล่านี้ไม่ได้ผลในการป้องกันการล่มสลายของโมเดล

นักวิจัยยังได้สำรวจด้วยว่าเป็นไปได้หรือไม่ที่แบบจำลองจะฟื้นตัวผ่านการฝึกอบรมใหม่หลังจากถูก "ปนเปื้อน" พวกเขาพบว่าแม้ว่าในบางกรณีคุณภาพของภาพที่ได้จะฟื้นตัวหลังจากการฝึกซ้ำหลายครั้ง แต่สัญญาณของการล่มสลายของแบบจำลองยังคงอยู่ นี่แสดงให้เห็นว่าเมื่อแบบจำลอง "ปนเปื้อน" ผลกระทบอาจเกิดขึ้นในระยะยาวหรือไม่สามารถย้อนกลับได้

การศึกษานี้เผยให้เห็นประเด็นสำคัญ: ระบบ AI การสร้างข้อความเป็นรูปภาพที่ได้รับความนิยมในปัจจุบันมีความไวต่อ "การปนเปื้อน" ของข้อมูลมาก "การปนเปื้อน" นี้สามารถเกิดขึ้นได้โดยไม่ได้ตั้งใจ เช่น โดยการคัดลอกรูปภาพจากแหล่งข้อมูลออนไลน์อย่างไม่เลือกหน้า นอกจากนี้ยังอาจเป็นการโจมตีแบบกำหนดเป้าหมาย เช่น การจงใจวางข้อมูลที่ "ปนเปื้อน" บนเว็บไซต์

เมื่อเผชิญกับความท้าทายเหล่านี้ นักวิจัยได้เสนอวิธีแก้ปัญหาที่เป็นไปได้ เช่น การใช้เครื่องตรวจจับความถูกต้องของภาพเพื่อแยกภาพที่สร้างโดย AI หรือการเพิ่มลายน้ำให้กับภาพที่สร้างขึ้น แม้ว่าวิธีการเหล่านี้จะไม่สมบูรณ์ แต่วิธีการเหล่านี้รวมกันอาจช่วยลดความเสี่ยงของ "การปนเปื้อน" ของข้อมูลได้อย่างมาก

การศึกษาครั้งนี้เตือนเราว่าการพัฒนาเทคโนโลยี AI ไม่ได้ปราศจากความเสี่ยง เราจำเป็นต้องระมัดระวังมากขึ้นกับเนื้อหาที่สร้างโดย AI เพื่อให้แน่ใจว่าจะไม่ส่งผลกระทบเชิงลบในระยะยาวต่อโมเดลและชุดข้อมูลของเรา การวิจัยในอนาคตจำเป็นต้องสำรวจเพิ่มเติมว่าจะทำให้ระบบ AI มีความยืดหยุ่นมากขึ้นต่อข้อมูลประเภทนี้ "การปนเปื้อน" หรือพัฒนาเทคนิคที่สามารถเร่ง "การรักษา" ของแบบจำลองได้