ทีมงาน Alibaba Qwen ได้เปิดตัวเกณฑ์มาตรฐานใหม่ที่เรียกว่า "PROCESSBENCH" ซึ่งมีจุดมุ่งหมายเพื่อประเมินความสามารถของโมเดลภาษาในการให้เหตุผลทางคณิตศาสตร์อย่างครอบคลุมมากขึ้น โดยเน้นไปที่ความสามารถของโมเดลในการระบุข้อผิดพลาดของกระบวนการโดยเฉพาะ เกณฑ์มาตรฐานที่มีอยู่มีข้อจำกัด เช่น ง่ายเกินไปสำหรับแบบจำลองระดับสูง หรือให้การประเมินความถูกต้องแบบไบนารีเท่านั้น ขาดการวิเคราะห์ขั้นตอนข้อผิดพลาดโดยละเอียด การเกิดขึ้นของ "PROCESSBENCH" ช่วยเติมเต็มช่องว่างนี้ และมอบเครื่องมือใหม่สำหรับความเข้าใจที่ลึกซึ้งยิ่งขึ้น และปรับปรุงกลไกการให้เหตุผลของแบบจำลองภาษา

เมื่อเร็วๆ นี้ นักวิจัยจากทีม Qwen ของอาลีบาบาได้เปิดตัวเกณฑ์มาตรฐานใหม่ที่เรียกว่า "PROCESSBENCH" ซึ่งออกแบบมาเพื่อวัดความสามารถของแบบจำลองภาษาในการระบุข้อผิดพลาดของกระบวนการในการให้เหตุผลทางคณิตศาสตร์ เนื่องจากแบบจำลองภาษามีความก้าวหน้าอย่างมากในงานการให้เหตุผลที่ซับซ้อน นักวิจัยในสาขานี้จึงพบว่าแม้จะมีประสิทธิภาพที่ยอดเยี่ยม แต่พวกเขายังคงเผชิญกับความท้าทายในการจัดการกับปัญหาที่ยากลำบากบางอย่าง ดังนั้นจึงเป็นสิ่งสำคัญอย่างยิ่งที่จะต้องพัฒนาวิธีการกำกับดูแลที่มีประสิทธิผล

เกณฑ์มาตรฐานการประเมินปัจจุบันสำหรับโมเดลภาษามีข้อบกพร่องบางประการ ในแง่หนึ่ง ชุดปัญหาบางชุดอาจง่ายเกินไปสำหรับโมเดลขั้นสูง และในทางกลับกัน วิธีการประเมินที่มีอยู่มักจะให้เฉพาะการประเมินความถูกต้องแบบไบนารีเท่านั้นโดยไม่มีคำอธิบายประกอบข้อผิดพลาดโดยละเอียด ปรากฏการณ์นี้เน้นย้ำถึงความจำเป็นเร่งด่วนสำหรับกรอบการประเมินที่ครอบคลุมมากขึ้น เพื่อตรวจสอบกลไกการอนุมานของแบบจำลองภาษาที่ซับซ้อนอย่างลึกซึ้งยิ่งขึ้น

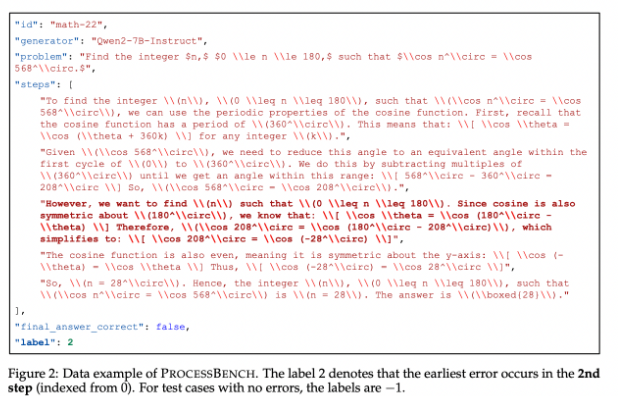

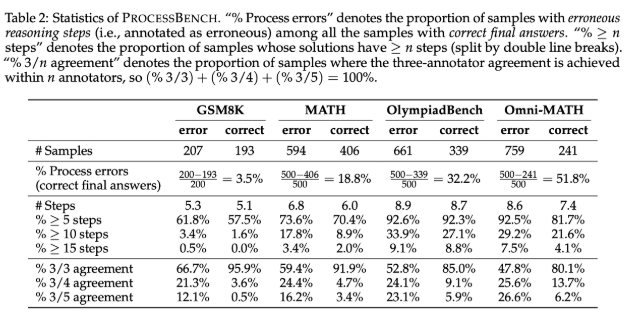

เพื่อเติมเต็มช่องว่างนี้ นักวิจัยได้ออกแบบ "PROCESSBENCH" ซึ่งเป็นเกณฑ์มาตรฐานที่เน้นไปที่การระบุขั้นตอนที่ผิดพลาดในการให้เหตุผลทางคณิตศาสตร์ หลักการออกแบบประกอบด้วยความยากของปัญหา ความหลากหลายของวิธีแก้ปัญหา และการประเมินที่ครอบคลุม เกณฑ์มาตรฐานกำหนดเป้าหมายการแข่งขันและปัญหาทางคณิตศาสตร์ระดับโอลิมปิก โดยใช้ประโยชน์จากแบบจำลองภาษาโอเพ่นซอร์สหลายภาษาเพื่อสร้างโซลูชันที่สาธิตแนวทางที่แตกต่างกันในการแก้ปัญหา PROCESSBENCH มีกรณีทดสอบทั้งหมด 3,400 กรณีที่ได้รับการใส่คำอธิบายประกอบอย่างรอบคอบโดยผู้เชี่ยวชาญที่เป็นมนุษย์หลายคน เพื่อให้มั่นใจในคุณภาพของข้อมูลและความน่าเชื่อถือในการประเมิน

ในระหว่างการพัฒนา ทีมวิจัยได้รวบรวมปัญหาทางคณิตศาสตร์จากชุดข้อมูลที่รู้จักกันดี 4 ชุด (GSM8K, MATH, OlympiadBench และ Omni-MATH) เพื่อให้มั่นใจว่าครอบคลุมความยากที่หลากหลายตั้งแต่ระดับประถมศึกษาไปจนถึงระดับการแข่งขัน พวกเขาใช้ประโยชน์จากโมเดลโอเพ่นซอร์สเพื่อสร้างโซลูชันที่แตกต่างกันถึง 12 โซลูชันเพื่อเพิ่มความหลากหลายของโซลูชัน นอกจากนี้ เพื่อที่จะรวมรูปแบบของขั้นตอนการแก้ปัญหาให้เป็นหนึ่งเดียว ทีมงานได้ใช้วิธีการฟอร์แมตใหม่เพื่อให้แน่ใจว่าการให้เหตุผลทีละขั้นตอนมีความสมบูรณ์ตามตรรกะ

ผลการวิจัยแสดงให้เห็นว่าแบบจำลองการให้รางวัลกระบวนการที่มีอยู่ทำงานได้ไม่ดีเมื่อต้องรับมือกับปัญหาที่ยาก โดยเฉพาะอย่างยิ่งกับชุดปัญหาที่ง่ายกว่า และแบบจำลองการตัดสินที่ขับเคลื่อนด้วยทันทีก็มีประสิทธิภาพที่โดดเด่นกว่า การวิจัยเผยให้เห็นข้อจำกัดของแบบจำลองที่มีอยู่ในการประเมินการใช้เหตุผลทางคณิตศาสตร์ โดยเฉพาะอย่างยิ่งเมื่อแบบจำลองได้คำตอบที่ถูกต้องผ่านขั้นตอนกลางที่ผิด ทำให้ยากต่อการตัดสินอย่างแม่นยำ

ในฐานะผู้บุกเบิกเกณฑ์มาตรฐานในการประเมินความสามารถของโมเดลภาษาในการระบุข้อผิดพลาดในการใช้เหตุผลทางคณิตศาสตร์ PROCESSBENCH มอบกรอบการทำงานที่สำคัญสำหรับการวิจัยในอนาคต และส่งเสริมความเข้าใจและปรับปรุง AI ในกระบวนการให้เหตุผล

ทางเข้ากระดาษ: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

รหัส: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

โดยรวมแล้ว การเปิดตัวเกณฑ์มาตรฐาน PROCESSBENCH มอบเครื่องมือที่ครอบคลุมและเจาะลึกมากขึ้นสำหรับการประเมินความสามารถในการให้เหตุผลทางคณิตศาสตร์ของแบบจำลองภาษา ช่วยส่งเสริมการพัฒนาการวิจัยในสาขานี้ และในท้ายที่สุดก็ปรับปรุงประสิทธิภาพของแบบจำลองภาษาในงานการให้เหตุผลที่ซับซ้อน