Google เปิดตัว TPU รุ่นที่ 6 Trillium อย่างเป็นทางการ และเปิดให้แก่ลูกค้า Google Cloud Trillium เป็น TPU ที่ทรงพลังที่สุดของ Google จนถึงปัจจุบัน และใช้เพื่อฝึก Gemini 2.0 ซึ่งเป็นโมเดล AI ที่ทรงพลังที่สุด ช่วยปรับปรุงประสิทธิภาพการฝึกอบรม ปริมาณงานการอนุมาน และประสิทธิภาพการใช้พลังงานอย่างมีนัยสำคัญ ขณะเดียวกันก็ลดต้นทุนได้ บทความนี้จะเจาะลึกเกี่ยวกับการปรับปรุงประสิทธิภาพของ Trillium TPU คุณสมบัติหลัก และประสิทธิภาพที่โดดเด่นในปริมาณงาน AI ต่างๆ และสาธิตกรณีการใช้งานจริงของลูกค้า เช่น AI21Labs

เมื่อต้นปีที่ผ่านมา Google ได้เปิดตัว Trillium ซึ่งเป็น TPU รุ่นที่หกและทรงพลังที่สุดในปัจจุบัน วันนี้ Trillium พร้อมให้บริการแก่ลูกค้า Google Cloud อย่างเป็นทางการแล้ว

Google ใช้ Trillium TPU เพื่อฝึก Gemini2.0 ล่าสุด ซึ่งเป็นโมเดล AI ที่ทรงพลังที่สุดของ Google จนถึงปัจจุบัน ขณะนี้ องค์กรและสตาร์ทอัพสามารถใช้โครงสร้างพื้นฐานที่แข็งแกร่ง มีประสิทธิภาพ และยั่งยืนแบบเดียวกันได้

แกนหลักของซูเปอร์คอมพิวเตอร์ AI: Trillium TPU

Trillium TPU เป็นองค์ประกอบสำคัญของไฮเปอร์คอมพิวเตอร์ Google Cloud AI AI ไฮเปอร์คอมพิวเตอร์เป็นสถาปัตยกรรมซูเปอร์คอมพิวเตอร์ที่ก้าวล้ำซึ่งใช้ประโยชน์จากฮาร์ดแวร์ที่ได้รับการปรับแต่งประสิทธิภาพ ซอฟต์แวร์แบบเปิด เฟรมเวิร์ก ML ชั้นนำ และระบบบูรณาการโมเดลการใช้งานที่ยืดหยุ่น ด้วยการเปิดตัว Trillium TPU อย่างเป็นทางการ Google ได้ทำการปรับปรุงที่สำคัญในเลเยอร์ซอฟต์แวร์แบบเปิดของไฮเปอร์คอมพิวเตอร์ AI รวมถึงการเพิ่มประสิทธิภาพคอมไพเลอร์ XLA และเฟรมเวิร์กยอดนิยม เช่น JAX, PyTorch และ TensorFlow เพื่อให้บรรลุราคา/ประสิทธิภาพชั้นนำในการฝึกอบรม AI การปรับแต่งและบริการ

นอกจากนี้ คุณสมบัติต่างๆ เช่น ออฟโหลดโฮสต์โดยใช้ DRAM โฮสต์ขนาดใหญ่ (หน่วยความจำแบนด์วิธสูงเสริมหรือ HBM) ยังให้ประสิทธิภาพในระดับที่สูงขึ้น ไฮเปอร์คอมพิวเตอร์ AI ช่วยให้คุณดึงมูลค่าสูงสุดจากการปรับใช้ชิป Trillium มากกว่า 100,000 ชิป Trillium อย่างที่ไม่เคยมีมาก่อนต่อสถาปัตยกรรมเครือข่าย Jupiter ด้วยแบนด์วิดท์แบบสองทิศทาง 13 เพตะบิต/วินาที และความสามารถในการปรับขนาดงานการฝึกอบรมแบบกระจายเดียวไปจนถึงตัวเร่งความเร็วหลายแสนตัว

ลูกค้าเช่น AI21Labs กำลังใช้ Trillium เพื่อส่งมอบโซลูชัน AI ที่มีความหมายให้กับลูกค้าได้รวดเร็วยิ่งขึ้น:

Barak Lenz, CTO ของ AI21Labs กล่าวว่า “ที่ AI21 เราทำงานอย่างต่อเนื่องเพื่อปรับปรุงประสิทธิภาพและประสิทธิภาพของโมเดลภาษา Mamba และ Jamba ในฐานะผู้ใช้ TPU v4 ในระยะยาว เราประทับใจในความสามารถของ Trillium ของ Google Cloud ในระดับ ความเร็ว และต้นทุน การปรับปรุงประสิทธิภาพมีความสำคัญมาก เราเชื่อว่า Trillium จะมีบทบาทสำคัญในการเร่งการพัฒนาโมเดลภาษาที่ซับซ้อนรุ่นต่อไป ช่วยให้เรานำเสนอโซลูชัน AI ที่ทรงพลังและเข้าถึงได้มากขึ้นแก่ลูกค้าของเรา"

ประสิทธิภาพของ Trillium ได้รับการปรับปรุงอย่างมาก และตัวชี้วัดจำนวนมากได้สร้างสถิติใหม่

เมื่อเทียบกับรุ่นก่อนหน้า Trillium ได้ทำการปรับปรุงที่สำคัญในด้าน:

ประสิทธิภาพการฝึกอบรมดีขึ้นมากกว่า 4 เท่า

ปรับปรุงปริมาณการอนุมานให้ดีขึ้น 3 เท่า

ประสิทธิภาพการใช้พลังงานเพิ่มขึ้น 67%

การปรับปรุงประสิทธิภาพการประมวลผลสูงสุดต่อชิปเพิ่มขึ้น 4.7 เท่า

หน่วยความจำแบนด์วิธสูง (HBM) เพิ่มความจุเป็นสองเท่า

Inter-Chip Interconnect (ICI) เพิ่มแบนด์วิธเป็นสองเท่า

สถาปัตยกรรมเครือข่ายดาวพฤหัสบดีเดียวประกอบด้วยชิป Trillium 100,000 ชิ้น

การปรับปรุงประสิทธิภาพการฝึกอบรม 2.5 เท่าต่อดอลลาร์ และการปรับปรุงประสิทธิภาพการอนุมาน 1.4 เท่าต่อดอลลาร์

การปรับปรุงเหล่านี้ช่วยให้ Trillium ทำงานได้ดีกับเวิร์กโหลด AI ที่หลากหลาย รวมถึง:

ปรับขนาดปริมาณงานการฝึกอบรม AI

ฝึก LLM รวมถึงโมเดลหนาแน่นและโมเดล Mixed Expert (MoE)

ประสิทธิภาพการอนุมานและการกำหนดเวลาโดยรวม

การฝังโมเดลที่มีความหนาแน่นสูง

ให้การฝึกอบรมและการอนุมานที่คุ้มค่า

Trillium ทำงานอย่างไรกับปริมาณงานที่แตกต่างกัน

ปรับขนาดปริมาณงานการฝึกอบรม AI

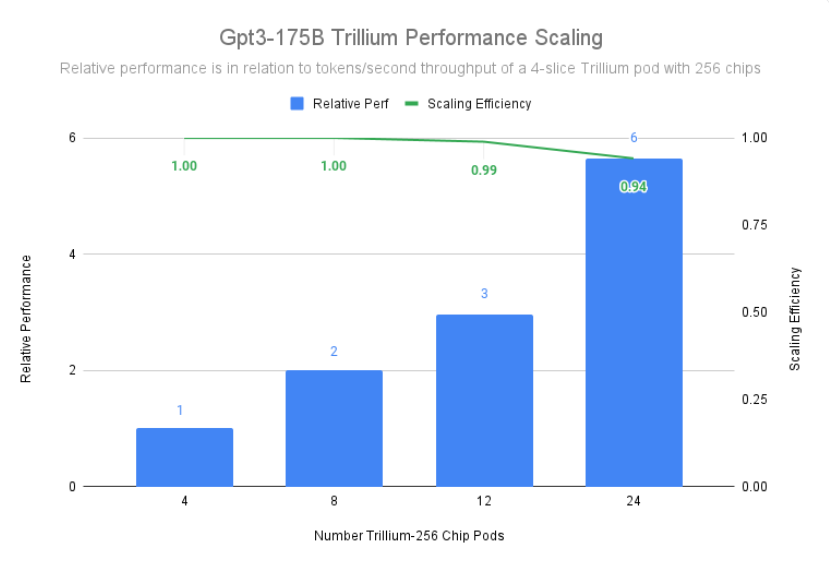

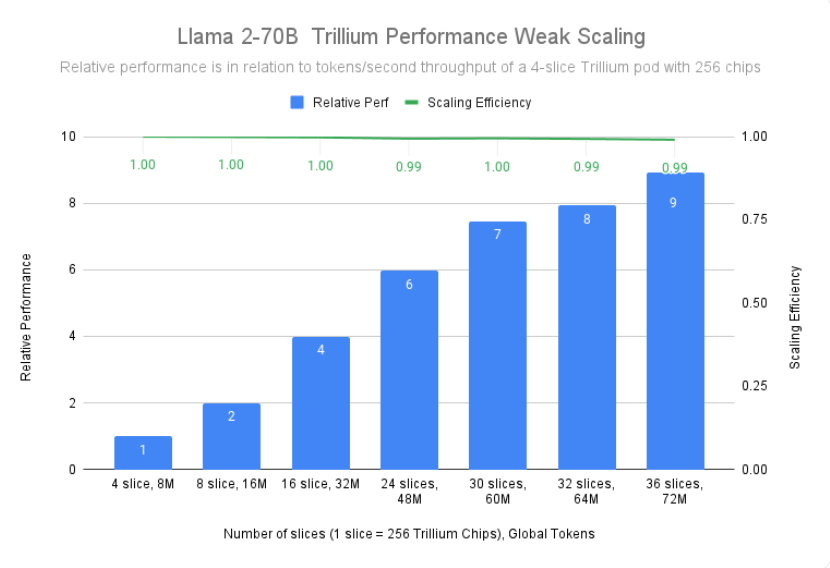

การฝึกโมเดลขนาดใหญ่อย่าง Gemini2.0 ต้องใช้ข้อมูลและการคำนวณจำนวนมาก ความสามารถในการขยายขนาดแบบใกล้เชิงเส้นของ Trillium ช่วยให้โมเดลเหล่านี้ได้รับการฝึกฝนเร็วขึ้นอย่างมาก โดยการกระจายปริมาณงานอย่างมีประสิทธิภาพและประสิทธิผลไปยังโฮสต์ Trillium หลายแห่ง เชื่อมต่อกันผ่านการเชื่อมต่อระหว่างกันแบบชิปต่อชิปความเร็วสูงในพ็อด 256 ชิปและนวัตกรรมล้ำสมัยของเราใน เครือข่ายศูนย์ข้อมูลจูปิเตอร์ ซึ่งสามารถทำได้ผ่านเทคโนโลยีฟูลสแตกแบบหลายชิป TPU สำหรับการฝึกอบรมขนาดใหญ่ และได้รับการปรับปรุงเพิ่มเติมผ่าน Titanium ซึ่งเป็นระบบออฟโหลดระดับศูนย์ข้อมูลแบบไดนามิกที่มีตั้งแต่อะแดปเตอร์โฮสต์ไปจนถึงสถาปัตยกรรมเครือข่าย

Trillium บรรลุประสิทธิภาพในการปรับขนาด 99% ในการปรับใช้ 12 พ็อดด้วยชิป 3072 และสาธิตประสิทธิภาพการปรับขนาด 94% ใน 24 พ็อดด้วยชิป 6144 เพื่อฝึก gpt3-175b ล่วงหน้า แม้จะเป็นแบบเดียวกันเมื่อทำงานผ่านเครือข่ายศูนย์ข้อมูลก็ตาม

ฝึก LLM รวมถึงโมเดลหนาแน่นและโมเดล Mixed Expert (MoE)

LLM เช่น Gemini นั้นทรงพลังและซับซ้อนโดยธรรมชาติ โดยมีพารามิเตอร์นับพันล้านรายการ การฝึกอบรม LLM ที่เข้มข้นเช่นนี้ต้องใช้พลังการประมวลผลจำนวนมหาศาลรวมถึงการเพิ่มประสิทธิภาพซอฟต์แวร์ที่ออกแบบร่วมกัน Trillium เร็วกว่า Cloud TPU v5e รุ่นก่อนถึง 4 เท่า เมื่อฝึก LLM ที่เข้มข้น เช่น Llama-2-70b และ gpt3-175b

นอกเหนือจาก LLM แบบเข้มข้นแล้ว แนวทางที่ได้รับความนิยมมากขึ้นเรื่อยๆ ก็คือการฝึกอบรม LLM โดยใช้สถาปัตยกรรมแบบผู้เชี่ยวชาญแบบผสม (MoE) ซึ่งรวมโครงข่ายประสาทเทียม “ผู้เชี่ยวชาญ” หลายตัวเข้าด้วยกัน โดยแต่ละโครงมีความเชี่ยวชาญในด้านต่างๆ ของงาน AI การจัดการและการประสานงานผู้เชี่ยวชาญเหล่านี้ในระหว่างการฝึกอบรมเพิ่มความซับซ้อนเมื่อเทียบกับการฝึกอบรมแบบจำลองเสาหินเดียว Trillium เร็วกว่า Cloud TPU v5e รุ่นก่อนหน้า 3.8 เท่า เมื่อฝึกฝนโมเดล MoE

นอกจากนี้ Trillium TPU ยังมอบหน่วยความจำเข้าถึงโดยสุ่มแบบไดนามิก (DRAM) ของโฮสต์ถึง 3 เท่า เมื่อเทียบกับ Cloud TPU v5e ซึ่งจะช่วยลดการคำนวณบางส่วนไปยังโฮสต์ ซึ่งช่วยเพิ่มประสิทธิภาพในสเกลใหญ่และทรูพุตที่ดีให้สูงสุด คุณลักษณะการถ่ายโฮสต์ของ Trillium ช่วยให้การใช้งานโมเดล FLOP (MFU) มีประสิทธิภาพดีขึ้นกว่า 50% เมื่อฝึกโมเดล Llama-3.1-405B

ประสิทธิภาพการอนุมานและการกำหนดเวลาโดยรวม

ความสำคัญที่เพิ่มขึ้นของการอนุมานแบบหลายขั้นตอนต้องใช้ตัวเร่งความเร็วที่สามารถรองรับความต้องการในการคำนวณที่เพิ่มขึ้นได้อย่างมีประสิทธิภาพ Trillium มอบความก้าวหน้าที่สำคัญสำหรับปริมาณงานการอนุมาน ช่วยให้ปรับใช้โมเดล AI ได้เร็วและมีประสิทธิภาพยิ่งขึ้น ในความเป็นจริง Trillium มอบประสิทธิภาพการอนุมาน TPU ที่ดีที่สุดสำหรับการแพร่กระจายภาพและ LLM ที่หนาแน่น การทดสอบของเราแสดงให้เห็นว่า Stable Diffusion XL มีปริมาณการประมวลผลการอนุมานสัมพัทธ์ (ภาพต่อวินาที) สูงกว่า Cloud TPU v5e มากกว่า 3 เท่า ในขณะที่ Llama2-70B มีเกือบ 2 เท่า

Trillium เป็น TPU ที่มีประสิทธิภาพสูงสุดสำหรับกรณีใช้งานแบบออฟไลน์และการอนุมานเซิร์ฟเวอร์ รูปด้านล่างแสดงให้เห็นว่าเมื่อเทียบกับ Cloud TPU v5e แล้ว อัตราการประมวลผลสัมพัทธ์ของ Stable Diffusion XL (ภาพต่อวินาที) สำหรับการอนุมานแบบออฟไลน์จะสูงกว่า 3.1 เท่า และปริมาณการประมวลผลสัมพัทธ์สำหรับการอนุมานเซิร์ฟเวอร์จะสูงกว่า 2.9 เท่า

นอกจากประสิทธิภาพที่ดีขึ้นแล้ว Trillium ยังแนะนำความสามารถในการจัดกำหนดการแบบรวมใหม่อีกด้วย ฟีเจอร์นี้ช่วยให้ระบบการกำหนดเวลาของ Google ตัดสินใจกำหนดเวลางานได้อย่างชาญฉลาด เพื่อปรับปรุงความพร้อมใช้งานโดยรวมและประสิทธิภาพของปริมาณงานการอนุมานเมื่อมีการจำลองหลายรายการในคอลเลกชัน โดยมีวิธีจัดการชิ้นส่วน TPU หลายชิ้นที่ใช้ภาระงานการอนุมานโฮสต์เดียวหรือหลายโฮสต์ รวมถึงผ่าน Google Kubernetes Engine (GKE) การจัดกลุ่มชิ้นส่วนเหล่านี้เป็นคอลเลกชันทำให้ง่ายต่อการปรับจำนวนแบบจำลองให้ตรงกับความต้องการ

การฝังโมเดลที่มีความหนาแน่นสูง

ด้วยการเพิ่ม SparseCore รุ่นที่สาม Trillium ปรับปรุงประสิทธิภาพของโมเดลที่เน้นการฝังได้ 2 เท่า และ DLRM DCNv2 ขึ้น 5 เท่า

SparseCore คือตัวประมวลผลกระแสข้อมูลที่ให้รากฐานทางสถาปัตยกรรมที่ปรับเปลี่ยนได้มากขึ้นสำหรับเวิร์กโหลดแบบฝังตัวจำนวนมาก SparseCore รุ่นที่สามของ Trillium มีความเป็นเลิศในการเร่งการดำเนินการแบบไดนามิกและที่เกี่ยวข้องกับข้อมูล เช่น การรวบรวมแบบกระจาย ผลรวมแบบกระจาย และการแบ่งพาร์ติชัน

ให้การฝึกอบรมและการอนุมานที่คุ้มค่า

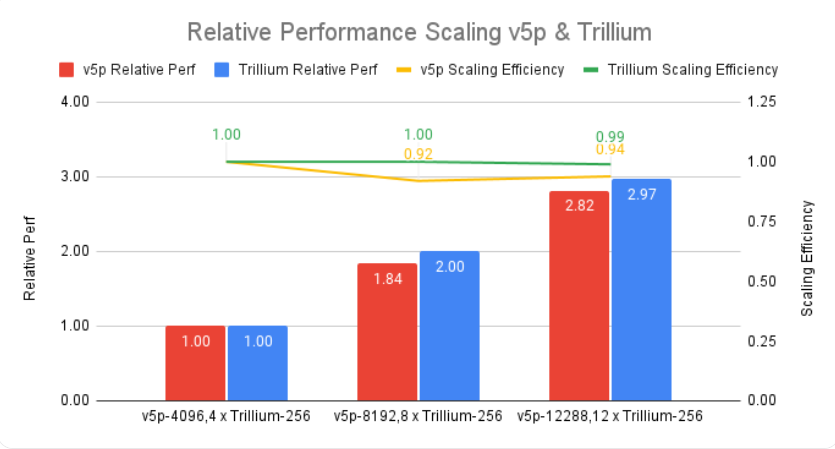

นอกเหนือจากประสิทธิภาพและขนาดที่จำเป็นในการฝึกอบรมปริมาณงาน AI ที่ใหญ่ที่สุดในโลกแล้ว Trillium ยังได้รับการออกแบบมาเพื่อเพิ่มประสิทธิภาพต่อดอลลาร์อีกด้วย จนถึงปัจจุบัน Trillium ได้รับประสิทธิภาพที่ดีขึ้นต่อดอลลาร์ถึง 2.1 เท่าเมื่อเทียบกับ Cloud TPU v5e และดีกว่า Cloud TPU v5p ถึง 2.5 เท่า เมื่อฝึกฝน LLM ที่เข้มข้น เช่น Llama2-70b และ Llama3.1-405b

Trillium เป็นเลิศในการประมวลผลโมเดลขนาดใหญ่ควบคู่กันไปอย่างคุ้มค่า ได้รับการออกแบบมาเพื่อให้นักวิจัยและนักพัฒนาสามารถส่งมอบโมเดลภาพที่ทรงพลังและมีประสิทธิภาพด้วยต้นทุนที่ต่ำกว่าเมื่อก่อนมาก ต้นทุนในการสร้างรูปภาพนับพันภาพบน Trillium ต่ำกว่า Cloud TPU v5e สำหรับการอนุมานแบบออฟไลน์ 27% และต่ำกว่า Cloud TPU v5e สำหรับการอนุมานเซิร์ฟเวอร์บน SDXL 22%

ยกระดับนวัตกรรม AI ไปอีกระดับ

Trillium แสดงถึงการก้าวกระโดดครั้งใหญ่ในโครงสร้างพื้นฐาน Google Cloud AI โดยมอบประสิทธิภาพ ความสามารถในการปรับขนาด และประสิทธิภาพอันน่าทึ่งสำหรับปริมาณงาน AI ที่หลากหลาย ด้วยความสามารถในการขยายขนาดชิปนับแสนโดยใช้ซอฟต์แวร์การออกแบบร่วมระดับโลก Trillium ช่วยให้คุณบรรลุความก้าวหน้าที่รวดเร็วยิ่งขึ้นและส่งมอบโซลูชัน AI ที่เหนือกว่า นอกจากนี้ ราคา/ประสิทธิภาพที่ยอดเยี่ยมของ Trillium ทำให้ Trillium เป็นตัวเลือกที่คุ้มค่าสำหรับองค์กรที่ต้องการเพิ่มมูลค่าสูงสุดให้กับการลงทุน AI ของตน ในขณะที่ภูมิทัศน์ AI ยังคงพัฒนาต่อไป Trillium แสดงให้เห็นถึงความมุ่งมั่นของ Google Cloud ในการจัดหาโครงสร้างพื้นฐานที่ล้ำสมัยเพื่อช่วยให้องค์กรต่างๆ ปลดล็อกศักยภาพของ AI ได้อย่างเต็มที่

ข้อมูลเบื้องต้นอย่างเป็นทางการ: https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga

โดยรวมแล้ว การเกิดขึ้นของ Trillium TPU ถือเป็นการปรับปรุงที่สำคัญในขีดความสามารถด้านการประมวลผล AI บนคลาวด์ ประสิทธิภาพอันทรงพลัง ความสามารถในการปรับขนาด และผลประโยชน์ทางเศรษฐกิจ จะส่งเสริมการพัฒนาที่รวดเร็วยิ่งขึ้นในสาขา AI และมอบโซลูชัน AI ที่ทรงพลังยิ่งขึ้นสำหรับองค์กรและสถาบันการวิจัย