NVILA โมเดลภาษาภาพแบบเปิดล่าสุดของ NVIDIA ประสบความสำเร็จอย่างมากในด้านความแม่นยำและประสิทธิภาพ กลายเป็นอีกก้าวสำคัญในด้าน Visual AI เมื่อเปรียบเทียบกับโมเดลการมองเห็นขนาดใหญ่อื่นๆ NVILA สามารถลดต้นทุนการฝึกอบรม การใช้หน่วยความจำ และเวลาแฝงได้อย่างมาก นอกจากนี้ยังแสดงให้เห็นถึงประสิทธิภาพที่ยอดเยี่ยมในการทดสอบเกณฑ์มาตรฐานหลายรายการ แม้จะเหนือกว่าคู่แข่งบางรายก็ตาม บทความนี้จะแนะนำรายละเอียดทางเทคนิคของ NVILA อย่างละเอียด รวมถึงเทคโนโลยี "ขยายก่อนแล้วบีบอัดทีหลัง" เช่นเดียวกับการขยาย S2 แบบไดนามิก การตัดชุดข้อมูลที่ใช้ DeltaLoss และกลยุทธ์การปรับให้เหมาะสมอื่น ๆ โดยมีเป้าหมายเพื่อสร้างความสมดุลระหว่างความแม่นยำและประสิทธิภาพของโมเดล นี่เป็นการพัฒนาเทคโนโลยีแบบจำลองภาษาภาพไปในทิศทางที่ประหยัดและมีประสิทธิภาพมากขึ้น

ล่าสุด NVIDIA ได้เปิดตัวโมเดลภาษาภาพแบบเปิดรุ่นใหม่ - NVILA ออกแบบมาเพื่อปรับความแม่นยำและประสิทธิภาพให้เหมาะสม ทำให้กลายเป็นผู้นำในด้าน Visual AI ด้วยประสิทธิภาพที่โดดเด่น

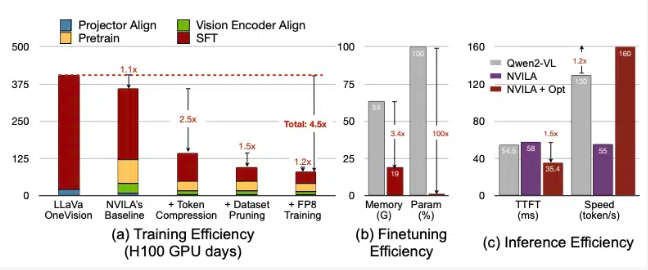

จากข้อมูลของ NVIDIA NVILA ลดต้นทุนการฝึกอบรมได้ 4.5 เท่า ลดหน่วยความจำที่จำเป็นสำหรับการปรับแต่งอย่างละเอียด 3.4 เท่า และลดเวลาแฝงในการกรอกข้อมูลล่วงหน้าและถอดรหัสได้เกือบ 2 เท่า ข้อมูลเหล่านี้จะถูกนำไปเปรียบเทียบกับโมเดลการมองเห็นขนาดใหญ่อื่น LLaVa OneVision

ในการวัดประสิทธิภาพวิดีโอ NVILA มีประสิทธิภาพเหนือกว่า GPT4o Mini และยังทำงานได้ดีเมื่อเปรียบเทียบกับ GPT4o, Sonnet3.5 และ Gemini1.5Pro นอกจากนี้ NVILA ยังได้รับชัยชนะเล็กน้อยเมื่อเปรียบเทียบกับ Llama3.2 อย่างไรก็ตาม NVIDIA ระบุว่าโมเดลดังกล่าวยังไม่ได้เปิดตัวบนแพลตฟอร์ม Hugging Face และพวกเขาสัญญาว่าจะปล่อยโค้ดและโมเดลเร็วๆ นี้เพื่อส่งเสริมความสามารถในการทำซ้ำของโมเดล

NVIDIA ชี้ให้เห็นว่าค่าใช้จ่ายในการฝึกอบรมโมเดลภาษาภาพนั้นสูงมาก ใช้เวลาประมาณ 400 GPU วันในการฝึกโมเดลภาษาภาพด้วยพารามิเตอร์ 7B ในขณะเดียวกัน การปรับแต่งโมเดลดังกล่าวอย่างละเอียดก็ต้องใช้หน่วยความจำมากเช่นกัน โดยโมเดลพารามิเตอร์ 7B ต้องใช้หน่วยความจำ GPU มากกว่า 64GB

ดังนั้น NVIDIA จึงใช้เทคนิคที่เรียกว่าขยายแล้วบีบอัดเพื่อสร้างสมดุลระหว่างความแม่นยำและประสิทธิภาพของโมเดล แทนที่จะลดขนาดรูปภาพและวิดีโอ โมเดลจะใช้หลายเฟรมจากรูปภาพและวิดีโอที่มีความละเอียดสูงเพื่อให้แน่ใจว่าไม่มีรายละเอียดสูญหาย

ในระหว่างกระบวนการบีบอัด โมเดลจะลดขนาดของข้อมูลอินพุตโดยการบีบอัดข้อมูลภาพให้เป็นโทเค็นน้อยลงและจัดกลุ่มพิกเซลเพื่อเก็บข้อมูลที่สำคัญ NVIDIA กล่าวถึงในรายงานว่าการเพิ่มความละเอียดเป็นสองเท่าจะเพิ่มจำนวนโทเค็นภาพเป็นสองเท่า ซึ่งจะเพิ่มค่าใช้จ่ายในการฝึกอบรมและการอนุมานมากกว่า 2 เท่า ดังนั้นพวกเขาจึงลดต้นทุนนี้โดยการบีบอัดโทเค็นพื้นที่/เวลา

NVIDIA ยังแสดงการสาธิตบางรุ่น และ NVILA สามารถตอบคำถามได้หลายข้อตามรูปภาพหรือวิดีโอ ผลลัพธ์เอาต์พุตยังถูกเปรียบเทียบกับรุ่น VILA1.5 ที่ NVIDIA เปิดตัวก่อนหน้านี้ นอกจากนี้ NVIDIA ยังแนะนำเทคโนโลยีอื่นๆ อย่างละเอียด เช่น การขยาย S2 แบบไดนามิก, การตัดชุดข้อมูลแบบ DeltaLoss, การหาปริมาณโดยใช้ความแม่นยำ FP8 เป็นต้น

เทคนิคเหล่านี้ใช้กับโมเดลพารามิเตอร์ 8B และดูรายละเอียดเฉพาะได้บน Arxiv

ทางเข้ากระดาษ: https://arxiv.org/pdf/2412.04468

ไฮไลท์:

? โมเดล NVILA ลดต้นทุนการฝึกอบรมได้ 4.5 เท่า ปรับปรุงประสิทธิภาพของ Visual AI

? ด้วยภาพและเฟรมวิดีโอที่มีความละเอียดสูง NVILA จึงรับประกันความสมบูรณ์ของข้อมูลที่ป้อน

? NVIDIA สัญญาว่าจะปล่อยโค้ดและโมเดลเร็วๆ นี้เพื่อส่งเสริมความสามารถในการทำซ้ำของการวิจัย

โดยรวมแล้ว การเกิดขึ้นของ NVILA ได้นำความเป็นไปได้ใหม่ๆ มาสู่การพัฒนาโมเดลภาษาภาพและกระบวนการอนุมานที่มีประสิทธิภาพจะช่วยลดเกณฑ์สำหรับแอปพลิเคชัน Visual AI และส่งเสริมการพัฒนาเพิ่มเติมในสาขานี้ เราหวังว่าจะเปิดเผยโค้ดและแบบจำลองตั้งแต่เนิ่นๆ ของ NVIDIA เพื่อให้นักวิจัยจำนวนมากขึ้นสามารถมีส่วนร่วมและร่วมกันส่งเสริมความก้าวหน้าของเทคโนโลยี Visual AI