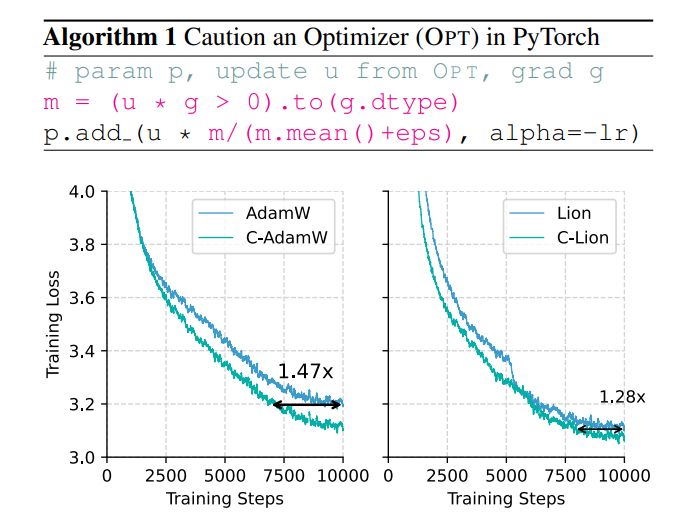

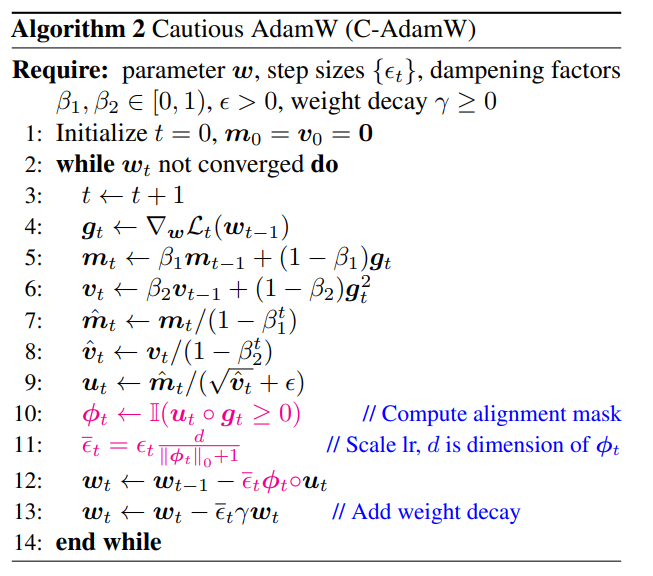

ปัญหาด้านประสิทธิภาพและการใช้พลังงานของการฝึกโมเดลขนาดใหญ่กำลังมีความโดดเด่นมากขึ้นเรื่อยๆ และเครื่องมือเพิ่มประสิทธิภาพ AdamW แบบเดิมไม่สามารถรับมือกับโมเดลขนาดใหญ่ได้ เพื่อแก้ไขปัญหานี้ ทีมงานชาวจีนทั้งหมดได้เสนอเครื่องมือเพิ่มประสิทธิภาพใหม่ที่เรียกว่า C-AdamW (Crudent AdamW) แนวคิดหลักของ C-AdamW คือการ "คิดก่อนดำเนินการ" ด้วยการระบุทิศทางการอัปเดตที่แม่นยำ โมเดลจึงสามารถหลีกเลี่ยงการสิ้นเปลืองทรัพยากรไปในเส้นทางที่ไม่ถูกต้อง จึงช่วยเพิ่มความเร็วในการฝึกอบรมและลดการใช้พลังงาน เครื่องมือเพิ่มประสิทธิภาพนี้ช่วยเพิ่มความเร็วการฝึกได้สูงสุดถึง 1.47 เท่าในการฝึกล่วงหน้าของ Llama และ MAE โดยแทบไม่มีค่าใช้จ่ายในการคำนวณเพิ่มเติม และสามารถทำได้ด้วยการแก้ไขโค้ดที่มีอยู่อย่างง่ายดาย

ในโลกของ AI "ความแข็งแกร่งสามารถนำมาซึ่งปาฏิหาริย์" ดูเหมือนจะเป็นกฎทอง ยิ่งโมเดลมีขนาดใหญ่ ข้อมูลก็ยิ่งมากขึ้น และพลังการประมวลผลที่แข็งแกร่งยิ่งขึ้น ดูเหมือนว่าจะเข้าใกล้จอกศักดิ์สิทธิ์แห่งสติปัญญามากขึ้นเท่านั้น อย่างไรก็ตาม เบื้องหลังการพัฒนาอย่างรวดเร็วนี้ ยังมีแรงกดดันอย่างมากต่อต้นทุนและการใช้พลังงาน

เพื่อให้การฝึกอบรม AI มีประสิทธิภาพมากขึ้น นักวิทยาศาสตร์กำลังมองหาเครื่องมือเพิ่มประสิทธิภาพที่มีประสิทธิภาพมากขึ้น เช่น โค้ช เพื่อเป็นแนวทางในพารามิเตอร์ของแบบจำลองเพื่อเพิ่มประสิทธิภาพอย่างต่อเนื่องและไปถึงสถานะที่ดีที่สุดในที่สุด AdamW ซึ่งเป็นเครื่องมือเพิ่มประสิทธิภาพเริ่มต้นสำหรับการฝึกอบรมล่วงหน้าของ Transformer ถือเป็นมาตรฐานอุตสาหกรรมมาหลายปีแล้ว อย่างไรก็ตาม เมื่อเผชิญกับขนาดของโมเดลที่ใหญ่ขึ้นเรื่อยๆ AdamW ก็เริ่มดูเหมือนจะไม่สามารถรับมือกับข้อจำกัดของมันได้

ไม่มีวิธีใดที่จะเพิ่มความเร็วในการฝึกฝนในขณะที่ลดการใช้พลังงานลงได้ใช่ไหม ไม่ต้องกังวล ทีมชาวจีนล้วนอยู่ที่นี่พร้อมกับ "อาวุธลับ" C-AdamW!

ชื่อเต็มของ C-AdamW คือ Cautious AdamW และชื่อภาษาจีนคือ "Cautious AdamW" ฟังดูเป็น "ชาวพุทธ" ใช่ไหม ใช่แล้ว แนวคิดหลักของ C-AdamW คือ "คิดให้รอบคอบก่อนแสดง"

ลองนึกภาพว่าพารามิเตอร์ของโมเดลเป็นเหมือนกลุ่มเด็กที่กระตือรือร้นซึ่งมักจะอยากวิ่งเล่น AdamW เปรียบเสมือนครูผู้ทุ่มเท ที่พยายามชี้แนะพวกเขาไปในทิศทางที่ถูกต้อง แต่บางครั้งเด็กๆ ก็ตื่นเต้นเกินไปและวิ่งไปผิดทาง ทำให้เสียเวลาและพลังงานไปโดยเปล่าประโยชน์

ในเวลานี้ C-AdamW เปรียบเสมือนผู้อาวุโสที่ฉลาด สวม "ดวงตาที่ลุกเป็นไฟ" ที่สามารถระบุได้อย่างแม่นยำว่าทิศทางการอัปเดตนั้นถูกต้องหรือไม่ หากทิศทางไม่ถูกต้อง C-AdamW จะทำการหยุดรถอย่างเด็ดขาดเพื่อป้องกันไม่ให้โมเดลเดินไปผิดทาง

กลยุทธ์ "ระมัดระวัง" นี้ช่วยให้มั่นใจได้ว่าการอัปเดตแต่ละครั้งสามารถลดฟังก์ชันการสูญเสียได้อย่างมีประสิทธิภาพ ซึ่งจะช่วยเร่งการบรรจบกันของโมเดล ผลการทดลองแสดงให้เห็นว่า C-AdamW เพิ่มความเร็วการฝึกเป็น 1.47 เท่าในการฝึกล่วงหน้า Llama และ MAE!

ที่สำคัญกว่านั้น C-AdamW แทบไม่ต้องเสียค่าใช้จ่ายในการคำนวณเพิ่มเติม และสามารถนำไปใช้ได้ด้วยการแก้ไขโค้ดที่มีอยู่เพียงบรรทัดเดียว ซึ่งหมายความว่านักพัฒนาสามารถใช้ C-AdamW กับการฝึกโมเดลต่างๆ ได้อย่างง่ายดาย และเพลิดเพลินไปกับ "ความเร็วและความหลงใหล"!

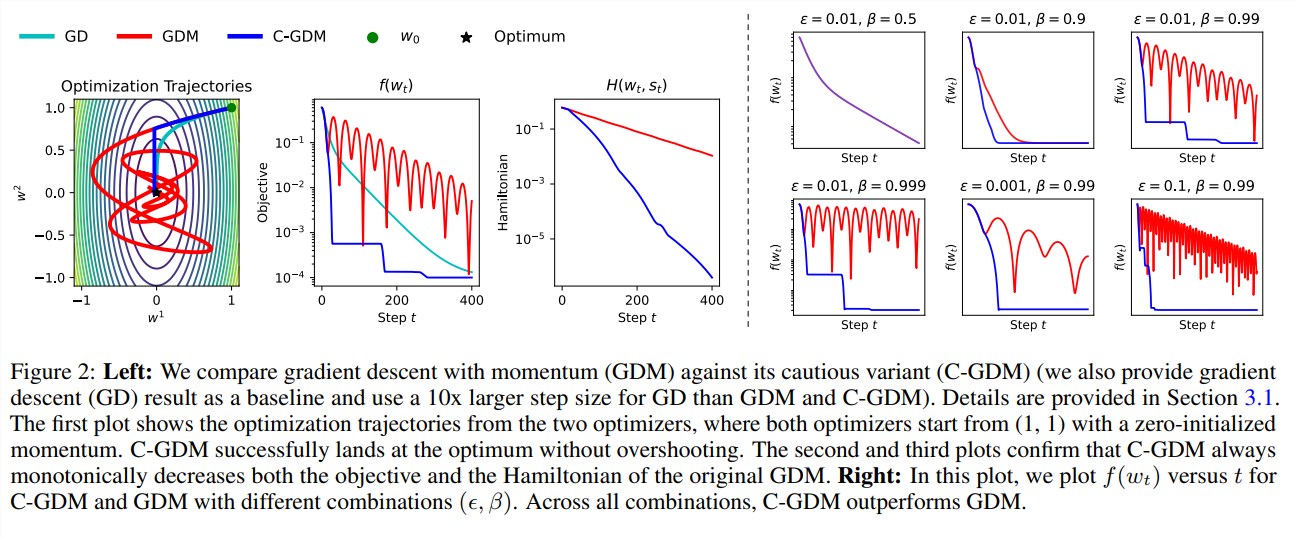

แง่มุม "พุทธ" ของ C-AdamW คือมันยังคงรักษาฟังก์ชันแฮมิลตันของอดัม และไม่ทำลายการรับประกันการลู่เข้าภายใต้การวิเคราะห์ของ Lyapunov ซึ่งหมายความว่า C-AdamW ไม่เพียงแต่เร็วขึ้นเท่านั้น แต่ยังรับประกันความเสถียรด้วย และจะไม่มีปัญหาเช่นการขัดข้องในการฝึก

แน่นอนว่า "พุทธ" ไม่ได้แปลว่า "ไม่ทะเยอทะยาน" ทีมวิจัยระบุว่าพวกเขาจะสำรวจฟังก์ชัน ϕ ที่สมบูรณ์ยิ่งขึ้นต่อไป และใช้มาสก์ในพื้นที่คุณลักษณะ แทนที่จะใช้พื้นที่พารามิเตอร์ เพื่อปรับปรุงประสิทธิภาพของ C-AdamW ต่อไป

คาดการณ์ได้ว่า C-AdamW จะกลายเป็นรายการโปรดใหม่ในด้านการเรียนรู้เชิงลึก โดยนำการเปลี่ยนแปลงที่ปฏิวัติวงการมาสู่การฝึกโมเดลขนาดใหญ่!

ที่อยู่กระดาษ: https://arxiv.org/abs/2411.16085

GitHub:

https://github.com/kyleliang919/C-Optim

การเกิดขึ้นของ C-AdamW ทำให้เกิดแนวทางใหม่ในการแก้ปัญหาด้านประสิทธิภาพและการใช้พลังงานของการฝึกอบรมโมเดลขนาดใหญ่ ประสิทธิภาพสูงและต้นทุนต่ำทำให้มีแนวโน้มการใช้งานในวงกว้าง และคุ้มค่าที่จะรอคอยการพัฒนาในภาคสนาม ของการเรียนรู้เชิงลึกในอนาคต