โมเดลภาษาขนาดใหญ่ (LLM) ประสบความสำเร็จอย่างมากในด้านการประมวลผลภาษาธรรมชาติ แต่การประมวลผลแบบโทเค็นจะจำกัดประสิทธิภาพในการทำความเข้าใจข้อความขนาดยาวและแอปพลิเคชันหลายภาษาและหลายรูปแบบ Large Concept Model (LCM) ที่เสนอโดย Meta AI มอบโซลูชันใหม่ล่าสุดที่ใช้งานหน่วยความหมายเชิงนามธรรม - แนวคิดในพื้นที่ฝังมิติสูง ดังนั้นจึงเอาชนะข้อจำกัดของ LLM นวัตกรรมของ LCM อยู่ที่แนวทางการสร้างแบบจำลองที่ไม่ขึ้นอยู่กับภาษาและกิริยา เช่นเดียวกับสถาปัตยกรรมแบบลำดับชั้นและกลไกการสร้างตามการแพร่กระจาย ซึ่งช่วยให้ LCM บรรลุการสร้างแบบจำลองภาษาที่มีประสิทธิภาพและปรับขนาดได้ พร้อมด้วยความสามารถในการสรุปข้อมูลทั่วไปแบบ Zero-Shot ที่แข็งแกร่ง

โมเดลภาษาขนาดใหญ่ (LLM) มีความก้าวหน้าอย่างมากในด้านการประมวลผลภาษาธรรมชาติ (NLP) ทำให้เป็นที่นิยมในการใช้งาน เช่น การสร้างข้อความ การสรุป และการตอบคำถาม อย่างไรก็ตาม การพึ่งพาการประมวลผลระดับโทเค็นของ LLM (การทำนายทีละคำ) ก็มีความท้าทายเช่นกัน แนวทางนี้แตกต่างกับวิธีที่มนุษย์สื่อสาร ซึ่งโดยทั่วไปจะดำเนินการในระดับนามธรรมที่สูงกว่า เช่น ประโยคหรือแนวคิด

การสร้างแบบจำลองระดับโทเค็นยังขาดงานที่ต้องใช้ความเข้าใจบริบทที่ยาวนานและสามารถสร้างผลลัพธ์ที่ไม่สอดคล้องกัน นอกจากนี้ การขยายโมเดลเหล่านี้ไปยังแอปพลิเคชันหลายภาษาและหลายรูปแบบนั้นมีราคาแพงในการคำนวณและต้องใช้ข้อมูลมาก เพื่อแก้ไขปัญหาเหล่านี้ นักวิจัยจาก Meta AI ได้เสนอวิธีการใหม่: Large Conceptual Model (LCM)

แบบจำลองแนวความคิดขนาดใหญ่: กระบวนทัศน์ใหม่สำหรับการทำความเข้าใจความหมาย

โมเดลแนวความคิดขนาดใหญ่ (LCM) ของ Meta AI แสดงถึงการเปลี่ยนแปลงจากสถาปัตยกรรม LLM แบบดั้งเดิม LCM แนะนำนวัตกรรมหลักสองประการ:

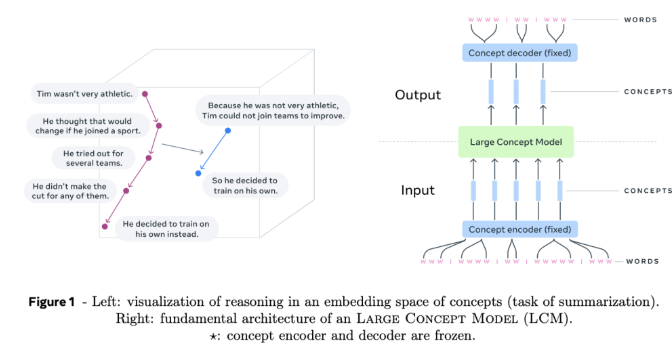

การสร้างแบบจำลองพื้นที่การฝังมิติสูง: LCM จะไม่ทำงานบนโทเค็นแยกอีกต่อไป แต่ทำการคำนวณในพื้นที่การฝังมิติสูง พื้นที่นี้แสดงถึงหน่วยความหมายเชิงนามธรรม ที่เรียกว่าแนวคิด ซึ่งสอดคล้องกับประโยคหรือคำพูด พื้นที่ฝังนี้เรียกว่า SONAR ได้รับการออกแบบมาให้เป็นภาษาและไม่เชื่อเรื่องพระเจ้า โดยรองรับมากกว่า 200 ภาษาและรูปแบบต่างๆ มากมาย รวมถึงข้อความและคำพูด

การสร้างแบบจำลองภาษาและรูปแบบที่ไม่เชื่อเรื่องพระเจ้า: แตกต่างจากแบบจำลองที่เชื่อมโยงกับภาษาหรือรูปแบบเฉพาะ LCM ประมวลผลและสร้างเนื้อหาในระดับความหมายล้วนๆ การออกแบบนี้ช่วยให้สามารถสลับระหว่างภาษาและรูปแบบต่างๆ ได้อย่างราบรื่น ส่งผลให้มีภาพรวมที่ชัดเจนเป็นศูนย์

แกนหลักของ LCM คือตัวเข้ารหัสและตัวถอดรหัสแนวคิดที่จับคู่ประโยคอินพุตกับพื้นที่ฝังของ SONAR และถอดรหัสการฝังกลับไปเป็นภาษาธรรมชาติหรือรูปแบบอื่นๆ ส่วนประกอบเหล่านี้ถูกตรึงไว้ ทำให้มั่นใจได้ถึงความเป็นโมดูลและการขยายไปสู่ภาษาหรือรูปแบบใหม่ๆ ได้ง่าย โดยไม่ต้องฝึกอบรมโมเดลทั้งหมดใหม่

รายละเอียดทางเทคนิคและข้อดีของ LCM

LCM แนะนำนวัตกรรมหลายอย่างเพื่อพัฒนาการสร้างแบบจำลองภาษา:

สถาปัตยกรรมแบบเลเยอร์: LCM ใช้โครงสร้างแบบเลเยอร์ที่สะท้อนกระบวนการให้เหตุผลของมนุษย์ การออกแบบนี้ปรับปรุงการเชื่อมโยงกันสำหรับเนื้อหาที่มีรูปแบบยาว และช่วยให้สามารถแก้ไขเฉพาะที่โดยไม่ทำลายบริบทที่กว้างขึ้น

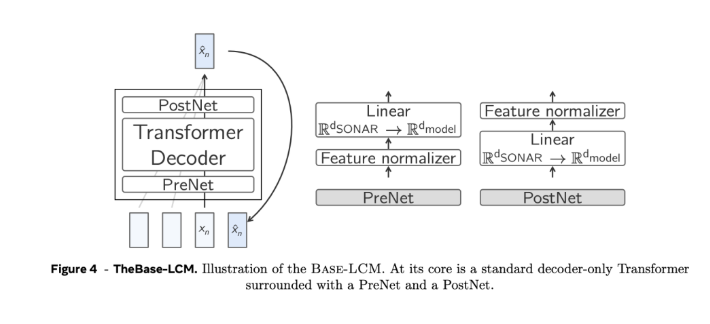

การสร้างตามการแพร่กระจาย: แบบจำลองการแพร่กระจายถือเป็นการออกแบบ LCM ที่มีประสิทธิภาพมากที่สุด โมเดลเหล่านี้ทำนายการฝัง SONAR ครั้งถัดไปโดยอิงจากการฝังครั้งก่อน มีการสำรวจสถาปัตยกรรมสองแบบ:

หอคอยเดี่ยว: ตัวถอดรหัส Transformer ตัวเดียวจัดการการเข้ารหัสบริบทและการลดสัญญาณรบกวน

Twin Towers: แยกการเข้ารหัสบริบทและการลดสัญญาณรบกวน โดยจัดเตรียมส่วนประกอบเฉพาะสำหรับแต่ละงาน

ความสามารถในการปรับขนาดและประสิทธิภาพ: เมื่อเปรียบเทียบกับการประมวลผลระดับโทเค็น การสร้างแบบจำลองระดับแนวคิดจะช่วยลดความยาวของลำดับ แก้ไขความซับซ้อนกำลังสองของ Transformers มาตรฐาน และสามารถรองรับบริบทที่ยาวได้อย่างมีประสิทธิภาพมากขึ้น

การวางนัยทั่วไปแบบ Zero-shot: LCM แสดงความสามารถในการสรุปทั่วไปแบบ Zero-shot ที่แข็งแกร่งในภาษาและรูปแบบที่มองไม่เห็น โดยใช้ประโยชน์จากการสนับสนุนหลายภาษาและหลายรูปแบบที่กว้างขวางของ SONAR

เกณฑ์การค้นหาและการหยุด: อัลกอริธึมการค้นหาพร้อมเกณฑ์การหยุดตามระยะห่างจากแนวคิด "จุดสิ้นสุดของเอกสาร" ทำให้มั่นใจได้ว่าการสร้างมีความสอดคล้องและสมบูรณ์โดยไม่จำเป็นต้องปรับแต่งอย่างละเอียด

โดยรวมแล้ว โมเดลแนวคิดขนาดใหญ่ (LCM) ของ Meta AI นำแนวคิดใหม่ๆ มาสู่การประมวลผลภาษาธรรมชาติ ข้อดีของมันในการประมวลผลข้อมูลข้อความขนาดยาว หลายภาษา และหลายรูปแบบ บ่งบอกถึงทิศทางที่สำคัญสำหรับการพัฒนาแบบจำลองภาษาในอนาคต . การเกิดขึ้นของ LCM จะช่วยเพิ่มขีดความสามารถของปัญญาประดิษฐ์ในการประมวลผลข้อมูลข้ามภาษาและข้ามโมดัลอย่างมีนัยสำคัญ และขยายการใช้งานในสาขาอื่นๆ มากขึ้น