ความก้าวหน้าในโมเดลปัญญาประดิษฐ์ได้นำมาซึ่งพลังการประมวลผลที่ไม่เคยมีมาก่อน แต่ยังนำมาซึ่งการใช้พลังงานมหาศาลและปัญหาสิ่งแวดล้อมอีกด้วย การใช้พลังงานของโมเดล AI o3 ล่าสุดของ OpenAI และผลกระทบต่อสิ่งแวดล้อมดึงดูดความสนใจและการอภิปรายอย่างกว้างขวาง บทความนี้จะวิเคราะห์การใช้พลังงาน การปล่อยก๊าซคาร์บอน และผลกระทบต่อสิ่งแวดล้อมของแบบจำลอง o3 และสำรวจมุมมองและกลยุทธ์การตอบสนองของผู้เชี่ยวชาญและนักวิชาการในสาขาที่เกี่ยวข้องในประเด็นนี้

ในขณะที่ปัญญาประดิษฐ์ก้าวหน้าอย่างต่อเนื่อง ความสมดุลระหว่างนวัตกรรมและความยั่งยืนจึงกลายเป็นความท้าทายที่สำคัญ เมื่อเร็วๆ นี้ OpenAI ได้เปิดตัวโมเดล AI ล่าสุด o3 ซึ่งเป็นโมเดลที่ทรงพลังที่สุดในปัจจุบัน อย่างไรก็ตาม นอกเหนือจากค่าใช้จ่ายในการใช้งานโมเดลเหล่านี้แล้ว ผลกระทบต่อสิ่งแวดล้อมยังทำให้เกิดความกังวลอย่างกว้างขวางอีกด้วย

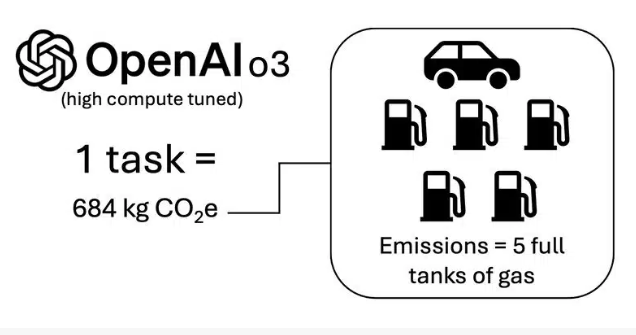

การศึกษาชิ้นหนึ่งแสดงให้เห็นว่างาน O3 แต่ละงานใช้ไฟฟ้าประมาณ 1,785 กิโลวัตต์ชั่วโมง ซึ่งเทียบเท่ากับการใช้ไฟฟ้าของครัวเรือนอเมริกันโดยเฉลี่ยในสองเดือน ตามการวิเคราะห์โดย Boris Gamazaychikov หัวหน้าฝ่ายความยั่งยืนของ AI ของ Salesforce ปริมาณการใช้ไฟฟ้านี้สอดคล้องกับการปล่อยก๊าซคาร์บอนไดออกไซด์เทียบเท่าประมาณ 684 กิโลกรัม ซึ่งเทียบเท่ากับการปล่อยก๊าซคาร์บอนของน้ำมันเบนซินเต็มถังห้าถัง

o3 เวอร์ชันที่มีการประมวลผลสูงได้รับการเปรียบเทียบภายใต้เฟรมเวิร์ก ARC-AGI และการคำนวณจะขึ้นอยู่กับการใช้พลังงาน GPU มาตรฐานและปัจจัยการปล่อยกริด “ในขณะที่เทคโนโลยียังคงขยายตัวและบูรณาการ เราจำเป็นต้องให้ความสำคัญกับการแลกเปลี่ยนเหล่านี้มากขึ้น” Gamazaychikov กล่าว นอกจากนี้เขายังกล่าวอีกว่าการคำนวณนี้ไม่ได้คำนึงถึงคาร์บอนที่เป็นตัวเป็นตนและมุ่งเน้นไปที่การใช้พลังงานของ GPU เท่านั้น ดังนั้น การปล่อยก๊าซเรือนกระจกที่เกิดขึ้นจริงอาจมีการประเมินต่ำเกินไป

นอกจากนี้ นักวิทยาศาสตร์ข้อมูล Kasper Groes Albin Ludvigsen กล่าวว่าการใช้พลังงานของเซิร์ฟเวอร์ HGX ที่ติดตั้งกราฟิกการ์ด Nvidia H100 แปดตัวอยู่ระหว่าง 11 ถึง 12 กิโลวัตต์ ซึ่งเกิน 0.7 กิโลวัตต์ต่อกราฟิกการ์ดมาก

ในแง่ของคำจำกัดความของงาน Pierre-Carl Langlais ผู้ร่วมก่อตั้ง Pleias ได้หยิบยกข้อกังวลเกี่ยวกับการออกแบบแบบจำลอง โดยเฉพาะอย่างยิ่งหากการออกแบบแบบจำลองไม่สามารถลดขนาดลงได้อย่างรวดเร็ว “มีการร่าง การทดสอบระดับกลาง และการให้เหตุผลจำนวนมากที่จำเป็นในการแก้ปัญหาคณิตศาสตร์ที่ซับซ้อน” เขากล่าว

เมื่อต้นปีที่ผ่านมา ผลการวิจัยพบว่า ChatGPT ใช้น้ำ 10% ของปริมาณน้ำที่มนุษย์ได้รับโดยเฉลี่ยต่อวันในระหว่างการสนทนาครั้งเดียว ซึ่งคิดเป็นน้ำเกือบครึ่งลิตร แม้ว่าตัวเลขนี้อาจดูไม่มากนัก แต่เมื่อผู้คนนับล้านใช้แชทบอทนี้ทุกวัน ปริมาณการใช้น้ำทั้งหมดก็มีความสำคัญ

Kathy Baxter หัวหน้าสถาปนิกด้านเทคโนโลยีปัญญาประดิษฐ์ที่ Salesforce เตือนว่าความก้าวหน้าของ AI เช่น โมเดล o3 ของ OpenAI อาจประสบปัญหาจากความขัดแย้งของ Jevons “แม้ว่าพลังงานที่ต้องการอาจลดลง แต่ปริมาณการใช้น้ำก็อาจเพิ่มขึ้น” เธอกล่าว

เพื่อตอบสนองต่อความท้าทายที่ศูนย์ข้อมูล AI ต้องเผชิญ เช่น การใช้พลังงานสูง ข้อกำหนดการระบายความร้อนที่ซับซ้อน และโครงสร้างพื้นฐานทางกายภาพขนาดใหญ่ บริษัทต่างๆ เช่น Synaptics และ embedUR กำลังพยายามแก้ไขปัญหาเหล่านี้ผ่าน Edge AI เพื่อลดการพึ่งพาศูนย์ข้อมูล ลดเวลาแฝง และการบริโภคประสิทธิภาพทำให้สามารถตัดสินใจแบบเรียลไทม์ในระดับอุปกรณ์ได้

ไฮไลท์:

การใช้พลังงานของแต่ละงาน o3 เท่ากับปริมาณการใช้ไฟฟ้าในครัวเรือนสองเดือน

แต่ละภารกิจปล่อยก๊าซคาร์บอนไดออกไซด์มากเท่ากับน้ำมันเบนซินเต็มห้าถัง

ปริมาณน้ำที่ใช้ในการสนทนา ChatGPT สูงถึง 10% ของปริมาณน้ำดื่มโดยเฉลี่ยของมนุษย์ในแต่ละวัน

โดยรวมแล้ว การใช้พลังงานที่สูงและผลกระทบต่อสิ่งแวดล้อมของโมเดล AI ไม่สามารถละเลยได้ เราจำเป็นต้องสำรวจเส้นทางการพัฒนา AI ที่เป็นมิตรกับสิ่งแวดล้อมและยั่งยืนมากขึ้นในขณะเดียวกันก็ดำเนินการตามความก้าวหน้าทางเทคโนโลยี และสร้างสมดุลระหว่างความสัมพันธ์ระหว่างนวัตกรรมและการปกป้องสิ่งแวดล้อม เพื่อให้บรรลุการพัฒนาปัญญาประดิษฐ์ที่ยั่งยืน