NVIDIA เปิดตัว GB300 และ B300 GPU อย่างรวดเร็ว โดยได้รับการปรับปรุงประสิทธิภาพที่สำคัญเพียงครึ่งปีหลังจากการเปิดตัว GB200 และ B200 โดยเฉพาะในโมเดลอนุมาน นี่ไม่ใช่แค่การอัพเกรดฮาร์ดแวร์ธรรมดาเท่านั้น แต่ยังแสดงให้เห็นถึงการปรับเลย์เอาต์เชิงกลยุทธ์ของ NVIDIA ในด้านของการเร่งความเร็ว AI ซึ่งจะมีผลกระทบอย่างมากต่ออุตสาหกรรม แกนหลักของการอัพเกรดนี้อยู่ที่การก้าวกระโดดครั้งใหญ่ในด้านประสิทธิภาพการอนุมาน เช่นเดียวกับการปรับหน่วยความจำและสถาปัตยกรรมให้เหมาะสม ซึ่งจะส่งผลโดยตรงต่อประสิทธิภาพและต้นทุนของโมเดลภาษาขนาดใหญ่

เพียง 6 เดือนหลังจากการเปิดตัว GB200 และ B200 ทาง Nvidia ก็ได้เปิดตัว GPUs-GB300 และ B300 ใหม่อีกครั้ง นี่อาจดูเหมือนเป็นการอัปเกรดเล็กน้อย แต่จริงๆ แล้วมีการเปลี่ยนแปลงครั้งใหญ่ โดยเฉพาะอย่างยิ่งการปรับปรุงประสิทธิภาพของโมเดลการอนุมานอย่างมีนัยสำคัญ ซึ่งจะมีผลกระทบอย่างมากต่อทั้งอุตสาหกรรม

B300/GB300: ประสิทธิภาพการอนุมานที่ก้าวกระโดดครั้งใหญ่

B300GPU ใช้โหนดกระบวนการ 4NP ของ TSMC และได้รับการปรับแต่งมาสำหรับชิปประมวลผล ทำให้ประสิทธิภาพ FLOPS ของ B300 สูงกว่า B200 ถึง 50% การปรับปรุงประสิทธิภาพส่วนหนึ่งมาจากการเพิ่มขึ้นของ TDP TDP ของ GB300 และ B300HGX สูงถึง 1.4KW และ 1.2KW ตามลำดับ (GB200 และ B200 คือ 1.2KW และ 1KW ตามลำดับ) ประสิทธิภาพที่เพิ่มขึ้นที่เหลือมาจากการปรับปรุงสถาปัตยกรรมและการเพิ่มประสิทธิภาพระดับระบบ เช่น การจัดสรรพลังงานแบบไดนามิกระหว่าง CPU และ GPU

นอกเหนือจากการเพิ่มขึ้นของ FLOPS แล้ว หน่วยความจำยังได้รับการอัปเกรดเป็น 12-Hi HBM3E และความจุ HBM ของ GPU แต่ละตัวก็เพิ่มขึ้นเป็น 288GB อย่างไรก็ตาม ความเร็วพินยังคงไม่เปลี่ยนแปลง ดังนั้นแบนด์วิธหน่วยความจำต่อ GPU ยังคงเป็น 8TB/s เป็นที่น่าสังเกตว่า Samsung ล้มเหลวในการเข้าสู่ห่วงโซ่อุปทาน GB200 หรือ GB300

นอกจากนี้ Nvidia ยังได้ปรับราคาอีกด้วย ซึ่งจะส่งผลต่ออัตรากำไรของผลิตภัณฑ์ Blackwell ในระดับหนึ่ง แต่ที่สำคัญกว่านั้น การปรับปรุงประสิทธิภาพของ B300/GB300 จะสะท้อนให้เห็นในรูปแบบการอนุมานเป็นหลัก

เหมาะสำหรับโมเดลการอนุมาน

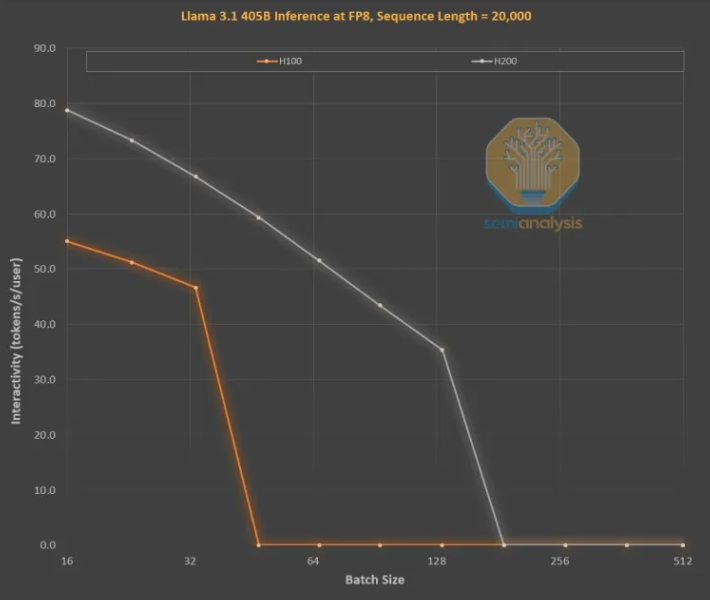

การปรับปรุงหน่วยความจำถือเป็นสิ่งสำคัญสำหรับการฝึกอบรมการอนุมาน LLM แบบ OpenAI O3 เนื่องจากลำดับที่ยาวจะเพิ่ม KVCache ซึ่งจำกัดขนาดแบทช์และเวลาแฝงที่สำคัญ การอัพเกรดจาก H100 เป็น H200 (การเพิ่มหน่วยความจำเป็นหลัก) ได้นำมาซึ่งการปรับปรุงในสองด้านต่อไปนี้:

แบนด์วิธหน่วยความจำที่สูงขึ้น (4.8TB/s บน H200 และ 3.35TB/s บน H100) ส่งผลให้การโต้ตอบโดยรวมดีขึ้น 43% ในทุกขนาดแบตช์ที่เทียบเคียงได้

เนื่องจาก H200 รันขนาดแบตช์ที่ใหญ่กว่า H100 จำนวนโทเค็นที่สร้างขึ้นต่อวินาทีจึงเพิ่มขึ้น 3 เท่า และต้นทุนลดลงประมาณ 3 เท่า ความแตกต่างนี้มีสาเหตุหลักมาจาก KVCache ที่จำกัดขนาดแบตช์ทั้งหมด

การปรับปรุงประสิทธิภาพของความจุหน่วยความจำที่ใหญ่ขึ้นนั้นยิ่งใหญ่มาก ประสิทธิภาพและความแตกต่างทางเศรษฐกิจระหว่าง GPU ทั้งสองนั้นมากกว่าข้อกำหนดที่แนะนำมาก:

ประสบการณ์ผู้ใช้กับโมเดลการอนุมานอาจไม่ดี เนื่องจากมีเวลาแฝงที่สำคัญระหว่างคำขอและการตอบกลับ หากสามารถเร่งเวลาอนุมานได้อย่างมาก ความเต็มใจที่จะใช้และจ่ายเงินของผู้ใช้ก็จะเพิ่มขึ้น

การปรับปรุงประสิทธิภาพฮาร์ดแวร์ 3 เท่าจากการอัพเกรดหน่วยความจำรุ่นกลางนั้นน่าทึ่งและเร็วกว่ากฎของมัวร์ กฎของหวาง หรือการปรับปรุงฮาร์ดแวร์อื่น ๆ ที่เราเคยเห็นมาก

โดยรวมแล้ว การเปิดตัว NVIDIA B300/GB300 ไม่เพียงแต่เป็นการก้าวกระโดดในเทคโนโลยี GPU เท่านั้น แต่ยังเป็นการส่งเสริมการประยุกต์ใช้โมเดลการอนุมาน AI อย่างมาก โดยจะปรับปรุงประสบการณ์ผู้ใช้อย่างมากและลดต้นทุน ซึ่งนำไปสู่อุตสาหกรรม AI เข้าสู่ขั้นตอนใหม่ของการพัฒนา