การฝึกอบรมโมเดล AI ขนาดใหญ่มีค่าใช้จ่ายสูงและความต้องการทรัพยากรจำนวนมากจำกัดการใช้งานอย่างแพร่หลาย และสร้างความกังวลเกี่ยวกับประสิทธิภาพการใช้พลังงานและผลกระทบต่อสิ่งแวดล้อม วิธีการฝึกอบรมแบบดั้งเดิมไม่มีประสิทธิภาพ ต้องอาศัยเมทริกซ์หนาแน่น และต้องใช้หน่วยความจำและพลังการประมวลผลจำนวนมาก แม้ว่าวิธีการที่มีอยู่บางวิธีจะพยายามบรรเทาปัญหาเหล่านี้ แต่ก็ยังมีข้อจำกัดในการใช้งานจริง ดังนั้นจึงจำเป็นอย่างยิ่งที่จะต้องพัฒนาแนวทางที่สามารถลดการใช้หน่วยความจำ ค่าใช้จ่ายในการคำนวณ และเวลาฝึกอบรมไปพร้อมๆ กัน โดยไม่กระทบต่อประสิทธิภาพการทำงาน

การฝึกอบรมโมเดล AI ขนาดใหญ่ (เช่น Transformers และโมเดลภาษา) กลายเป็นส่วนเชื่อมโยงหลักที่ขาดไม่ได้ในสาขา AI แต่ยังต้องเผชิญกับต้นทุนการประมวลผลที่สูง การใช้หน่วยความจำ และความต้องการพลังงานอีกด้วย ตัวอย่างเช่น GPT-3 ของ OpenAI มีพารามิเตอร์ 175 พันล้านพารามิเตอร์ และต้องใช้เวลาฝึกฝน GPU หลายสัปดาห์ ความต้องการทรัพยากรจำนวนมหาศาลนี้จำกัดการประยุกต์ใช้เทคโนโลยีนี้กับองค์กรขนาดใหญ่ที่อุดมไปด้วยทรัพยากรด้านคอมพิวเตอร์ ขณะเดียวกันก็ทำให้ความกังวลเกี่ยวกับประสิทธิภาพการใช้พลังงานและผลกระทบต่อสิ่งแวดล้อมรุนแรงขึ้น การจัดการกับความท้าทายเหล่านี้มีความสำคัญอย่างยิ่งต่อการรับรองการเข้าถึงที่กว้างขึ้นและความยั่งยืนของการพัฒนา AI

วิธีการฝึกอบรมแบบดั้งเดิมนั้นไม่มีประสิทธิภาพและจำเป็นต้องมีการแก้ปัญหาเชิงนวัตกรรมอย่างเร่งด่วน

กรอบงาน CoMERA: การฝึกอบรมที่มีประสิทธิภาพผ่านการเพิ่มประสิทธิภาพเทนเซอร์แบบปรับเปลี่ยนได้

รากฐานของ CoMERA คือการนำเสนอเทนเซอร์แบบปรับเปลี่ยนได้ ซึ่งช่วยให้เลเยอร์โมเดลสามารถปรับอันดับแบบไดนามิกตามข้อจำกัดด้านทรัพยากร ด้วยการปรับเปลี่ยนอันดับเทนเซอร์ เฟรมเวิร์กจึงสามารถบีบอัดได้โดยไม่กระทบต่อความสมบูรณ์ในการปฏิบัติงานของโครงข่ายประสาทเทียม การเพิ่มประสิทธิภาพแบบไดนามิกนี้ทำได้ผ่านกระบวนการฝึกอบรมสองขั้นตอน:

ระยะเริ่มต้น: มุ่งเน้นไปที่การบรรจบกันอย่างมั่นคง

ขั้นตอนต่อมา: ปรับอันดับอย่างละเอียดเพื่อให้บรรลุเป้าหมายการบีบอัดเฉพาะ

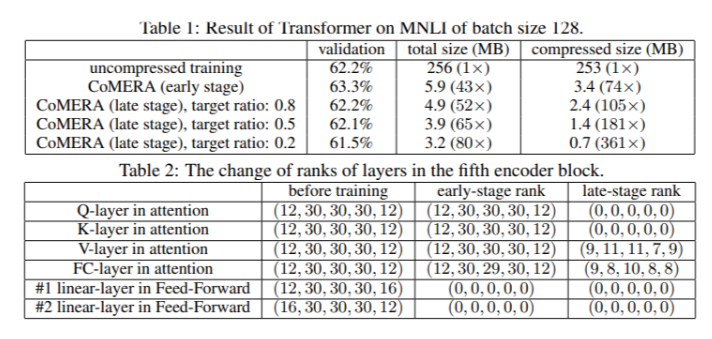

ในรุ่น Transformer หกตัว CoMERA มีอัตราส่วนการบีบอัดสูงถึง 43x ในระยะแรก และอัตราส่วนการบีบอัดที่สูงขึ้นถึง 361x ในขั้นตอนการเพิ่มประสิทธิภาพในภายหลัง นอกจากนี้ยังลดการใช้หน่วยความจำลง 9 เท่า และเพิ่มความเร็วการฝึกต่อรอบได้ 2-3 เท่า เมื่อเทียบกับ GaLore

ผลการทดสอบหลายรายการแสดงให้เห็นว่า CoMERA มีประสิทธิภาพที่ยอดเยี่ยม

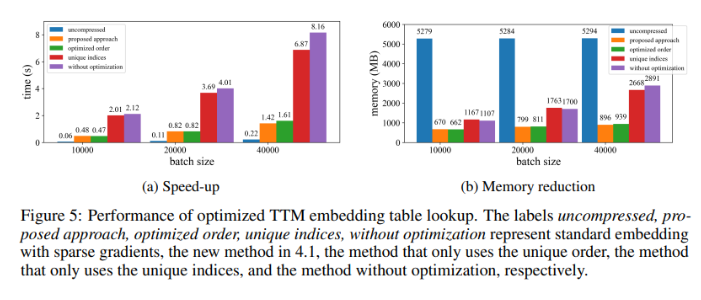

เมื่อนำไปใช้กับโมเดล Transformer ที่ได้รับการฝึกบนชุดข้อมูล MNLI แล้ว CoMERA จะลดขนาดโมเดลจาก 256MB เหลือเพียง 3.2MB ในขณะที่ยังคงความแม่นยำไว้ ในระบบผู้แนะนำขนาดใหญ่ เช่น DLRM นั้น CoMERA บีบอัดโมเดล 99 เท่า และลดการใช้หน่วยความจำสูงสุดลง 7 เท่า เฟรมเวิร์กยังทำงานได้ดีใน CodeBERT ก่อนการฝึกอบรม ซึ่งเป็นโมเดลภาษาขนาดใหญ่เฉพาะโดเมน โดยมีอัตราส่วนการบีบอัดโดยรวมที่ 4.23 เท่า และเร่งความเร็วได้ 2 เท่าในบางขั้นตอนการฝึกอบรม ผลลัพธ์เหล่านี้เน้นย้ำถึงความสามารถในการจัดการงานและสถาปัตยกรรมที่หลากหลาย และขยายความสามารถในการนำไปใช้ในด้านต่างๆ

สรุปคุณประโยชน์ที่สำคัญของกรอบงาน CoMERA

ข้อสรุปหลักของการศึกษาครั้งนี้มีดังนี้:

CoMERA มีอัตราส่วนการบีบอัดสูงถึง 361x สำหรับเลเยอร์เฉพาะ และ 99x สำหรับทั้งรุ่น ซึ่งช่วยลดความต้องการพื้นที่จัดเก็บข้อมูลและหน่วยความจำลงอย่างมาก

เฟรมเวิร์กนี้ช่วยลดระยะเวลาการฝึกอบรมของแต่ละรอบของ Transformer และระบบแนะนำลงได้ 2-3 เท่า ช่วยประหยัดทรัพยากรและเวลาในการประมวลผล

ด้วยการใช้การนำเสนอแบบเทนเซอร์และกราฟ CUDA CoMERA จะลดการใช้หน่วยความจำสูงสุดลง 7 เท่า ทำให้สามารถฝึกฝน GPU ขนาดเล็กลงได้

แนวทางของ CoMERA รองรับสถาปัตยกรรมที่หลากหลาย รวมถึง Transformers และโมเดลภาษาขนาดใหญ่ ในขณะที่ยังคงรักษาหรือปรับปรุงความแม่นยำ

ด้วยการลดพลังงานและทรัพยากรที่จำเป็นสำหรับการฝึกอบรม CoMERA ช่วยให้แนวทางปฏิบัติ AI มีความยั่งยืนมากขึ้น และทำให้ผู้ชมสามารถเข้าถึงโมเดลที่ล้ำสมัยได้กว้างขึ้น

โดยรวมแล้ว เฟรมเวิร์ก CoMERA มอบโซลูชันที่ก้าวล้ำสำหรับการฝึกโมเดล AI ขนาดใหญ่อย่างมีประสิทธิภาพ ซึ่งช่วยลดต้นทุนในการคำนวณและความต้องการหน่วยความจำลงอย่างมาก ด้วยการเพิ่มประสิทธิภาพเทนเซอร์แบบปรับเปลี่ยนได้ ในขณะเดียวกันก็รักษาความแม่นยำของโมเดลไว้ด้วย งานวิจัยนี้มีส่วนสำคัญต่อการพัฒนาอย่างต่อเนื่องและการเข้าถึง AI ในวงกว้างมากขึ้น