ทีมงาน Qwen ได้ใช้โมเดลการให้เหตุผลหลายรูปแบบแบบโอเพ่นซอร์ส QVQ ซึ่งสร้างขึ้นบน Qwen2-VL-72B และปรับปรุงความสามารถในการเข้าใจและการใช้เหตุผลของ AI อย่างเห็นได้ชัด QVQ ได้คะแนนสูงถึง 70.3 ในการทดสอบ MMMU และเหนือกว่ารุ่นก่อนในการวัดประสิทธิภาพทางคณิตศาสตร์หลายรายการ บทความนี้จะแนะนำรายละเอียดเกี่ยวกับคุณลักษณะ ข้อดี ข้อจำกัด และการใช้งานของโมเดล QVQ และให้ลิงก์ที่เกี่ยวข้องเพื่ออำนวยความสะดวกให้ผู้อ่านเข้าใจและใช้งานเพิ่มเติม

เมื่อเร็วๆ นี้ ทีมงาน Qwen ได้ประกาศเปิดตัวโอเพ่นซอร์สของโมเดลการให้เหตุผลหลายรูปแบบล่าสุด QVQ ซึ่งถือเป็นก้าวสำคัญในการทำความเข้าใจภาพของปัญญาประดิษฐ์และความสามารถในการแก้ปัญหาที่ซับซ้อน โมเดลนี้สร้างขึ้นบน Qwen2-VL-72B และมีเป้าหมายเพื่อปรับปรุงความสามารถในการให้เหตุผลของ AI ด้วยการรวมภาษาและข้อมูลภาพเข้าด้วยกัน ในการประเมิน MMMU นั้น QVQ ได้รับคะแนนสูงถึง 70.3 และแสดงให้เห็นการปรับปรุงประสิทธิภาพอย่างมีนัยสำคัญ เมื่อเทียบกับ Qwen2-VL-72B-Instruct ในการทดสอบเกณฑ์มาตรฐานที่เกี่ยวข้องกับคณิตศาสตร์หลายรายการ

โมเดล QVQ ได้แสดงให้เห็นข้อได้เปรียบโดยเฉพาะในงานการให้เหตุผลด้วยภาพ โดยเฉพาะอย่างยิ่งในด้านที่ต้องใช้การคิดเชิงวิเคราะห์ที่ซับซ้อน แม้จะมีประสิทธิภาพที่ยอดเยี่ยมของ QVQ-72B-Preview ทีมงานยังได้ชี้ให้เห็นข้อจำกัดบางประการของโมเดลนี้ รวมถึงปัญหาด้านภาษาและการสลับรหัส ความเป็นไปได้ที่จะตกอยู่ในรูปแบบตรรกะแบบวงกลม การพิจารณาด้านความปลอดภัยและจริยธรรม และข้อจำกัดด้านประสิทธิภาพและเกณฑ์มาตรฐาน ทีมงานเน้นย้ำว่าแม้ว่าแบบจำลองจะได้รับการปรับปรุงในด้านการใช้เหตุผลด้วยภาพ แต่ก็ไม่สามารถแทนที่ความสามารถของ Qwen2-VL-72B ได้อย่างสมบูรณ์ ในระหว่างกระบวนการให้เหตุผลด้วยภาพแบบหลายขั้นตอน แบบจำลองอาจค่อยๆ สูญเสียความสนใจไปที่เนื้อหาภาพ ซึ่งนำไปสู่อาการประสาทหลอน

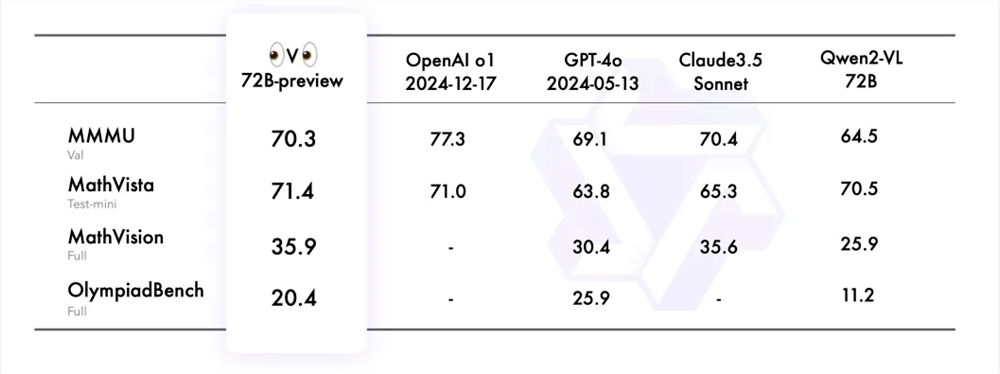

ทีมงาน Qwen ประเมิน QVQ-72B-Preview จากชุดข้อมูล 4 ชุด ได้แก่ MMMU, MathVista, MathVision และ OlympiadBench ชุดข้อมูลเหล่านี้ได้รับการออกแบบมาเพื่อตรวจสอบความเข้าใจที่ครอบคลุมและความสามารถในการให้เหตุผลที่เกี่ยวข้องกับการมองเห็น QVQ-72B-Preview ทำงานได้ดีในการวัดประสิทธิภาพเหล่านี้ ซึ่งปิดช่องว่างกับรุ่นชั้นนำได้อย่างมีประสิทธิภาพ

เพื่อสาธิตการประยุกต์ใช้โมเดล QVQ ในงานการให้เหตุผลเชิงภาพเพิ่มเติม ทีมงาน Qwen ได้จัดเตรียมตัวอย่างหลายตัวอย่างและแบ่งปันลิงก์ไปยังบล็อกทางเทคนิค นอกจากนี้ ทีมงานยังจัดเตรียมตัวอย่างโค้ดสำหรับการอนุมานโมเดลและวิธีใช้ Magic API-Inference เพื่อเรียกโมเดล QVQ-72B-Preview โดยตรง API-Inference ของ Magic Platform ให้การสนับสนุนโมเดล QVQ-72B-Preview และผู้ใช้สามารถใช้โมเดลได้โดยตรงผ่านการเรียก API

ลิงค์รุ่น:

https://modelscope.cn/models/Qwen/QVQ-72B-Preview

ลิงค์ประสบการณ์:

https://modelscope.cn/studios/Qwen/QVQ-72B-preview

บล็อกจีน:

https://qwenlm.github.io/zh/blog/qvq-72b-preview

โอเพ่นซอร์สของโมเดล QVQ มอบทรัพยากรที่มีคุณค่าสำหรับการวิจัยปัญญาประดิษฐ์หลายรูปแบบ และยังถือเป็นการประกาศถึงการพัฒนาเพิ่มเติมของ AI ในด้านการให้เหตุผลด้วยภาพในอนาคต แม้ว่าจะมีข้อจำกัดบางประการ แต่ประสิทธิภาพที่ยอดเยี่ยมในการทดสอบเกณฑ์มาตรฐานหลายรายการยังคงน่าประทับใจ เราหวังว่าจะเพิ่มประสิทธิภาพและการปรับปรุงโมเดล QVQ เพิ่มเติมในอนาคต