เมื่อเร็วๆ นี้ Magic Square Quantitative ได้เปิดตัวโมเดลขนาดใหญ่ DeepSeek-V3 ซึ่งมีสเกลพารามิเตอร์ 671 พันล้านและสถาปัตยกรรม MoE ทำให้ประสิทธิภาพสามารถเทียบได้กับโมเดลโอเพ่นซอร์สชั้นนำ อีกทั้งยังมีคุณลักษณะที่มีต้นทุนต่ำและมีประสิทธิภาพสูง ซึ่งได้รับความสนใจอย่างแพร่หลาย ความสนใจในอุตสาหกรรม DeepSeek-V3 ทำงานได้ดีในการทดสอบหลายๆ รายการ โดยเฉพาะอย่างยิ่งเหนือกว่าโมเดลที่มีอยู่ทั้งหมดในการทดสอบความสามารถทางคณิตศาสตร์ และให้บริการ API ในราคาที่ต่ำกว่าโมเดลอย่าง GPT-4 อย่างมาก ช่วยให้นักพัฒนาและองค์กรต่างๆ ได้รับโซลูชัน AI ที่คุ้มค่า บทความนี้จะวิเคราะห์รายละเอียดเกี่ยวกับประสิทธิภาพ ต้นทุน และกลยุทธ์เชิงพาณิชย์ของ DeepSeek-V3 และหารือถึงผลกระทบที่มีต่ออุตสาหกรรม AI

Magic Square Quantitative เปิดตัว DeepSeek-V3 โมเดลขนาดใหญ่รุ่นใหม่ในตอนเย็นของวันที่ 26 ธันวาคม ซึ่งแสดงให้เห็นถึงความก้าวหน้าทางเทคโนโลยีที่น่าทึ่ง โมเดลนี้ที่ใช้สถาปัตยกรรม MoE (Mixed Experts) ไม่เพียงแต่สามารถเทียบเคียงได้ในด้านประสิทธิภาพกับโมเดลโอเพ่นซอร์สชั้นนำเท่านั้น แต่ฟีเจอร์ที่มีต้นทุนต่ำและมีประสิทธิภาพสูงได้ดึงดูดความสนใจของอุตสาหกรรมอีกด้วย

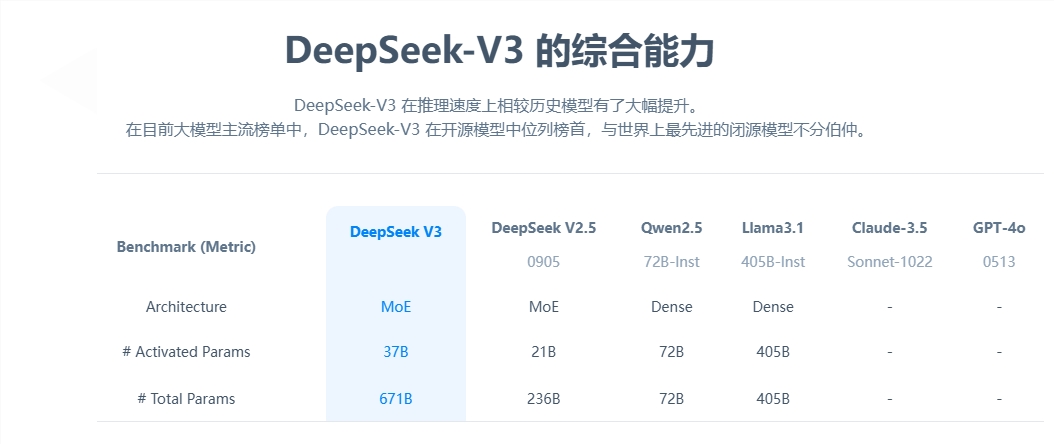

จากมุมมองของพารามิเตอร์หลัก DeepSeek-V3 มีพารามิเตอร์ 671 พันล้านพารามิเตอร์ โดยในจำนวนนี้เป็นพารามิเตอร์การเปิดใช้งาน 37 พันล้านพารามิเตอร์ และได้เสร็จสิ้นการฝึกอบรมล่วงหน้าในระดับข้อมูล 14.8 ล้านล้านโทเค็น เมื่อเทียบกับผลิตภัณฑ์รุ่นก่อนหน้า ความเร็วในการสร้างของรุ่นใหม่เพิ่มขึ้น 3 เท่า และสามารถประมวลผลได้ 60 โทเค็นต่อวินาที ซึ่งช่วยปรับปรุงประสิทธิภาพของการใช้งานจริงได้อย่างมาก

ในแง่ของการประเมินประสิทธิภาพ DeepSeek-V3 แสดงให้เห็นถึงความแข็งแกร่งที่ยอดเยี่ยม ไม่เพียงแต่เหนือกว่ารุ่นโอเพ่นซอร์สที่มีชื่อเสียง เช่น Qwen2.5-72B และ Llama-3.1-405B เท่านั้น แต่ยังเทียบเท่ากับ GPT-4 และ Claude-3.5-Sonnet ในการทดสอบหลายรายการอีกด้วย โดยเฉพาะอย่างยิ่งในการทดสอบความสามารถทางคณิตศาสตร์ โมเดลดังกล่าวมีประสิทธิภาพเหนือกว่าโมเดลโอเพ่นซอร์สและโอเพ่นซอร์สที่มีอยู่ทั้งหมดด้วยผลลัพธ์ที่ยอดเยี่ยม

สิ่งที่โดดเด่นที่สุดคือข้อได้เปรียบที่มีต้นทุนต่ำของ DeepSeek-V3 ตามรายงานโอเพ่นซอร์ส ซึ่งคำนวณที่ 2 เหรียญสหรัฐต่อชั่วโมง GPU ค่าใช้จ่ายในการฝึกอบรมทั้งหมดของโมเดลอยู่ที่ 5.576 ล้านเหรียญสหรัฐเท่านั้น ผลลัพธ์ที่ก้าวล้ำนี้เกิดจากการเพิ่มประสิทธิภาพร่วมกันของอัลกอริธึม เฟรมเวิร์ก และฮาร์ดแวร์ Karpathy ผู้ร่วมก่อตั้ง OpenAI กล่าวถึงสิ่งนี้ โดยชี้ให้เห็นว่า DeepSeek-V3 มีประสิทธิภาพเหนือกว่า Llama3 ในเวลาเพียง 2.8 ล้าน GPU ชั่วโมง และประสิทธิภาพการประมวลผลเพิ่มขึ้นประมาณ 11 เท่า

ในแง่ของการค้า แม้ว่าราคาบริการ API ของ DeepSeek-V3 จะเพิ่มขึ้นเมื่อเทียบกับรุ่นก่อนหน้า แต่ก็ยังรักษาประสิทธิภาพด้านต้นทุนที่สูงไว้ได้ เวอร์ชันใหม่มีราคาอยู่ที่ 0.5-2 หยวนต่อล้านโทเค็นอินพุต และ 8 หยวนต่อล้านโทเค็นเอาท์พุต โดยมีต้นทุนรวมประมาณ 10 หยวน เมื่อเปรียบเทียบกันแล้ว ราคาบริการที่เทียบเท่าของ GPT-4 อยู่ที่ประมาณ 140 หยวน และส่วนต่างราคาก็มีนัยสำคัญ

ในฐานะโมเดลโอเพ่นซอร์สขนาดใหญ่ที่ครอบคลุม การเปิดตัว DeepSeek-V3 ไม่เพียงแต่แสดงให้เห็นถึงความก้าวหน้าของเทคโนโลยี AI ของจีนเท่านั้น แต่ยังช่วยให้นักพัฒนาและองค์กรต่างๆ ได้รับโซลูชัน AI ประสิทธิภาพสูงและราคาประหยัดอีกด้วย

การเกิดขึ้นของ DeepSeek-V3 ถือเป็นความก้าวหน้าครั้งสำคัญในเทคโนโลยี AI ของจีนในด้านโมเดลภาษาขนาดใหญ่ ข้อได้เปรียบด้านต้นทุนที่ต่ำและประสิทธิภาพสูง ทำให้มีการแข่งขันสูงในการใช้งานเชิงพาณิชย์ และการพัฒนาในอนาคตก็คุ้มค่ากับการรอคอย . โอเพ่นซอร์สของโมเดลนี้ยังมีส่วนสนับสนุนทรัพยากรอันมีค่าให้กับชุมชน AI ทั่วโลก และส่งเสริมการแบ่งปันและพัฒนาเทคโนโลยี AI