ความเร็วในการถอดรหัสของรุ่น Transformer ถือเป็นปัญหาคอขวดสำคัญที่จำกัดการใช้งานอยู่เสมอ เมื่อเร็ว ๆ นี้ นักวิจัยจากสถาบันวิทยาศาสตร์และเทคโนโลยีแห่งเกาหลี, LG และ DeepMind ร่วมกันเอาชนะปัญหานี้ พวกเขาเสนอสถาปัตยกรรมใหม่ที่เรียกว่า Block Transformer ซึ่งเพิ่มความเร็วในการถอดรหัสอย่างน่าอัศจรรย์ 10 ถึง 20 เท่า! แกนหลักของการพัฒนาที่ก้าวล้ำนี้อยู่ที่ "การแบ่งส่วน" อันชาญฉลาดของกลไกความสนใจของ Transformer ซึ่งแก้ปัญหาการใช้ GPU ในระดับต่ำใน Transformer แบบดั้งเดิมได้อย่างมีประสิทธิภาพ และลดโอเวอร์เฮดของหน่วยความจำได้อย่างมาก

แม้ว่ารุ่น Transformer จะทรงพลัง แต่ประสิทธิภาพในการถอดรหัสก็เป็นเรื่องที่น่าปวดหัวมาโดยตลอด อย่างไรก็ตาม นักวิจัยจากสถาบันวิทยาศาสตร์และเทคโนโลยีแห่งเกาหลี, LG และ DeepMind ทำให้เราประหลาดใจในครั้งนี้ - พวกเขาเสนอสถาปัตยกรรม Transformer ใหม่ที่เรียกว่า Block Transformer ซึ่งเพิ่มความเร็วในการถอดรหัสโดยตรง 10 ถึง 20 เท่า!

ทำอย่างไร ปรากฎว่าพวกเขา "ตัด" กลไกความสนใจของ Transformer ด้วยวิธีนี้ วิธีการที่ไม่มีประสิทธิภาพของ Transformer ดั้งเดิมในการเข้าถึงแคช KV ส่วนกลางทุกครั้งที่สร้างโทเค็นจึงถูกยกเลิกโดยสิ้นเชิง

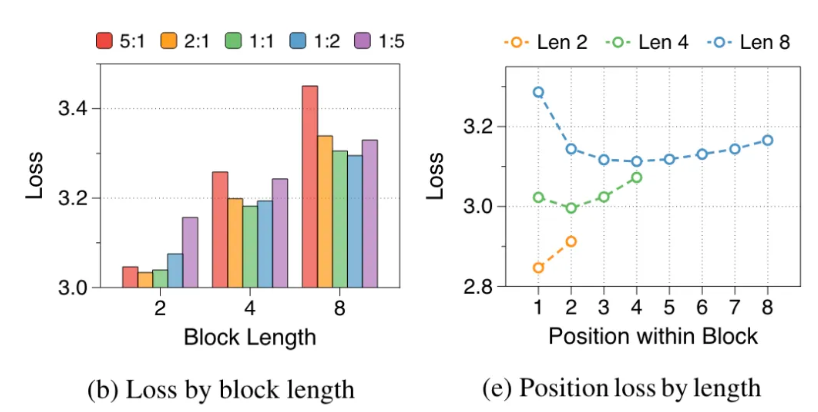

นักวิจัยได้วิเคราะห์ข้อบกพร่องของ Transformer ดั้งเดิม: การใช้งาน GPU อย่างมีประสิทธิภาพน้อยกว่า 1% และ 99% ที่เหลือใช้สำหรับการเข้าถึงหน่วยความจำ เห็นได้ชัดว่านี่ไม่สมเหตุสมผล ดังนั้นพวกเขาจึงเสนอ Block Transformer สถาปัตยกรรมใหม่นี้ใช้การแยกส่วนของความสนใจระดับบล็อกและความสนใจภายในบล็อกเพื่อทำให้ปริมาณงานการให้เหตุผลของแบบจำลองระเบิดโดยตรง

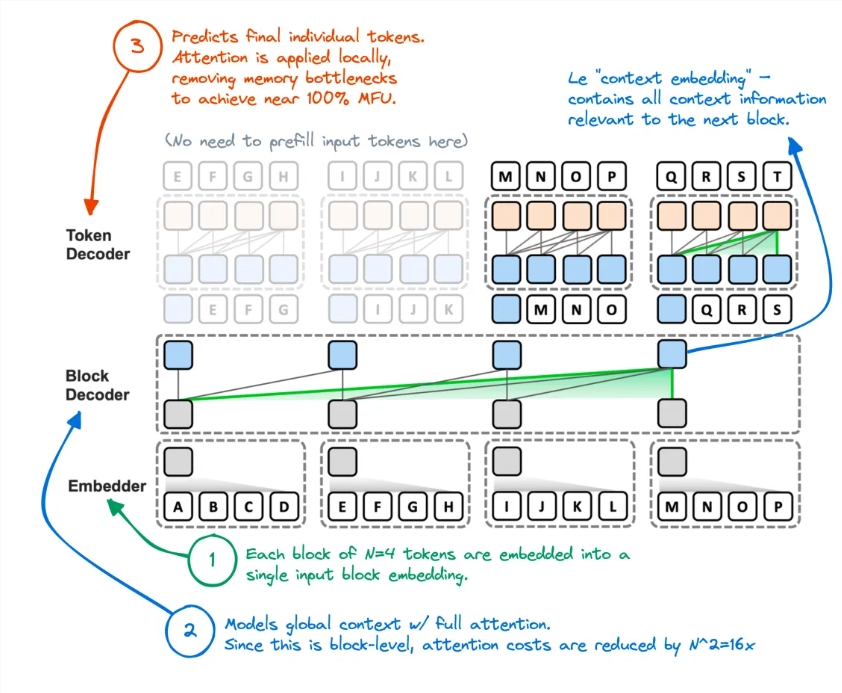

โดยเฉพาะอย่างยิ่ง ขั้นตอนการทำงานของ Block Transformer มีดังนี้: ขั้นแรกให้ตัดลำดับออกเป็นบล็อก จากนั้นใช้ Embedder เพื่อแปลงแต่ละบล็อกให้เป็นเวกเตอร์ที่ฝัง Block Decoder รับผิดชอบในการประมวลผลเวกเตอร์การฝังบล็อกและบันทึกการพึ่งพาทั่วโลกระหว่างบล็อก Token Decoder รับผิดชอบในการประมวลผลการพึ่งพาท้องถิ่นระหว่างโทเค็นและการสร้างลำดับโทเค็น

วิธีการนี้ไม่เพียงแต่ปรับปรุงความเร็วการอนุมานเท่านั้น แต่ยังช่วยลดโอเวอร์เฮดของหน่วยความจำได้อย่างมากอีกด้วย ชาวเน็ตบางคนบอกว่าพวกเขามีความคิดที่คล้ายกันมาก่อน แต่ประสิทธิภาพของโมเดลที่ได้นั้นไม่เพียงพอ ตอนนี้วิธีนี้ดูเหมือนว่าจะลดแคช KV ลงได้อย่างมีประสิทธิภาพ

นอกจากนี้ ความแม่นยำของ Block Transformer ในงาน Zero-Shot หลายงานยังเทียบเคียงหรือสูงกว่าของ Transformer ดั้งเดิมที่มีขนาดเดียวกันด้วยซ้ำเล็กน้อย ซึ่งพิสูจน์ได้ว่าปรับปรุงประสิทธิภาพโดยไม่ทำให้คุณภาพลดลง

ความหมายของการวิจัยนี้ไม่ได้หยุดอยู่แค่นั้น นอกจากนี้ยังช่วยลดต้นทุนการฝึกอบรมของโมเดล ค่าใช้จ่ายในการเข้าถึงหน่วยความจำสำรองที่ทั่วโลกสนใจลดลง 16 เท่า และการใช้งาน GPU ก็เพิ่มขึ้นจาก 1% เป็น 44%

ที่อยู่กระดาษ: https://arxiv.org/abs/2406.02657

การเกิดขึ้นของ Block Transformer ได้ขยายความเป็นไปได้ใหม่ๆ สำหรับการประยุกต์ใช้โมเดล Transformer และยังให้ทิศทางใหม่สำหรับการเพิ่มประสิทธิภาพของโมเดลภาษาขนาดใหญ่ในอนาคต การปรับปรุงความเร็วและประสิทธิภาพอย่างมีนัยสำคัญคาดว่าจะส่งเสริมการพัฒนาและการประยุกต์ใช้เทคโนโลยี AI ต่อไป