แพลตฟอร์มแบบเปิด Kimi กำลังจะเปิดตัวการทดสอบภายในของฟังก์ชัน Context Caching ภายในที่ทุกคนตั้งตารอคอย เทคโนโลยีที่เป็นนวัตกรรมใหม่นี้จะช่วยปรับปรุงประสบการณ์ผู้ใช้ของโมเดลข้อความยาวขนาดใหญ่ได้อย่างมาก ด้วยการแคชเนื้อหาโทเค็นที่ซ้ำกัน การแคชบริบทสามารถลดต้นทุนของผู้ใช้ที่ร้องขอเนื้อหาเดียวกันได้อย่างมาก และปรับปรุงความเร็วการตอบสนองอินเทอร์เฟซ API ได้อย่างมาก นี่เป็นสิ่งสำคัญอย่างยิ่งสำหรับสถานการณ์แอปพลิเคชันที่ต้องการการร้องขอบ่อยครั้งและการอ้างอิงซ้ำไปยังบริบทเริ่มต้นจำนวนมาก เช่น สถานการณ์พร้อมท์ขนาดใหญ่และซ้ำซ้อนสูง

ข่าวจาก ChinaZ.com เมื่อวันที่ 20 มิถุนายน: Kimi Open Platform เพิ่งประกาศว่าฟังก์ชัน Context Caching ที่หลายคนรอคอยจะเปิดตัวการทดสอบภายในเร็วๆ นี้ คุณลักษณะที่เป็นนวัตกรรมใหม่นี้จะสนับสนุนรูปแบบข้อความยาวขนาดใหญ่ และช่วยให้ผู้ใช้ได้รับประสบการณ์ที่ไม่เคยมีมาก่อนผ่านกลไกการแคชบริบทที่มีประสิทธิภาพ

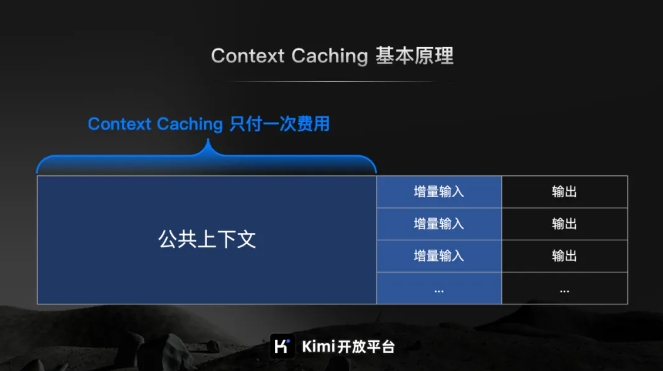

ตามการแนะนำอย่างเป็นทางการของ Kimi Open Platform การแคชบริบทเป็นเทคโนโลยีล้ำสมัยที่ได้รับการออกแบบมาเพื่อลดต้นทุนของผู้ใช้ที่ร้องขอเนื้อหาเดียวกันอย่างมากโดยการแคชเนื้อหาโทเค็นที่ซ้ำกัน หลักการทำงานของมันคือการระบุและจัดเก็บส่วนของข้อความที่ประมวลผลอย่างชาญฉลาด เมื่อผู้ใช้ร้องขออีกครั้ง ระบบสามารถดึงข้อมูลจากแคชได้อย่างรวดเร็ว ซึ่งจะช่วยปรับปรุงความเร็วในการตอบสนองของอินเทอร์เฟซ API ได้อย่างมาก

สำหรับสถานการณ์พร้อมท์ขนาดใหญ่และมีการทำซ้ำสูง ข้อดีของฟังก์ชันการแคชบริบทมีความสำคัญอย่างยิ่ง สามารถตอบสนองคำขอที่พบบ่อยจำนวนมากได้อย่างรวดเร็ว และปรับปรุงประสิทธิภาพการประมวลผลได้อย่างมาก ในขณะที่ลดต้นทุนโดยการนำเนื้อหาที่แคชไว้กลับมาใช้ใหม่

เป็นเรื่องที่ควรค่าแก่การกล่าวถึงเป็นพิเศษว่าฟังก์ชัน Context Caching เหมาะอย่างยิ่งสำหรับสถานการณ์แอปพลิเคชันที่ต้องการการร้องขอบ่อยครั้งและการอ้างอิงซ้ำไปยังบริบทเริ่มต้นจำนวนมาก ด้วยคุณสมบัตินี้ ผู้ใช้สามารถใช้การแคชบริบทที่มีประสิทธิภาพได้อย่างง่ายดาย ซึ่งจะช่วยปรับปรุงประสิทธิภาพการทำงานและลดต้นทุนการดำเนินงาน

การทดสอบภายในของฟังก์ชัน Context Caching กำลังจะเริ่มต้นขึ้น ซึ่งเป็นก้าวสำคัญที่แพลตฟอร์มเปิด Kimi ดำเนินการในการปรับปรุงประสิทธิภาพของโมเดลขนาดใหญ่และลดต้นทุนของผู้ใช้ อนาคตมีแนวโน้มที่ดี