ผลการประยุกต์ใช้ในทางปฏิบัติของแบบจำลองภาษาเชิงกำเนิดมักถูกจำกัดโดยกลยุทธ์การถอดรหัสในขั้นตอนการอนุมาน วิธีการที่มีอยู่ เช่น RLHF มุ่งเน้นไปที่อัตราการชนะของโมเดลเป็นหลัก และไม่สนใจผลกระทบของกลยุทธ์การถอดรหัสที่มีต่อประสิทธิภาพของโมเดล ส่งผลให้ประสิทธิภาพต่ำและความยากลำบากในการรับรองคุณภาพเอาต์พุต เพื่อที่จะแก้ไขปัญหานี้ Google DeepMind และทีมวิจัยของ Google ได้เสนอกรอบงาน InfAlign ซึ่งมีจุดมุ่งหมายเพื่อรวมกลยุทธ์การอนุมานเข้ากับกระบวนการจัดตำแหน่งโมเดล เพื่อปรับปรุงประสิทธิภาพการอนุมานและความน่าเชื่อถือของโมเดล

โมเดลภาษาเชิงสร้างสรรค์เผชิญกับความท้าทายมากมายในกระบวนการตั้งแต่การฝึกอบรมไปจนถึงการใช้งานจริง ปัญหาหลักประการหนึ่งคือการบรรลุประสิทธิภาพของโมเดลที่เหมาะสมที่สุดในระหว่างขั้นตอนการอนุมาน

มาตรการรับมือในปัจจุบัน เช่น การเรียนรู้แบบเสริมกำลังผ่านการตอบสนองของมนุษย์ (RLHF) มุ่งเน้นไปที่การปรับปรุงอัตราการชนะของแบบจำลองเป็นหลัก แต่มักจะมองข้ามกลยุทธ์การถอดรหัสในระหว่างการอนุมาน เช่น การสุ่มตัวอย่าง Best-of-N และการถอดรหัสแบบควบคุม ช่องว่างระหว่างเป้าหมายการฝึกอบรมและการใช้งานจริงอาจทำให้เกิดความไร้ประสิทธิภาพและส่งผลต่อคุณภาพและความน่าเชื่อถือของผลลัพธ์

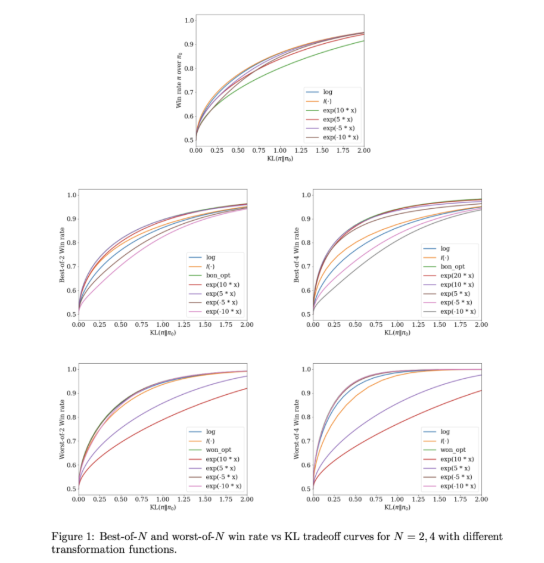

เพื่อแก้ไขปัญหาเหล่านี้ Google DeepMind และทีมวิจัยของ Google ได้พัฒนา InfAlign ซึ่งเป็นเฟรมเวิร์กแมชชีนเลิร์นนิงที่ออกแบบมาเพื่อใช้ร่วมกับกลยุทธ์การอนุมาน InfAlign รวมวิธีการอนุมานเวลาเข้ากับกระบวนการจัดตำแหน่ง และมุ่งมั่นที่จะเชื่อมช่องว่างระหว่างการฝึกอบรมและการใช้งาน ใช้วิธีการเรียนรู้แบบเสริมกำลังที่ปรับเทียบแล้วเพื่อปรับฟังก์ชันการให้รางวัลตามกลยุทธ์การอนุมานเฉพาะ InfAlign มีประสิทธิภาพเป็นพิเศษกับเทคนิคต่างๆ เช่น การสุ่มตัวอย่าง Best-of-N (สร้างการตอบสนองหลายรายการและเลือกคำตอบที่ดีที่สุด) และ Worst-of-N (มักใช้ในการประเมินความปลอดภัย) ทำให้มั่นใจได้ว่าแบบจำลองที่สอดคล้องกันจะทำงานทั้งในสภาพแวดล้อมที่มีการควบคุมและในสภาพแวดล้อมจริง - สถานการณ์ชีวิตที่ดี

แกนหลักของ InfAlign คืออัลกอริธึมการเรียนรู้การเสริมกำลังการสอบเทียบและการเปลี่ยนแปลง (CTRL) ซึ่งมีสามขั้นตอน: การสอบเทียบคะแนนรางวัล การแปลงคะแนนเหล่านี้ตามกลยุทธ์การอนุมาน และการแก้ปัญหาการปรับให้เหมาะสมที่ทำให้เป็นมาตรฐานของ KL InfAlign ปรับเป้าหมายการฝึกอบรมให้สอดคล้องกับข้อกำหนดการอนุมานโดยปรับแต่งการเปลี่ยนแปลงรางวัลให้เหมาะกับสถานการณ์เฉพาะ วิธีการนี้ไม่เพียงแต่ปรับปรุงอัตราการชนะในระหว่างการอนุมานเท่านั้น แต่ยังรักษาประสิทธิภาพการคำนวณอีกด้วย นอกจากนี้ InfAlign ยังปรับปรุงความแข็งแกร่งของโมเดล ทำให้สามารถรับมือกับกลยุทธ์การถอดรหัสต่างๆ ได้อย่างมีประสิทธิภาพ และสร้างเอาต์พุตคุณภาพสูงที่สม่ำเสมอ

ประสิทธิผลของ InfAlign ได้รับการตรวจสอบในการทดลองโดยใช้ชุดข้อมูลที่เป็นประโยชน์และไม่เป็นอันตรายของ Anthropic เมื่อเปรียบเทียบกับวิธีการที่มีอยู่ InfAlign จะปรับปรุงอัตราการชนะการอนุมานได้ 8%-12% ในการสุ่มตัวอย่างแบบ Best-of-N และ 4%-9% ในการประเมินความปลอดภัยที่แย่ที่สุดแบบ N การปรับปรุงเหล่านี้เกิดขึ้นเนื่องจากการเปลี่ยนแปลงรางวัลที่ได้รับการสอบเทียบ ซึ่งช่วยแก้ปัญหาการสอบเทียบที่ไม่ถูกต้องของโมเดลรางวัลได้อย่างมีประสิทธิภาพ และรับประกันประสิทธิภาพที่สม่ำเสมอในสถานการณ์การอนุมานที่แตกต่างกัน

InfAlign แสดงถึงความก้าวหน้าที่สำคัญในการจัดตำแหน่งของโมเดลภาษาเชิงกำเนิด ด้วยการผสมผสานกลยุทธ์การรับรู้การอนุมาน InfAlign จึงสามารถจัดการกับความแตกต่างที่สำคัญระหว่างการฝึกอบรมและการปรับใช้ รากฐานทางทฤษฎีที่แข็งแกร่งและผลลัพธ์เชิงประจักษ์เน้นย้ำถึงศักยภาพในการปรับปรุงการจัดตำแหน่งระบบ AI อย่างครอบคลุม

ลิงค์: https://arxiv.org/abs/2412.19792

ไฮไลท์:

InfAlign เป็นเฟรมเวิร์กใหม่ที่พัฒนาโดย Google DeepMind โดยมีเป้าหมายเพื่อปรับปรุงประสิทธิภาพของโมเดลภาษาในขั้นตอนการอนุมาน

กรอบการทำงานนี้จะปรับฟังก์ชันการให้รางวัลของกลยุทธ์การอนุมานผ่านวิธีการเรียนรู้แบบเสริมกำลังที่ปรับเทียบแล้ว เพื่อให้บรรลุการจัดตำแหน่งระหว่างเป้าหมายการฝึกอบรมและข้อกำหนดในการอนุมาน

ผลการทดลองแสดงให้เห็นว่า InfAlign ปรับปรุงอัตราการชนะของการอนุมานของแบบจำลองในงานหลายๆ งานได้อย่างมาก ซึ่งแสดงให้เห็นถึงความสามารถในการปรับตัวและความน่าเชื่อถือที่ดี

การเกิดขึ้นของกรอบงาน InfAlign ทำให้เกิดแนวคิดใหม่ๆ ในการแก้ปัญหาด้านประสิทธิภาพและคุณภาพของโมเดลภาษาเชิงกำเนิดในขั้นตอนการอนุมาน ซึ่งสมควรได้รับความสนใจ การวิจัยในอนาคตสามารถสำรวจการประยุกต์ใช้ InfAlign ในโมเดลและงานต่างๆ เพิ่มเติมได้ เพื่อส่งเสริมการพัฒนาเทคโนโลยี AI เชิงสร้างสรรค์อย่างต่อเนื่อง