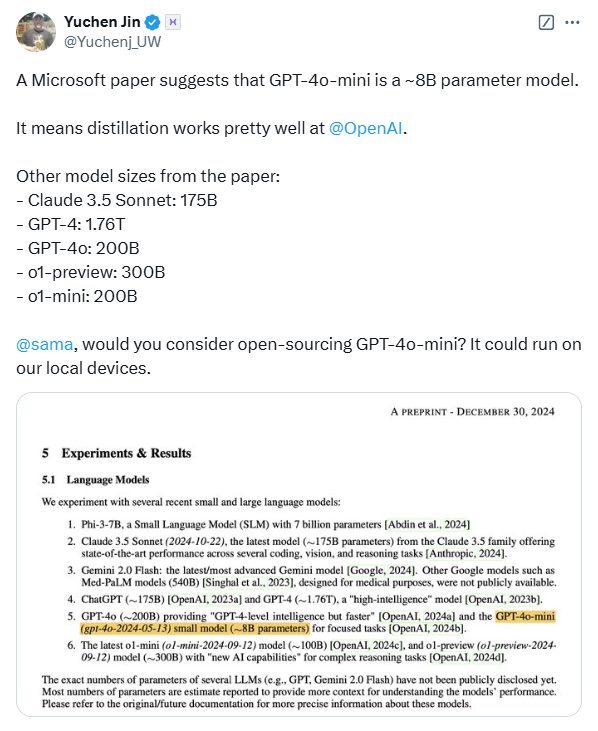

รายงานเกี่ยวกับการประเมิน AI ทางการแพทย์ได้เปิดเผยขนาดพารามิเตอร์ของโมเดลภาษาขนาดใหญ่ชั้นนำหลายๆ แบบโดยไม่คาดคิด ทำให้เกิดความกังวลอย่างกว้างขวางในอุตสาหกรรม เอกสารนี้เผยแพร่โดย Microsoft นำการทดสอบเกณฑ์มาตรฐานด้านการแพทย์ของ MEDEC เป็นแกนหลัก และประเมินพารามิเตอร์โมเดลของ OpenAI, Anthropic และบริษัทอื่นๆ รวมถึงโมเดลต่างๆ เช่น ซีรีส์ GPT-4 ของ OpenAI และ Claude 3.5 Sonnet ของ Anthropic มีความแตกต่างระหว่างสเกลพารามิเตอร์ที่กล่าวถึงในรายงานและข้อมูลสาธารณะ ตัวอย่างเช่น สเกลพารามิเตอร์ของ GPT-4 นั้นแตกต่างจากข้อมูลที่ NVIDIA ประกาศก่อนหน้านี้อย่างมาก สิ่งนี้ทำให้เกิดการอภิปรายอย่างดุเดือดในอุตสาหกรรมเกี่ยวกับสถาปัตยกรรมโมเดลและเทคนิค และกระตุ้นให้ผู้คนเกิดความกังวลเกี่ยวกับโมเดล AI อีกครั้ง

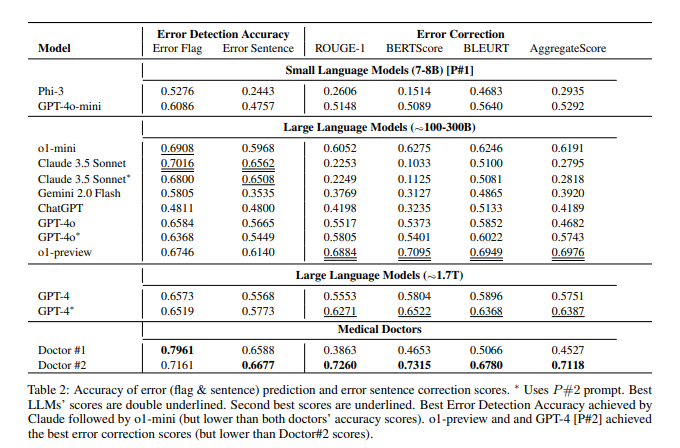

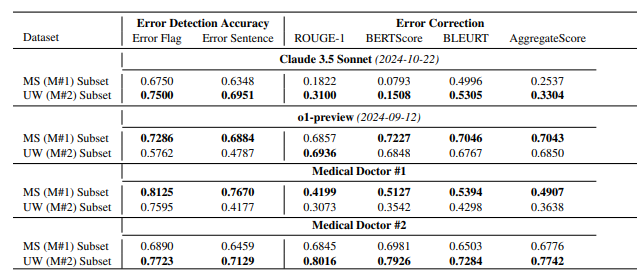

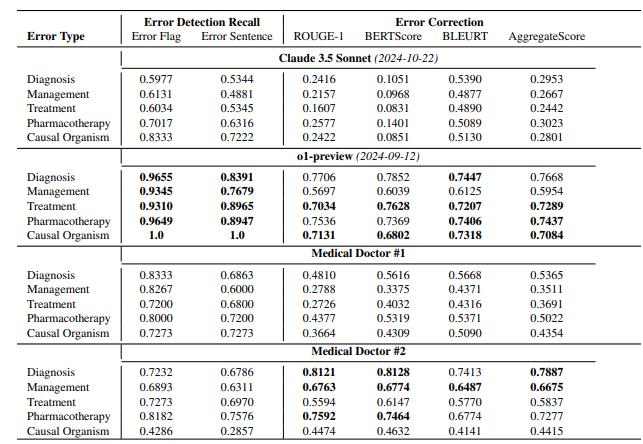

ตามรายงาน โมเดล o1-preview ของ OpenAI มีพารามิเตอร์ประมาณ 300B GPT-4o มีประมาณ 200B และ GPT-4o-mini มีเพียง 8B ขนาดพารามิเตอร์ของ Claude3.5Sonnet อยู่ที่ประมาณ 175B ผลการทดสอบของ MEDEC แสดงให้เห็นว่า Claude3.5Sonnet ทำงานได้ดีในการตรวจจับข้อผิดพลาด โดยให้คะแนนสูงถึง 70.16 พารามิเตอร์ของ Google Gemini ไม่ได้กล่าวถึงในบทความนี้ อาจเป็นเพราะ Gemini ใช้ TPU แทน NVIDIA GPU ซึ่งทำให้ยากต่อการประมาณความเร็วในการสร้างโทเค็นอย่างแม่นยำ ข้อมูลพารามิเตอร์ "รั่วไหล" ในรายงาน รวมถึงผลการประเมินประสิทธิภาพของแบบจำลอง ถือเป็นข้อมูลอ้างอิงที่มีคุณค่าสำหรับอุตสาหกรรมในการคิดอย่างลึกซึ้งเกี่ยวกับเส้นทางเทคโนโลยีแบบจำลองขนาดใหญ่ การแข่งขันทางธุรกิจ และทิศทางการพัฒนาในอนาคต

นี่ไม่ใช่ครั้งแรกที่ Microsoft มีข้อมูลพารามิเตอร์โมเดล "รั่วไหล" ในเอกสาร ในเดือนตุลาคมปีที่แล้ว Microsoft เปิดเผยขนาดพารามิเตอร์ 20B ของ GPT-3.5-Turbo ในกระดาษ แต่ต่อมาได้ลบข้อมูลนี้ในเวอร์ชันอัปเดต "การรั่วไหล" ที่เกิดขึ้นซ้ำๆ นี้ได้นำไปสู่การคาดเดาในหมู่คนในวงการว่ามีเจตนาเฉพาะเจาะจงหรือไม่

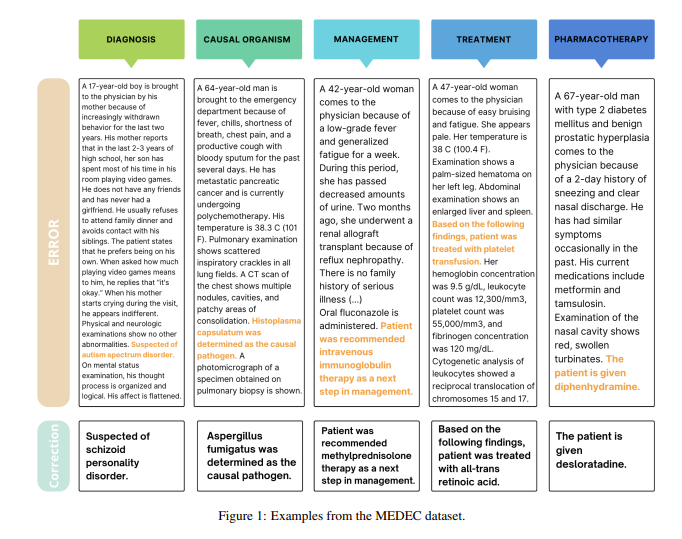

เป็นที่น่าสังเกตว่าวัตถุประสงค์หลักของบทความนี้คือเพื่อแนะนำเกณฑ์มาตรฐานในสาขาการแพทย์ที่เรียกว่า MEDEC ทีมวิจัยวิเคราะห์บันทึกทางคลินิก 488 รายการจากโรงพยาบาลสามแห่งในสหรัฐฯ และประเมินความสามารถของแบบจำลองหลักในการระบุและแก้ไขข้อผิดพลาดในเอกสารทางการแพทย์ ผลการทดสอบพบว่า Claude3.5Sonnet เป็นผู้นำในการตรวจจับข้อผิดพลาดรุ่นอื่นๆ ด้วยคะแนน 70.16

มีการถกเถียงอย่างดุเดือดในอุตสาหกรรมเกี่ยวกับความถูกต้องของข้อมูลเหล่านี้ บางคนเชื่อว่าหาก Claude3.5Sonnet บรรลุประสิทธิภาพที่ยอดเยี่ยมด้วยพารามิเตอร์จำนวนน้อยลง สิ่งนี้จะเน้นย้ำถึงจุดแข็งทางเทคนิคของ Anthropic นักวิเคราะห์บางคนยังเชื่อว่าการประมาณค่าพารามิเตอร์บางอย่างมีความสมเหตุสมผลผ่านการอนุมานการกำหนดราคาแบบจำลอง

สิ่งที่น่าสังเกตเป็นพิเศษคือบทความนี้จะประมาณค่าพารามิเตอร์ของโมเดลกระแสหลักเท่านั้น แต่ไม่ได้กล่าวถึงพารามิเตอร์เฉพาะของ Google Gemini นักวิเคราะห์บางคนเชื่อว่าสิ่งนี้อาจเกี่ยวข้องกับการใช้ TPU ของ Gemini แทน NVIDIA GPU ทำให้ยากต่อการประมาณความเร็วในการสร้างโทเค็นอย่างแม่นยำ

เนื่องจาก OpenAI ค่อยๆ ลดความมุ่งมั่นต่อโอเพ่นซอร์สลง ข้อมูลหลัก เช่น พารามิเตอร์โมเดล อาจยังคงกลายเป็นจุดสนใจของความสนใจอย่างต่อเนื่องในอุตสาหกรรม การรั่วไหลที่ไม่คาดคิดนี้กระตุ้นให้ผู้คนเกิดความคิดเชิงลึกเกี่ยวกับสถาปัตยกรรมโมเดล AI เส้นทางทางเทคนิค และการแข่งขันทางธุรกิจอีกครั้ง

อ้างอิง:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probally_around_8b_active/

โดยรวมแล้ว แม้ว่าข้อมูลพารามิเตอร์แบบจำลอง "รั่วไหล" ในบทความนี้จะไม่ใช่เนื้อหาหลักของการวิจัยของบทความนี้ แต่ก็ได้กระตุ้นให้เกิดการอภิปรายในเชิงลึกในอุตสาหกรรมเกี่ยวกับขนาดของพารามิเตอร์แบบจำลองขนาดใหญ่ การเลือกเส้นทางทางเทคนิค และ ภูมิทัศน์การแข่งขันเชิงพาณิชย์ซึ่งเป็นพื้นฐานสำหรับการพัฒนาด้านปัญญาประดิษฐ์ในอนาคต