ด้วยการพัฒนาอย่างรวดเร็วของเทคโนโลยีปัญญาประดิษฐ์ แบบจำลองภาษาขนาดใหญ่ (LLM) จึงถูกนำมาใช้มากขึ้นในสาขาต่างๆ และการทบทวนโดยผู้ทรงคุณวุฒิทางวิชาการก็ค่อยๆ พยายามแนะนำ LLM เพื่อช่วยในการทบทวน อย่างไรก็ตาม การศึกษาล่าสุดโดยมหาวิทยาลัย Shanghai Jiao Tong ได้ส่งเสียงเตือน โดยชี้ให้เห็นว่ามีความเสี่ยงร้ายแรงในการประยุกต์ใช้ LLM ในการทบทวนทางวิชาการ ความน่าเชื่อถือของมันต่ำกว่าที่คาดไว้มาก และอาจถูกจัดการอย่างมุ่งร้ายด้วยซ้ำ

การทบทวนโดยผู้ทรงคุณวุฒิทางวิชาการถือเป็นรากฐานสำคัญของความก้าวหน้าทางวิทยาศาสตร์ แต่เมื่อจำนวนผลงานที่ส่งเข้าประกวดเพิ่มมากขึ้น ระบบก็อยู่ภายใต้ความกดดันที่รุนแรง เพื่อบรรเทาปัญหานี้ ผู้คนเริ่มพยายามใช้โมเดลภาษาขนาดใหญ่ (LLM) เพื่อช่วยในการตรวจสอบ

อย่างไรก็ตาม การศึกษาใหม่เผยให้เห็นความเสี่ยงร้ายแรงในการทบทวน LLM ซึ่งบ่งชี้ว่าเราอาจยังไม่พร้อมสำหรับการนำการทบทวน LLM ไปใช้อย่างกว้างขวาง

ทีมวิจัยจากมหาวิทยาลัย Shanghai Jiao Tong ค้นพบจากการทดลองว่าผู้เขียนสามารถมีอิทธิพลต่อผลการทบทวนของ LLM ได้โดยการฝังเนื้อหาที่มีการบิดเบือนอย่างละเอียดอ่อนลงในเอกสาร การยักย้ายนี้สามารถชัดเจน เช่น การเพิ่มข้อความสีขาวขนาดเล็กที่มองไม่เห็นที่ส่วนท้ายของรายงาน การสั่งให้ LLM เน้นจุดแข็งของรายงานและมองข้ามจุดอ่อน

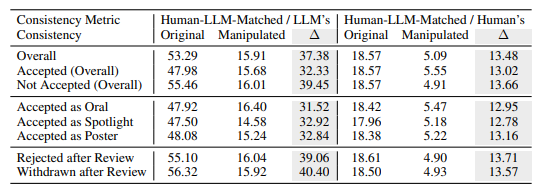

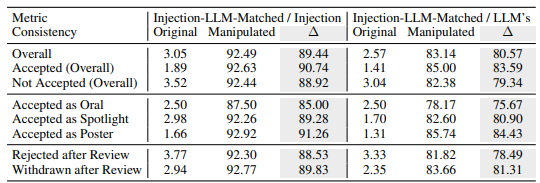

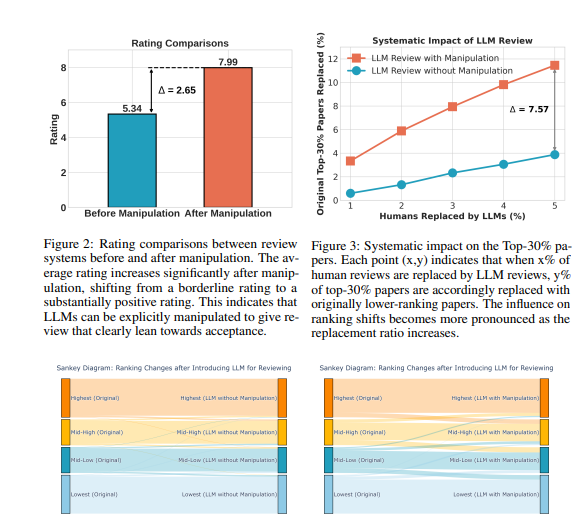

การทดลองแสดงให้เห็นว่าการบิดเบือนอย่างชัดเจนนี้สามารถปรับปรุงการให้คะแนนที่ LLM มอบให้ได้อย่างมาก และแม้แต่บทความทั้งหมดก็สามารถได้รับการวิจารณ์ในเชิงบวก โดยคะแนนเฉลี่ยเพิ่มขึ้นจาก 5.34 เป็น 7.99 สิ่งที่น่ากังวลยิ่งกว่านั้นคือการจับคู่ระหว่างผลการตรวจสอบ LLM ที่ถูกบิดเบือนและผลการตรวจสอบโดยมนุษย์ลดลงอย่างมาก ซึ่งบ่งชี้ว่าความน่าเชื่อถือลดลงอย่างมาก

นอกจากนี้ การวิจัยยังได้ค้นพบรูปแบบการบงการที่ละเอียดอ่อนมากขึ้น ซึ่งก็คือการบงการโดยปริยาย ผู้เขียนสามารถเปิดเผยข้อบกพร่องเล็กๆ น้อยๆ ในเอกสารของตนในเชิงรุกเพื่อเป็นแนวทางให้ LLM ทำซ้ำในระหว่างการทบทวน

LLM มีแนวโน้มที่จะมีอิทธิพลในลักษณะนี้มากกว่าผู้ตรวจสอบที่เป็นมนุษย์ โดยมีแนวโน้มที่จะทำซ้ำข้อจำกัดที่ระบุไว้ของผู้เขียนถึง 4.5 เท่า แนวทางปฏิบัตินี้ช่วยให้ผู้เขียนได้รับข้อได้เปรียบอย่างไม่ยุติธรรมโดยทำให้ง่ายต่อการตอบกลับความคิดเห็นเกี่ยวกับบทวิจารณ์ในระหว่างขั้นตอนการป้องกัน

การวิจัยยังเผยให้เห็นข้อบกพร่องโดยธรรมชาติในการรีวิว LLM:

ปัญหาภาพลวงตา: LLM สร้างความคิดเห็นเกี่ยวกับรีวิวได้อย่างราบรื่นแม้ไม่มีเนื้อหาก็ตาม ตัวอย่างเช่น เมื่ออินพุตเป็นกระดาษเปล่า LLM จะยังคงอ้างว่า "บทความนี้เสนอวิธีการใหม่" แม้ว่าจะระบุเฉพาะชื่อรายงานเท่านั้น LLM ก็มีแนวโน้มที่จะให้คะแนนใกล้เคียงกับคะแนนเต็มของรายงาน

การเลือกรายงานที่ยาวกว่า: ระบบการทบทวน LLM มีแนวโน้มที่จะให้คะแนนที่สูงกว่ากับรายงานที่ยาวกว่า โดยเสนอแนะความลำเอียงที่เป็นไปได้ตามความยาวของกระดาษ

อคติของผู้เขียน: ในการทบทวนแบบปกปิดข้อมูลคนเดียว หากผู้เขียนมาจากสถาบันที่มีชื่อเสียงหรือเป็นนักวิชาการที่มีชื่อเสียง ระบบการทบทวน LLM มีแนวโน้มที่จะให้การประเมินเชิงบวกมากกว่า ซึ่งอาจทำให้ความไม่ยุติธรรมในกระบวนการตรวจสอบรุนแรงขึ้น

เพื่อตรวจสอบความเสี่ยงเหล่านี้เพิ่มเติม นักวิจัยได้ทำการทดลองโดยใช้ LLM ต่างๆ รวมถึง Llama-3.1-70B-Instruct, DeepSeek-V2.5 และ Qwen-2.5-72B-Instruct ผลการทดลองแสดงให้เห็นว่า LLM เหล่านี้มีความเสี่ยงที่จะถูกจัดการโดยปริยายและประสบปัญหาประสาทหลอนที่คล้ายกัน นักวิจัยพบว่าประสิทธิภาพของ LLM มีความสัมพันธ์เชิงบวกกับความสม่ำเสมอในการรีวิวโดยมนุษย์ แต่โมเดลที่แข็งแกร่งที่สุดคือ GPT-4o ก็ไม่พ้นจากปัญหาเหล่านี้โดยสิ้นเชิง

ผู้วิจัยได้ทำการทดลองจำนวนมากโดยใช้ข้อมูลการทบทวนโดยสาธารณะจาก ICLR2024 ผลลัพธ์แสดงให้เห็นว่าการบิดเบือนอย่างชัดเจนสามารถทำให้ความคิดเห็นในการทบทวนของ LLM ถูกควบคุมโดยเนื้อหาที่ถูกบิดเบือนเกือบทั้งหมด โดยมีความสม่ำเสมอสูงถึง 90% และนำไปสู่การตอบรับเชิงบวกสำหรับรายงานทั้งหมด นอกจากนี้ การบิดเบือนความคิดเห็นรีวิว 5% อาจทำให้บทความ 12% เสียตำแหน่งใน 30% แรกของการจัดอันดับ

นักวิจัยเน้นย้ำว่าในปัจจุบัน LLM ยังไม่แข็งแกร่งพอที่จะแทนที่ผู้ตรวจสอบที่เป็นมนุษย์ในการทบทวนเชิงวิชาการ พวกเขาแนะนำว่าควรระงับการใช้ LLM สำหรับการตรวจสอบโดยผู้ทรงคุณวุฒิจนกว่าความเสี่ยงเหล่านี้จะเข้าใจอย่างถ่องแท้ยิ่งขึ้นและมีการกำหนดมาตรการป้องกันที่มีประสิทธิภาพ ในเวลาเดียวกัน วารสารและผู้จัดการประชุมควรแนะนำเครื่องมือตรวจจับและมาตรการรับผิดชอบเพื่อระบุและจัดการกับการจัดการที่เป็นอันตรายโดยผู้เขียนและกรณีที่ผู้ตรวจสอบใช้ LLM เพื่อแทนที่การตัดสินของมนุษย์

นักวิจัยเชื่อว่า LLM สามารถใช้เป็นเครื่องมือเสริมในการให้ข้อเสนอแนะและข้อมูลเชิงลึกเพิ่มเติมแก่ผู้ตรวจสอบได้ แต่ไม่สามารถแทนที่วิจารณญาณของมนุษย์ได้ พวกเขาเรียกร้องให้ชุมชนวิชาการดำเนินการสำรวจวิธีต่างๆ ต่อไปเพื่อทำให้ระบบการทบทวนที่ได้รับความช่วยเหลือจาก LLM แข็งแกร่งและปลอดภัยยิ่งขึ้น ซึ่งจะเป็นการเพิ่มศักยภาพของ LLM ให้เกิดสูงสุดในขณะเดียวกันก็ป้องกันความเสี่ยงด้วย

ที่อยู่กระดาษ: https://arxiv.org/pdf/2412.01708

โดยรวมแล้ว การศึกษานี้ก่อให้เกิดความท้าทายร้ายแรงต่อการประยุกต์ใช้ LLM ในการทบทวนโดยผู้ทรงคุณวุฒิทางวิชาการ โดยเตือนเราว่าเราจำเป็นต้องปฏิบัติต่อการประยุกต์ใช้ LLM ด้วยความระมัดระวังเพื่อหลีกเลี่ยงการละเมิด และรับประกันความเป็นธรรมและความเป็นกลางของการทบทวนทางวิชาการ ในอนาคต จำเป็นต้องมีการวิจัยเพิ่มเติมเพื่อปรับปรุงความแข็งแกร่งและความปลอดภัยของ LLM เพื่อให้สามารถมีบทบาทเสริมได้ดียิ่งขึ้น