คุณสงสัยหรือไม่ว่า AI เช่น ChatGPT และ Wen Xinyiyan ทำงานอย่างไร ทั้งหมดนี้มีพื้นฐานมาจากโมเดลภาษาขนาดใหญ่ (LLM) บทความนี้จะใช้วิธีง่ายๆ ที่เข้าใจง่าย แม้ว่าคุณจะเรียนแค่ชั้นประถมศึกษาปีที่ 2 คุณก็สามารถเข้าใจหลักการทำงานของ LLM ได้ เราจะเริ่มต้นจากแนวคิดพื้นฐานของโครงข่ายประสาทเทียม และค่อยๆ อธิบายเทคโนโลยีหลัก เช่น การแปลงข้อความเป็นดิจิทัล การฝึกโมเดล เทคนิคขั้นสูง และสถาปัตยกรรม GPT และ Transformer ซึ่งจะพาคุณไปค้นพบความลึกลับของ LLM

โครงข่ายประสาทเทียม: ความมหัศจรรย์ของตัวเลข

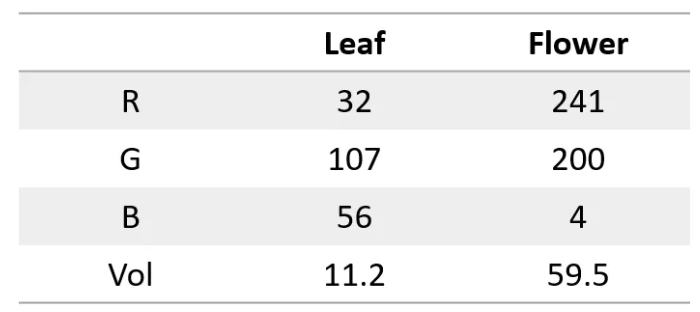

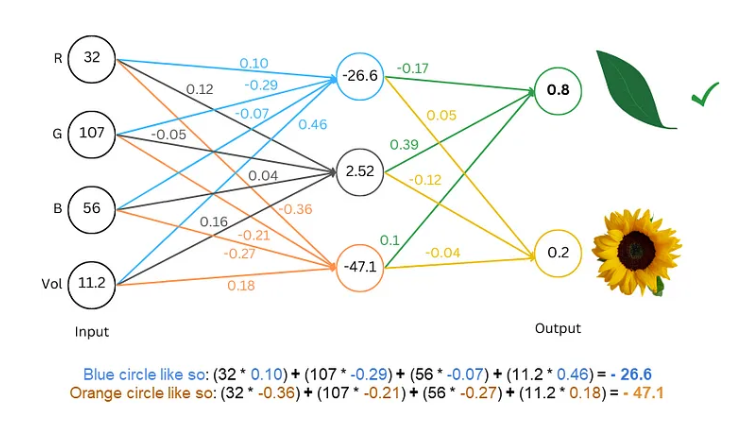

ก่อนอื่น เราต้องรู้ว่าโครงข่ายประสาทเทียมก็เหมือนกับซูเปอร์คอมพิวเตอร์ มันสามารถประมวลผลได้เฉพาะตัวเลขเท่านั้น ทั้งอินพุตและเอาต์พุตต้องเป็นตัวเลข แล้วเราจะทำให้มันเข้าใจข้อความได้อย่างไร?

เคล็ดลับคือการแปลงคำให้เป็นตัวเลข เช่น เราสามารถแสดงตัวอักษรแต่ละตัวด้วยตัวเลข เช่น a=1, b=2 และอื่นๆ ด้วยวิธีนี้โครงข่ายประสาทเทียมสามารถ "อ่าน" ข้อความได้

การฝึกโมเดล: ให้เครือข่าย “เรียนรู้” ภาษา

ด้วยข้อความดิจิทัล ขั้นตอนต่อไปคือการฝึกโมเดลและปล่อยให้โครงข่ายประสาทเทียม "เรียนรู้" กฎของภาษา

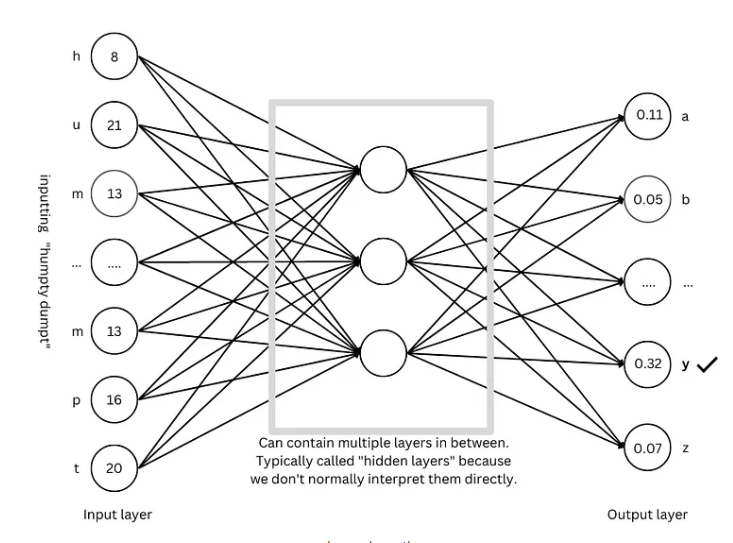

กระบวนการฝึกฝนก็เหมือนกับการเล่นเกมทายผล เราแสดงข้อความบางอย่างแก่เครือข่าย เช่น "Humpty Dumpty" และขอให้เครือข่ายเดาว่าตัวอักษรถัดไปคืออะไร ถ้ามันทายถูกเราจะให้รางวัล ถ้ามันทายผิดเราจะให้โทษ ด้วยการคาดเดาและปรับเปลี่ยนอย่างต่อเนื่อง เครือข่ายจึงสามารถทำนายตัวอักษรถัดไปได้อย่างแม่นยำยิ่งขึ้น ในที่สุดก็สร้างประโยคที่สมบูรณ์ เช่น "Humpty Dumpty นั่งบนกำแพง"

เทคนิคขั้นสูง: ทำให้โมเดลมีความ "ฉลาด" มากขึ้น

เพื่อให้โมเดลมีความ "ฉลาด" มากขึ้น นักวิจัยได้คิดค้นเทคนิคขั้นสูงมากมาย เช่น:

การฝังคำ: แทนที่จะใช้ตัวเลขธรรมดาแทนตัวอักษร เราใช้ชุดตัวเลข (เวกเตอร์) แทนคำแต่ละคำ ซึ่งสามารถอธิบายความหมายของคำได้ครบถ้วนยิ่งขึ้น

ตัวแบ่งคำย่อย: แบ่งคำออกเป็นหน่วยย่อย (คำย่อย) เช่น การแยก "แมว" เป็น "แมว" และ "s" ซึ่งสามารถลดคำศัพท์และปรับปรุงประสิทธิภาพได้

กลไกการเอาใจใส่ตนเอง: เมื่อโมเดลทำนายคำถัดไปก็จะปรับน้ำหนักของการทำนายตามคำทั้งหมดในบริบทเหมือนกับที่เราเข้าใจความหมายของคำตามบริบทเมื่ออ่าน

การเชื่อมต่อที่เหลือ: เพื่อหลีกเลี่ยงปัญหาการฝึกอบรมที่เกิดจากเลเยอร์เครือข่ายมากเกินไป นักวิจัยได้คิดค้นการเชื่อมต่อที่เหลือเพื่อทำให้เครือข่ายเรียนรู้ได้ง่ายขึ้น

กลไกความสนใจแบบหลายหัว: ด้วยการเรียกใช้กลไกความสนใจหลายรายการพร้อมกัน โมเดลสามารถเข้าใจบริบทจากมุมมองที่แตกต่างกัน และปรับปรุงความแม่นยำของการคาดการณ์

การเข้ารหัสตำแหน่ง: เพื่อให้โมเดลเข้าใจลำดับของคำ นักวิจัยจะเพิ่มข้อมูลตำแหน่งลงในการฝังคำ เช่นเดียวกับที่เราใส่ใจกับลำดับของคำเมื่ออ่าน

สถาปัตยกรรม GPT: “พิมพ์เขียว” สำหรับโมเดลภาษาขนาดใหญ่

ปัจจุบันสถาปัตยกรรม GPT เป็นหนึ่งในสถาปัตยกรรมโมเดลภาษาขนาดใหญ่ที่ได้รับความนิยมมากที่สุด ซึ่งเปรียบเสมือน "พิมพ์เขียว" ที่เป็นแนวทางในการออกแบบและการฝึกอบรมโมเดล สถาปัตยกรรม GPT ผสมผสานเทคนิคขั้นสูงที่กล่าวมาข้างต้นอย่างชาญฉลาด เพื่อให้โมเดลสามารถเรียนรู้และสร้างภาษาได้อย่างมีประสิทธิภาพ

สถาปัตยกรรมหม้อแปลงไฟฟ้า: “การปฏิวัติ” ของโมเดลภาษา

สถาปัตยกรรม Transformer ถือเป็นความก้าวหน้าครั้งสำคัญในด้านโมเดลภาษาในช่วงไม่กี่ปีที่ผ่านมา ไม่เพียงแต่ปรับปรุงความแม่นยำในการทำนายเท่านั้น แต่ยังช่วยลดความยากในการฝึกอบรม ซึ่งเป็นการวางรากฐานสำหรับการพัฒนาโมเดลภาษาขนาดใหญ่ สถาปัตยกรรม GPT ยังพัฒนาตามสถาปัตยกรรม Transformer

อ้างอิง: https://towardsdatascience.com/understand-llms-from-scratch-using-middle-school-math-e602d27ec876

จากคำอธิบายของบทความนี้ ฉันเชื่อว่าคุณมีความเข้าใจเบื้องต้นเกี่ยวกับโมเดลภาษาขนาดใหญ่แล้ว แม้ว่ากลไกภายในของ LLM จะซับซ้อนมาก แต่หลักการสำคัญของมันไม่ลึกลับ ฉันหวังว่าบทความนี้จะช่วยให้คุณเข้าใจเทคโนโลยีที่น่าทึ่งนี้ได้ดีขึ้น