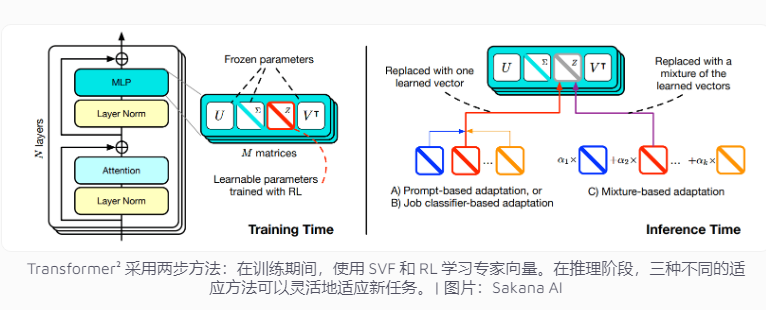

บริษัท Sakana AI ของญี่ปุ่นเพิ่งเปิดตัว Transforman ²ซึ่งเป็นเทคโนโลยีที่เป็นนวัตกรรมที่มีจุดมุ่งหมายเพื่อปรับปรุงงานรูปแบบภาษา แตกต่างจากระบบ AI แบบดั้งเดิมที่จำเป็นต้องจัดการงานหลายอย่างในครั้งเดียวTransformer²ใช้การเรียนรู้สองขั้นตอนในการใช้เวกเตอร์ผู้เชี่ยวชาญและเทคโนโลยีการปรับค่าปรับค่าปรับ (SVF) เพื่อให้สามารถปรับให้เข้ากับงานใหม่ได้อย่างมีประสิทธิภาพ เครือข่ายแสดงให้เห็นว่าเห็นได้ชัดว่ามันมีความชัดเจน เทคโนโลยีนี้มุ่งเน้นไปที่เวกเตอร์ผู้เชี่ยวชาญที่ควบคุมความสำคัญของการเชื่อมต่อเครือข่ายเพื่อมุ่งเน้นไปที่งานที่เฉพาะเจาะจงเช่นการดำเนินการทางคณิตศาสตร์การเขียนโปรแกรมและการใช้เหตุผลเชิงตรรกะและรวมกับการเสริมสร้างการเรียนรู้เพื่อเพิ่มประสิทธิภาพของโมเดลต่อไป

ระบบปัญญาประดิษฐ์ในปัจจุบันมักจะต้องจัดการงานหลายอย่างในการฝึกอบรม แต่พวกเขามีแนวโน้มที่จะท้าทายโดยไม่ตั้งใจเมื่อเผชิญกับงานใหม่ส่งผลให้มีการ จำกัด การปรับตัวของโมเดล แนวคิดการออกแบบของ Transformer 理มีจุดมุ่งหมายในเรื่องนี้

วิธีการฝึกอบรมแบบดั้งเดิมจำเป็นต้องปรับน้ำหนักของเครือข่ายประสาททั้งหมดและการฝึกฝนนี้ไม่เพียง แต่มีประสิทธิภาพสูงเท่านั้น แต่ยังอาจนำไปสู่ความรู้ที่ได้เรียนรู้ก่อนแบบจำลอง "ลืม" ในทางตรงกันข้ามเทคโนโลยี SVF หลีกเลี่ยงปัญหาเหล่านี้โดยการเรียนรู้เวกเตอร์ผู้เชี่ยวชาญที่ควบคุมความสำคัญของการเชื่อมต่อเครือข่ายแต่ละครั้ง เวกเตอร์ผู้เชี่ยวชาญสามารถช่วยโมเดลมุ่งเน้นไปที่งานที่เฉพาะเจาะจงโดยการปรับเมทริกซ์น้ำหนักของการเชื่อมต่อเครือข่ายเช่นการคำนวณทางคณิตศาสตร์การเขียนโปรแกรมและการใช้เหตุผลเชิงตรรกะ

วิธีนี้จะช่วยลดจำนวนพารามิเตอร์ที่จำเป็นสำหรับโมเดลเพื่อปรับให้เข้ากับงานใหม่ได้อย่างมีนัยสำคัญ ตัวอย่างเช่นวิธี LORA ต้องใช้พารามิเตอร์ 6.82 ล้านพารามิเตอร์ในขณะที่ SVF ต้องการพารามิเตอร์ 160,000 ตัวเท่านั้น สิ่งนี้ไม่เพียง แต่ช่วยลดการใช้หน่วยความจำและความสามารถในการประมวลผล แต่ยังป้องกันไม่ให้โมเดลลืมความรู้อื่น ๆ เมื่อมุ่งเน้นไปที่งานบางอย่าง สิ่งที่สำคัญที่สุดคือเวกเตอร์ผู้เชี่ยวชาญเหล่านี้สามารถทำงานร่วมกันได้อย่างมีประสิทธิภาพเพื่อเพิ่มความสามารถของแบบจำลองในการปรับให้เข้ากับงานที่หลากหลาย

เพื่อปรับปรุงการปรับตัวให้ดียิ่งขึ้น Transforch แนะนำการเรียนรู้ที่เพิ่มขึ้น ในระหว่างกระบวนการฝึกอบรมโมเดลจะเพิ่มประสิทธิภาพเวกเตอร์ผู้เชี่ยวชาญอย่างต่อเนื่องโดยเสนอโซลูชันงานและรับข้อเสนอแนะซึ่งจะเป็นการเพิ่มประสิทธิภาพของงานใหม่ ทีมได้พัฒนากลยุทธ์สามประการในการใช้ผู้เชี่ยวชาญเหล่านี้: ปรับให้เข้ากับเคล็ดลับตัวแยกประเภทงานและการปรับตัวอย่างเล็ก ๆ โดยเฉพาะอย่างยิ่งกลยุทธ์การปรับตัวของตัวอย่างขนาดเล็กโดยการวิเคราะห์ตัวอย่างของงานใหม่และปรับเวกเตอร์ผู้เชี่ยวชาญปรับปรุงความยืดหยุ่นและความแม่นยำของโมเดลต่อไป

ในการทดสอบเกณฑ์มาตรฐานหลายครั้ง Transform ²ดำเนินการมากกว่าวิธีดั้งเดิม LORA ในงานคณิตศาสตร์ประสิทธิภาพของมันเพิ่มขึ้น 16%และพารามิเตอร์ที่ต้องการลดลงอย่างมาก ในการเผชิญกับงานใหม่ความแม่นยำของหม้อแปลง²สูงกว่ารุ่นเดิม 4%ในขณะที่ LORA ล้มเหลวในการบรรลุผลที่คาดหวัง

หม้อแปลง能ไม่เพียง แต่สามารถแก้ปัญหาทางคณิตศาสตร์ที่ซับซ้อนได้ แต่ยังรวมการเขียนโปรแกรมและความสามารถในการใช้เหตุผลเชิงตรรกะเพื่อให้ได้การแบ่งปันความรู้ข้ามโดเมน ตัวอย่างเช่นทีมพบว่าโมเดลขนาดเล็กสามารถถ่ายโอนเวกเตอร์ผู้เชี่ยวชาญเพื่อปรับปรุงประสิทธิภาพด้วยความรู้เกี่ยวกับโมเดลขนาดใหญ่ซึ่งให้ความเป็นไปได้ใหม่สำหรับการแบ่งปันความรู้ระหว่างโมเดล

แม้ว่า Transformerr มีความคืบหน้าอย่างมีนัยสำคัญในการปรับตัวงาน แต่ก็ยังต้องเผชิญกับข้อ จำกัด บางประการ ในปัจจุบันเวกเตอร์ผู้เชี่ยวชาญที่ใช้การฝึกอบรม SVF สามารถพึ่งพาความสามารถที่มีอยู่ในรูปแบบการฝึกอบรมก่อนและไม่สามารถเพิ่มทักษะใหม่ได้ การเรียนรู้อย่างต่อเนื่องที่แท้จริงหมายความว่าแบบจำลองสามารถเรียนรู้ทักษะใหม่ได้อย่างอิสระและเป้าหมายนี้ยังคงต้องใช้เวลาในการบรรลุ วิธีการขยายเทคโนโลยีนี้ในรูปแบบขนาดใหญ่ที่มีพารามิเตอร์มากกว่า 70 พันล้านพารามิเตอร์ยังคงเป็นปัญหาที่ไม่สามารถบรรยายได้

โดยรวมแล้วTransformer²ได้แสดงให้เห็นถึงศักยภาพอย่างมากในด้านการเรียนรู้อย่างต่อเนื่อง อย่างไรก็ตามเทคโนโลยียังคงต้องได้รับการปรับปรุงอย่างต่อเนื่องเพื่อเอาชนะข้อ จำกัด ที่มีอยู่และบรรลุเป้าหมายการเรียนรู้อย่างต่อเนื่องที่แท้จริง