Sakana AI เปิดตัว Transformer ²แบบจำลองการปรับตัวที่เป็นนวัตกรรมซึ่งใช้กลไกการปรับน้ำหนักแบบไดนามิกแบบสองขั้นตอนที่ไม่เหมือนใครซึ่งเรียนรู้แบบไดนามิกและปรับให้เข้ากับงานใหม่ในระหว่างกระบวนการอนุมานโดยไม่มีการปรับแต่งราคาแพง นี่เป็นสิ่งสำคัญในการพัฒนาที่สำคัญในเทคโนโลยีรูปแบบภาษาขนาดใหญ่ (LLM) และคาดว่าจะเปลี่ยนวิธีการใช้ LLM เพื่อให้มีประสิทธิภาพมากขึ้นเป็นส่วนตัวและใช้งานได้จริง เมื่อเปรียบเทียบกับวิธีการปรับจูนแบบดั้งเดิม Transfort ²เลือกส่วนประกอบสำคัญของน้ำหนักแบบจำลองผ่านการสลายตัวของค่าเอกพจน์ (SVD) และเทคนิคการปรับแต่งค่าปรับ (SVF) เพื่อเพิ่มประสิทธิภาพการทำงานแบบเรียลไทม์ ผลการทดสอบแสดงให้เห็นว่าTransformer²นั้นเหนือกว่ารุ่น LORA ในหลายงานที่มีพารามิเตอร์น้อยลงและยังแสดงให้เห็นถึงความสามารถในการถ่ายโอนความรู้ที่แข็งแกร่ง

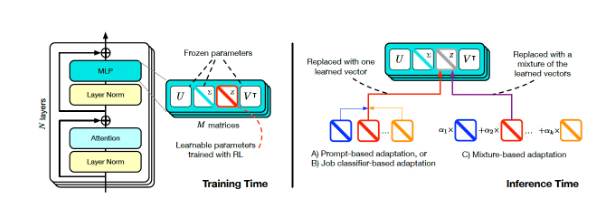

นวัตกรรมหลักของTransformer²อยู่ในกลไกการปรับน้ำหนักแบบไดนามิกสองขั้นตอนที่ไม่เหมือนใคร ขั้นแรกให้วิเคราะห์คำขอของผู้ใช้ที่เข้ามาและเข้าใจข้อกำหนดของงาน; โดยการเลือกการปรับส่วนประกอบสำคัญของน้ำหนักรุ่น Transfort ²ช่วยเพิ่มประสิทธิภาพการทำงานแบบเรียลไทม์โดยไม่ต้องใช้เวลานาน สิ่งนี้ตรงกันข้ามกับวิธีการปรับจูนแบบดั้งเดิมซึ่งต้องการการรักษาพารามิเตอร์แบบคงที่หลังจากการฝึกอบรมหรือใช้วิธีการเช่นการปรับระดับต่ำ (LORA) เพื่อปรับเปลี่ยนพารามิเตอร์จำนวนน้อยเท่านั้น

การฝึกอบรมและการอนุมานของ Transformer Square (ที่มา: Arxiv)

เพื่อให้ได้การปรับแบบไดนามิกนักวิจัยได้ใช้วิธีการปรับค่าปรับค่าปรับ (SVF) ในระหว่างการฝึกอบรม SVF เรียนรู้ชุดของการเป็นตัวแทนทักษะที่เรียกว่า Z-vectors จากส่วนประกอบ SVD ของโมเดล เมื่อการให้เหตุผล Transforman ²กำหนดทักษะที่จำเป็นโดยการวิเคราะห์พรอมต์แล้วกำหนดค่า Z-vectors ที่สอดคล้องกันเพื่อให้ได้การตอบสนองที่เหมาะกับแต่ละพรอมต์

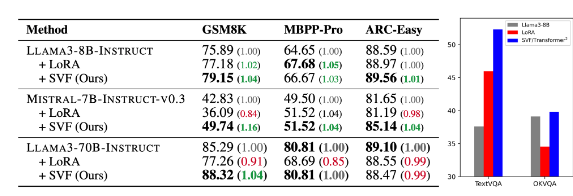

ผลการทดสอบแสดงให้เห็นว่าTransformer²นั้นเหนือกว่ารุ่น LORA ในงานต่าง ๆ เช่นคณิตศาสตร์การเข้ารหัสการใช้เหตุผลและคำถามและคำตอบและมีพารามิเตอร์น้อยลง ที่น่าทึ่งยิ่งกว่านั้นคือแบบจำลองนี้ยังมีความสามารถในการถ่ายโอนความรู้นั่นคือ Z-vectors ที่เรียนรู้จากรุ่นหนึ่งสามารถนำไปใช้กับอีกรุ่นหนึ่งได้ดังนั้นแสดงให้เห็นถึงศักยภาพในการใช้งานที่แพร่หลาย

การเปรียบเทียบของหม้อแปลง-สแควร์ (SVF ในตาราง) กับโมเดลพื้นฐานและ LORA (ที่มา: arxiv)

Sakana AI เปิดตัวรหัสการฝึกอบรมสำหรับส่วนประกอบTransformer²ในหน้า GitHub เปิดประตูสำหรับนักวิจัยและนักพัฒนาอื่น ๆ

ในขณะที่องค์กรยังคงสำรวจแอปพลิเคชันของ LLM เทคโนโลยีการปรับแต่งการอนุมานจะค่อยๆกลายเป็นเทรนด์กระแสหลัก Transformer²พร้อมกับเทคโนโลยีอื่น ๆ เช่น Titans ของ Google กำลังเปลี่ยนวิธีการใช้ LLM ทำให้ผู้ใช้สามารถปรับโมเดลแบบไดนามิกตามความต้องการเฉพาะของพวกเขาโดยไม่ต้องฝึกอบรมใหม่ ความก้าวหน้าทางเทคโนโลยีนี้จะทำให้ LLM มีประโยชน์มากขึ้นและใช้งานได้จริงในพื้นที่ที่กว้างขึ้น

นักวิจัยที่ Sakana AI กล่าวว่าTransformer²แสดงถึงสะพานเชื่อมระหว่างปัญญาประดิษฐ์แบบคงที่และหน่วยสืบราชการลับในชีวิตวางรากฐานสำหรับเครื่องมือ AI ที่มีประสิทธิภาพเป็นส่วนตัวและบูรณาการอย่างสมบูรณ์

การเปิดตัวโอเพ่นซอร์สของ Transform ²จะส่งเสริมการพัฒนาและการประยุกต์ใช้เทคโนโลยี LLM อย่างมากและให้ทิศทางใหม่สำหรับการสร้างระบบปัญญาประดิษฐ์ที่มีประสิทธิภาพและเป็นส่วนตัวมากขึ้น ความสามารถในการเรียนรู้แบบไดนามิกและปรับให้เข้ากับงานใหม่ทำให้มีศักยภาพแอปพลิเคชันขนาดใหญ่ในสาขาต่าง ๆ และคุ้มค่าที่จะรอคอยการพัฒนาในอนาคต