สถาบันอัลเลนแห่งปัญญาประดิษฐ์ (AI2) เพิ่งเปิดตัวโมเดลภาษาขนาดใหญ่ใหม่ Olmoe ซึ่งเป็นแบบจำลอง Hybrid Expert (MOE) ที่มีพารามิเตอร์ 7 พันล้านพารามิเตอร์ แต่เครื่องหมายอินพุตแต่ละตัวใช้พารามิเตอร์เพียง 1 พันล้านพารามิเตอร์ซึ่งจะลดจำนวนการอนุมานอย่างมีนัยสำคัญ ค่าใช้จ่ายและข้อกำหนดของหน่วยความจำ Olmoe มีสองเวอร์ชัน: Olmoe-1b-7b เวอร์ชันสากลและ Olmoe-1b-7b-Instruct เวอร์ชันการเรียนการสอนซึ่งดำเนินการไม่น้อยกว่ารุ่นใหญ่อื่น ๆ ในการวัดผล AI2 เน้นแหล่งโอเพ่นซอร์สที่สมบูรณ์ของ Olmoe ซึ่งมีค่าเป็นพิเศษในด้านโมเดล MOE และให้ทรัพยากรที่มีค่าสำหรับการวิจัยทางวิชาการ

Olmoe ใช้สถาปัตยกรรม Hybrid Expert (MOE) ที่มีพารามิเตอร์ 7 พันล้านพารามิเตอร์ แต่มีการใช้พารามิเตอร์เพียง 1 พันล้านตัวต่อแท็กอินพุต มันมาในสองเวอร์ชันยิ่ง OLMOE-1B-7B ทั่วไปและ OLMOE-1B-7B-Instruct ที่ได้รับการปรับแต่ง

ซึ่งแตกต่างจากรุ่นผู้เชี่ยวชาญไฮบริดอื่น ๆ ส่วนใหญ่ที่เป็นแหล่งปิด AI2 เน้นว่า Olmoe เป็นโอเพ่นซอร์สอย่างสมบูรณ์ พวกเขากล่าวถึงในบทความว่า "โมเดล MOE ส่วนใหญ่เป็นแหล่งข้อมูลปิด: แม้ว่าบางคนจะเปิดเผยน้ำหนักของแบบจำลอง แต่ก็มีข้อมูลที่ จำกัด อย่างมากเกี่ยวกับข้อมูลการฝึกอบรมรหัสหรือสูตรอาหาร"

Nathan Lambert นักวิทยาศาสตร์การวิจัย AI2 กล่าวในโซเชียลมีเดียว่า Olmoe จะช่วยในการกำหนดนโยบายซึ่งสามารถเป็นจุดเริ่มต้นสำหรับการเปิดตัวกลุ่ม H100 ในสถาบันการศึกษา นอกจากนี้เขายังกล่าวว่าการเปิดตัวโมเดล Olmoe เป็นส่วนหนึ่งของเป้าหมายของ AI2 ในการพัฒนาโมเดลโอเพ่นซอร์สและทำให้ประสิทธิภาพเทียบเคียงได้กับรุ่นปิด

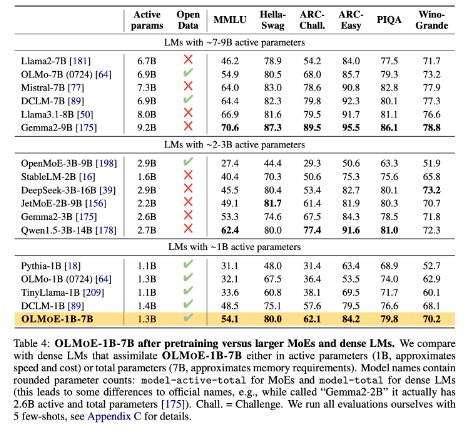

ในแง่ของการสร้างแบบจำลอง AI2 ตัดสินใจใช้ผู้เชี่ยวชาญขนาดเล็ก 64 คนสำหรับการกำหนดเส้นทางที่ดีและเปิดใช้งานเพียงแปดคนในรันไทม์ การทดลองแสดงให้เห็นว่า Olmoe เปรียบได้กับรุ่นอื่น ๆ ในประสิทธิภาพ แต่ลดลงอย่างมากในค่าอนุมานและการจัดเก็บหน่วยความจำ Olmoe ยังสร้างบนโมเดลโอเพ่นซอร์ส OLMO1.7-7B ก่อน AI2 ซึ่งรองรับหน้าต่างบริบท 4096 ที่ติดแท็ก ข้อมูลการฝึกอบรม Olmoe มาจากหลายแหล่งรวมถึงการรวบรวมข้อมูลทั่วไป Dolma CC, Wikipedia ฯลฯ

ในเกณฑ์มาตรฐาน OLMOE-1B-7B มีประสิทธิภาพสูงกว่ารุ่นที่มีอยู่จำนวนมากเมื่อเปรียบเทียบกับโมเดลที่มีพารามิเตอร์ที่คล้ายกันและยิ่งกว่ารุ่นที่ใหญ่กว่าเช่น LLAMA2-13B-Chat และ DeepSeekMoE-16B

หนึ่งในเป้าหมายของ AI2 คือการให้แบบจำลอง AI โอเพนซอร์สที่สมบูรณ์ยิ่งขึ้นรวมถึงสถาปัตยกรรมผู้เชี่ยวชาญไฮบริด แม้ว่านักพัฒนาหลายคนจะใช้สถาปัตยกรรม MOE แต่ AI2 เชื่อว่ารุ่น AI อื่น ๆ ส่วนใหญ่ยังไม่เปิดเพียงพอ

HuggingFace: https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30c8cd3da

ทางเข้ากระดาษ: https://arxiv.org/abs/2409.02060

ประเด็นสำคัญ:

- Olmoe รุ่นโอเพนซอร์สใหม่ที่เปิดตัวโดย AI2 นั้นมีการแข่งขันในแง่ของประสิทธิภาพและค่าใช้จ่าย

- Olmoe ใช้สถาปัตยกรรมผู้เชี่ยวชาญแบบไฮบริดที่เบาบางซึ่งสามารถลดต้นทุนการอนุมานและข้อกำหนดของหน่วยความจำได้อย่างมีประสิทธิภาพ

- AI2 มุ่งมั่นที่จะจัดทำแบบจำลอง AI โอเพนซอร์สอย่างเต็มที่ซึ่งส่งเสริมการวิจัยและพัฒนาเชิงวิชาการ

ในระยะสั้นการเปิดตัวโอเพ่นซอร์สของ Olmoe เป็นความก้าวหน้าที่สำคัญในสาขาภาษาขนาดใหญ่ การเคลื่อนไหวของ AI2 สะท้อนให้เห็นถึงความมุ่งมั่นของ บริษัท ในการพัฒนาโอเพนซอร์ส AI และคุ้มค่าที่จะรอคอยการมีส่วนร่วมที่คล้ายกันมากขึ้นในอนาคต