Meta Fair, UC Berkeley และทีมวิจัยมหาวิทยาลัยนิวยอร์กได้ร่วมมือกันพัฒนาเทคโนโลยีใหม่ที่เรียกว่าการเพิ่มประสิทธิภาพการคิดการคิด (TPO) เพื่อปรับปรุงการปฏิบัติตามการสอนและคุณภาพการตอบสนองในรูปแบบภาษาขนาดใหญ่ (LLM) อย่างมีนัยสำคัญ ซึ่งแตกต่างจาก LLM แบบดั้งเดิมที่ให้คำตอบโดยตรงเทคโนโลยี TPO ช่วยให้โมเดลคิดและไตร่ตรองภายในก่อนที่จะตอบกลับซึ่งจะสร้างคำตอบที่แม่นยำและสอดคล้องกันมากขึ้น นวัตกรรมนี้นำเสนอแบบจำลองเพื่อเพิ่มประสิทธิภาพกระบวนการคิดโดยไม่แสดงขั้นตอนกลางของผู้ใช้ในที่สุดปรับปรุงคุณภาพการตอบสนองผ่านวิธีการให้เหตุผลการคิดโซ่ (COT) ที่ดีขึ้น

แกนหลักของเทคโนโลยี TPO คือวิธีการให้เหตุผลในการคิดโซ่ (COT) ที่ดีขึ้น วิธีการนี้กระตุ้นให้นางแบบ“ คิดและตอบ” ในระหว่างการฝึกอบรมช่วยให้พวกเขาสร้างกระบวนการคิดภายในที่เป็นระเบียบมากขึ้นก่อนที่จะให้คำตอบสุดท้าย ตัวชี้นำเปลแบบดั้งเดิมบางครั้งอาจนำไปสู่ความแม่นยำที่ลดลงและค่อนข้างยุ่งยากในการฝึกอบรมเนื่องจากขาดขั้นตอนการคิดที่ชัดเจน และ TPO ประสบความสำเร็จในการเอาชนะความท้าทายเหล่านี้โดยการอนุญาตให้โมเดลสามารถเพิ่มประสิทธิภาพและทำให้กระบวนการคิดของพวกเขาได้ง่ายขึ้นโดยไม่เปิดเผยขั้นตอนกลางให้กับผู้ใช้

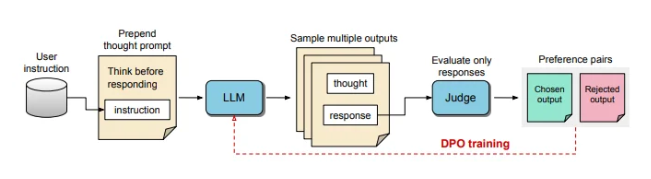

ในระหว่างกระบวนการฝึกอบรม TPO ก่อนครั้งแรกจะแจ้งรูปแบบภาษาขนาดใหญ่เพื่อสร้างความคิดหลายอย่างจากนั้นจัดเรียงคำตอบสุดท้าย ผลลัพธ์เหล่านี้จะถูกประเมินโดยโมเดล "ผู้พิพากษา" เพื่อเลือกคำตอบที่ดีที่สุดและมีประสิทธิภาพที่ดีที่สุด ผลการประเมินเหล่านี้ใช้เป็นคู่ "ตัวเลือก" และ "ปฏิเสธ" สำหรับการเพิ่มประสิทธิภาพการตั้งค่าโดยตรง (DPO) เพื่อปรับปรุงคุณภาพการตอบสนองของแบบจำลองอย่างต่อเนื่อง

ด้วยการปรับพรอมต์การฝึกอบรม TPO สนับสนุนให้โมเดลคิดภายในก่อนที่จะตอบ กระบวนการนี้นำทางโมเดลเพื่อเพิ่มประสิทธิภาพคำตอบเพื่อให้ชัดเจนและมีความเกี่ยวข้องมากขึ้น ในที่สุดการประเมินผลทำได้โดยรูปแบบการตัดสินที่ใช้ LLM ซึ่งทำคะแนนคำตอบสุดท้ายเท่านั้นจึงช่วยให้แบบจำลองปรับปรุงคุณภาพของคำตอบโดยอิสระจากขั้นตอนการคิดที่ซ่อนอยู่ TPO ยังใช้การเพิ่มประสิทธิภาพการตั้งค่าโดยตรงเพื่อสร้างคำตอบที่ต้องการและการปฏิเสธซึ่งมีความคิดที่ซ่อนอยู่และหลังจากการฝึกอบรมหลายรอบให้ปรับแต่งกระบวนการภายในของโมเดลต่อไป

ในมาตรฐานสำหรับ Alpacaeval และ Arena-Hard วิธี TPO มีประสิทธิภาพสูงกว่าพื้นฐานการตอบสนองแบบดั้งเดิมและดีกว่ารูปแบบ Llama-3-8b-Instruct ของ "เคล็ดลับการคิด" การฝึกอบรมซ้ำวิธีนี้ช่วยเพิ่มประสิทธิภาพความสามารถในการสร้างการคิดในที่สุดก็มีมากกว่ารุ่นพื้นฐานหลายรุ่น เป็นมูลค่าการกล่าวขวัญว่า TPO ไม่เพียง แต่เหมาะสำหรับงานตรรกะและคณิตศาสตร์เท่านั้น แต่ยังใช้ความพยายามอย่างมากในด้านความคิดสร้างสรรค์เช่นการตลาดและคำแนะนำด้านสุขภาพเพื่อปฏิบัติตามงาน

Karan Verma ผู้เชี่ยวชาญ AI และหุ่นยนต์ได้แบ่งปันมุมมองของเขาเกี่ยวกับแนวคิดของ "การคิด LLM" บนแพลตฟอร์มโซเชียล X โดยกล่าวว่าเขารู้สึกตื่นเต้นมากเกี่ยวกับเรื่องนี้และหวังว่าจะมีศักยภาพของนวัตกรรมนี้ในการใช้งานทางการแพทย์ .

กระบวนการคิดภายในที่มีโครงสร้างนี้ช่วยให้แบบจำลองสามารถประมวลผลคำแนะนำที่ซับซ้อนได้อย่างมีประสิทธิภาพมากขึ้นขยายการใช้งานในพื้นที่ที่ต้องใช้เหตุผลหลายระดับและความเข้าใจที่พิถีพิถันโดยไม่จำเป็นต้องให้มนุษย์ให้ข้อมูลการคิดที่เฉพาะเจาะจง การศึกษาครั้งนี้แสดงให้เห็นว่า TPO มีศักยภาพที่จะทำให้แบบจำลองภาษาขนาดใหญ่มีความยืดหยุ่นและมีประสิทธิภาพมากขึ้นในบริบทที่หลากหลายเหมาะสำหรับพื้นที่ที่มีความต้องการสูงสำหรับความยืดหยุ่นและความลึกของการสร้างการตอบสนอง

ความก้าวหน้าในการพัฒนาเทคโนโลยี TPO ได้นำความสามารถในการอนุมานและความเข้าใจที่แข็งแกร่งขึ้นไปสู่แบบจำลองภาษาขนาดใหญ่เปิดโอกาสใหม่ ๆ สำหรับการใช้งานของพวกเขาในสาขาต่าง ๆ โดยเฉพาะอย่างยิ่งในงานที่ต้องใช้กระบวนการคิดที่ซับซ้อน