Meta AI ร่วมกับนักวิจัยจาก University of California, Berkeley และ New York University ได้พัฒนาวิธีการใหม่ที่เรียกว่าการเพิ่มประสิทธิภาพการคิด (TPO) ที่มีจุดมุ่งหมายเพื่อปรับปรุงคุณภาพการตอบสนองของแบบจำลองภาษาขนาดใหญ่ (LLM) ซึ่งแตกต่างจากวิธีการดั้งเดิมที่มุ่งเน้นเฉพาะคำตอบสุดท้าย TPO อนุญาตให้โมเดลคิดภายในก่อนที่จะสร้างคำตอบทำให้เกิดการตอบสนองที่แม่นยำและสอดคล้องกันมากขึ้น วิธีการให้เหตุผลในการสร้างโซ่การคิดที่ได้รับการปรับปรุงเทคโนโลยีนี้เอาชนะข้อบกพร่องของวิธีการที่มีความแม่นยำต่ำและความยากลำบากในการฝึกอบรมผ่านการเพิ่มประสิทธิภาพและปรับปรุงกระบวนการคิดภายในของโมเดลและในที่สุดก็สร้างคำตอบที่มีคุณภาพสูงขึ้นและในหลาย ๆ ด้าน การทดสอบเกณฑ์มาตรฐานแต่ละครั้ง

ซึ่งแตกต่างจากโมเดลดั้งเดิมที่มุ่งเน้นเฉพาะคำตอบสุดท้ายวิธี TPO ช่วยให้โมเดลคิดภายในก่อนที่จะสร้างการตอบสนองทำให้เกิดคำตอบที่แม่นยำและสอดคล้องกันมากขึ้น

เทคโนโลยีใหม่นี้ผสมผสานวิธีการให้เหตุผลที่ดีขึ้นของโซ่ (COT) ในระหว่างกระบวนการฝึกอบรมวิธีการส่งเสริมให้แบบจำลอง "คิด" ก่อนที่จะตอบสนองช่วยสร้างกระบวนการคิดภายในที่เป็นระบบมากขึ้น COT โดยตรงก่อนหน้านี้มีการแจ้งเตือนบางครั้งลดความแม่นยำและกระบวนการฝึกอบรมเป็นเรื่องยากเนื่องจากขาดขั้นตอนการคิดที่ชัดเจน TPO เอาชนะข้อ จำกัด เหล่านี้โดยอนุญาตให้โมเดลสามารถเพิ่มประสิทธิภาพและปรับปรุงกระบวนการคิดและไม่แสดงขั้นตอนการคิดขั้นกลางต่อหน้าผู้ใช้

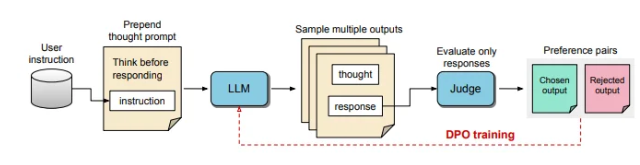

ในกระบวนการของ TPO โมเดลภาษาขนาดใหญ่จะได้รับการแจ้งเตือนเป็นครั้งแรกเพื่อสร้างกระบวนการคิดหลายอย่างจากนั้นเอาต์พุตเหล่านี้จะถูกสุ่มตัวอย่างและประเมินผลก่อนที่จะสร้างการตอบสนองสุดท้าย รูปแบบการประเมินผลจะให้คะแนนผลลัพธ์เพื่อตรวจสอบการตอบสนองที่ดีที่สุดและแย่ที่สุด ด้วยการใช้ผลลัพธ์เหล่านี้เป็นตัวเลือกและการปฏิเสธสำหรับการเพิ่มประสิทธิภาพการตั้งค่าโดยตรง (DPO) วิธีการฝึกอบรมซ้ำนี้ช่วยเพิ่มความสามารถของโมเดลในการสร้างการตอบสนองที่มีความเกี่ยวข้องและมีคุณภาพสูงมากขึ้นซึ่งจะเป็นการปรับปรุงผลลัพธ์โดยรวม

ในวิธีการนี้มีการปรับการฝึกอบรมกระตุ้นให้แบบจำลองคิดภายในก่อนที่จะตอบสนอง การตอบสนองขั้นสุดท้ายที่ได้รับการประเมินนั้นได้รับคะแนนจากรูปแบบการประเมินผลที่ใช้ LLM ซึ่งช่วยให้แบบจำลองสามารถปรับปรุงคุณภาพตามประสิทธิภาพของการตอบสนองโดยไม่คำนึงถึงขั้นตอนการคิดโดยนัย นอกจากนี้ TPO ใช้การเพิ่มประสิทธิภาพการตั้งค่าโดยตรงเพื่อสร้างการตั้งค่าและการตอบสนองการปฏิเสธที่มีการคิดโดยนัยและปรับแต่งกระบวนการภายในของโมเดลผ่านรอบการฝึกอบรมหลายรอบ

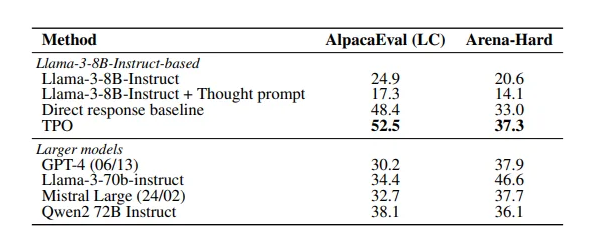

ผลการศึกษาแสดงให้เห็นว่าวิธี TPO ทำได้ดีในการเปรียบเทียบหลายแบบเหนือกว่ารุ่นที่มีอยู่หลากหลาย วิธีการนี้ไม่เพียง แต่ใช้กับงานเชิงตรรกะและคณิตศาสตร์เท่านั้น แต่ยังแสดงให้เห็นถึงศักยภาพในสาขาที่สร้างสรรค์เช่นงานด้านการตลาดและการปฏิบัติตามคำสั่งด้านสุขภาพ

กระดาษ: https://arxiv.org/pdf/2410.10630

ประเด็นสำคัญ:

เทคโนโลยี TPO ช่วยเพิ่มความสามารถในการคิดของแบบจำลองภาษาขนาดใหญ่ก่อนที่จะสร้างการตอบสนองเพื่อให้มั่นใจว่าการตอบสนองนั้นแม่นยำยิ่งขึ้น

ด้วยการให้เหตุผลในการให้เหตุผลในห่วงโซ่การคิดที่ดีขึ้นโมเดลสามารถเพิ่มประสิทธิภาพและปรับปรุงกระบวนการคิดภายในและปรับปรุงคุณภาพของการตอบสนอง

TPO เหมาะสำหรับหลากหลายสาขาไม่เพียง แต่สำหรับงานเชิงตรรกะและคณิตศาสตร์เท่านั้น แต่ยังรวมถึงความคิดสร้างสรรค์และสุขภาพ

ในระยะสั้นวิธี TPO ให้แนวคิดใหม่สำหรับการปรับปรุงประสิทธิภาพของแบบจำลองภาษาขนาดใหญ่ ลิงก์กระดาษสะดวกสำหรับผู้อ่านที่จะได้รับข้อมูลเชิงลึกเกี่ยวกับรายละเอียดทางเทคนิคและผลการทดลอง