ด้วยการพัฒนาอย่างรวดเร็วของโมเดลภาษาขนาดใหญ่หลายรูปแบบ (MLLMS) งานและงานที่เกี่ยวข้องกับวิดีโอได้นำไปสู่การพัฒนาที่ไม่เคยเกิดขึ้นมาก่อนโดยเฉพาะอย่างยิ่งในสาขาของคำถามและคำตอบที่มองเห็นการสร้างการเล่าเรื่องและการแก้ไขแบบโต้ตอบ อย่างไรก็ตามแม้จะมีความคืบหน้าอย่างมีนัยสำคัญในเทคโนโลยีเหล่านี้การบรรลุความเข้าใจเนื้อหาวิดีโอที่ละเอียดยังคงเป็นปัญหาที่ยากที่จะแก้ไข ความท้าทายนี้ไม่เพียง แต่เกี่ยวข้องกับการแบ่งส่วนและการติดตามระดับพิกเซลด้วยคำอธิบายภาษาเท่านั้น

แม้ว่ารูปแบบการรับรู้วิดีโอที่ทันสมัยในปัจจุบันทำงานได้ดีในการแบ่งส่วนและงานติดตาม แต่ก็ยังไม่เพียงพอในการทำความเข้าใจภาษาเปิดและความสามารถในการสนทนา วิดีโอ mllms แม้ว่าจะทำงานได้ดีในวิดีโอความเข้าใจและงานถาม - ตอบ แต่ก็ยังไม่สามารถจัดการงานการรับรู้และตัวชี้นำภาพได้ ข้อ จำกัด นี้ จำกัด การใช้งานของพวกเขาในสถานการณ์ที่กว้างขึ้น

โซลูชันที่มีอยู่ส่วนใหญ่แบ่งออกเป็นสองประเภท: แบบจำลองภาษาขนาดใหญ่หลายรูปแบบ (MLLMs) และระบบการแบ่งส่วนอ้างอิง MLLMS เริ่มต้นที่เน้นการปรับปรุงวิธีการฟิวชั่นแบบหลายรูปแบบและสารสกัดจากคุณลักษณะและค่อยๆพัฒนาเป็นกรอบสำหรับการปรับแต่งการเรียนการสอนเกี่ยวกับ LLM เช่น LLAVA เมื่อเร็ว ๆ นี้นักวิจัยได้พยายามรวมรูปภาพวิดีโอและการวิเคราะห์หลายภาพเข้าด้วยกันในกรอบเดียวเช่น LLAVA-OneVision ในขณะเดียวกันระบบการแบ่งส่วนอ้างอิงก็ผ่านการแปลงจากโมดูลฟิวชั่นพื้นฐานไปสู่การแบ่งส่วนและการติดตามแบบบูรณาการ อย่างไรก็ตามโซลูชันเหล่านี้ยังคงมีข้อบกพร่องในการรวมความสามารถในการรับรู้และความสามารถในการเข้าใจภาษาที่ครอบคลุม

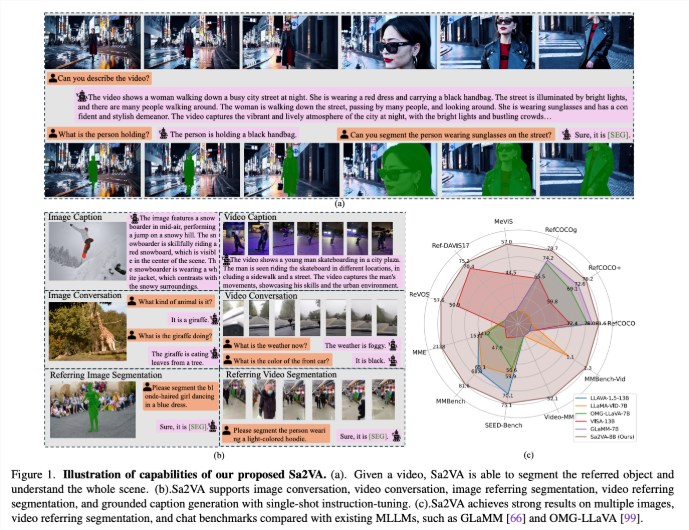

นักวิจัยจาก UC Merced, ทีม Bytedance Seed, Wuhan University และ Peking University ได้เสนอ Sa2va ซึ่งเป็นรูปแบบที่เป็นเอกภาพที่ก้าวล้ำซึ่งออกแบบมาเพื่อให้เข้าใจภาพและวิดีโอขั้นพื้นฐานอย่างเข้มข้น โมเดลนี้เอาชนะข้อ จำกัด ของโมเดลภาษาขนาดใหญ่หลายรูปแบบที่มีอยู่โดยการลดการปรับแต่งคำสั่งครั้งเดียวและรองรับงานภาพและวิดีโอที่หลากหลาย

SA2VA รวม SAM-2 เข้ากับ LLAVA เพื่อรวมข้อความรูปภาพและวิดีโอเข้ากับพื้นที่โทเค็น LLM ที่ใช้ร่วมกัน นอกจากนี้นักวิจัยได้เปิดตัวชุดข้อมูลคำอธิบายประกอบอัตโนมัติที่เรียกว่า REF-SAV ซึ่งมีการแสดงออกของวัตถุในสถานการณ์วิดีโอที่ซับซ้อนกว่า 72K และ 2K ที่ผ่านการตรวจสอบด้วยตนเองเพื่อให้แน่ใจว่ามีความสามารถในการเปรียบเทียบที่แข็งแกร่ง

สถาปัตยกรรมของ SA2VA ส่วนใหญ่ประกอบด้วยสองส่วน: โมเดลที่คล้ายกับ LLAVA และ SAM-2 และใช้การออกแบบ decoupling ใหม่ ส่วนประกอบที่มีลักษณะคล้าย LLAVA รวมถึงตัวเข้ารหัสภาพที่ประมวลผลภาพและวิดีโอเลเยอร์การฉายภาพด้วยภาพและ LLM สำหรับการทำนายโทเค็นข้อความ ระบบใช้วิธีการ decoupling ที่ไม่ซ้ำกันซึ่งช่วยให้ SAM-2 ทำงานถัดจากรุ่น LLAVA ที่ผ่านการฝึกอบรมมาก่อนโดยไม่มีการแลกเปลี่ยนโทเค็นโดยตรงดังนั้นจึงรักษาประสิทธิภาพการคำนวณและช่วยให้ปลั๊กอินและถอดปลั๊กด้วย MLLMs ที่ผ่านการฝึกอบรมมาก่อน

ผลการวิจัยแสดงให้เห็นว่า SA2VA ประสบความสำเร็จในการแบ่งส่วนที่ล้ำสมัยในงานการแบ่งส่วนการอ้างอิงด้วยโมเดล SA2VA-8B ที่มีคะแนน CIOU ใน RefCOCO, REFCOCO+ และ RefCOCOG ตามลำดับ ในแง่ของความสามารถในการสนทนา SA2VA ได้ผลลัพธ์ที่ยอดเยี่ยมของ 2128, 81.6 และ 75.1 ใน MME, MMBENCH และ SEED-BENCH ตามลำดับ

นอกจากนี้ประสิทธิภาพของ SA2VA ในการวัดภาพวิดีโอนั้นเหนือกว่าสถานะก่อนหน้านี้อย่างมีนัยสำคัญ-VISA-13B ซึ่งแสดงประสิทธิภาพและประสิทธิภาพในงานภาพและความเข้าใจวิดีโอ

กระดาษ: https://arxiv.org/abs/2501.04001

รุ่น: https://huggingface.co/collections/bytedance/sa2va-model-zoo-677e3084d71b5f108d00e093

ประเด็นสำคัญ:

Sa2va เป็นกรอบ AI แบบครบวงจรใหม่ที่บรรลุความเข้าใจในเชิงลึกของภาพและวิดีโอและเอาชนะข้อ จำกัด ของโมเดลหลายรูปแบบที่มีอยู่

โมเดลดังกล่าวได้รับผลลัพธ์ที่ล้ำสมัยในการเปรียบเทียบหลายประการเช่นการแบ่งส่วนการอ้างอิงและความสามารถในการสนทนาแสดงประสิทธิภาพที่โดดเด่น

การออกแบบ SA2VA รวมความสามารถด้านภาพและความเข้าใจภาษาอย่างมีประสิทธิภาพผ่านวิธีการแยกส่วนรองรับงานภาพและวิดีโอที่หลากหลาย