加入我们的微信或NPU用户群。

[ 英语 | 中文]

微调大型语言模型可以很容易......

选择你的路径:

Colab :https://colab.research.google.com/drive/1eRTPn37ltBbYsISy9Aw2NuI2Aq5CQrD9?usp=sharing

PAI-DSW :Llama3 示例 | Qwen2-VL 示例

本机:请参考使用方法

文档(WIP) :https://llamafactory.readthedocs.io/zh-cn/latest/

近期活动:

2024/10/18-2024/11/30 : 使用 PAI+LLaMA Factory 构建个人导游机器人。 [网站]

笔记

除上述链接外,所有其他网站均为未经授权的第三方网站。请小心使用它们。

特征

基准

变更日志

支持型号

支持的培训方法

提供的数据集

要求

入门

使用 LLaMA Factory 的项目

执照

引文

致谢

各种型号:LLaMA、LLaVA、Mistral、Mixtral-MoE、Qwen、Qwen2-VL、Yi、Gemma、Baichuan、ChatGLM、Phi 等。

综合方法:(连续)预训练、(多模态)监督微调、奖励建模、PPO、DPO、KTO、ORPO等。

可扩展资源:16位全调优、冻结调优、LoRA和2/3/4/5/6/8位QLoRA(通过AQLM/AWQ/GPTQ/LLM.int8/HQQ/EETQ)。

高级算法:GaLore、BAdam、Adam-mini、DoRA、LongLoRA、LLaMA Pro、Mixture-of-Depths、LoRA+、LoftQ、PiSSA 和 Agent 调整。

实用技巧:FlashAttention-2、Unsloth、Liger Kernel、RoPE 缩放、NEFTune 和 rsLoRA。

实验监视器:LlamaBoard、TensorBoard、Wandb、MLflow等

更快的推理:OpenAI 风格的 API、Gradio UI 和 CLI 以及 vLLM Worker。

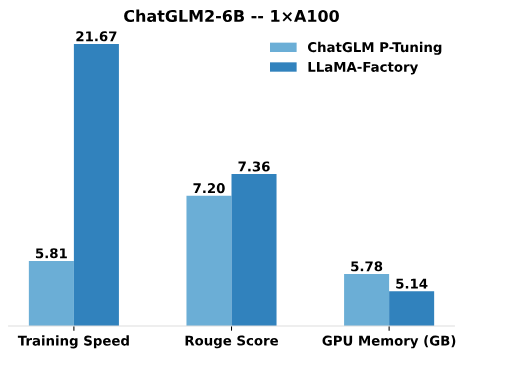

与 ChatGLM 的 P-Tuning 相比,LLaMA Factory 的 LoRA 调优可将训练速度提高 3.7 倍,并在广告文本生成任务上获得更好的 Rouge 分数。通过利用 4 位量化技术,LLaMA Factory 的 QLoRA 进一步提高了 GPU 内存的效率。

训练速度:训练期间每秒处理的训练样本数。 (bs=4,cutoff_len=1024)

Rouge Score :广告文本生成任务开发集的 Rouge-2 分数。 (bs=4,cutoff_len=1024)

GPU 内存:4 位量化训练中 GPU 内存使用峰值。 (bs=1,cutoff_len=1024)

我们对 ChatGLM 的 P 调优采用pre_seq_len=128 ,对 LLaMA Factory 的 LoRA 调优采用lora_rank=32 。

[2009年10月24日] 我们支持从Modelers Hub下载预训练的模型和数据集。使用方法请参阅本教程。

[24/09/19] 我们支持Qwen2.5模型的微调。

[24/08/30] 我们支持对Qwen2-VL模型进行微调。感谢@simonJJJ 的公关。

[27/08/24] 我们支持Liger 内核。尝试使用enable_liger_kernel: true进行高效训练。

[24/08/09] 我们支持Adam-mini优化器。请参阅使用示例。感谢@relic-yuexi 的公关。

[24/07/04] 我们支持无污染包装培训。使用neat_packing: true来激活它。感谢@chuan298 的公关。

[24/06/16] 我们支持PiSSA算法。请参阅使用示例。

[24/06/07] 我们支持对Qwen2和GLM-4模型进行微调。

[26/05/24] 我们支持SimPO算法进行偏好学习。请参阅使用示例。

[2020年5月24日] 我们支持对PaliGemma系列模型进行微调。请注意,PaliGemma 模型是预先训练的模型,您需要使用paligemma模板对其进行微调以完成聊天。

[24/05/18] 我们支持偏好学习的KTO算法。请参阅使用示例。

[2014-05-24] 支持在Ascend NPU设备上进行训练和推理。有关详细信息,请检查安装部分。

[26/04/24] 我们支持对LLaVA-1.5多模式法学硕士进行微调。请参阅使用示例。

[22/04/24] 我们提供了一个Colab 笔记本,用于在免费的 T4 GPU 上微调 Llama-3 模型。 Hugging Face 提供了使用 LLaMA Factory 微调的两个 Llama-3 衍生模型,请查看 Llama3-8B-Chinese-Chat 和 Llama3-Chinese 了解详细信息。

[21/04/24] 我们根据 AstraMindAI 的实现支持Mixture-of-Depths 。请参阅使用示例。

[24/04/16] 我们支持BAdam优化器。请参阅使用示例。

[24/04/16] 支持unsloth的长序列训练(24GB以内的Llama-2-7B-56k)。与 FlashAttention-2 相比,它实现了117% 的速度和50% 的内存,更多基准测试可以在本页找到。

[24/03/31] 我们支持ORPO 。请参阅使用示例。

[21/03/24] 我们的论文“LlamaFactory: Unified Efficient Fine-Tuning of 100+ Language Models”已在 arXiv 发布!

[2020年3月24日] 我们支持FSDP+QLoRA ,可在 2x24GB GPU 上微调 70B 模型。请参阅使用示例。

[2013年3月24日] 我们支持LoRA+ 。请参阅使用示例。

[2007年3月24日] 我们支持GaLore优化器。请参阅使用示例。

[2007 年 3 月 24 日] 我们集成了vLLM以实现更快的并发推理。尝试infer_backend: vllm享受270% 的推理速度。

[28/02/24] 我们支持权重分解的LoRA( DoRA )。尝试使用use_dora: true来激活 DoRA 训练。

[24/02/15] 我们支持LLaMA Pro提出的块扩展。请参阅使用示例。

[24/02/05] LLaMA-Factory支持Qwen1.5(Qwen2 beta版)系列模型。查看此博客文章了解详细信息。

[24/01/18] 我们支持大多数模型的代理调整,通过dataset: glaive_toolcall_en的微调为模型配备工具使用能力。

[23/12/23] 我们支持unsloth的实现,以促进 LLaMA、Mistral 和 Yi 模型的 LoRA 调整。尝试使用use_unsloth: true参数来激活 unsloth 补丁。它在我们的基准测试中实现了170% 的速度,请查看此页面了解详细信息。

[23/12/12] 我们支持在我们的框架中微调最新的 MoE 模型Mixtral 8x7B 。请参阅此处的硬件要求。

[23/12/01] 我们支持从ModelScope Hub下载预训练的模型和数据集。使用方法请参阅本教程。

[21/10/23] 我们支持NEFTune技巧进行微调。尝试使用neftune_noise_alpha: 5参数来激活 NEFTune。

[27/09/23] 我们支持shift_attn: true参数来启用转移短期注意力。

[23/09/23] 我们在此存储库中集成了 MMLU、C-Eval 和 CMMLU 基准测试。请参阅使用示例。

[23/09/10] 我们支持FlashAttention-2 。如果您使用的是 RTX4090、A100 或 H100 GPU,请尝试使用flash_attn: fa2参数来启用 FlashAttention-2。

[23/08/12] 我们支持RoPE 缩放以扩展 LLaMA 模型的上下文长度。尝试使用rope_scaling: linear参数”和rope_scaling: dynamic参数”来推断位置嵌入。

[23/08/11] 我们支持针对指令调整模型的DPO 培训。请参阅使用示例。

[23/07/31] 我们支持数据集流式传输。尝试使用streaming: true和max_steps: 10000参数以流模式加载数据集。

[23/07/29] 我们在 Hugging Face 发布了两款指令调校的 13B 模型。有关详细信息,请参阅这些 Hugging Face Repos (LLaMA-2 / Baichuan)。

[23/07/18] 我们开发了一个用于训练、评估和推理的一体化 Web UI 。尝试train_web.py在 Web 浏览器中微调模型。感谢@KanadeSiina 和@codemayq 在开发中所做的努力。

[23/07/09] 我们发布了FastEdit ⚡?,一个易于使用的软件包,用于高效编辑大型语言模型的事实知识。感兴趣的话请关注FastEdit。

[23/06/29] 我们提供了一个使用指令跟踪数据集训练聊天模型的可重复示例,详细信息请参阅 Baichuan-7B-sft。

[22/06/23] 我们将演示 API 与 OpenAI 的格式保持一致,您可以在任意基于 ChatGPT 的应用程序中插入微调后的模型。

[23/06/03] 我们支持量化训练和推理(又名QLoRA )。请参阅使用示例。

| 模型 | 型号尺寸 | 模板 |

|---|---|---|

| 百川2号 | 7B/13B | 百川2 |

| 布卢姆/布卢姆兹 | 560M/1.1B/1.7B/3B/7.1B/176B | - |

| 聊天GLM3 | 6B | 聊天glm3 |

| 命令R | 35B/104B | 连贯 |

| DeepSeek(代码/MoE) | 7B/16B/67B/236B | 深度搜索 |

| 鹘 | 7B/11B/40B/180B | 鹘 |

| 杰玛/杰玛 2/CodeGemma | 2B/7B/9B/27B | 芽 |

| GLM-4 | 9B | GLM4 |

| 实习生LM2/实习生LM2.5 | 7B/20B | 实习生2 |

| 骆驼 | 7B/13B/33B/65B | - |

| 骆驼2 | 7B/13B/70B | 骆驼2 |

| 骆驼3-3.2 | 1B/3B/8B/70B | 骆驼3 |

| LLaVA-1.5 | 7B/13B | 拉瓦 |

| LLaVA-NeXT | 7B/8B/13B/34B/72B/110B | llava_下一个 |

| LLaVA-NeXT-视频 | 7B/34B | llava_下一个视频 |

| 最小每千次展示费用 | 1B/2B/4B | 每千次展示费用/每千次展示费用3 |

| 米斯特拉尔/米斯特拉尔 | 7B/8x7B/8x22B | 米斯塔拉尔 |

| OLMo | 1B/7B | - |

| 巴利语杰玛 | 3B | 帕利格玛 |

| Φ1.5/Φ2 | 1.3B/2.7B | - |

| Φ3 | 4B/7B/14B | 菲 |

| 皮克斯特拉尔 | 12B | 像素化 |

| Qwen (1-2.5)(代码/数学/教育部) | 0.5B/1.5B/3B/7B/14B/32B/72B/110B | 曲文 |

| Qwen2-VL | 2B/7B/72B | qwen2_vl |

| 星编码器2 | 3B/7B/15B | - |

| XVERSE | 7B/13B/65B | 宇宙 |

| Yi/Yi-1.5(代码) | 1.5B/6B/9B/34B | 伊 |

| 易-VL | 6B/34B | 易_vl |

| 2元 | 2B/51B/102B | 元 |

笔记

对于“base”模型, template参数可以从default 、 alpaca 、 vicuna等中选择。但请确保为“instruct/chat”模型使用相应的模板。

请记住在训练和推理中使用相同的模板。

请参阅constants.py以获取我们支持的模型的完整列表。

您还可以将自定义聊天模板添加到 template.py。

| 方法 | 全面调校 | 冻结调谐 | 洛拉 | QLoRA |

|---|---|---|---|---|

| 预训练 | ✅ | ✅ | ✅ | ✅ |

| 监督微调 | ✅ | ✅ | ✅ | ✅ |

| 奖励模型 | ✅ | ✅ | ✅ | ✅ |

| PPO培训 | ✅ | ✅ | ✅ | ✅ |

| DPO 培训 | ✅ | ✅ | ✅ | ✅ |

| 韩国旅游局培训 | ✅ | ✅ | ✅ | ✅ |

| 奥普培训 | ✅ | ✅ | ✅ | ✅ |

| SimPO 培训 | ✅ | ✅ | ✅ | ✅ |

提示

PPO的实现细节可以在这篇博客中找到。

维基演示(英文)

精致网络 (en)

红色睡衣 V2(zh)

维基百科(en)

维基百科 (zh)

桩 (zh)

SkyPile (zh)

FineWeb(英文)

FineWeb-Edu(en)

堆栈 (zh)

StarCoder(英文)

身份(英文&中文)

斯坦福羊驼毛 (zh)

斯坦福羊驼 (zh)

羊驼毛 GPT4(en&zh)

Glaive 函数调用 V2(en&zh)

利马 (zh)

原驼数据集(多语言)

百丽 2M (zh)

百丽 1M (zh)

百丽 0.5M (zh)

美女对话0.4M (zh)

百丽学校数学 0.25M (zh)

BELLE 多轮聊天 0.8M (zh)

UltraChat(zh)

OpenPlatypus (en)

CodeAlpaca 20k(en)

羊驼 CoT(多语言)

OpenOrca(zh)

SlimOrca (zh)

数学指导 (en)

萤火虫 1.1M (zh)

维基质量检查(英文)

网络质量检查 (zh)

网络小说 (zh)

花蜜 (zh)

深度控制(英语和中文)

广告生成 (zh)

ShareGPT 超过滤 (en)

ShareGPT4(en&zh)

UltraChat 200k(英文)

代理指示 (en)

LMSYS 聊天 1M(en)

Evol 指导 V2(英文)

宇宙百科(英文)

STEM(中文)

若知霸 (zh)

Neo-sft (zh)

WebInstructSub (en)

Magpie-Pro-300K-过滤(英文)

Magpie-ultra-v0.1(zh)

LLaVA 混合 (en&zh)

Pokemon-gpt4o-字幕(en&zh)

打开助手(德)

多莉 15k(德)

羊驼毛 GPT4(德)

OpenSchnabeltier (德)

Evol 指导 (德)

海豚 (德)

书本总和 (de)

艾洛波罗斯 (de)

Ultrachat (德)

DPO 混合(英文和中文)

超反馈(英文)

RLHF-V(英文)

VL 反馈 (en)

Orca DPO 对 (zh)

HH-RLHF (zh)

花蜜 (zh)

Orca DPO(德)

KTO 混合 (en)

某些数据集在使用前需要确认,因此我们建议使用这些命令使用您的 Hugging Face 帐户登录。

pip install --升级 Huggingface_hub Huggingface-cli 登录

| 强制的 | 最低限度 | 推荐 |

|---|---|---|

| Python | 3.8 | 3.11 |

| 火炬 | 1.13.1 | 2.4.0 |

| 变形金刚 | 4.41.2 | 4.43.4 |

| 数据集 | 2.16.0 | 2.20.0 |

| 加速 | 0.30.1 | 0.32.0 |

| 佩夫特 | 0.11.1 | 0.12.0 |

| 特尔 | 0.8.6 | 0.9.6 |

| 选修的 | 最低限度 | 推荐 |

|---|---|---|

| CUDA | 11.6 | 12.2 |

| 深速 | 0.10.0 | 0.14.0 |

| 位和字节 | 0.39.0 | 0.43.1 |

| 弗洛姆 | 0.4.3 | 0.5.0 |

| 闪光注意事项 | 2.3.0 | 2.6.3 |

*估计的

| 方法 | 位 | 7B | 13B | 30B | 70B | 110B | 8x7B | 8x22B |

|---|---|---|---|---|---|---|---|---|

| 满的 | AMP | 120GB | 240GB | 600GB | 1200GB | 2000GB | 900GB | 2400GB |

| 满的 | 16 | 60GB | 120GB | 300GB | 600GB | 900GB | 400GB | 1200GB |

| 冻结 | 16 | 20GB | 40GB | 80GB | 200GB | 360GB | 160GB | 400GB |

| LoRA/GaLore/BAdam | 16 | 16 GB | 32GB | 64GB | 160GB | 240GB | 120GB | 320GB |

| QLoRA | 8 | 10GB | 20GB | 40GB | 80GB | 140GB | 60GB | 160GB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | 72GB | 30GB | 96GB |

| QLoRA | 2 | 4GB | 8GB | 16 GB | 24GB | 48GB | 18GB | 48GB |

重要的

安装是强制性的。

git clone --深度 1 https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factory pip install -e ".[torch,metrics]"

可用的额外依赖项:torch、torch-npu、metrics、deepspeed、liger-kernel、bitsandbytes、hqq、eetq、gptq、awq、aqlm、vllm、galore、badam、adam-mini、qwen、modelscope、openmind、quality

提示

使用pip install --no-deps -e .解决包冲突。

如果您想在Windows平台上启用量化LoRA(QLoRA),您需要安装预构建版本的bitsandbytes库,该库支持CUDA 11.1至12.2,请根据您的CUDA版本选择合适的发行版本。

pip 安装 https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl

要在Windows平台上启用FlashAttention-2,需要安装预编译的flash-attn库,该库支持CUDA 12.1至12.2。请根据您的需求从flash-attention下载对应版本。

要在 Ascend NPU 设备上安装 LLaMA Factory,请指定额外的依赖项: pip install -e ".[torch-npu,metrics]" 。此外,您还需要安装Ascend CANN Toolkit 和 Kernels 。请按照安装教程或使用以下命令:

# 根据您的CANN版本和设备替换url# 安装CANN Toolkitwget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-toolkit_8 .0.RC1.alpha001_linux-"$(uname -i)".run bash Ascend-cann-toolkit_8.0.RC1.alpha001_linux-"$(uname -i)".run --install# 安装 CANN Kernelswget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run bash Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run --install# 设置环境变量source /usr/local/Ascend/ascend-toolkit/set_env.sh

| 要求 | 最低限度 | 推荐 |

|---|---|---|

| 坎恩 | 8.0.RC1 | 8.0.RC1 |

| 火炬 | 2.1.0 | 2.1.0 |

| 火炬-NPU | 2.1.0 | 2.1.0.post3 |

| 深速 | 0.13.2 | 0.13.2 |

请记住使用ASCEND_RT_VISIBLE_DEVICES而不是CUDA_VISIBLE_DEVICES来指定要使用的设备。

如果无法在 NPU 设备上推断模型,请尝试在配置中设置do_sample: false 。

下载预构建的 Docker 镜像:32GB | 64GB

有关数据集文件格式的详细信息,请参阅 data/README.md。您可以使用 HuggingFace / ModelScope / Modelers hub 上的数据集,也可以将数据集加载到本地磁盘中。

笔记

请更新data/dataset_info.json以使用您的自定义数据集。

使用以下3条命令分别运行Llama3-8B-Instruct模型的LoRA微调、推理和合并。

llamafactory-cli 火车示例/train_lora/llama3_lora_sft.yaml llamafactory-cli 聊天示例/inference/llama3_lora_sft.yaml llamafactory-cli 导出示例/merge_lora/llama3_lora_sft.yaml

有关高级用法(包括分布式训练),请参阅示例/README.md。

提示

使用llamafactory-cli help显示帮助信息。

llamafactory-cli webui

对于 CUDA 用户:

cd docker/docker-cuda/ docker 组成-d docker compose exec llamafactory bash

对于升腾NPU用户:

cd docker/docker-npu/ docker 组成-d docker compose exec llamafactory bash

对于 AMD ROCm 用户:

cd docker/docker-rocm/ docker 组成-d docker compose exec llamafactory bash

对于 CUDA 用户:

docker build -f ./docker/docker-cuda/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:最新的 .docker run -dit --gpus=all

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/应用程序/数据

-v ./输出:/应用程序/输出

-p 7860:7860

-p 8000:8000

--shm-大小16G

--名称 llamafactory

骆驼工厂:最新

docker exec -it llamafactory bash对于升腾NPU用户:

# 根据您的环境选择 docker 镜像docker build -f ./docker/docker-npu/Dockerfile

--build-arg INSTALL_DEEPSPEED=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:latest .# 根据您的资源更改 `device`docker run -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/应用程序/数据

-v ./输出:/应用程序/输出

-v /usr/local/dcmi:/usr/local/dcmi

-v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver

-v /etc/ascend_install.info:/etc/ascend_install.info

-p 7860:7860

-p 8000:8000

--设备/dev/davinci0

--设备/dev/davinci_manager

--设备/dev/devmm_svm

--设备/dev/hisi_hdc

--shm-大小16G

--名称 llamafactory

骆驼工厂:最新

docker exec -it llamafactory bash对于 AMD ROCm 用户:

docker build -f ./docker/docker-rocm/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:最新的 .docker run -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/应用程序/数据

-v ./输出:/应用程序/输出

-v ./保存:/应用程序/保存

-p 7860:7860

-p 8000:8000

--设备/dev/kfd

--设备/dev/dri

--shm-大小16G

--名称 llamafactory

骆驼工厂:最新

docker exec -it llamafactory bashhf_cache :利用主机上的 Hugging Face 缓存。如果缓存已存在于不同的目录中,则可重新分配。

ms_cache :与 Hugging Face 缓存类似,但适用于 ModelScope 用户。

om_cache :与 Hugging Face 缓存类似,但适用于建模者用户。

data :将数据集放置在主机的此目录中,以便可以在 LLaMA Board GUI 上选择它们。

output :将导出目录设置为该位置,以便可以在主机上直接访问合并结果。

API_PORT=8000 llamafactory-cli api 示例/inference/llama3_vllm.yaml

提示

访问此页面获取 API 文档。

示例:图像理解 |函数调用

如果您在从 Hugging Face 下载模型和数据集时遇到问题,可以使用 ModelScope。

export USE_MODELSCOPE_HUB=1 # 对于 Windows 设置 USE_MODELSCOPE_HUB=1

通过将 ModelScope Hub 的模型 ID 指定为model_name_or_path来训练模型。您可以在 ModelScope Hub 上找到模型 ID 的完整列表,例如LLM-Research/Meta-Llama-3-8B-Instruct 。

您还可以使用 Modelers Hub 下载模型和数据集。

export USE_OPENMIND_HUB=1 # 对于 Windows 设置 USE_OPENMIND_HUB=1

通过将 Modelers Hub 的模型 ID 指定为model_name_or_path来训练模型。您可以在 Modelers Hub 找到模型 ID 的完整列表,例如TeleAI/TeleChat-7B-pt 。

要使用权重和偏差来记录实验结果,您需要将以下参数添加到 yaml 文件中。

report_to: wandbrun_name: test_run # 可选

在启动训练任务时将WANDB_API_KEY设置为您的密钥,以使用您的 W&B 帐户登录。

如果您有需要合并的项目,请通过电子邮件联系或创建拉取请求。

王等人。 ESRL:用于序列生成的高效基于采样的强化学习。 2023. [arxiv]

于等人。用于文本分类的开放式、封闭式或小型语言模型? 2023. [arxiv]

王等人。 UbiPhysio:通过自然语言的动作理解和反馈支持日常功能、健身和康复。 2023. [arxiv]

卢切里等人。利用大型语言模型检测社交媒体中的影响力活动。 2023. [arxiv]

张等人。通过诱导幻觉减轻大语言模型的幻觉。 2023. [arxiv]

王等人。更好地了解您的需求:通过类比推理增强法学硕士对营销人员需求进行结构化理解。 KDD 2024。 [arxiv]

王等人。 CANDLE:从大型语言模型中进行常识推理的迭代概念化和实例化蒸馏。 ACL 2024。 [arxiv]

崔等人。 FACT-GPT:通过与法学硕士的索赔匹配增强事实核查。 2024.[arxiv]

张等人。 AutoMathText:使用数学文本语言模型进行自主数据选择。 2024.[arxiv]

吕等人。 KnowTuning:大型语言模型的知识感知微调。 2024.[arxiv]

杨等人。 LaCo:通过层折叠进行大型语言模型修剪。 2024. [arxiv]

巴德瓦吉等人。语言模型是荷马·辛普森!通过任务算术对微调语言模型进行安全重新调整。 2024. [arxiv]

杨等人。通过使用小型同理心模型增强法学硕士来增强同理心响应的生成。 2024. [arxiv]

易等人。一代遇见验证:通过智能并行自动更正解码加速大型语言模型推理。 ACL 2024 调查结果。 [arxiv]

曹等人。大型语言模型的 Head-wise 可共享注意力。 2024. [arxiv]

张等人。通过资源丰富的语言的自我蒸馏增强大型语言模型的多语言能力。 2024. [arxiv]

金等人。面向多语言大型语言模型的高效且有效的词汇扩展。 2024. [arxiv]

于等人。 KIEval:基于知识的大型语言模型交互式评估框架。 ACL 2024。[arxiv]

黄等人。关键点驱动的数据合成及其数学推理的增强。 2024. [arxiv]

段等人。否定阴性:通过分布偏好优化在没有人类阳性样本的情况下进行比对。 2024. [arxiv]

谢和施韦特费格。使用大型语言模型增强机器人技术:osmAG 与法学硕士的地图理解。 2024. [arxiv]

吴等人。大型语言模型是并行的多语言学习器。 2024. [arxiv]

张等人。 EDT:通过基于熵的动态温度采样改进大型语言模型的生成。 2024. [arxiv]

韦勒等人。 FollowIR:评估和教授信息检索模型以遵循说明。 2024. [arxiv]

娜宏斌. CBT-LLM:基于认知行为治疗的心理健康问答的中文大语言模型。科林 2024。 [arxiv]

赞等人。 CodeS:通过多层草图将自然语言转换为代码存储库。 2024. [arxiv]

刘等人。广泛的自我对比可实现无反馈的语言模型对齐。 2024. [arxiv]

罗等人。 BAdam:一种用于大型语言模型的内存高效全参数训练方法。 2024. [arxiv]

杜等人。中文小型法学硕士:预训练以中文为中心的大语言模型。 2024. [arxiv]

马等人。通过吉文斯旋转进行参数高效准正交微调。 ICML 2024。 [arxiv]

刘等人。使用大型语言模型动态生成个性。 2024. [arxiv]

尚等人。我们在使用大型语言模型理解剥离二进制代码方面已经走了多远。 2024. [arxiv]

黄等人。 LLMTune:使用大型语言模型加速数据库旋钮调整。 2024. [arxiv]

邓等人。文本-元组-表:通过全局元组提取实现文本到表生成中的信息集成。 2024. [arxiv]

阿奇科兹等人。希波克拉底:用于推进医疗保健领域大型语言模型的开源框架。 2024. [arxiv]

张等人。小语言模型需要强大的验证器来自我纠正推理。 ACL 2024 调查结果。 [arxiv]

周等人。 FREB-TQA:表问答的细粒度鲁棒性评估基准。 NAACL 2024。 [arxiv]

徐等人。网络安全的大型语言模型:系统文献综述。 2024. [arxiv]

达穆等人。 “他们没有文化”:在法学硕士生成的对话中揭示隐性危害和社会威胁。 2024. [arxiv]

易等人。通过大型语言模型的面向子空间的模型融合的安全重新调整框架。 2024. [arxiv]

卢等人。 SPO:具有隐式奖励建模的多维偏好顺序对齐。 2024. [arxiv]

张等人。事半功倍:大型语言模型是良好的自发多语言学习者。 2024. [arxiv]

张等人。 TS-Align:用于大型语言模型可扩展迭代微调的师生协作框架。 2024. [arxiv]

陈子宏.基于XunziALLM的分句和句子标点。 2024.[论文]

高等人。两全其美:建立一个诚实且有用的大型语言模型。 2024. [arxiv]

王、宋. MARS:使用多任务评估数据集对语言模型的形而上推理能力进行基准测试。 2024. [arxiv]

胡等人。基于 Transformer 的模型的低秩适应 (LoRA) 的计算限制。 2024. [arxiv]

葛等人。通过高效微调进行时间敏感的知识编辑。 ACL 2024。[arxiv]

谭等人。同行评审是一种具有基于角色的交互的多轮、长上下文对话。 2024. [arxiv]

宋等人。 Turbo Sparse:以最少的激活参数实现 LLM SOTA 性能。 2024. [arxiv]

顾等人。 RWKV-CLIP:强大的视觉语言表示学习器。 2024. [arxiv]

陈等人。推进工具增强的大型语言模型:整合推理树中错误的见解。 2024.[arxiv]

朱等人。大型语言模型是好的统计学家吗? 2024. [arxiv]

李等人。了解未知:LLM 指令调整的不确定性敏感方法。 2024. [arxiv]

丁等人。 IntentionQA:评估电子商务语言模型购买意图理解能力的基准。 2024. [arxiv]

他等人。社区跨指令:用于使大型语言模型与在线社区保持一致的无监督指令生成。 2024. [arxiv]

林等人。 FVEL:通过定理证明使用大型语言模型的交互式形式验证环境。 2024. [arxiv]

特罗伊特兰等人。连接点:法学硕士可以从不同的训练数据中推断和表达潜在结构。 2024. [arxiv]

冯等人。 SS-Bench:社会故事生成和评估的基准。 2024. [arxiv]

冯等人。具有细粒度对齐增强的自构建上下文反编译。 2024. [arxiv]

刘等人。用于通过可穿戴生物信号进行无袖血压测量的大型语言模型。 2024. [arxiv]

艾耶等人。与法学硕士探索极低资源翻译:爱丁堡大学提交给 AmericasNLP 2024 翻译任务。 AmericasNLP 2024。[论文]

李等人。通过思维树上的偏好优化来校准法学硕士,以生成科学问题评分的基本原理。 2024. [arxiv]

杨等人。金融知识大语言模型。 2024. [arxiv]

林等人。 DogeRM:通过模型合并为奖励模型配备领域知识。 2024. [arxiv]

巴科等人。评估法学硕士在数据可视化中自然语言表达的语义分析能力。 2024. [arxiv]

黄等人。 RoLoRA:微调旋转无离群点 LLM 以实现有效的权重激活量化。 2024. [arxiv]

江等人。法学硕士-面向普通观众的自动科学新闻合作。 2024. [arxiv]

井上等人。在 LoRA 超参数上应用自动调整。 2024.[论文]

齐等人。基于法学硕士的西藏旅游观点信息生成系统研究2024. [arxiv]

徐等人。路线修正:使用综合偏好进行安全调整。 2024. [arxiv]

孙等人。 LAMBDA:基于大型模型的数据代理。 2024. [arxiv]

朱等人。 CollectiveSFT:通过医疗保健领域的集体指令扩展中国医学基准的大型语言模型。 2024. [arxiv]

于等人。通过负注意力分数对齐来纠正大型语言模型中的负偏差。 2024. [arxiv]

谢等人。个性化数据集的力量:通过有针对性的模型微调推进小学语文作文写作。 IALP 2024。[论文]

刘等人。 Instruct-Code-Llama:通过在线评委反馈提高语言模型在竞赛级代码生成中的能力。 ICIC 2024。[论文]

王等人。控制论哨兵:揭示安全数据选择对监督微调中模型安全性的影响。 ICIC 2024。[论文]

夏等人。了解 LLM 微调的性能并估计其成本。 2024. [arxiv]

曾等人。感知、反思和计划:设计 LLM 代理,用于无指令的目标导向城市导航。 2024. [arxiv]

夏等人。使用预先训练的语言模型进行准确的 ESG 预测。 FinNLP 2024。[论文]

梁等人。 I-SHEEP:法学硕士通过迭代自我增强范式从头开始自我调整。 2024. [arxiv]

StarWhisper :基于 ChatGLM2-6B 和 Qwen-14B 的大型天文学语言模型。

DISC-LawLLM :基于Baichuan-13B的专门针对中文法律领域的大型语言模型,能够对法律知识进行检索和推理。

Sunsimiao :专门针对中医领域的大型语言模型,基于Baichuan-7B和ChatGLM-6B。

CareGPT :一系列针对中文医学领域的大型语言模型,基于LLaMA2-7B和Baichuan-13B。

MachineMindset :一系列 MBTI Personality 大语言模型,能够根据不同的数据集和训练方法赋予任何 LLM 16 种不同的性格类型。

Luminia-13B-v3 :一种大型语言模型,专门用于生成稳定扩散的元数据。 [演示]

Chinese-LLaVA-Med :基于LLaVA-1.5-7B的专门针对中医领域的多模态大语言模型。

AutoRE :基于大语言模型的文档级关系抽取系统。

NVIDIA RTX AI 工具包:用于在 Windows PC 上针对 NVIDIA RTX 微调 LLM 的 SDK。

LazyLLM :一种构建多代理 LLM 应用程序的简单而懒惰的方法,并支持通过 LLaMA Factory 进行模型微调。

RAG-Retrieval :用于 RAG 检索模型微调、推理和蒸馏的完整管道。 [博客]

该存储库根据 Apache-2.0 许可证获得许可。

请按照模型授权使用相应的模型权重:Baichuan 2 / BLOOM / ChatGLM3 / Command R / DeepSeek / Falcon / Gemma / GLM-4 / InternLM2 / Llama / Llama 2 (LLaVA-1.5) / Llama 3 / MiniCPM / Mistral /Mixtral/Pixtral / OLMo / Phi-1.5/Phi-2 / Phi-3 / Qwen / StarCoder 2 / XVERSE / Yi / Yi-1.5 / Yuan 2

如果这项工作有帮助,请引用为:

@inproceedings{zheng2024llamafactory, title={LlamaFactory:100+语言模型的统一高效微调},author={郑耀伟、张日冲、张俊豪、叶彦涵、罗哲彦、冯张驰、马永强},booktitle={计算语言学协会第62届年会论文集(卷3:系统演示)},地址={泰国曼谷},出版商={计算语言学协会},年份={2024},url={http://arxiv.org/abs/2403.13372}}该存储库受益于 PEFT、TRL、QLoRA 和 FastChat。感谢他们的精彩作品。