5/8/2024 :更新 GPT-3.5 和 LLama2 推理代码以及图 6 的结果,显示了认知协同作用的新兴本质。3/15/2024 :该论文已被NAACL2024接受为主要会议论文! pip install -r requirements.txt

config_template.sh中设置 OpenAI API 配置并运行source config_template.sh以设置环境变量(请注意,我们在实验中使用 Azure API) 我们为这三个任务中的每一个提供了运行脚本,请查看“.sh”脚本中的注释以获取更多信息:

bash scripts/trivia_creative_writing.shbash scripts/codenames_collaborative.shbash scripts/logic_grid_puzzle.sh 所有提示都可以在prompts/文件夹中找到。

所有数据集都可以在data/文件夹中找到。

论文中每个任务的实验结果可以在logs/文件夹中找到。 gpt4_w_sys_mes和gpt4_wo_sys_mes包含与我们论文中表 2 相对应的结果。我们还包括与图 6 中的结果相对应的 gpt-3.5 和 llama2-13b 结果,其中超参数(例如是否添加系统消息)遵循 gpt4 实验中的最佳性能选择。

"test_output_infos" :包含每个实例的评估指标,例如,提到的#正确答案。"*raw_responses" :来自每个 API 调用的原始响应。"*parsing_flag" :原始响应是否已成功解析。 (对于 Codenames 任务,该字段分为“parsing_success_flag_spymaster”和“parsing_success_flag_guesser”)"unwrapped_output" :将用于计算评估指标的解析输出。 (对于 Codenames 任务,该字段分为“spymaster_output”和“guesser_output”;还有一个名为“hint_word”的附加字段,该字段从间谍大师的输出中解析并插入到 Guesser 的输入中;评估指标是根据“猜测者输出”)"task data" :当前任务实例的数据,例如问题、答案、目标词等。"usage" :记录迄今为止花费的代币数量和成本。如果您发现这项工作有趣/有帮助,请引用该论文并为该存储库加注星标。

@article{wang2023unleashing,

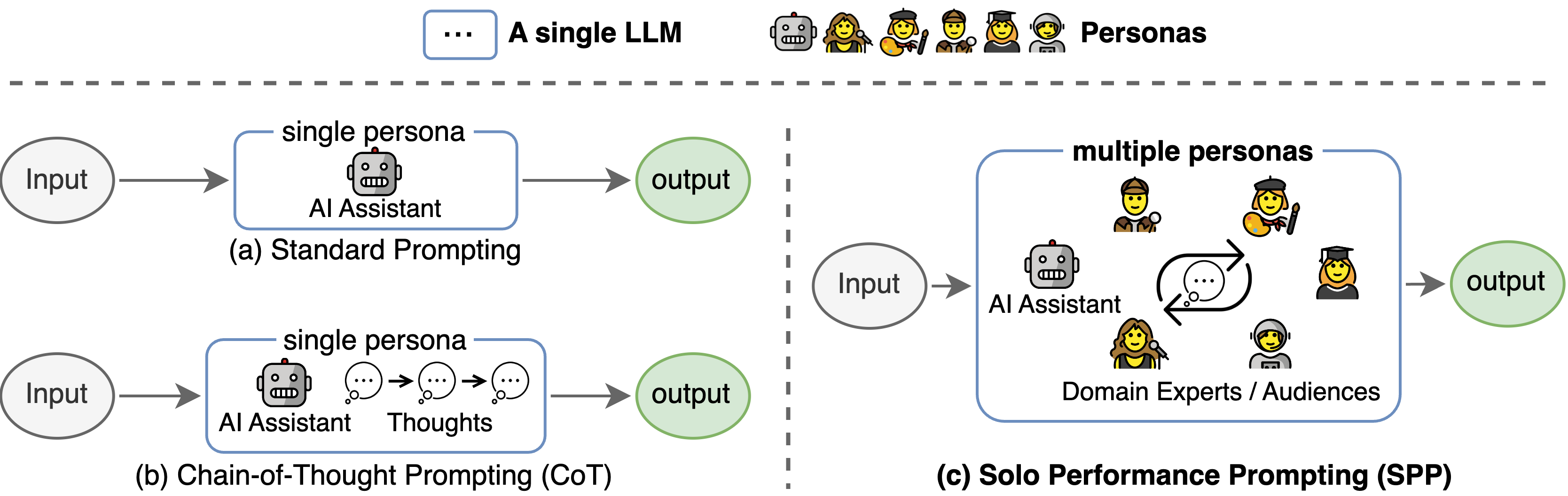

title={Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration},

author={Wang, Zhenhailong and Mao, Shaoguang and Wu, Wenshan and Ge, Tao and Wei, Furu and Ji, Heng},

journal={arXiv preprint arXiv:2307.05300},

year={2023}

}

该代码库引用了 Tree-of-thought 官方存储库的结构。我们感谢作者的开源努力。