SOLIDER

1.0.0

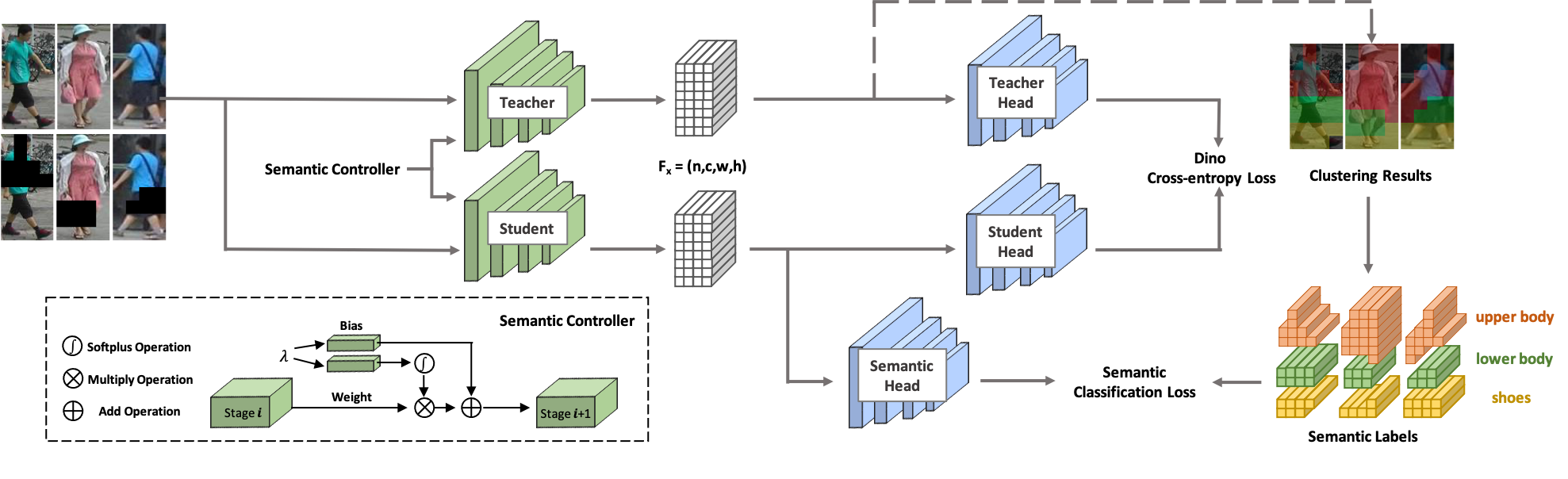

欢迎来到士兵! SOLIDER 是一个语义可控的自我监督学习框架,用于从大量未标记的人类图像中学习一般人类表示,这可以最大程度地有利于下游以人类为中心的任务。与现有的自监督学习方法不同,SOLIDER 利用人类图像的先验知识来构建伪语义标签,并将更多语义信息导入到学习的表示中。同时,不同的下游任务总是需要不同比例的语义信息和外观信息,并且单一的学习表示无法满足所有要求。为了解决这个问题,SOLIDER引入了带有语义控制器的条件网络,可以适应下游任务的不同需求。欲了解更多详细信息,请参阅我们的论文《Beyond Appearance: a Semantic Controllable Self-Supervised Learning Framework for Human-Centric Visual Tasks》。

该代码库是使用 python 版本 3.7、PyTorch 版本 1.7.1、CUDA 10.1 和 torchvision 0.8.2 开发的。

我们使用LUPerson作为训练数据,其中包含未标记的人类图像。从官方链接下载LUPerson并解压。

sh run_solider.shsh run_dino.sh

sh resume_solider.sh有一个演示可以运行经过训练的 SOLIDER 模型,可以将其嵌入到推理或下游任务微调中。

python demo.py我们使用 Swin-Transformer 作为主干,它在许多 CV 任务上显示出巨大的优势。

| 任务 | 数据集 | 斯文小 (关联) | 斯温小号 (关联) | 斯温基地 (关联) |

|---|---|---|---|---|

| 人员重新识别 (mAP/R1) 无需重新排名 | 市场1501 | 91.6/96.1 | 93.3/96.6 | 93.9/96.9 |

| MSMT17 | 67.4/85.9 | 76.9/90.8 | 77.1/90.7 | |

| 人员重新识别 (mAP/R1) 重新排名 | 市场1501 | 95.3/96.6 | 95.4/96.4 | 95.6/96.7 |

| MSMT17 | 81.5/89.2 | 86.5/91.7 | 86.5/91.7 | |

| 属性识别(mA) | PETA_ZS | 74.37 | 76.21 | 76.43 |

| RAP_ZS | 74.23 | 75.95 | 76.42 | |

| PA100K | 84.14 | 86.25 | 86.37 | |

| 人员搜索 (mAP/R1) | 香港中文大学-中山大学 | 94.9/95.7 | 95.5/95.8 | 94.9/95.5 |

| PRW | 56.8/86.8 | 59.8/86.7 | 59.7/86.8 | |

| 行人检测 (MR-2) | 城市人 | 10.3/40.8 | 10.0/39.2 | 9.7/39.4 |

| 人体解析 (mIOU) | 唇 | 57.52 | 60.21 | 60.50 |

| 姿态估计(AP/AR) | 可可 | 74.4/79.6 | 76.3/81.3 | 76.6/81.5 |

我们的实现主要基于以下代码库。我们衷心感谢作者的精彩作品。

如果您在研究中使用 SOLIDER,请使用以下 BibTeX 条目引用我们的工作:

@inproceedings{chen2023beyond,

title={Beyond Appearance: a Semantic Controllable Self-Supervised Learning Framework for Human-Centric Visual Tasks},

author={Weihua Chen and Xianzhe Xu and Jian Jia and Hao Luo and Yaohua Wang and Fan Wang and Rong Jin and Xiuyu Sun},

booktitle={The IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year={2023},

}