minichat

1.0.0

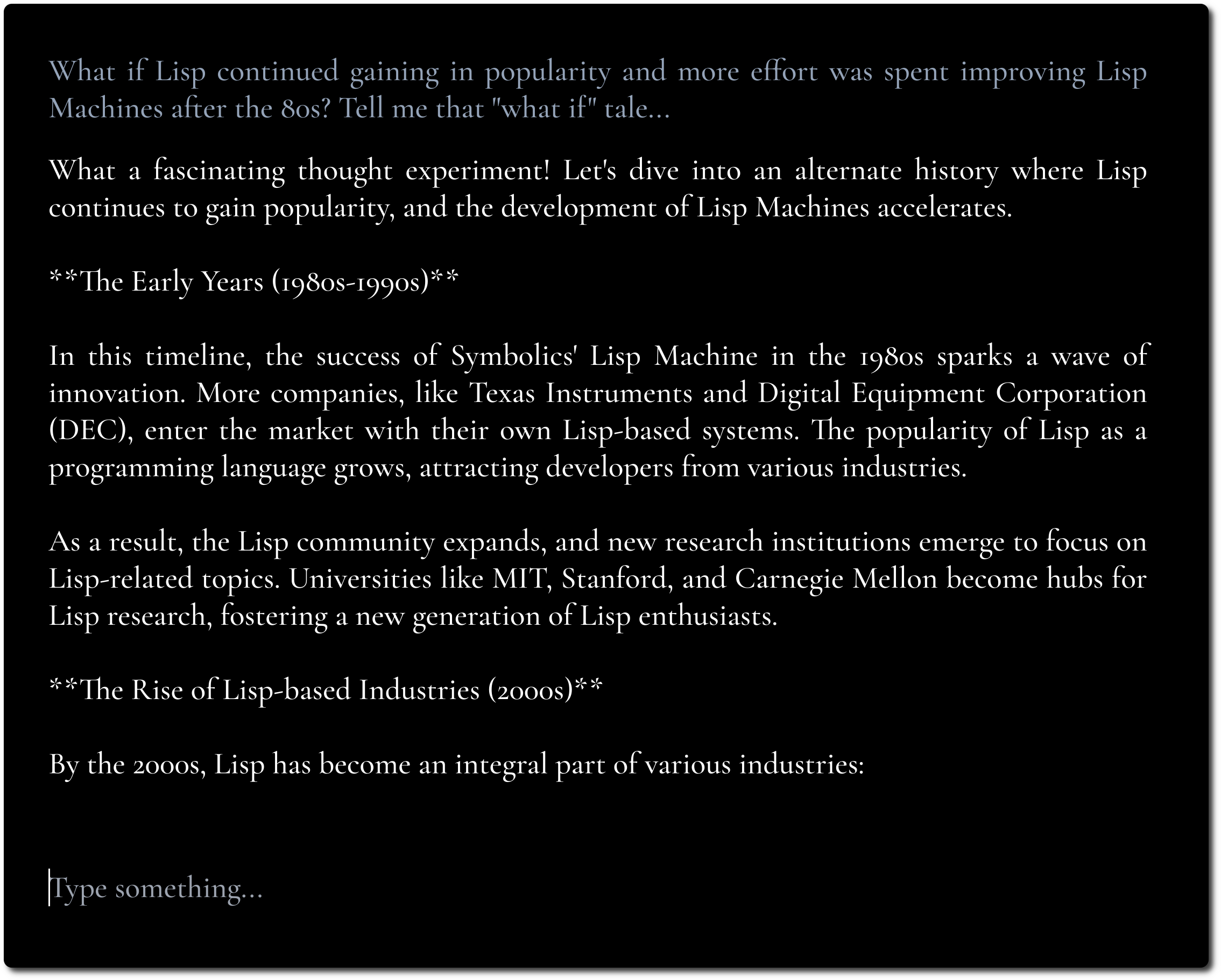

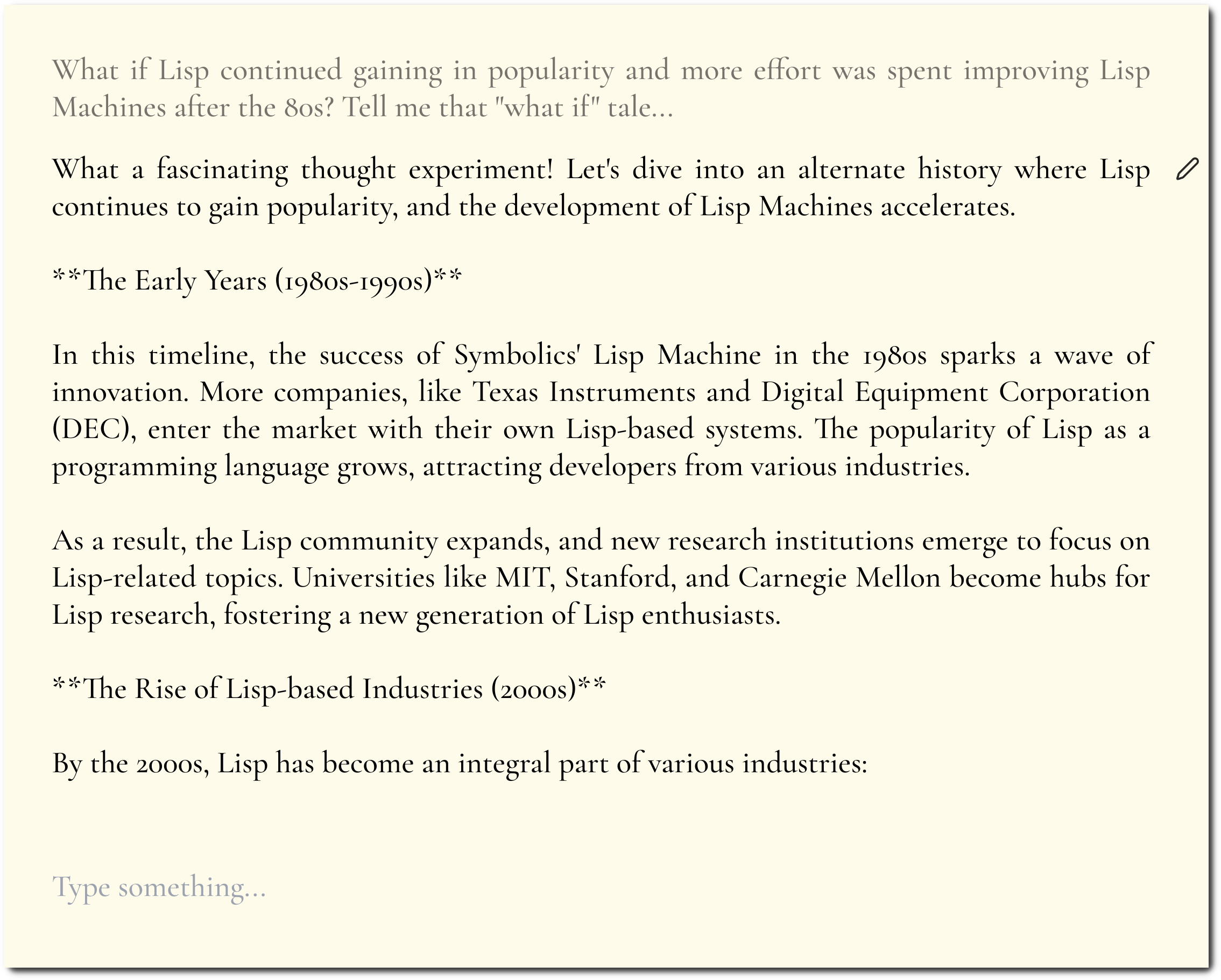

简约的 LLM 聊天 UI,灵感来自 Fooocus 和 Pi。

如果您有启用 CORS 的 API 端点可供使用,您可以在此处尝试。

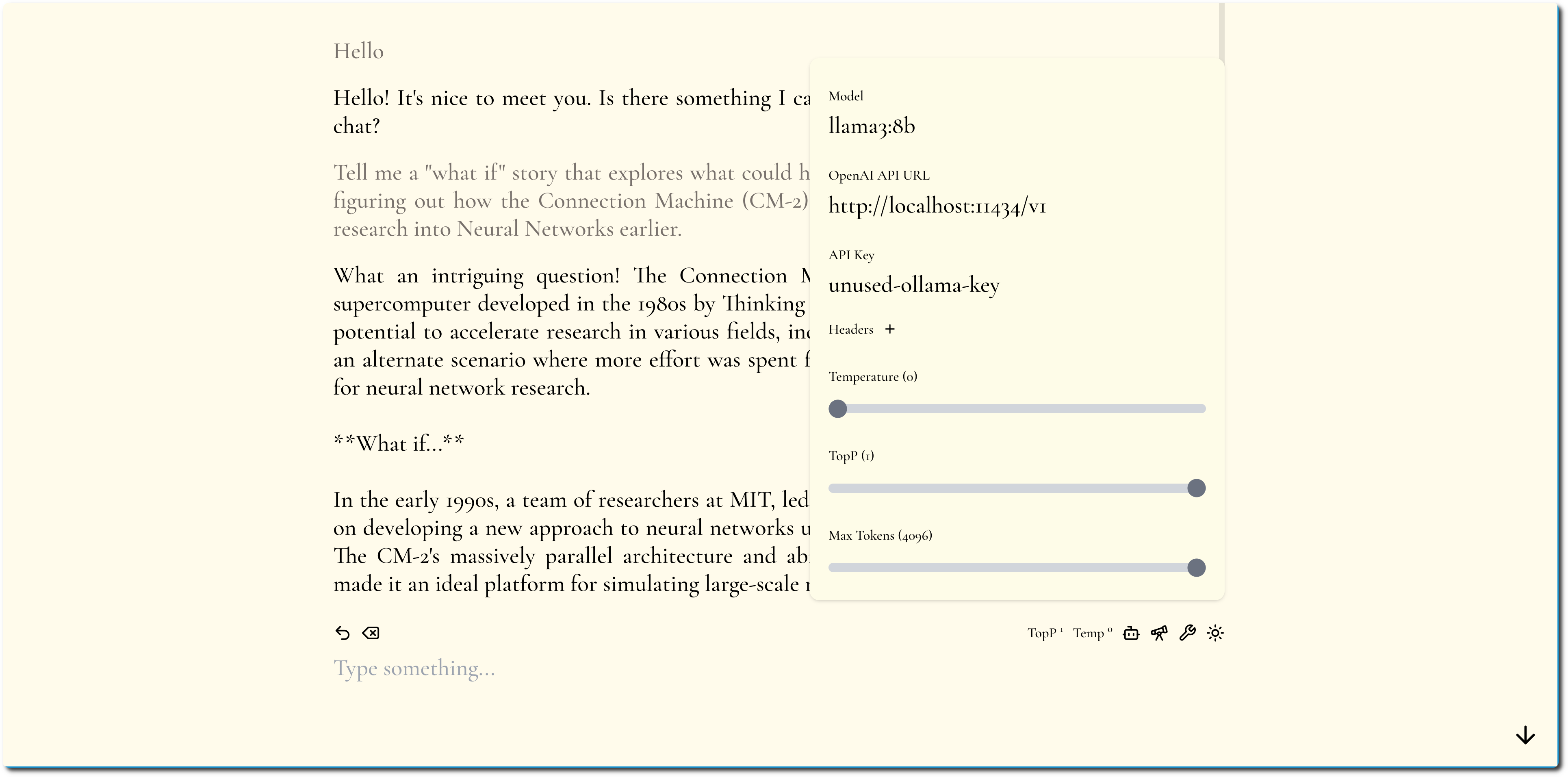

目标是专注于内容并隐藏尽可能多的修补和调整。

我们通过使用大胆的排版和简约的设计来强调内容。

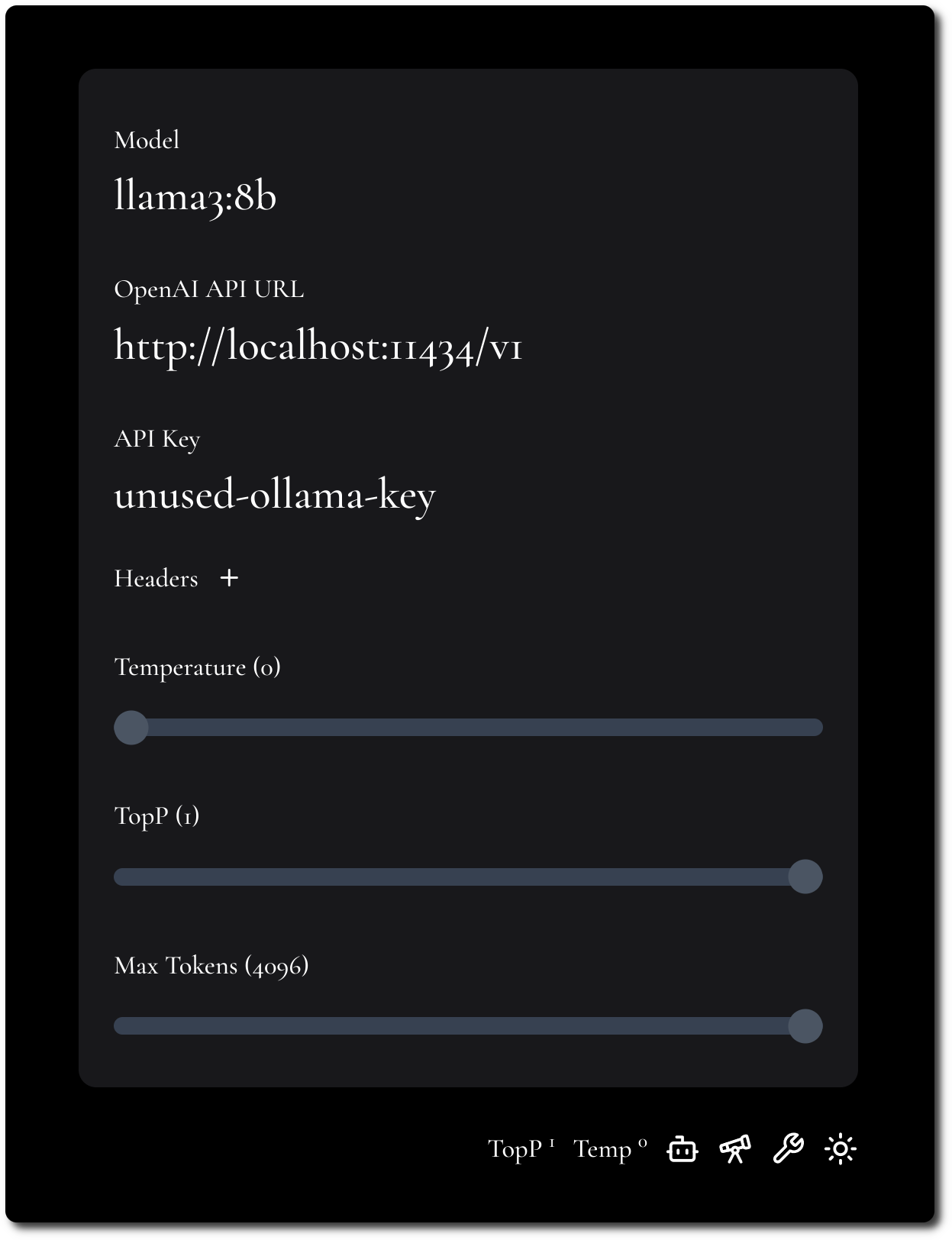

我们尝试保持配置最少但灵活。

MiniChat 支持 OpenAI 兼容的 API,请参阅 Docker Compose 部分,了解如何利用 Portkey 等网关与各种模型提供程序一起运行 MiniChat。

可以用Docker运行MiniChat,镜像小于2MB。

docker run -p 3216:3216 ghcr.io/functorism/minichat:master

跑步

docker compose -f docker-compose-ollama.yml up

docker exec minichat-ollama-1 ollama pull llama3:8b

用户界面设置:

跑步

docker compose -f docker-compose-portkey.yml up

用户界面设置:

跑步

docker compose -f docker-compose-tf-tgi.yml up

用户界面设置: