项目页面 • Arxiv 论文 • 演示 • 常见问题解答 • 引文

形状GPT简介

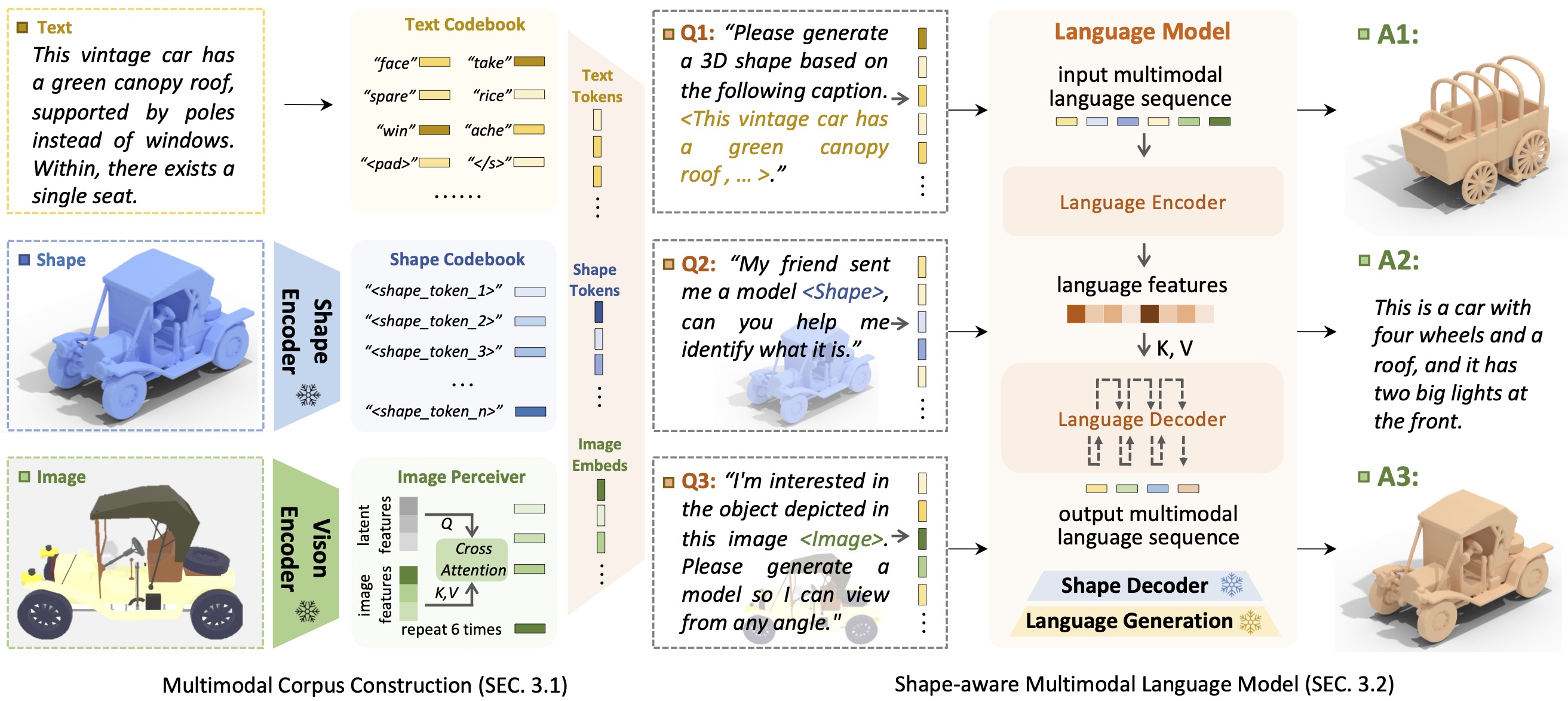

形状GPT简介ShapeGPT是一个统一且用户友好的以形状为中心的多模态语言模型,用于建立多模态语料库并开发针对多个形状任务的形状感知语言模型。

大型语言模型的出现通过指令驱动的方法实现了灵活性,彻底改变了许多传统的生成任务,但 3D 数据的大型模型,特别是在使用其他模式全面处理 3D 形状方面,仍处于探索之中。通过实现基于指令的形状生成,多功能多模态生成形状模型可以使 3D 虚拟施工和网络辅助设计等各个领域受益匪浅。在这项工作中,我们提出了 ShapeGPT,一种包含形状的多模态框架,利用强大的预训练语言模型来解决多个与形状相关的任务。具体来说,ShapeGPT采用单词-句子-段落框架将连续形状离散为形状词,进一步将这些单词组装为形状句子,并将形状与指导文本集成为多模态段落。为了学习这种形状语言模型,我们使用三阶段训练方案,包括形状表示、多模态对齐和基于指令的生成,来对齐形状语言密码本并学习这些模态之间复杂的相关性。大量实验表明,ShapeGPT 在形状相关任务中实现了可比的性能,包括文本到形状、形状到文本、形状完成和形状编辑。

如果您发现我们的代码或论文有帮助,请考虑引用:

@misc { yin2023shapegpt ,

title = { ShapeGPT: 3D Shape Generation with A Unified Multi-modal Language Model } ,

author = { Fukun Yin and Xin Chen and Chi Zhang and Biao Jiang and Zibo Zhao and Jiayuan Fan and Gang Yu and Taihao Li and Tao Chen } ,

year = { 2023 } ,

eprint = { 2311.17618 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}

感谢 T5 模型、Motion-GPT、Perceiver-IO 和 SDFusion,我们的代码部分借鉴了它们。我们的方法受到 Unified-IO、Michelangelo、ShapeCrafter、Pix2Vox 和 3DShape2VecSet 的启发。

该代码是根据 MIT 许可证分发的。

请注意,我们的代码依赖于其他库,包括 PyTorch3D 和 PyTorch Lightning,并使用数据集,每个数据集都有自己各自的许可证,也必须遵循这些许可证。