中文 | English

CodeFuse-ChatBot: Development by Private Knowledge Augmentation

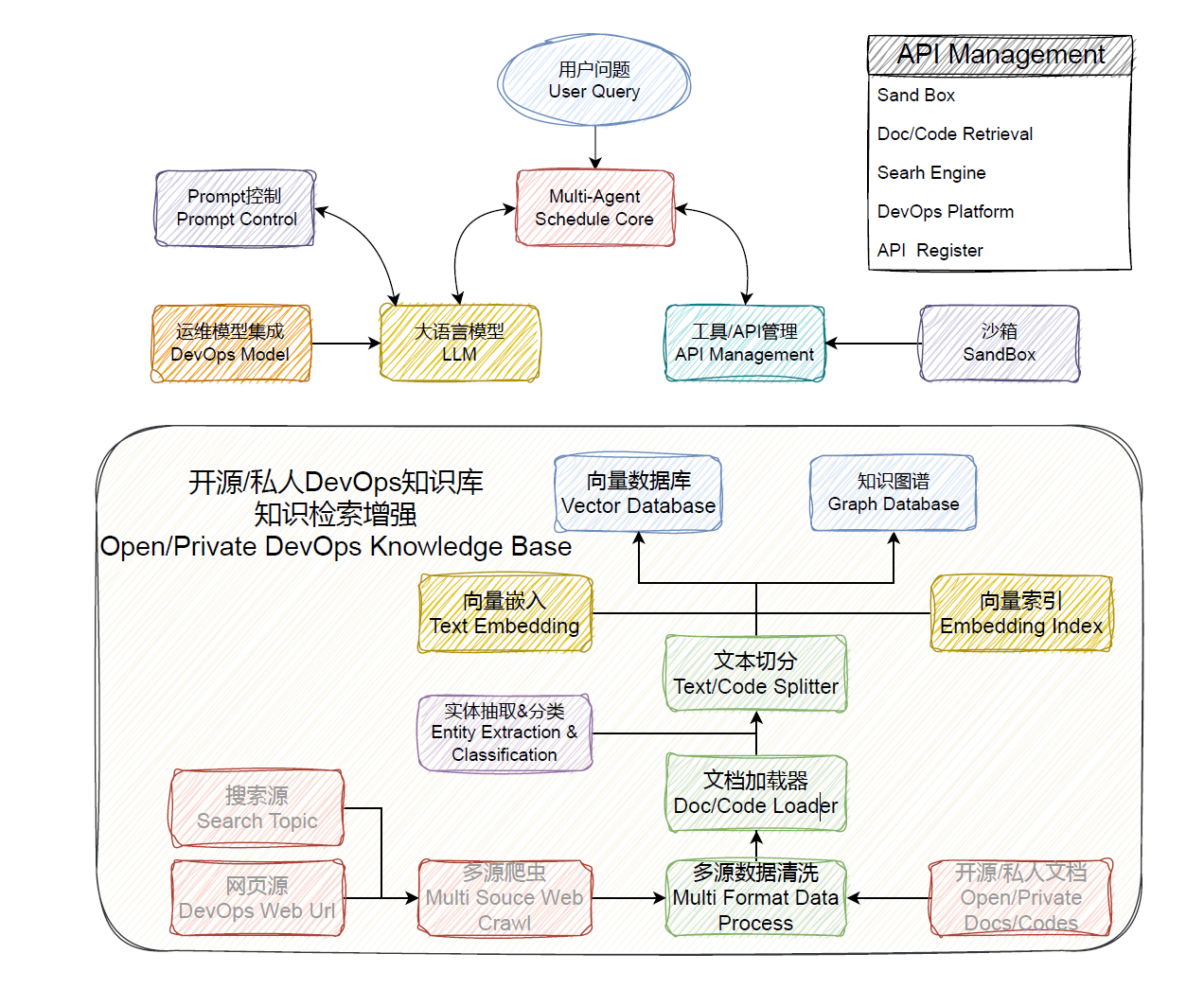

CodeFuse-ChatBot是由蚂蚁CodeFuse团队开发的开源AI智能助手,致力于简化和优化软件开发生命周期中的各个环节。该项目结合了Multi-Agent的协同调度机制,并集成了丰富的工具库、代码库、知识库和沙盒环境,使得LLM模型能够在DevOps领域内有效执行和处理复杂任务。

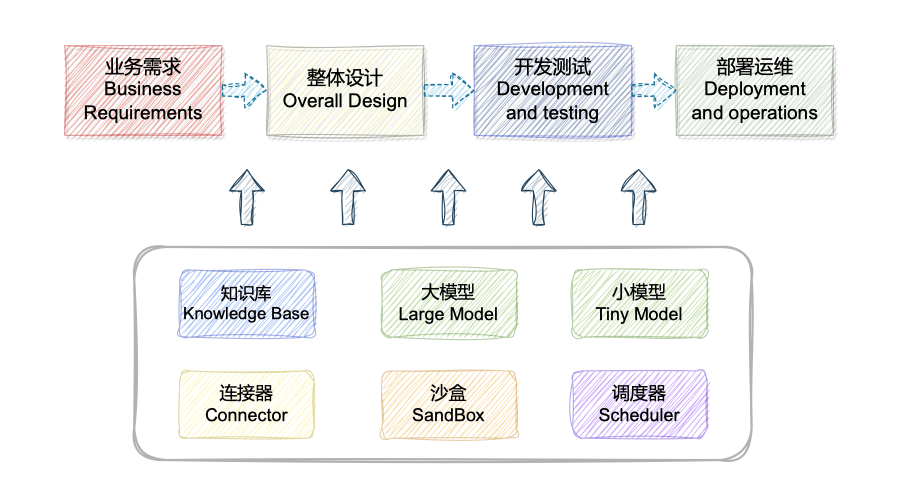

本项目旨在通过检索增强生成(Retrieval Augmented Generation,RAG)、工具学习(Tool Learning)和沙盒环境来构建软件开发全生命周期的AI智能助手,涵盖设计、编码、测试、部署和运维等阶段。 逐渐从各处资料查询、独立分散平台操作的传统开发运维模式转变到大模型问答的智能化开发运维模式,改变人们的开发运维习惯。

本项目核心差异技术、功能点:

? 依托于开源的 LLM 与 Embedding 模型,本项目可实现基于开源模型的离线私有部署。此外,本项目也支持 OpenAI API 的调用。接入Demo

核心研发团队长期专注于 AIOps + NLP 领域的研究。我们发起了 Codefuse-ai 项目,希望大家广泛贡献高质量的开发和运维文档,共同完善这套解决方案,以实现“让天下没有难做的开发”的目标。

为了帮助您更直观地了解 Codefuse-ChatBot 的功能和使用方法,我们录制了一系列演示视频。您可以通过观看这些视频,快速了解本项目的主要特性和操作流程。

具体实现明细见:技术路线明细 项目计划跟进见:Projects

如果您需要集成特定的模型,请通过提交issue来告知我们您的需求。

| model_name | model_size | gpu_memory | quantize | HFhub | ModelScope |

|---|---|---|---|---|---|

| chatgpt | - | - | - | - | - |

| codellama-34b-int4 | 34b | 20g | int4 | coming soon | link |

完整文档见:CodeFuse-muAgent

pip install codefuse-muagent

请自行安装 nvidia 驱动程序,本项目已在 Python 3.9.18,CUDA 11.7 环境下,Windows、X86 架构的 macOS 系统中完成测试。

Docker安装、私有化LLM接入及相关启动问题见:快速使用明细

对于 Apple Silicon(苹果M系列芯片),您可能需要首先通过brew install qpdf。

1、python 环境准备

# 准备 conda 环境

conda create --name devopsgpt python=3.9

conda activate devopsgptcd codefuse-chatbot

# python=3.9,notebook用最新即可,python=3.8用notebook=6.5.6

pip install -r requirements.txt2、启动服务

# 完成server_config.py配置后,可一键启动

cd examples

bash start.sh

# 开始在页面进行相关配置,然后打开`启动对话服务`即可

或者通过start.py进行启动老版启动方式

更多LLM接入方法见更多细节...

非常感谢您对 Codefuse 项目感兴趣,我们非常欢迎您对 Codefuse 项目的各种建议、意见(包括批评)、评论和贡献。

您对 Codefuse 的各种建议、意见、评论可以直接通过 GitHub 的 Issues 提出。

参与 Codefuse 项目并为其作出贡献的方法有很多:代码实现、测试编写、流程工具改进、文档完善等等。任何贡献我们都会非常欢迎,并将您加入贡献者列表。详见Contribution Guide...

本项目基于langchain-chatchat和codebox-api,在此深深感谢他们的开源贡献!