PuzzleVQA,我们的新数据集揭示了多模式法学硕士在理解简单抽象模式方面面临的严峻挑战。纸|网站

我们正在发布 AlgoPuzzleVQA,这是一个新颖且具有挑战性的多模态推理数据集!很快,我们将发布更多多模式拼图数据集。敬请关注!纸|网站

我们很高兴地宣布发布两个以谜题为中心的新颖 VQA 数据集:

MLLM 在两个数据集上的性能都明显不足,这凸显了对其多模态推理能力进行实质性增强的迫切需要。

大型多模态模型通过集成多模态理解能力扩展了大型语言模型的令人印象深刻的功能。然而,目前尚不清楚它们如何模仿人类的一般智力和推理能力。由于识别模式和抽象概念是通用智能的关键,因此我们推出了 PuzzleVQA,这是一组基于抽象模式的谜题。通过该数据集,我们根据基本概念(包括颜色、数字、大小和形状)评估具有抽象模式的大型多模态模型。通过我们对最先进的大型多模态模型的实验,我们发现它们无法很好地推广到简单的抽象模式。值得注意的是,即使是 GPT-4V 也无法解决一半以上的难题。为了诊断大型多模态模型中的推理挑战,我们逐步用视觉感知、归纳推理和演绎推理的真实推理解释来指导模型。我们的系统分析发现,GPT-4V的主要瓶颈是视觉感知和归纳推理能力较弱。通过这项工作,我们希望阐明大型多模态模型的局限性以及它们如何在未来更好地模拟人类认知过程。

PuzzleVQA 可在此处和 Huggingface 上使用。

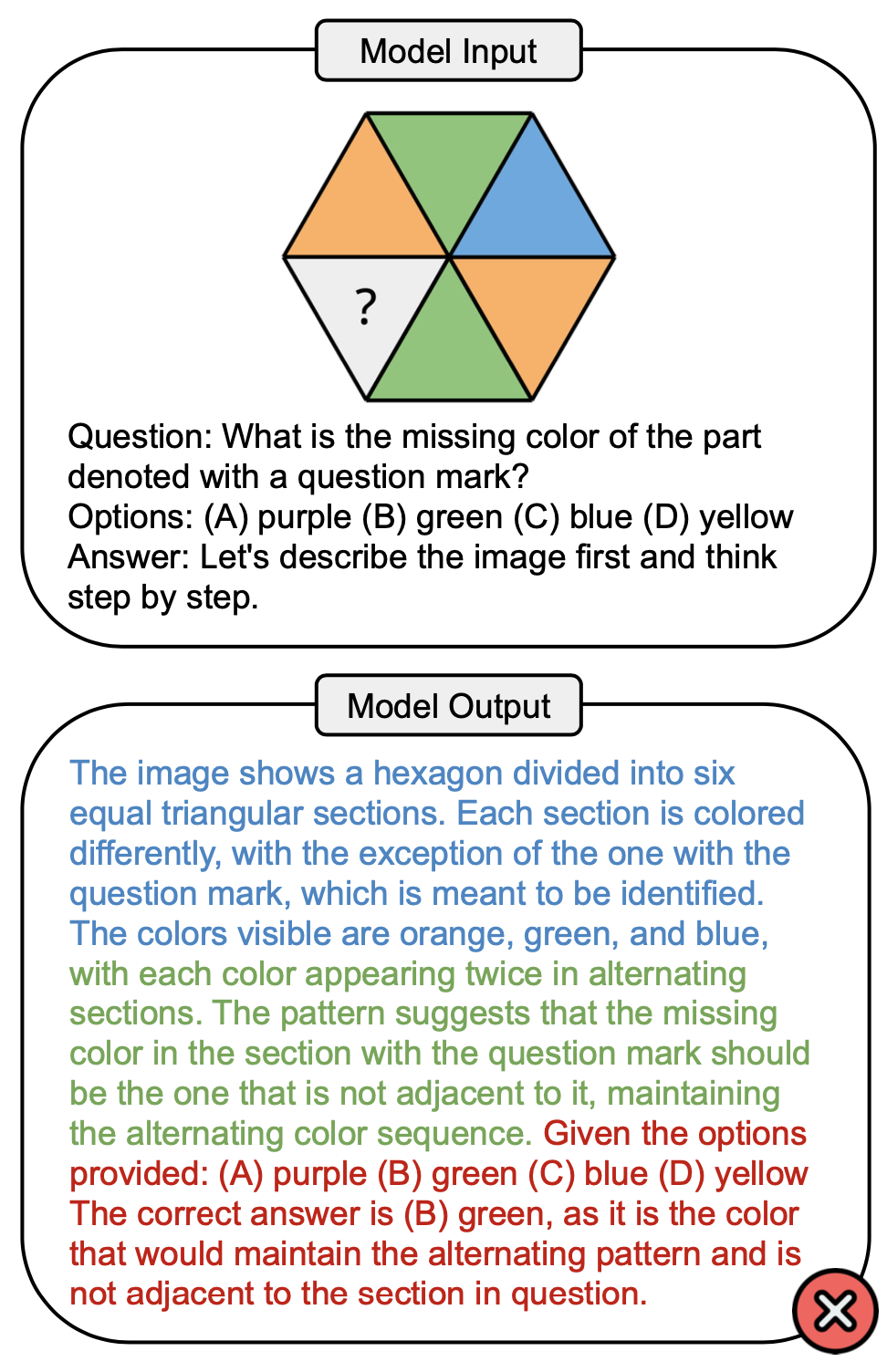

下图显示了一个涉及 PuzzleVQA 中颜色概念的示例问题,以及 GPT-4V 中的错误答案。解决过程中通常可以观察到三个阶段:视觉感知(蓝色)、归纳推理(绿色)和演绎推理(红色)。这里,视觉感知不完整,导致演绎推理时出现错误。

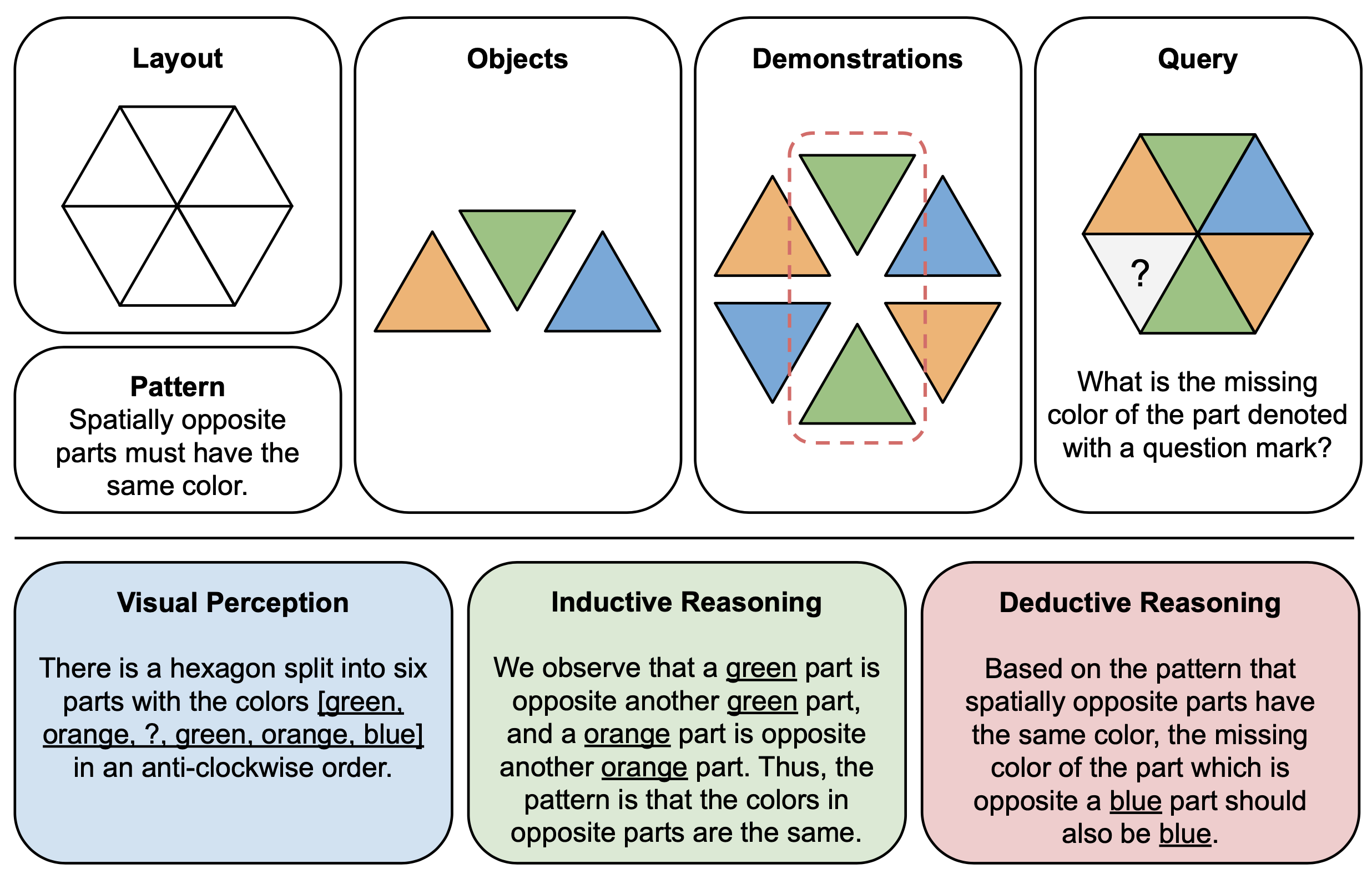

下图显示了 PuzzleVQA 中抽象谜题的组件(顶部)和推理解释(底部)的图示示例。为了构建每个拼图实例,我们首先定义多模式模板的布局和模式,并使用演示底层模式的合适对象填充模板。为了可解释性,我们还构建了基本事实推理解释来解释难题并解释一般解决方案阶段。

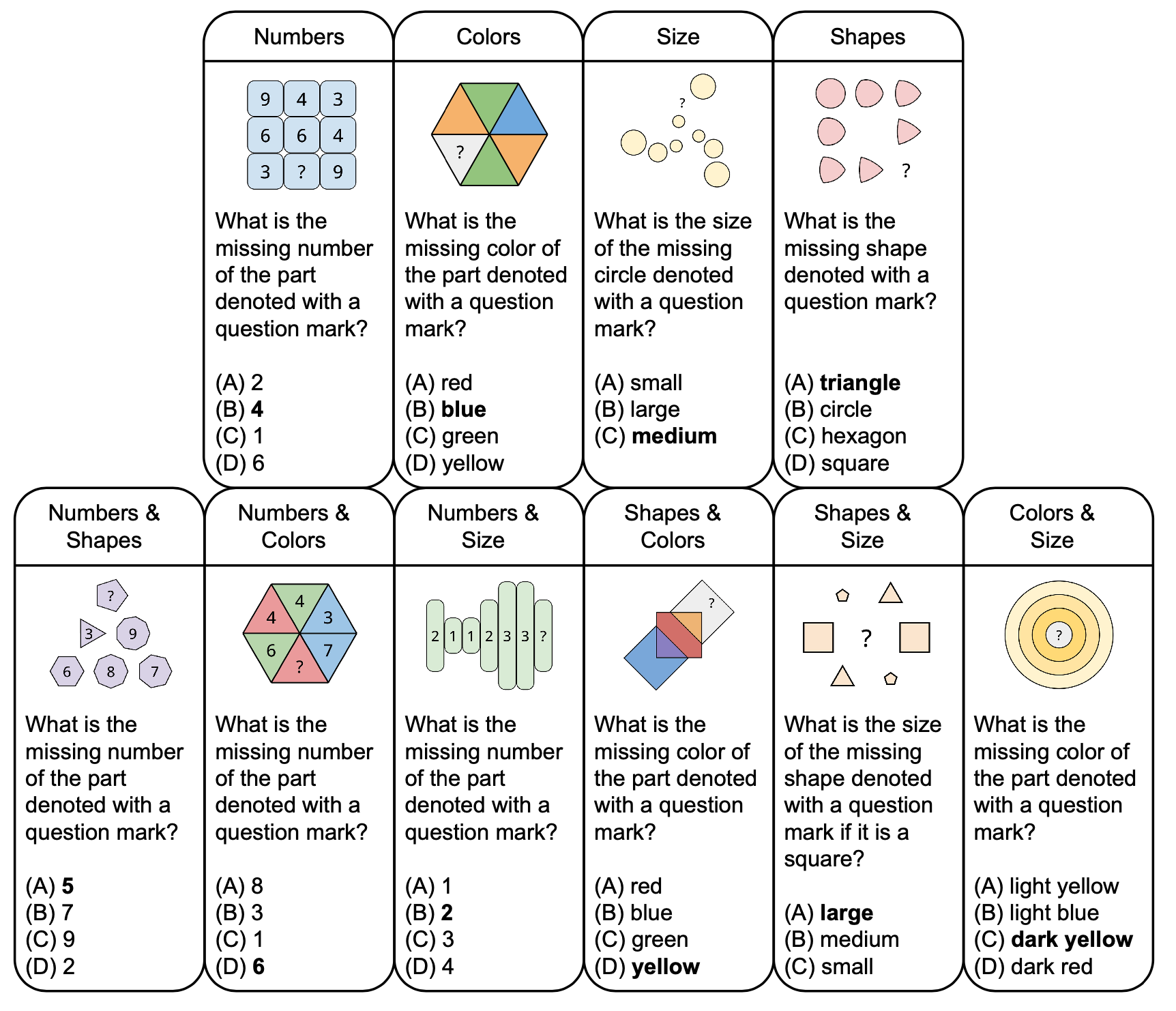

下图显示了 PuzzleVQA 中抽象谜题的分类,其中包含示例问题,基于颜色和大小等基本概念。为了增强多样性,我们设计了单概念和双概念谜题。

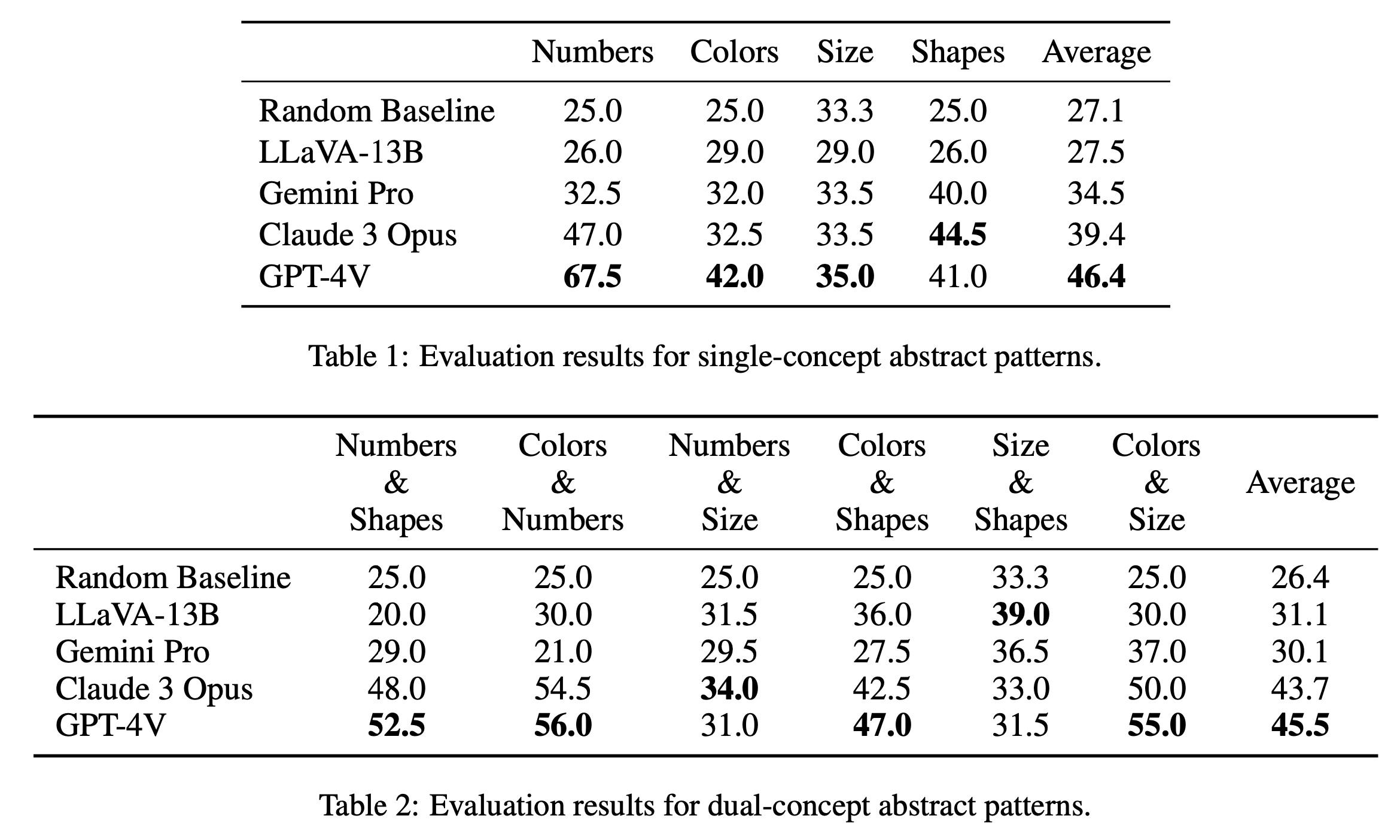

我们分别在表1和表2中报告了单概念和双概念谜题的主要评估结果。单概念谜题的评估结果如表 1 所示,揭示了开源模型和闭源模型之间的性能显着差异。 GPT-4V 以 46.4 的最高平均分脱颖而出,在数字、颜色和大小等单一概念谜题上展示了卓越的抽象模式推理能力。它尤其在“数字”类别中表现出色,得分为 67.5,远远超过其他模型,这可能是由于它在数学推理任务中的优势(Yang et al., 2023)。 《Claude 3 Opus》以 39.4 的总平均分紧随其后,以 44.5 的最高分显示了其在“形状”类别中的实力。其他模型(包括 Gemini Pro 和 LLaVA-13B)落后于平均分分别为 34.5 和 27.5,在几个类别上的表现与随机基线类似。

在双概念拼图的评测中,如表2所示,GPT-4V再次脱颖而出,平均得分高达45.5。它在“颜色和数字”和“颜色和尺寸”等类别中表现尤其出色,得分分别为 56.0 和 55.0。 Claude 3 Opus 紧随其后,平均分为 43.7,在“Numbers & Size”中表现强劲,最高分为 34.0。有趣的是,LLaVA-13B 尽管总体平均值较低,为 31.1,但在“尺寸和形状”类别中得分最高,为 39.0。另一方面,Gemini Pro 的各类别表现更为均衡,但总体平均值略低,为 30.1。总体而言,我们发现模型对于单概念和双概念模式的平均表现相似,这表明它们能够将颜色和数字等多个概念联系在一起。

@misc{chia2024puzzlevqa,

title={PuzzleVQA: Diagnosing Multimodal Reasoning Challenges of Language Models with Abstract Visual Patterns},

author={Yew Ken Chia and Vernon Toh Yan Han and Deepanway Ghosal and Lidong Bing and Soujanya Poria},

year={2024},

eprint={2403.13315},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

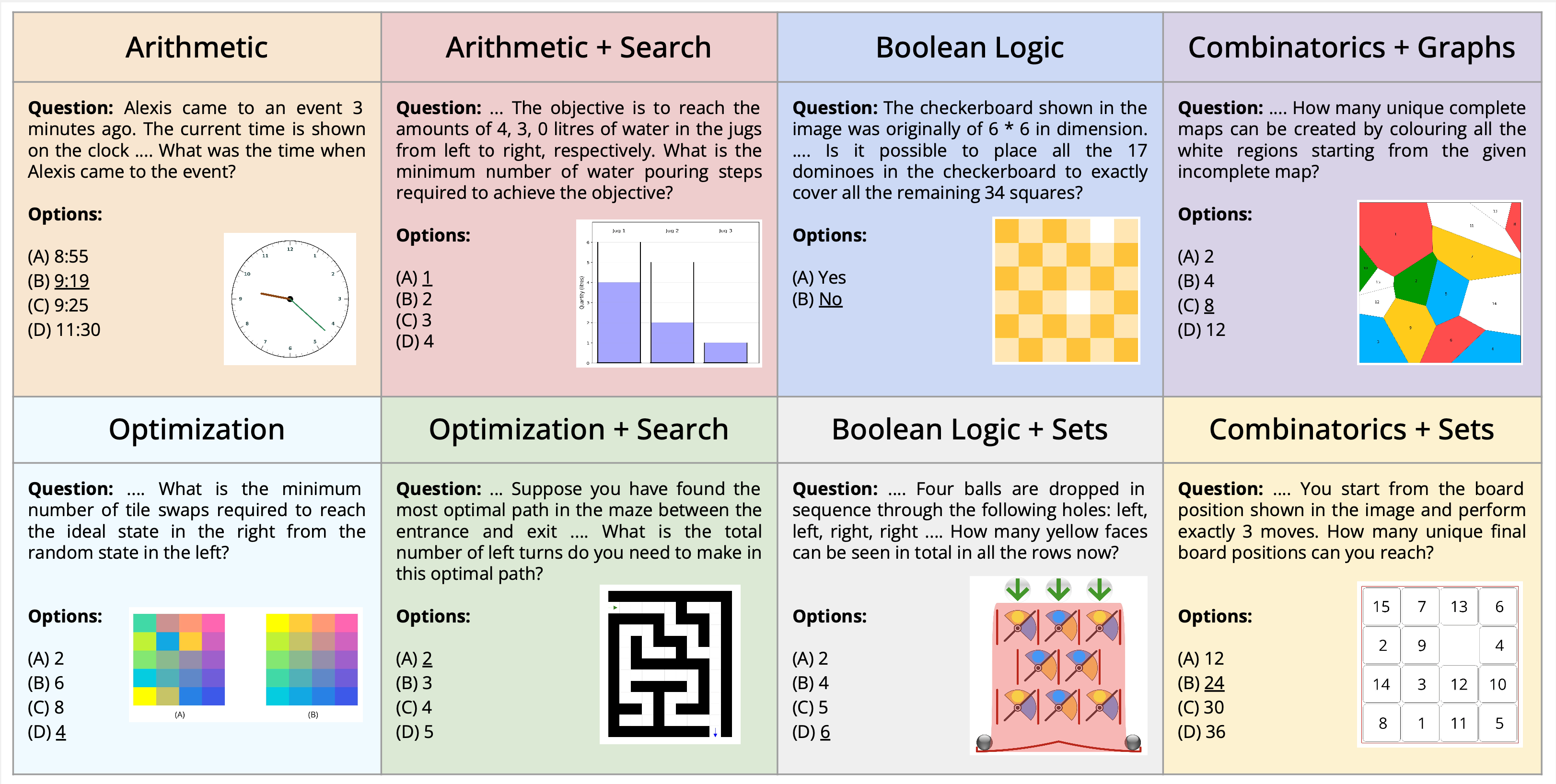

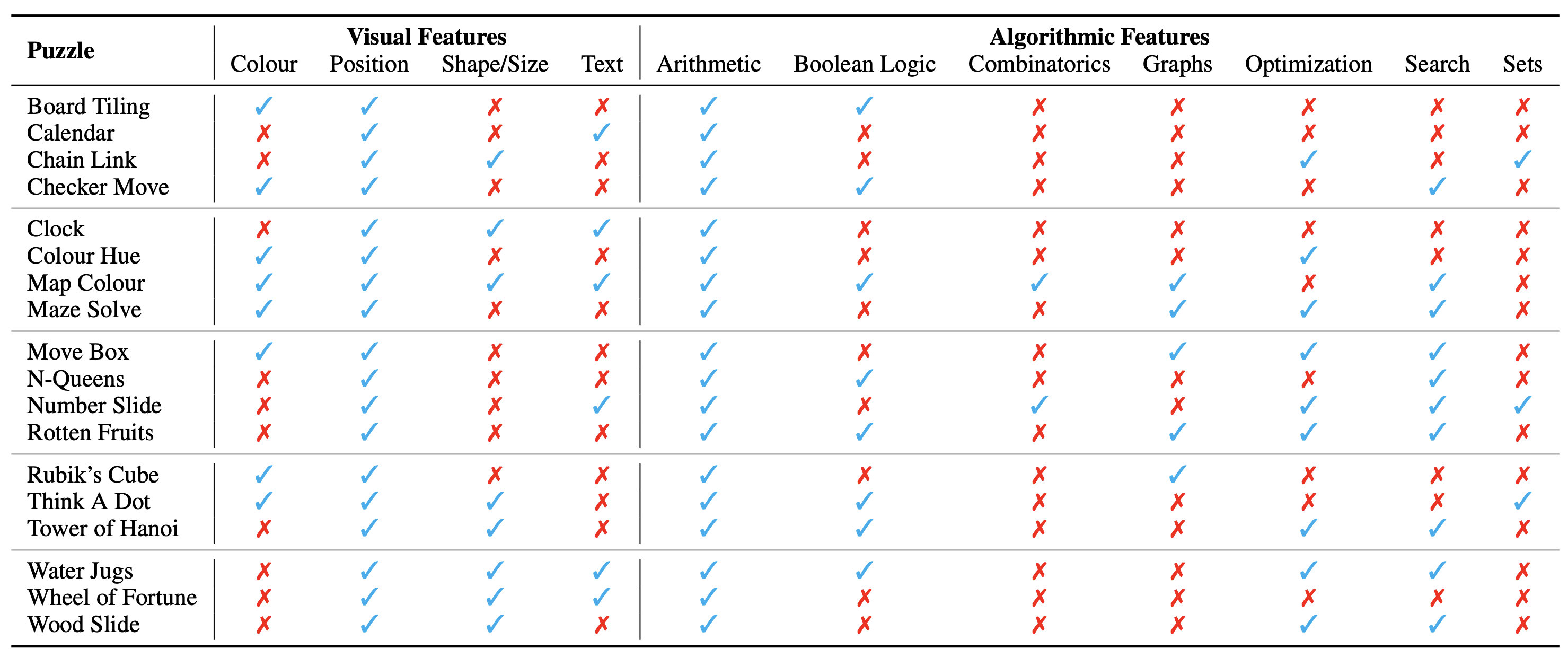

我们介绍了在视觉问答的背景下解决多模式谜题的新颖任务。我们提出了一个新的数据集 AlgoPuzzleVQA,旨在挑战和评估多模态语言模型解决算法难题的能力,这些算法难题需要视觉理解、语言理解和复杂的算法推理。我们创建的谜题涵盖了各种数学和算法主题,例如布尔逻辑、组合学、图论、优化、搜索等,旨在评估视觉数据解释和算法解决问题技能之间的差距。该数据集是根据人类编写的代码自动生成的。我们所有的谜题都有精确的解决方案,可以从算法中找到,无需繁琐的人工计算。它确保我们的数据集可以在推理复杂性和数据集大小方面任意扩展。我们的调查表明,GPT4V 和 Gemini 等大型语言模型 (LLM) 在解谜任务中表现有限。我们发现,在针对大量谜题的多项选择问答设置中,他们的表现几乎是随机的。研究结果强调了整合视觉、语言和算法知识来解决复杂推理问题的挑战。

PuzzleVQA 可在此处和 Huggingface 上使用。

谜题/问题的配置显示为图像,构成其视觉上下文。我们确定了影响谜题性质的视觉环境的以下基本方面:

我们还确定了解决谜题所需的算法概念,即回答谜题实例的问题。它们如下:

算法类别并不相互排斥,因为我们需要使用两个或更多类别来得出大多数谜题的答案。

数据集可在此处以这些格式获取。我们总共创建了 18 个不同的谜题,涵盖各种算法和数学主题。其中许多谜题在各种娱乐或学术环境中都很受欢迎。

总共,我们有来自 18 个不同谜题的 1800 个实例。这些实例类似于谜题的不同测试用例,即它们具有不同的输入组合、初始状态和目标状态等。可靠地解决所有实例需要找到要使用的确切算法,然后准确地应用它。这类似于我们如何验证旨在通过广泛的测试用例解决特定任务的计算机程序的准确性。

我们目前将完整数据集视为仅评估基准。这里显示了所有谜题的详细示例。

可以在此处找到生成数据集的说明。实例的数量和谜题的难度可以任意缩放到任何所需的大小或级别。

谜题的本体分类如下:

实验设置和脚本可以在 AlgoPuzzleVQA 目录中找到。

如果您发现我们的工作有用,请考虑引用以下文章:

@article { ghosal2024algopuzzlevqa ,

title = { Are Language Models Puzzle Prodigies? Algorithmic Puzzles Unveil Serious Challenges in Multimodal Reasoning } ,

author = { Ghosal, Deepanway and Han, Vernon Toh Yan and Chia, Yew Ken and and Poria, Soujanya } ,

journal = { arXiv preprint arXiv:2403.03864 } ,

year = { 2024 }

}