Foundationa法学硕士提供了在企业中部署、扩展、保护和管理生成式人工智能的平台。通过 Foundationa LLM,您可以:

笔记

Foundationa LLM并不是一个大型语言模型。它使您能够使用您选择的大型语言模型(例如,OpenAI GPT-4、Mistral、LLama 2 等)

Foundationa LLM将安全、全面且高度可配置的副驾驶平台部署到您的 Azure 云环境:

简而言之,我们看到很多人重新发明轮子,只是为了获得一个定制的副驾驶或人工智能代理,这些代理是接地的,并且其响应基于他们自己的数据,而不是模型训练有素的参数知识。我们看到的许多解决方案都是为了出色的演示而设计的,但它们实际上只是包装对 OpenAI 端点的调用的玩具——它们并不是有意或准备在企业规模的生产中投入使用的。我们建立了Foundationa LLM来提供一个持续的旅程,一个快速上手的旅程,这样人们就可以快速尝试LLM,但之后不会因为解决方案不安全、未经许可、不灵活且功能不够齐全而掉下悬崖。从原型成长为生产解决方案,而无需从头开始。

交付企业副驾驶或AI代理的核心问题是:

有一种误解,认为构建 LLM 应用程序和 AI 代理都是关于快速工程的,它很简单:

对于演示和玩具场景来说可能是这样,但对于企业中的人工智能代理来说,还有更多的要求,例如您如何:

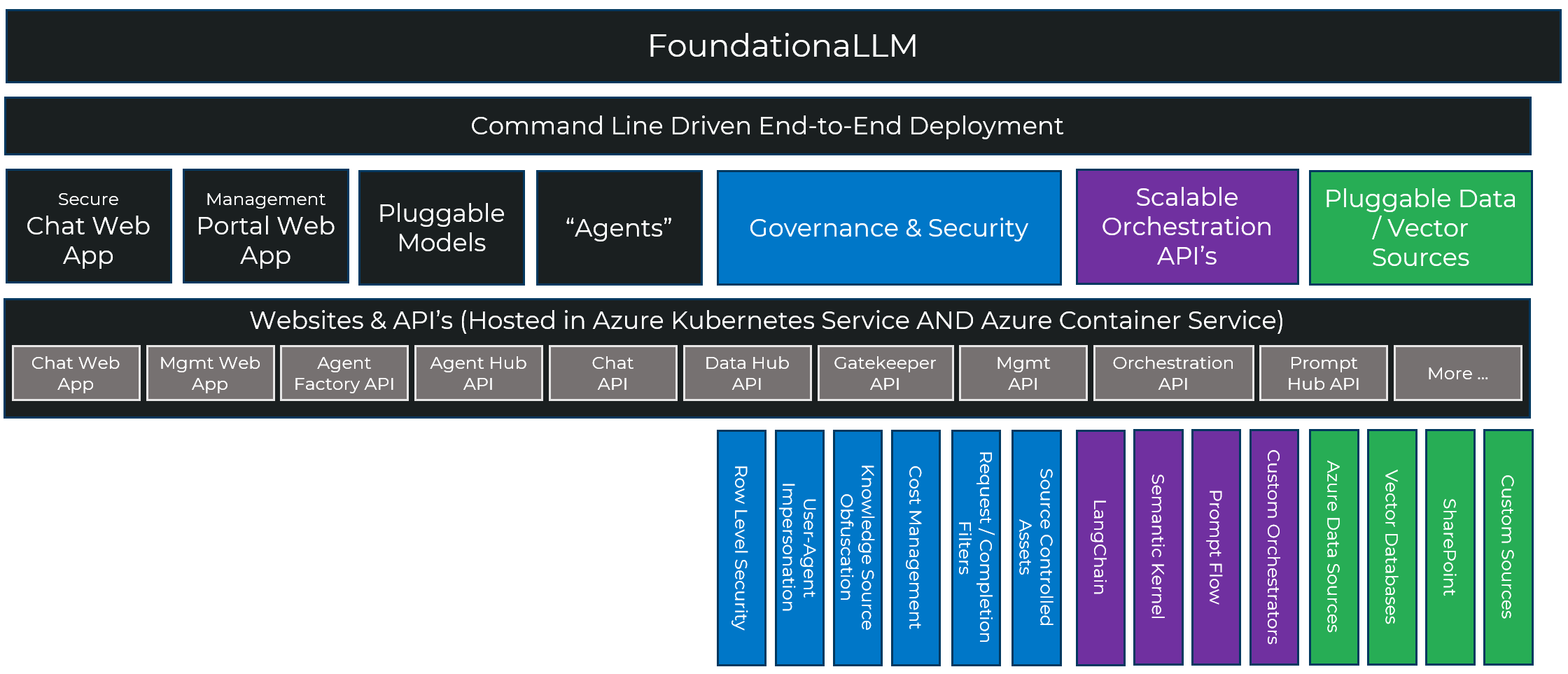

构建安全、管理良好、可扩展和可扩展的人工智能代理需要用到很多组件,Foundationa LLM提供了一个全面的堆栈,使这个过程更快、更可重复、更可靠:

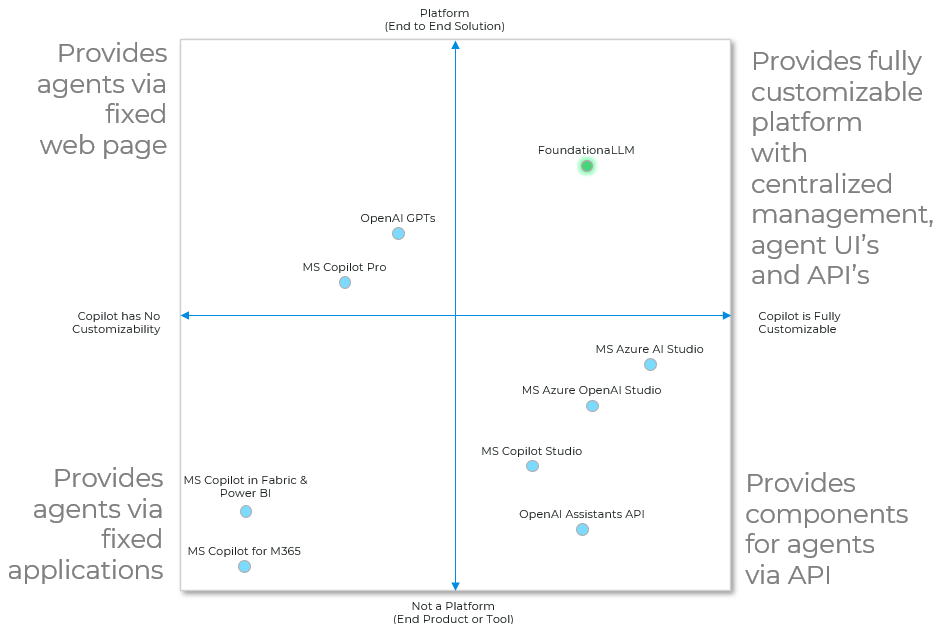

生态系统中有很多很棒的工具可以帮助构建副驾驶或人工智能代理。只有 Foundationa LLM将它们聚集在一起,提供端到端平台,用于创建具有集中管理、代理 UI 和 API 的完全可定制的 AI 代理。

最基本的是,副驾驶或人工智能代理使用企业提供的知识和生成式人工智能模型来创作文本、编写代码或渲染图像,通常是通过对人类提供的提示进行推理。在这些模式中,人工智能用于直接协助人类完成特定任务。

这种基本功能出现在两种原型中,Foundationa LLM本身就支持这两种原型:

Foundationa LLM简化并简化了在整个企业中存在的数据源上构建知识管理(例如,问答代理)和分析(例如,自助商业智能)代理。

通过阅读文档快速了解 Foundationa LLM 。这包括部署说明、快速入门、架构和 API 参考。

Foundationa LLM提供了一种简单的命令行驱动方法来启动并运行您的第一个部署。基本上,这是两个命令。之后,您可以自定义解决方案,在您的计算机上本地运行它并使用您的自定义更新部署。

按照快速入门部署说明在 Azure 订阅中部署 Foundationa LLM 。

如果您在使用 Foundationa LLM时遇到任何问题,请在 GitHub 上提出问题。我们将尽快回复您的问题。请使用标签( bug 、 documentation 、 general question 、 release xxx )对您的问题进行分类,并提供尽可能多的详细信息,以帮助我们理解和解决问题。

我们很高兴以反馈、错误报告和拉取请求的形式接受对 FoundationaLLM 项目的贡献。请参阅向 FoundationaLLM 做出贡献以获取说明。