MMD-DDM

通过 MMD 微调在去噪扩散模型中进行快速推理

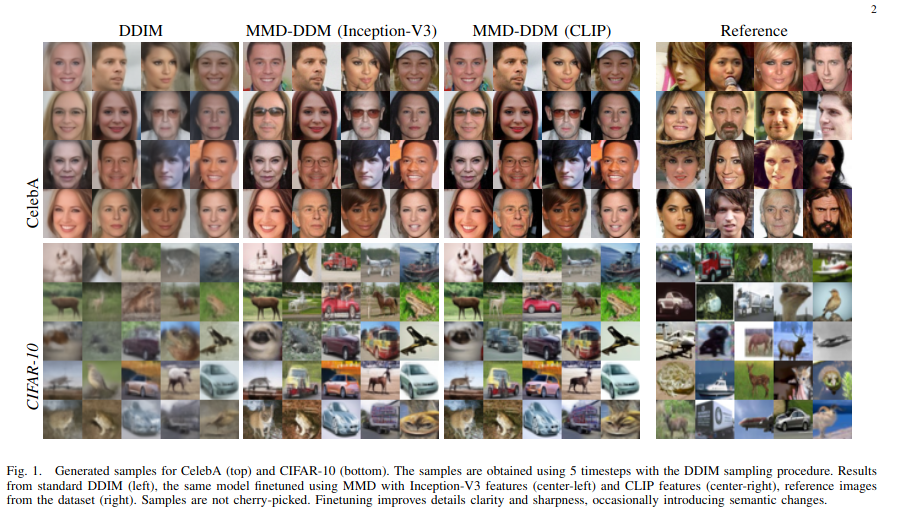

去噪扩散模型 (DDM) 已成为从复杂数据分布生成高质量样本的流行工具。这些模型能够捕获数据中复杂的模式和结构,并且可以生成高度多样化且代表底层分布的样本。然而,扩散模型的主要限制之一是样本生成的复杂性,因为需要大量的推理时间步才能忠实地捕获数据分布。在本文中,我们提出了 MMD-DDM,一种用于扩散模型快速采样的新方法。我们的方法基于使用最大平均差异(MMD)的思想,通过给定的时间步预算来微调学习的分布。这使得微调模型能够显着改善速度与质量的权衡,通过用很少的步骤大幅提高推理机制的保真度,或者等效地,通过减少达到目标保真度所需的步骤数,从而为更多的模型铺平道路。在广泛的应用中实际采用扩散模型。

要使用我们提出的 MMD-DDM 策略微调预训练扩散模型,请下载预训练模型并调整 runners/diffusion.py 中的路径,或使用 /function/ckpt_util.py 中存在的模型并运行命令:

python main.py --config {DATASET}.yml --timesteps {num_timesteps (e.g 5)} --exp {PROJECT_PATH} --train

要对微调模型生成的图像进行采样,请使用新训练的模型调整 runners/diffusion.py 中的 test_FID 函数中的路径并运行:

python main.py --config {DATASET}.yml --timesteps {num_timesteps (e.g 5)} --test_FID

如果您发现 MMD-DDM 对您的研究有帮助,请考虑引用:

@article { aiello2023fast ,

title = { Fast Inference in Denoising Diffusion Models via MMD Finetuning } ,

author = { Aiello, Emanuele and Valsesia, Diego and Magli, Enrico } ,

journal = { arXiv preprint arXiv:2301.07969 } ,

year = { 2023 }

}该存储库基于 DDIM 官方实现:https://github.com/ermongroup/ddim

如果您有任何疑问,请随时提出问题或通过 [email protected] 联系我们

? ⛏️?

预训练模型即将发布!