大规模、信息丰富、多样化的多轮对话数据和模型

UltraLM • 数据浏览器 • Nomic AI Atlas Explorer • 数据发布 • 构建流程 • 论文

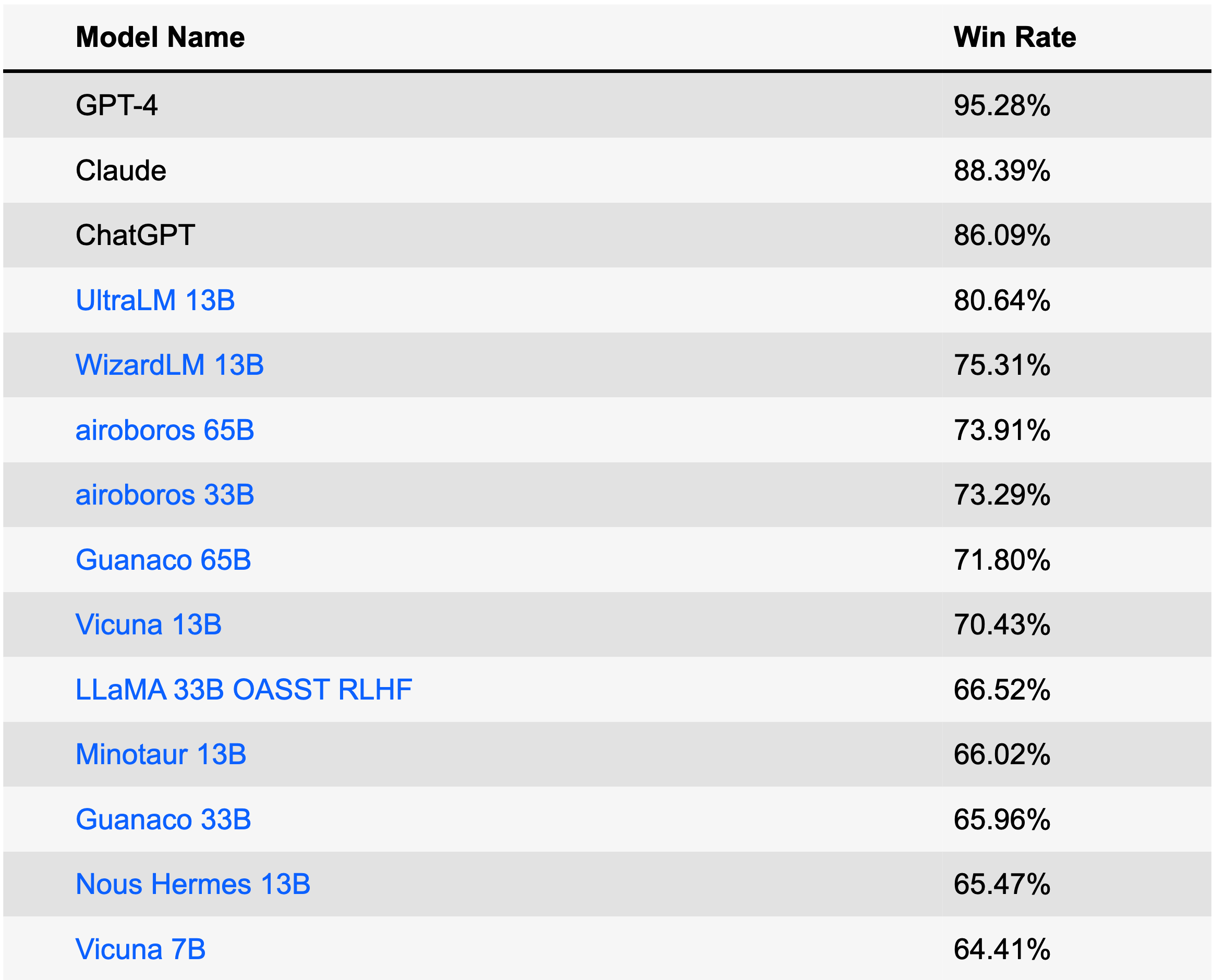

UltraLM 是一系列在 UltraChat 上训练的聊天语言模型。目前,我们已经发布了 13B 版本,在开源模型中排名第一,在 AlpacaEval 排行榜(2023 年 6 月 28 日)所有模型中排名第四。 UltraLM-13B基于LLaMA-13B,并在训练过程中得到BMTrain的支持。

| 模型 | 关联 | 版本 |

|---|---|---|

| 超LM-13B | 拥抱脸回购 | v1.0 |

| 超LM-65B | 拥抱脸回购 | v1.0 |

| 超LM-13B | 拥抱脸回购 | v2.0 |

| 超RM-13B | 拥抱脸回购 | v1.0 |

| 超CM-13B | 拥抱脸回购 | v1.0 |

/UltraLM/recover.sh中的脚本以获得恢复模型的最终权重。/UltraLM/chat_cli.sh中的模型路径替换为您的路径并运行开始聊天!注意:不同的超参数或系统提示会影响输出。您可以参考/UltraLM/inference_cli.py中的详细信息了解我们的默认设置。

我们在本节中报告了三个评估:来自斯坦福大学的 Alpaca-Eval、来自 Microsoft WizardLM 的 Evol-instruct 以及我们策划的评估集。现代LLM的评价可能存在偏差,受到多种因素的影响,我们也在积极研究更全面的评价方法。

AlpacaEval 是专门为评估法学硕士而设计的排行榜。排行榜是根据 GPT-4 自动评估的 Text-Davince-003 胜率创建的。

该数据集采用进化策略构建,通过多轮重写指令以获得不同复杂程度的指令。该基准测试由另一个优秀的聊天语言模型 WizardLM 项目开发!

我们策划了一个评估集,其中包括 Vicuna 基准测试以及 GPT-4 生成的额外 300 个问题和说明。问题/说明涵盖广泛的主题,包括常识、世界知识、专业知识(特别是物理和生物)、数学和不同难度级别的写作任务。我们使用GPT-4进行评估。这是数据集。

示例 A:常识问题

网友:哪种动物被称为人类最好的朋友?

UltraLM:人类喜欢许多动物作为伴侣动物,但对于“哪种动物被称为人类最好的朋友?”这个问题的绝对杰出答案之一。是国内饲养的狗。家养的狗数万年来一直陪伴在人类身边,为人类提供忠实的陪伴和帮助;保护人员和财产;从漫长孤独的日子到军事部署,一切都给予情感支持。狗的品种繁多,体型各异,能量水平、性格和性情也各不相同,这意味着几乎肯定会有一只小狗非常适合最需要它的人。

示例 B:常识推理

用户:一磅羽毛和一磅砖块哪个更重?

UltraLM:一磅羽毛和一磅砖块的重量都是一磅。这是因为一磅是重量单位,就像英尺是长度单位或秒是时间单位一样。我们使用磅(或其他重量单位)来描述不同物体的重量,无论该物体是由什么制成的。所以你的问题的答案是一磅羽毛和一磅砖块的重量相同。

示例 C:推理

用户:如果一个农民有 17 只羊,除了 9 只以外全部死亡,还剩下多少只?

UltraLM:剩下的羊总数是 9 只。

示例 D:推理

用户:如果红房子是用红砖砌成的,蓝房子是用青砖砌成的,那么温室是用什么建造的?

UltraLM:温室不是由绿砖制成,而是由玻璃或塑料等材料制成,这些材料可以让光线穿过,为植物生长创造一个受控的环境。温室可以有多种颜色,包括绿色,但建筑物本身的颜色不会影响内部生长的植物。

示例 E:创建

用户:写一首关于电磁学的诗。

UltraLM:电磁力是我们不能忽视的力量,

这是我们喜爱许多事物的原因。在磁场中,电线会发光,

新旧电子都会对齐。

电与磁齐头并进,

一者创造领域,一者拥有品牌。

磁场可以推、拉,

在有电流的电线上,它会完全反应。

它带来的吸引力和排斥,

都是很多事情的原因。

从电动机到发电机,以及介于两者之间的更多东西,

电磁学是其含义的根源。

这是我们身边无处不在的力量

从指南针到电灯开关。

凭借它的力量,它可以做很多事情,

从简单的针到火箭的推力。

这是我们无法抗拒的力量

因为它是我们生活的一部分。

电磁学是令人钦佩的,

就其力量和力量而言,它是无与伦比的,这是肯定的。

示例 F:创建

用户:写一个关于宇宙第一秒的短篇故事。

UltraLM:在宇宙诞生的第一秒,黑暗占据了统治地位。没有光,没有声音,没有形状,没有物质。虽然什么都没有,但有一股强烈的力量,一股原始的能量等待着释放。在无限之内,第一秒就掌握着创造的潜力。然后,随着一声巨响,一个明亮的光点出现了。其中,最基本的粒子诞生了,它们的形式尚不清楚,因为它们在混乱的创造之舞中疯狂碰撞。在这原始之光中,自然的每一种力量和生命的每一个组成部分都被从纯粹的能量搅动到物理现实。第一批原子迅速聚集,恒星和星系开始形成。它们的融合创造了一个炎热的环境,将虚空推回原处,通过膨胀和冷却的波塑造了宇宙。在这个宇宙第一中,没有任何经验结构,甚至时间或空间,可以建立其规则。一瞬间,整个宇宙存在于一个胚胎连接中,一个宇宙奇点,所有未来的存在都源于此。它是一个微观世界,最终成为宏观世界的一部分,它的诞生时刻是渗透到多元宇宙的创造循环的隐喻。从那个单一的光点,一个无限的宇宙展开了。几个世纪以来,亿万年以来,直到永远,它仍然是其不断进入远方深处的旅程中最基本的眨眼。第一秒是一切的开始。

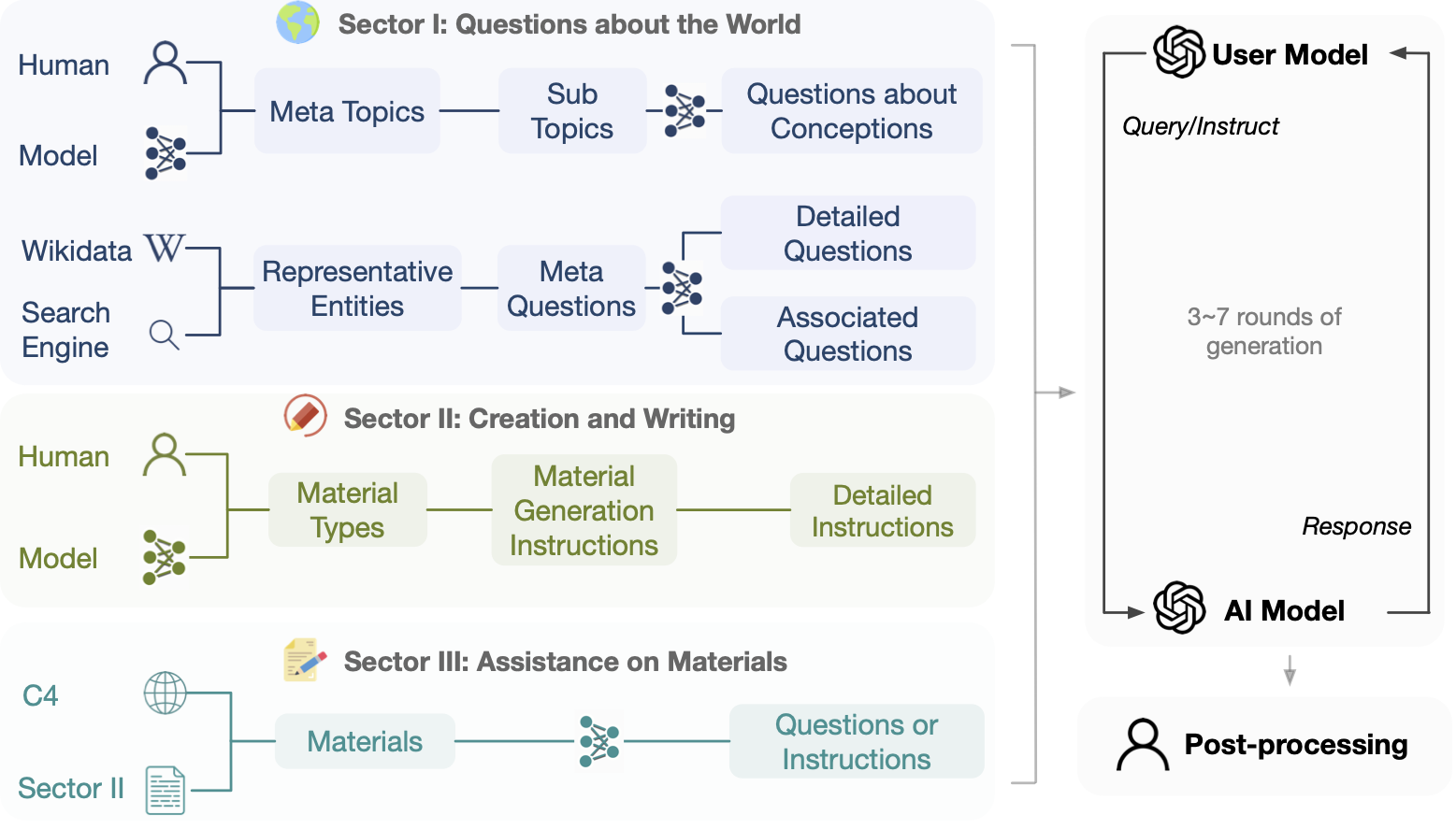

该项目旨在构建基于 Turbo API 的开源、大规模、多轮对话数据,以促进构建具有通用对话能力的强大语言模型。考虑到保护隐私等因素,我们不会直接使用互联网上可获得的任何数据作为提示。

免责声明:虽然UltraChat的构建过程不涉及任何公开的基准数据,但扩展到一定程度仍可能导致某些评估基准出现重叠。我们想再次强调,所有数据都是自动生成的(包括指令和响应) ,我们不插入任何公开的基准数据。例如,UltraChat 的发布时间(2023 年 4 月)早于 Alpaca Eval(2023 年 5 月)。我们鼓励用户密切关注此类现象,同时我们也在积极考虑如何更正确地评估LLM。

该数据集仅用于研究和教育目的,不应被解释为反映该数据集的创建者、所有者或贡献者的意见或观点。它是在 MIT 许可证下分发的。

下载前探索数据,或使用 Atlas explorer。

直接下载链接:

下载的数据文件中的每一行都是一个 json 字典,其中包含列表格式的数据 id 和对话数据。下面是一个示例行。

{

"id" : " 0 " ,

"data" : [

" How can cross training benefit groups like runners, swimmers, or weightlifters? " ,

" Cross training can benefit groups like runners, swimmers, or weightlifters in the following ways: ... " ,

" That makes sense. I've been wanting to improve my running time, but I never thought about incorporating strength training. Do you have any recommendations for specific exercises? " ,

" Sure, here are some strength training exercises that can benefit runners: ... " ,

" Hmm, I'm not really a fan of weightlifting though. Can I incorporate other forms of exercise into my routine to improve my running time? " ,

" Yes, absolutely! ... " ,

" ... "

]

}

我们在.src/中的 UltraChat 上提供了训练代码来微调 LLaMa(但是我们没有分配 LLaMa 的权重),训练由 BMTrain 加速。

下载发布的数据,放到./data下

运行train_bm.py ,例如:

WANDB_MODE= " offline " torchrun --nnodes=1 --nproc_per_node=8 --rdzv_id=1 --rdzv_backend=c10d --rdzv_endpoint=localhost:50003 train_bm.py --tensorboard ./ultrachat_llama_tb_2 --save_step 5000 --logging_step 100我们还在.src/train_legacy/中提供了一个训练脚本来微调 UltraChat 上的 GPT-J,该脚本是使用 OpenPrompt 实现的

./data下accelerate launch train.py开始训练UltraChat 的总体思路是使用单独的 LLM 来生成开场白、模拟用户并响应查询。 UltraChat 的每个领域都有自己的挑战,需要特定的策略设计。一旦UltraChat的某个扇区发布,我们将详细说明构建过程。

如果您认为 UltraChat 有用,请随意引用该存储库。

@article { ding2023enhancing ,

title = { Enhancing Chat Language Models by Scaling High-quality Instructional Conversations } ,

author = { Ding, Ning and Chen, Yulin and Xu, Bokai and Qin, Yujia and Zheng, Zhi and Hu, Shengding and Liu, Zhiyuan and Sun, Maosong and Zhou, Bowen } ,

journal = { arXiv preprint arXiv:2305.14233 } ,

year = { 2023 }

}