胡文波*、徐一凡*、李毅、李伟跃、陈泽元和涂卓文。 *平等贡献

加州大学圣地亚哥分校、 Coinbase Global, Inc.

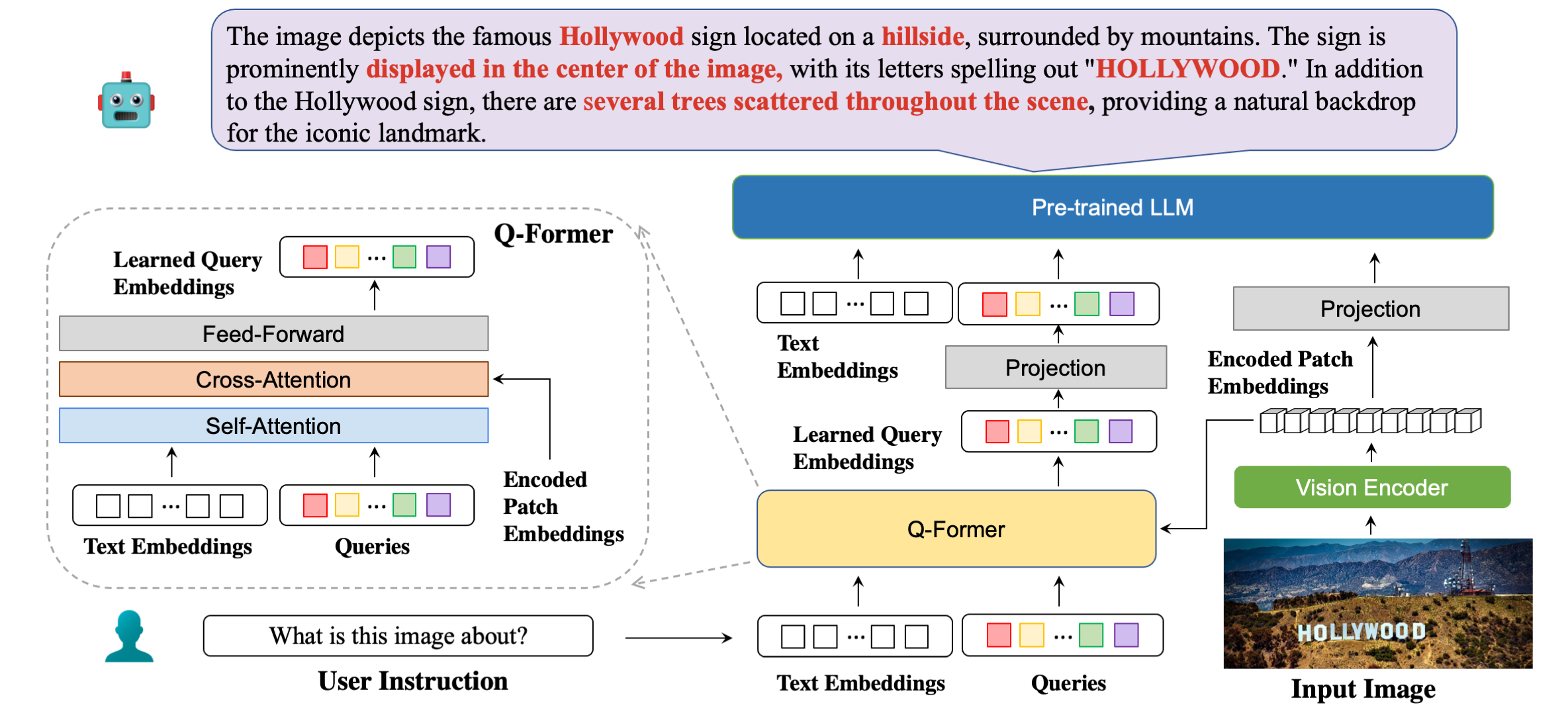

我们的模型架构详细说明了示例响应。

| 方法 | 卫星电视质量保证 | OCRV质量保证 | 文本VQA | 文档VQA | 信息质量保证 | 图表质量保证 | ESTVQA | 基金会 | 社会投资回报率 | POIE | 平均的 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 开放火烈鸟 | 19.32 | 27.82 | 29.08 | 5.05 | 14.99 | 9.12 | 28.20 | 0.85 | 0.12 | 2.12 | 13.67 |

| BLIP2-OPT | 13.36 | 10.58 | 21.18 | 0.82 | 8.82 | 7.44 | 27.02 | 0.00 | 0.00 | 0.02 | 8.92 |

| BLIP2-FLanT5XXL | 21.38 | 30.28 | 30.62 | 4.00 | 10.17 | 7.20 | 42.46 | 1.19 | 0.20 | 2.52 | 15:00 |

| 迷你GPT4 | 14.02 | 11.52 | 18.72 | 2.97 | 13.32 | 4.32 | 28.36 | 1.19 | 0.04 | 1.31 | 9.58 |

| 拉瓦 | 22.93 | 15.02 | 28.30 | 4.40 | 13.78 | 7.28 | 33.48 | 1.02 | 0.12 | 2.09 | 12.84 |

| mPLUG-Owl | 26.32 | 35:00 | 37.44 | 6.17 | 16.46 | 9.52 | 49.68 | 1.02 | 0.64 | 3.26 | 18.56 |

| 指导BLIP (FLANT5XXL) | 26.22 | 55.04 | 36.86 | 4.94 | 10.14 | 8.16 | 43.84 | 1.36 | 0.50 | 1.91 | 18.90 |

| 指导BLIP (Vicuna-7B) | 28.64 | 47.62 | 39.60 | 5.89 | 13.10 | 5.52 | 47.66 | 0.85 | 0.64 | 2.66 | 19.22 |

| 布利瓦 (FLANT5XXL) | 28.24 | 61.34 | 39.36 | 5.22 | 10.82 | 9.28 | 45.66 | 1.53 | 0.50 | 2.39 | 20.43 |

| BLIVA (Vicuna-7B) | 29.08 | 65.38 | 42.18 | 6.24 | 13.50 | 8.16 | 48.14 | 1.02 | 0.88 | 2.91 | 21.75 |

| 方法 | 振动时效 | 图标质量保证 | 文本VQA | 维斯迪亚尔 | Flickr30K | HM | 维兹维兹 | 右心室舒张时间 |

|---|---|---|---|---|---|---|---|---|

| 火烈鸟3B | - | - | 30.1 | - | 60.6 | - | - | - |

| 火烈鸟9B | - | - | 31.8 | - | 61.5 | - | - | - |

| 火烈鸟80B | - | - | 35.0 | - | 67.2 | - | - | - |

| 迷你GPT-4 | 50.65 | - | 18.56 | - | - | 29.0 | 34.78 | - |

| 拉瓦 | 56.3 | - | 37.98 | - | - | 9.2 | 36.74 | - |

| BLIP-2 (Vicuna-7B) | 50.0 | 39.7 | 40.1 | 44.9 | 74.9 | 50.2 | 49.34 | 4.17 |

| 指导BLIP (Vicuna-7B) | 54.3 | 43.1 | 50.1 | 45.2 | 82.4 | 54.8 | 43.3 | 18.7 |

| BLIVA (Vicuna-7B) | 62.2 | 44.88 | 57.96 | 45.63 | 87.1 | 55.6 | 42.9 | 23.81 |

conda create -n bliva python=3.9

conda activate blivagit clone https://github.com/mlpc-ucsd/BLIVA

cd BLIVA

pip install -e . BLIVA 骆驼毛 7B

我们的 Vicuna 版本模型在这里发布。下载我们的模型权重并在模型配置中的第 8 行指定路径。

我们使用的LLM是Vicuna-7B的v0.1版本。要准备骆驼毛的重量,请参阅此处的说明。然后,在模型配置文件第 21 行设置 vicuna 权重的路径。

BLIVA FlanT5 XXL(可用于商业用途)

FlanT5版本模型在这里发布。下载我们的模型权重并在模型配置中的第 8 行指定路径。

当运行我们的推理代码时,Flant5 的 LLM 权重将自动开始从 Huggingface 下载。

要回答图像中的一个问题,请运行以下评估代码。例如,

python evaluate.py --answer_qs

--model_name bliva_vicuna

--img_path images/example.jpg

--question " what is this image about? "我们还支持回答多项选择题,这与我们在论文中用于评估任务的相同。要提供选项列表,它应该是用逗号分隔的字符串。例如,

python evaluate.py --answer_mc

--model_name bliva_vicuna

--img_path images/mi6.png

--question " Which genre does this image belong to? "

--candidates " play, tv show, movie " 我们的演示可在此处公开获取。在您的计算机上本地运行我们的演示。跑步:

python demo.py下载训练数据集并在数据集配置中指定其路径后,我们就可以开始训练了。我们在实验中使用了 8x A6000 Ada。请根据您的GPU资源调整超参数。 Transformer 可能需要大约 2 分钟来加载模型,请给模型一些时间来开始训练。这里我们以训练 BLIVA Vicuna 版本为例,Flant5 版本遵循相同的格式。

torchrun --nnodes=1 --nproc_per_node=8

train.py

--cfg-path train_configs/pretrain_bliva_vicuna.yamltorchrun --nnodes=1 --nproc_per_node=8

train.py

--cfg-path train_configs/finetune_bliva_vicuna.yaml或者,我们也支持在第二步中使用 LoRA 与 BLIVA 一起训练 Vicuna7b,默认情况下我们不使用此版本。

torchrun --nnodes=1 --nproc_per_node=8

train.py

--cfg-path train_configs/finetune_bliva_and_vicuna.yaml如果您发现 BLIVA 对您的研究和应用有用,请使用此 BibTeX 进行引用:

@misc { hu2023bliva ,

title = { BLIVA: A Simple Multimodal LLM for Better Handling of Text-Rich Visual Questions } ,

author = { Wenbo Hu and Yifan Xu and Yi Li and Weiyue Li and Zeyuan Chen and Zhuowen Tu } ,

publisher = { arXiv:2308.09936 } ,

year = { 2023 } ,

}该存储库的代码遵循 BSD 3-Clause License。许多代码基于 Lavis,并具有 BSD 3-Clause License。

对于我们的 BLIVA Vicuna 版本的模型参数,它应该在 LLaMA 的模型许可下使用。对于 BLIVA FlanT5 的模型权重,它采用 Apache 2.0 许可证。对于我们的 YTTB-VQA 数据,它位于 CC BY NC 4.0 下