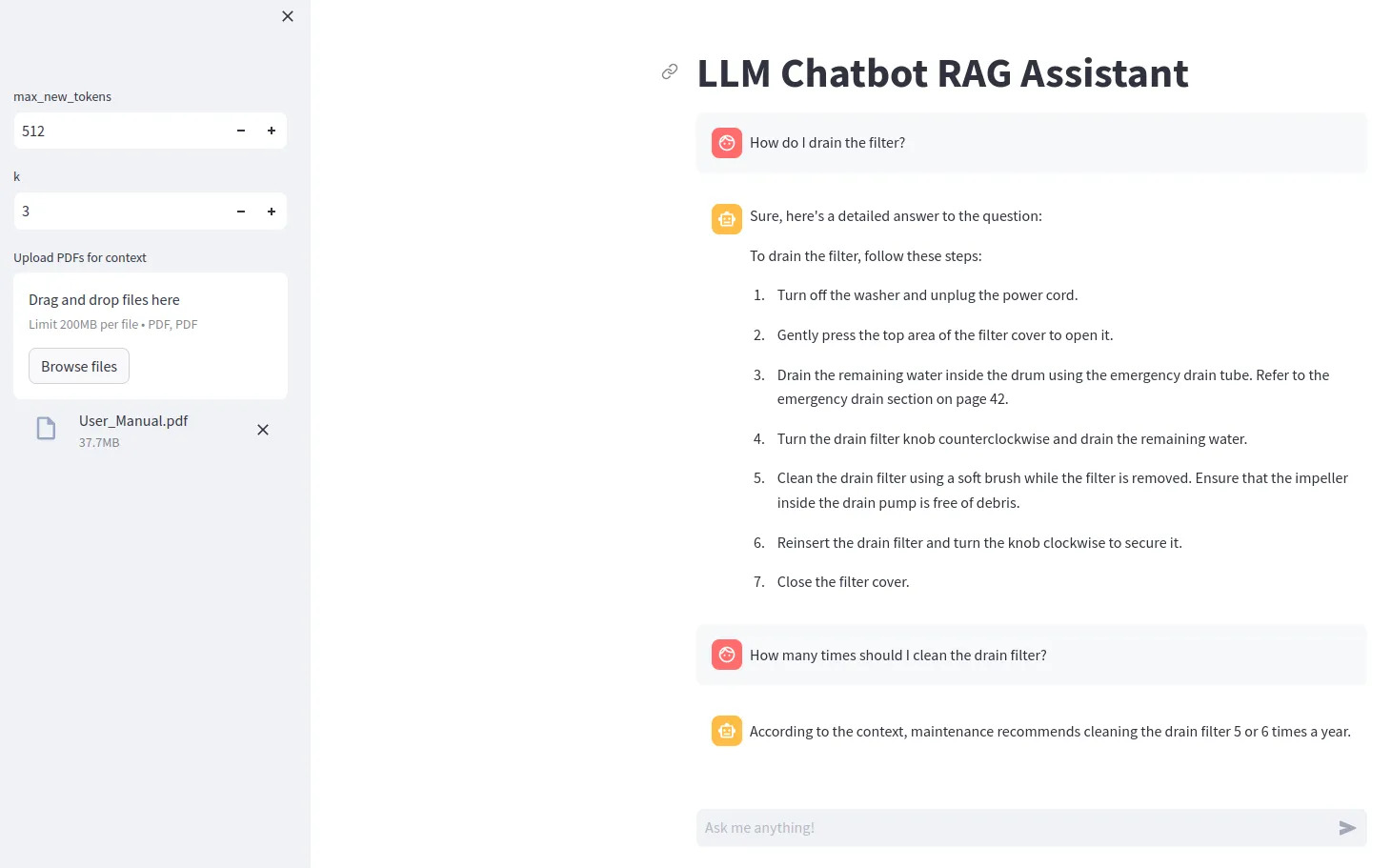

llm chatbot rag

1.0.0

要使用某些 LLM 模型(例如 Gemma),您需要创建一个包含行ACCESS_TOKEN=<your hugging face token>的 .env 文件

使用pip install -r requirements.txt安装依赖项

使用streamlit run src/app.py运行

要使用位和字节量化,需要 Nvidia GPU。确保先安装 NVIDIA Toolkit,然后安装 PyTorch。

您可以检查您的 GPU 在 Python 中是否可用:

import torch

print(torch.cuda.is_available())

如果您没有兼容的 GPU,请尝试为模型设置device="cpu"并删除量化配置。