元唐徐韩贤之李*乔宇医学豪龙胡敏陈

华中科技大学 华南理工大学

ACM MM 2024

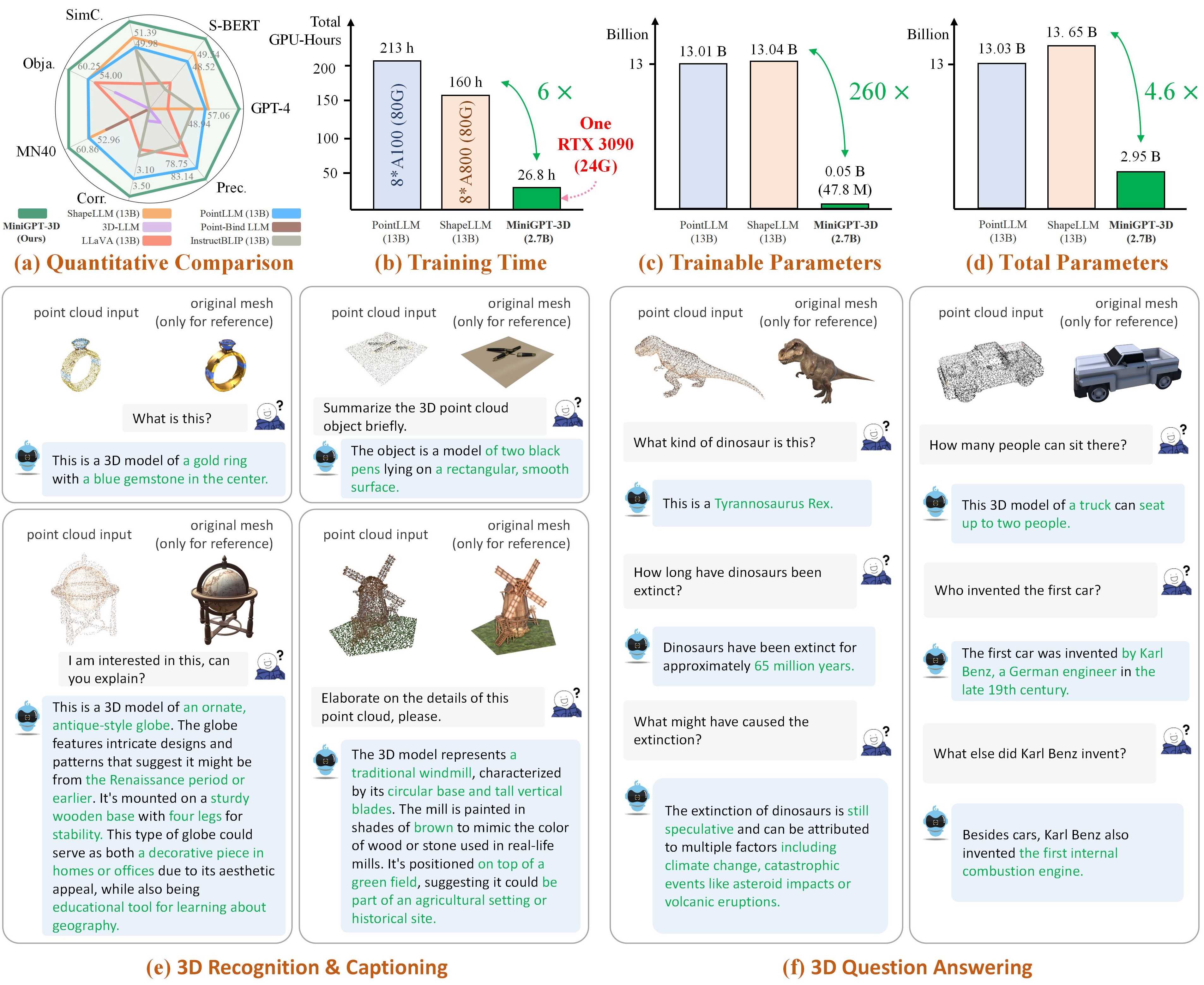

注: MiniGPT-3D迈出了高效3D-LLM的第一步,我们希望MiniGPT-3D能为这个社区带来新的见解。

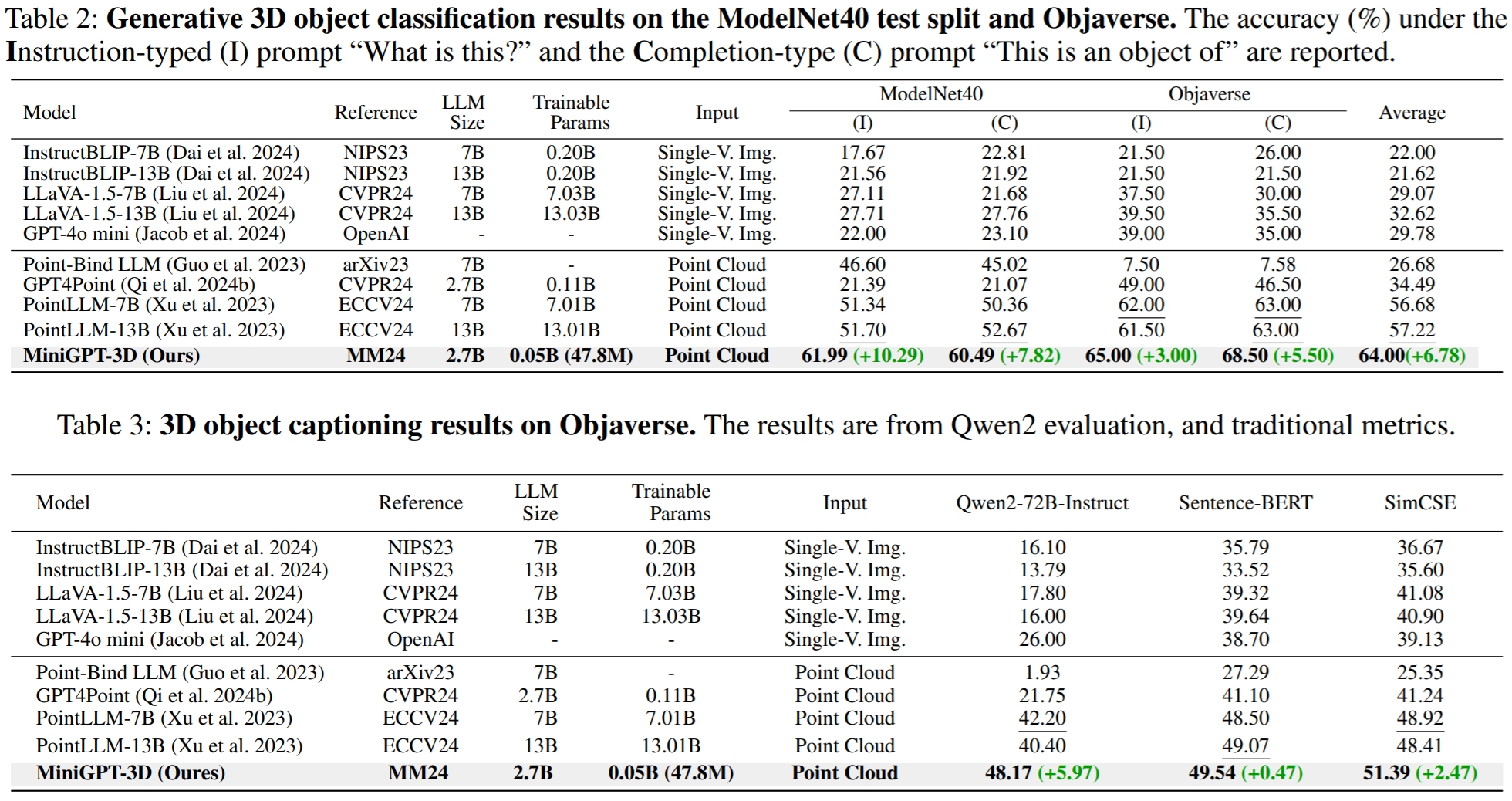

结果参考GreenPLM。

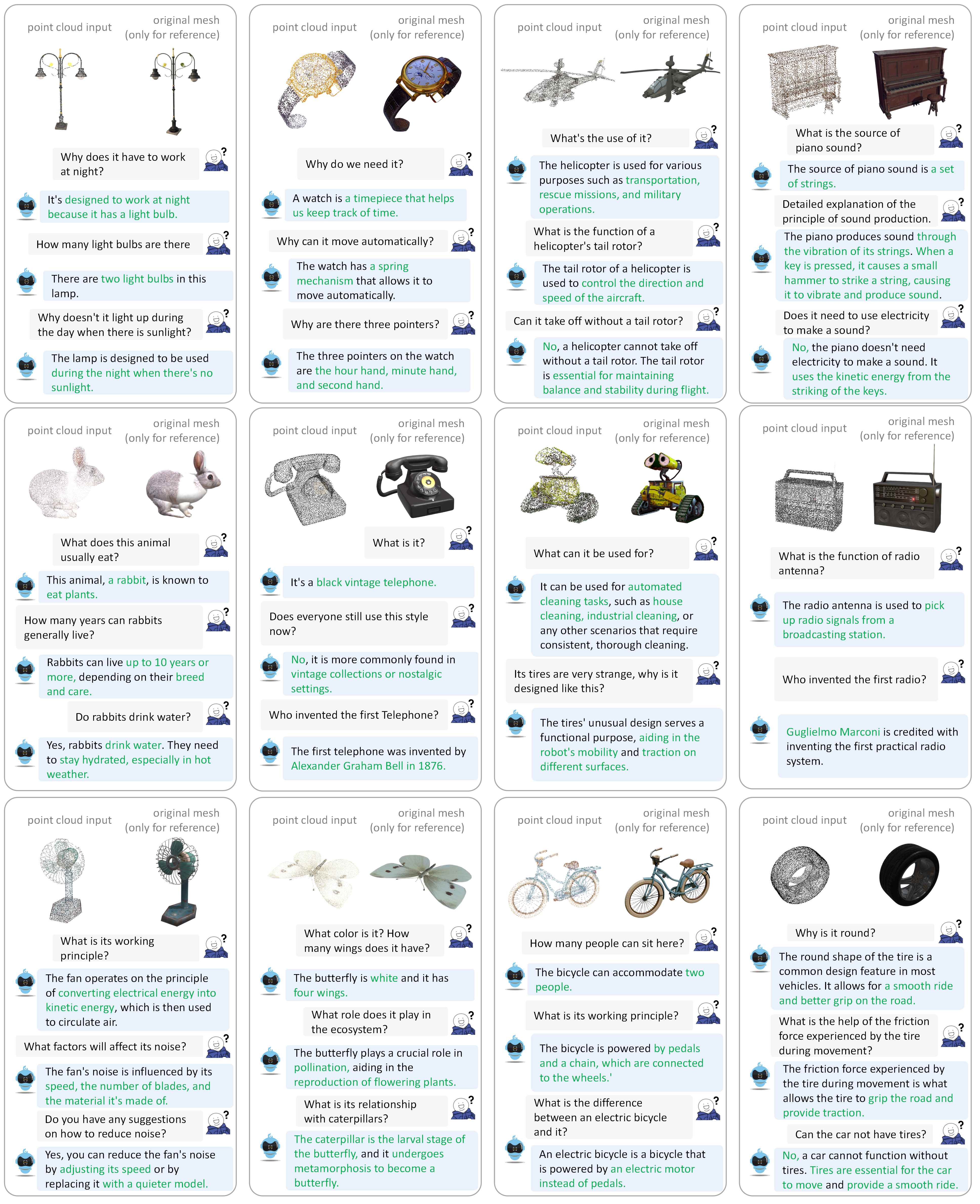

请参阅我们的论文以获取更多对话示例。

我们在以下环境下测试我们的代码:

开始:

克隆此存储库。

git clone https://github.com/TangYuan96/MiniGPT-3D.git

cd MiniGPT-3D安装包

默认情况下,您已经安装了 conda。

conda env create -f environment.yml

conda activate minigpt_3d

bash env_install.sh8192_npy的文件夹,其中包含名为{Objaverse_ID}_8192.npy 660K 点云文件。每个文件都是一个维度为 (8192, 6) 的 numpy 数组,其中前三个维度是xyz ,后三个维度是 [0, 1] 范围内的rgb 。 cat Objaverse_660K_8192_npy_split_a * > Objaverse_660K_8192_npy.tar.gz

tar -xvf Objaverse_660K_8192_npy.tar.gz8192_npy文件夹中的所有文件移动到./data/objaverse_data文件夹中。./data/anno_data文件夹。modelnet40_test_8192pts_fps.dat移动到./data/modelnet40_data文件夹。最后,整体数据目录结构应该是:

MiniGPT-3D/data

|-- anno_data

| |-- PointLLM_brief_description_660K.json

| |-- PointLLM_brief_description_660K_filtered.json

| |-- PointLLM_brief_description_val_200_GT.json

| |-- PointLLM_complex_instruction_70K.json

| |-- object_ids_660K.txt

| `-- val_object_ids_3000.txt

|-- modelnet40_data

| |-- modelnet40_test_8192pts_fps.dat

|-- objaverse_data

| |-- 00000054c36d44a2a483bdbff31d8edf_8192.npy

| |-- 00001ec0d78549e1b8c2083a06105c29_8192.npy

| .......

我们整理了MiniGPT-3D在训练和推理过程中所需的模型权重。

params_weight文件夹移动到MiniGPT-3D项目文件夹。最后,整体数据目录结构应该是:

MiniGPT-3D

|-- params_weight

| |-- MiniGPT_3D_stage_3 # Our MiniGPT-3D stage III weight, needed to verify the results of paper

| |-- MiniGPT_3D_stage_4 # Our MiniGPT-3D stage IV weight, Needed to verify the results of paper

| |-- Phi_2 # LLM weight

| |-- TinyGPT_V_stage_3 # 2D-LLM weights including loRA & Norm of LLM and projector

| |-- all-mpnet-base-v2 # Used in the caption traditional evaluation

| |-- bert-base-uncased # Used in initialize Q-former

| |-- pc_encoder # point cloud encoder

| `-- sup-simcse-roberta-large # Used in the caption traditional evaluation

|-- train_configs

| `-- MiniGPT_3D

| .......

您可以运行以下命令来启动本地 gradio 对话演示:

python UI_demo.py --cfg-path ./eval_configs/MiniGPT_3D_conv_UI_demo.yaml --gpu-id 0然后,将链接http://127.0.0.1:7860/复制到您的浏览器,您可以输入支持的Objaverse对象ID(660K对象)或上传一个对象文件(.ply或.npy)与我们的MiniGPT-3D对话。

示例:输入对象 ID:

示例:上传目标文件:

如果您想使用各个Stage的默认输出路径,则可以忽略以下步骤。

CUDA_VISIBLE_DEVICES=0 python train.py --cfg-path ./train_configs/MiniGPT_3D/stage_1.yaml

CUDA_VISIBLE_DEVICES=0 python train.py --cfg-path ./train_configs/MiniGPT_3D/stage_2.yaml

CUDA_VISIBLE_DEVICES=0 python train.py --cfg-path ./train_configs/MiniGPT_3D/stage_3.yaml

CUDA_VISIBLE_DEVICES=0 python train.py --cfg-path ./train_configs/MiniGPT_3D/stage_4.yaml

如果你只是想验证我们论文的结果,可以忽略以下步骤:

将 Stage III 的输出路径设置为第 8 行。

将 Stage IV 的输出路径设置为第 9 行。

在objverse上输出开放词汇分类的结果

# Prompt 0:

export PYTHONPATH= $PWD

CUDA_VISIBLE_DEVICES=0 python pointllm/eval/eval_objaverse.py --out_path ./output/test --task_type classification --cfg-path ./eval_configs/benchmark_evaluation_paper.yaml --prompt_index 0 # Prompt 1:

export PYTHONPATH= $PWD

CUDA_VISIBLE_DEVICES=0 python pointllm/eval/eval_objaverse.py --out_path ./output/test --task_type classification --cfg-path ./eval_configs/benchmark_evaluation_paper.yaml --prompt_index 1在ModelNet40上输出近集零样本分类的结果

# Prompt 0:

export PYTHONPATH= $PWD

CUDA_VISIBLE_DEVICES=0 python pointllm/eval/eval_modelnet_cls.py --out_path ./output/test --cfg-path ./eval_configs/benchmark_evaluation_paper.yaml --prompt_index 0 # Prompt 1:

export PYTHONPATH= $PWD

CUDA_VISIBLE_DEVICES=0 python pointllm/eval/eval_modelnet_cls.py --out_path ./output/test --cfg-path ./eval_configs/benchmark_evaluation_paper.yaml --prompt_index 1在objaverse上输出对象字幕的结果

export PYTHONPATH= $PWD

CUDA_VISIBLE_DEVICES=0 python pointllm/eval/eval_objaverse.py --out_path ./output/test --task_type captioning --cfg-path ./eval_configs/benchmark_evaluation_paper.yaml --prompt_index 2在GreenPLM中,我们注意到闭源LLM GPT-3.5和GPT-4有两个主要缺点: API版本不一致和评估成本较高(每次评估约35元人民币或5美元) 。例如,PointLLM 中使用的 GPT-3.5-turbo-0613 模型和我们的 MiniGPT-3D不再维护,因此很难复制结果。

export PYTHONPATH= $PWD

export OPENAI_API_KEY=sk- ****

python pointllm/eval/evaluator.py --results_path /path/to/evaluation/PointLLM_brief_description_val_200_GT_Objaverse_classification_prompt0.json --model_type gpt-4-0613 --eval_type open-free-form-classification --parallel --num_workers 15 export PYTHONPATH= $PWD

export OPENAI_API_KEY=sk- ****

python pointllm/eval/evaluator.py --results_path /path/to/evaluation/PointLLM_brief_description_val_200_GT_Objaverse_classification_prompt1.json --model_type gpt-4-0613 --eval_type open-free-form-classification --parallel --num_workers 15 export PYTHONPATH= $PWD

export OPENAI_API_KEY=sk- ****

python pointllm/eval/evaluator.py --results_path /path/to/evaluation/ModelNet_classification_prompt0.json --model_type gpt-3.5-turbo-0613 --eval_type modelnet-close-set-classification --parallel --num_workers 15 export PYTHONPATH= $PWD

export OPENAI_API_KEY=sk- ****

python pointllm/eval/evaluator.py --results_path /path/to/evaluation/ModelNet_classification_prompt1.json --model_type gpt-3.5-turbo-0613 --eval_type modelnet-close-set-classification --parallel --num_workers 15 export PYTHONPATH= $PWD

export OPENAI_API_KEY=sk- ****

python pointllm/eval/evaluator.py --results_path /path/to/evaluation/PointLLM_brief_description_val_200_GT_Objaverse_captioning_prompt2.json --model_type gpt-4-0613 --eval_type object-captioning --parallel --num_workers 15在 GreenPLM 中,我们使用GPT-4 级开源 Qwen2-72B-Instruct 提出新的 3D 对象分类和标题基准,以使评估具有成本效益且结果始终可重复。

export PYTHONPATH= $PWD

export DASHSCOPE_API_KEY=sk-xxx

python ./pointllm/eval/evaluator_opensource_llm_QwenAPI.py

--results_path /path/to/evaluation/PointLLM_brief_description_val_200_GT_Objaverse_classification_prompt0.json

--eval_type open-free-form-classification

--model_type qwen2-72b-instruct

--parallel --num_workers 4 export PYTHONPATH= $PWD

export DASHSCOPE_API_KEY=sk-xxx

python ./pointllm/eval/evaluator_opensource_llm_QwenAPI.py

--results_path /path/to/evaluation/PointLLM_brief_description_val_200_GT_Objaverse_classification_prompt1.json

--eval_type open-free-form-classification

--model_type qwen2-72b-instruct

--parallel --num_workers 4 export PYTHONPATH= $PWD

export DASHSCOPE_API_KEY=sk-xxx

python ./pointllm/eval/evaluator_opensource_llm_QwenAPI.py

--results_path /path/to/evaluation/ModelNet_classification_prompt0.json

--eval_type modelnet-close-set-classification

--model_type qwen2-72b-instruct

--parallel --num_workers 4 export PYTHONPATH= $PWD

export DASHSCOPE_API_KEY=sk-xxx

python ./pointllm/eval/evaluator_opensource_llm_QwenAPI.py

--results_path /path/to/evaluation/ModelNet_classification_prompt1.json

--eval_type modelnet-close-set-classification

--model_type qwen2-72b-instruct

--parallel --num_workers 4 export PYTHONPATH= $PWD

export DASHSCOPE_API_KEY=sk-xxx

python ./pointllm/eval/evaluator_opensource_llm_QwenAPI.py

--results_path /path/to/evaluation/PointLLM_brief_description_val_200_GT_Objaverse_captioning_prompt2.json

--eval_type object-captioning

--model_type qwen2-72b-instruct

--parallel --num_workers 4对于对象字幕任务,运行以下命令以使用传统指标 Sentence-BERT 和 SimCSE 评估模型输出。

CUDA_VISIBLE_DEVICES=0 python pointllm/eval/traditional_evaluator.py --results_path /path/to/evaluation/PointLLM_brief_description_val_200_GT_Objaverse_captioning_prompt2.json在第 8 行设置 Stage III 的输出路径。

在第 9 行设置 Stage IV 的输出路径。

您可以运行以下命令来启动本地 gradio 对话演示:

python UI_demo.py --cfg-path ./eval_configs/MiniGPT_3D_conv_UI_demo.yaml --gpu-id 0如果您发现我们的工作有帮助,请考虑引用:

@article { tang2024minigpt ,

title = { MiniGPT-3D: Efficiently Aligning 3D Point Clouds with Large Language Models using 2D Priors } ,

author = { Tang, Yuan and Han, Xu and Li, Xianzhi and Yu, Qiao and Hao, Yixue and Hu, Long and Chen, Min } ,

journal = { arXiv preprint arXiv:2405.01413 } ,

year = { 2024 }

}

本作品采用知识共享署名-非商业性-相同方式共享 4.0 国际许可证。

让我们一起让 3D 法学硕士变得更伟大!

我们要感谢 PointLLM、TinyGPT-V、MiniGPT-4 和 Octavius 的作者的出色作品和代码库。